Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 491 à 500.

| < Les 10 documents précédents | Les 10 documents suivants > |

(03/05/2011 11:34:15)

Double panne pour le Cloud Foundry de VMware

La solution PaaS de VMware, Cloud Foundry - qui est encore en version bêta - a subi une interruption de service pendant deux jours la semaine dernière (les 25 et 26 avril), peu de temps après la panne plus connue et médiatisée qui a frappé Elastic Compute Cloud d'Amazon. Le premier incident était du à une panne de courant dans une armoire de stockage. Les applications en ligne n'ont pas été affectées, mais les développeurs n'ont pas été en mesure d'effectuer certaines tâches, comme s'authentifier ou créer de nouvelles applications. La panne a duré près de 10 heures et a été réparée dans l'après-midi.

Mais le lendemain, les responsables de VMware ont accidentellement provoqué une deuxième coupure de courant, en élaborant un plan de prévention pour résoudre la panne initiale. Dekel Tankel, porte-parole de VMware a expliqué que la première panne d'électricité du 25 avril est « quelque chose qui arrive de temps en temps », et que l'éditeur veille à ce que ses logiciels de surveillance et les pratiques opérationnelles soient suffisamment robustes pour éviter que ces coupures d'électricité rendent inopérants le service des clients. Dans cet esprit, VMware a commencé à élaborer « un guide complet d'instructions pour la détection, la prévention et la restauration » dès le lendemain.

De Charybde en Scylla

« A huit heures le 26 avril, ce travail a fourni plusieurs instructions que les équipes opérationnelles et d'ingénierie devaient appliquer à midi », précise Dekel Tankel et d'ajouter « malheureusement, à 10h15, l'un des ingénieurs a fait une mauvaise manipulation, ce qui a eu comme conséquence une coupure complète de l'infrastructure du réseau de Cloud Foundry. Les équilibreurs de charge, les routeurs et les pare-feu ont été inopérants. Par ailleurs, notre infrastructure DNS interne a été partiellement touchée par la panne et a entraîné une perte complète de la connectivité externe à Cloud Foundry ». Le système a été rétabli à 11h30, apparemment sans que les développeurs soient impactés.

Cette seconde panne illustre l'élément « erreur humaine » dans les réseaux clouds, tout comme l'analyse des causes de la défaillance du cloud d'Amazon. Sur ce dernier, il s'agit d'une erreur commise lors d'une mise à jour du système et qui n'a été réparé qu'au bout de plusieurs jours. Certes Cloud Foundry est encore balbutiant et l'impact sur les clients des défaillances n'ont pas été du même niveau que celles d'Amazon, mais VMware découvre ainsi un avant-goût des problèmes que peut rencontrer un fournisseur de services cloud.

Cisco se lance dans les datacenters modulaires

Les datacenters modulaires standards sont de taille comprise entre 6 et 12 m et comprennent des serveurs, des éléments réseaux et des solutions de stockage et des systèmes de refroidissement. Mis au point par des sociétés comme APC et Sun Microsystems, ils sont utilisés pour ajouter rapidement une capacité supplémentaire à un centre de calcul existant ou répondre à un besoin sur des sites distant, comme une plateforme pétrolière ou une zone de conflit.

Cisco a opté pour un conteneur de 12m, opérationnel dans les 90 à 120 jours à compter de la date de la commande. Comme d'autres fournisseurs sur le marché, Cisco prévoit l'intégration de ses propres produits, mais accueille aussi les équipements d'autres fournisseurs, précise Keith Siracuse, ingénieur marketing produit chez Cisco. Avec leur taille relativement restreinte, les conteneurs proposent une meilleure efficience énergétique. Cisco va un peu plus loin que d'autres fournisseurs en concevant des racks capables d'adapter la température à chaque équipement en fonction des charges de travail et de l'environnement extérieur. Un conteneur peut accueillir jusqu'à 16 armoires, avec une puissance maximale de 25 kW par rack. Les conteneurs peuvent être placés côte à côte ou empilés pour économiser de l'espace au sol.

Une gestion fine de l'efficience énergétique

Cisco a opté pour un système de refroidissement liquide qui se situe dans le plancher du conteneur. Keith Siracuse défend ce choix « les équipements ne sont ainsi pas susceptibles d'être endommagés en cas de fuite d'eau ». La plupart des autres fournisseurs utilisent un système de refroidissement liquide par le plafond. Les fuites sont assez rares, mais il s'agit d'une préoccupation des responsables des datacenters d'entreprises.

Le conteneur est livré avec un outil de gestion, Cisco Data Center Operations 360, qui surveille la température des racks et d'autres variables en temps réel. Les clients peuvent ainsi planifier la température désirée pour chaque rack et le logiciel ajuste la vitesse des ventilateurs et le débit d'eau en conséquence. A noter que Cisco s'est associé à des partenaires comme Jonhson Controls pour assurer l'intégration de l'infrastructure et des services auprès des clients.

En concurrence frontale

D'autres sociétés qui vendent déjà des containers comme IBM, Hewlett-Packard, Dell, SGI et APC, n'ont pas commenté l'annonce de Cisco. IDC estime que ce n'est pas un grand marché où seules quelques centaines d'unités par an sont vendues. Mais les grands acteurs croient au potentiel de ces produits pour se lancer dans cette aventure. « Au cours de la dernière année, nous avons vraiment commencé à voir de l'attractivité sur ce marché », a déclaré Keith Siracuse et d'ajouter « Il y a beaucoup d'intérêt sur le marché de la santé, des compagnies pétrolières et du gaz, de l'éducation, y compris les centres de recherche universitaires qui sont limités en matière de capacité en datacenter ».

Pour répondre à la question des évolutions, le responsable de Cisco indique «il s'agit de notre premier produit. Nous allons examiner d'autres solutions prochainement ». La tarification varie selon la façon dont le produit est configuré et déployé. En général, les conteneurs coûtent généralement plus de 1 million de dollars pièce, en intégrant l'ensemble du matériel IT à l'intérieur.

Illustration: intérieur d'un datacenter modulaire de Cisco

Crédit Photo: James Niccolai

(...)(02/05/2011 09:41:04)Les intégrateurs peu réceptifs au cloud selon Hermitage Solutions

« Les nombreux arguments que nous entendons et lisons ces derniers mois quant aux avantages inhérents à la revente de solutions Cloud, ne semblent pas être rentrés dans les oreilles de nos Intégrateurs / Revendeurs. » C'est par ces mots que Hermitage Solutions, grossiste informatique spécialisé dans la sécurité, introduit les résultats d'un sondage qu'il a mené auprès d'une trentaine de ses clients lors de son événement partenaires du 7 avril.

Pour 89% d'entre eux, la montée du cloud computing est inévitable et ils se voient ainsi contraints d'investir sur ce marché. « Contraints », le mot n'est pas trop fort puisqu'ils ne sont que 37% à identifier ce modèle comme une opportunité à fort potentiel. En outre, la moitié d'entre eux pensent que revendre des solutions cloud va les amener à procéder à d'importants changements d'organisation dans leur société.

Un flou dans la répartition des compétences

Toutefois, 78% des revendeurs sondés estiment que le modèle de l'informatique dans le nuage se prête bien au domaine de la sécurité et comptent développer leur offre. Entre autres avantages du cloud, les clients d'Hermitages Solutions citent également la facilité d'accès aux services (82%), la récurrence des revenus (79%) et la tarification à la demande plus accessible aux PME (68%).

Reste que 60% d'entre eux estiment que l'approche du cloud computing n'est pas mature au niveau de la distribution, dans le sens où la répartition des rôles et des responsabilités entre l'éditeur, le grossiste et le revendeur n'est pas bien établie. Ce manque de maturité, ils sont également 45% à le pointer du doigt en termes de technologie. Enfin, 40% des revendeurs estiment que la diminution des contacts directs avec les clients est aussi un frein. (...)

Résultats annuels Acropolis Telecom : Une année 2010 forte en investissement

L'opérateur IP Acropolis Telecom a réalisé un chiffre d'affaires de 6,3 M€ en 2010, soit une hausse de 27% comparé à l'exercice précédent. La marge brute de l'entreprise a également progressé, passant de 1,84 M€ en 2009 à 2,4 M€ l'an dernier. En revanche, son résultat opérationnel a viré dans le rouge à -493 K€ alors qu'il se situait à près de 30 K€ en an plus tôt. Le résultat net est également négatif à -345 K€.

L'entreprise explique la dégradation de sa rentabilité par les nombreux investissements qu'elle a réalisés en 2010 et qu'elle a comptabilisés en charges. Ces dépenses ont été consacrées notamment aux ouvertures de 10 agences en France et à l'acquisition de l'opérateur ToIP IPEX. Acopolis Telecom poursuit d'ailleurs sa politique d'investissement cette année avec l'achat de trois datacenters à Paris. Pour Samir Koleilat, son président, « ces acquisitions devraient assurer à Acropolis Telecom un chiffre d'affaires annuel incrémental à sa croissance courante de plus de 6 millions d'euros à l'horizon 2013»

Développeurs, sur Facebook, n'utilisez plus «Share» mais «Like» !

La deuxième édition française du Facebook Developer Garage s'est tenue mardi soir dans les locaux de Microsoft, animée par Julien Cordorniou, un ancien de la maison, désormais directeur des partenariats pour Facebook en France et au Benelux. En un mois, l'appétence des développeurs s'est confirmée. A la Cantine, en mars, 420 personnes avaient manifesté leur intérêt pour l'invitation. Elles ont été 620 à le faire cette fois-ci, selon les chiffres communiqués. L'exercice doit être renouvelé chaque mois, promet l'équipe du réseau social.

Le but des Developer Garage, c'est d'expliquer aux développeurs comment ils peuvent tirer parti de Facebook, rappelle Julien Codorniou. Il souligne que l'un des paradoxes de cette plateforme où se retrouvent plus de 600 millions de personnes, pour beaucoup quotidiennement, c'est d'offrir des possibilités de distribution extraordinaires et un fort potentiel de monétisation (cf ce qu'en fait Zynga dans le domaine du social gaming), mais de n'être « pas facile à maîtriser ». Jusqu'à présent, il n'y avait personne en Europe pour donner le mode d'emploi sur ces questions. Facebook y remédie. Outre la constitution d'équipes internes pour s'adresser aux développeurs, la société certifie des partenaires pour l'épauler dans cette mission (en France, KRDS, Sociabliz, 909C...).

Facebook, un apporteur de trafic

Mardi, l'antenne française du réseau social a d'abord fait le point sur les nouveautés (le bouton Send, Facebook Deals...), avant de revenir sur les moyens qui, bien utilisés, permettront aux sites web (e-marchands, médias, jeux...) de booster le trafic que leur envoie la plateforme. Comment, par exemple, bien utiliser le bouton « Like » pour aller chercher « les amis des gens qui aiment vos produits et vos sites web », comment les tagger correctement, au bon endroit sur la page web. « C'est important de bien le comprendre », avertit Julien Codorniou en engageant à se servir désormais de ce bouton en lieu et place du bouton « Share », moins efficace pour récupérer des visiteurs sur les sites.

Pour tous les professionnels misant sur la fréquentation de leurs pages web pour développer leur activité, Facebook doit être vu comme un apporteur de trafic. C'est sur ce message essentiel que s'est principalement déclinée la soirée « Garage ». Parmi les derniers outils contribuant à ce but figure le bouton « Send », annoncé en début de semaine. Si le bouton Like sert à communiquer une information à tous ses amis sur son fil d'actualité Facebook (« news feed »), Send va au contraire l'envoyer à un nombre restreint d'utilisateurs : deux ou trois amis, un groupe. Il se met en oeuvre de la même façon. « C'est une fonctionnalité qui nous a été suggérée par les sites d'e-commerce, notamment dans la vente privée, pour prévenir d'un bon plan exclusif que l'on n'a pas envie de partager avec tout le monde, explique Julien Codorniou. Cette fonction, qui intéresse aussi les acteurs du « dating » et des médias, peut être utilisée pour « bookmarquer » des sites web. En France, certains partenaires l'ont déjà adopté, par exemple le site du Monde.fr qui l'a installé en moins de trois jours, ou encore LePost et Web.tv.

Accroître l'effet viral des opérations

Déjà évoquée mais officialisée cette semaine, Facebook Deals se présente un peu comme un concurrent de Groupon (site d'achats groupés), à la différence près qu'il s'agit aussi d'une plateforme et que les marchands pourront y pousser leurs propres deals à travers Facebook. « Il faudra faire un opt-in, par ville, précise Julien Codorniou. Aujourd'hui, c'est disponible dans cinq villes aux Etats-Unis et cela va arriver en France avant la fin de l'année. » Par rapport aux acteurs du coupening qui envoient le même e-mail à chacun, l'objectif est de proposer des « deals sociaux » assortis de réductions lorsque l'on se met à plusieurs. « Le grand intérêt de la plateforme, c'est la distribution, insiste le directeur des partenariats de Facebook France. L'information apparaîtra dans les fils d'actualité des personnes qui feront l'achat et il sera possible de payer avec des Credits. « C'est un peu la version super sociale de cette nouvelle vague dans l'industrie du coupening. Il y a déjà beaucoup de partenaires qui sont intéressés ». Il y a peu, le réseau avait également lancé les « check-in deals ». Ces derniers permettent, à proximité d'une boutique jouant le jeu, de se signaler à partir de son portable (sous Windows Phone 7, Android ou iPhone) pour bénéficier d'une promotion, dans l'instant ou plus tard, en cumulant les check-in deals, seul ou avec des amis. Maintenant, cela sert aussi à prévenir que l'on participe à un événement (un concert, une soirée, une vente flash sur site de vente privée...). « Cela a été demandé par nos partenaires, mentionne encore Julien Codorniou. C'est encore une manière pour nous d'accroître l'effet viral de certaines opérations. »

Un bouton Like sur tous les produits du site Wallmart

Il y a un mois, le Social plug-in Facebook Comments a été mis à jour. Par son intermédiaire, un membre du réseau social utilisera son identité Facebook lorsqu'il fait un commentaire sur un site. A la manière d'un Like. Cela augmente la visibilité du commentaire. « Encore une fois, c'est une manière d'aller chercher du trafic auprès des amis de ceux qui aiment le contenu qui se trouve sur vos sites », explique le directeur des partenariats.

Illustration : Julien Codorniou, directeur des développements partenaires chez Facebook France et Benelux (à droite sur la photo) interroge Alban Peltier, CEO de la société de développement de jeux Antvoice (à gauche) lors du deuxième Facebook Developer Garage, le 26 avril 2011 à Issy-les-Moulineaux.[[page]]Parmi les exemples récents de mises en oeuvre des outils de Facebook, la chaîne de distribution américaine Wallmart a placé le bouton Like sur tous les produits de son site web. « Cela va rajouter des milliers d'objets dans l'Open Graph », souligne Julien Codorniou. En France, il cite « 60 secondes », une série développée sur Arte, uniquement sur le réseau social. La chaîne de télévision mise sur l'effet viral en livrant un contenu exclusif pour toucher les plus de 20 millions de Français présents sur Facebook.

Enfin, pour illustrer l'intérêt d'insérer des Social plug-in sur un site, Julien Codorniou rappelle que le module de reporting, Insights, permet aux webmasters de voir, à partir des actions sociales placées sur leur site (boutons Like ou Share), combien de fois l'information s'imprime sur Facebook. Il donne l'exemple d'un site web, sans le citer. A chaque fois qu'un internaute actionne un bouton, le site récolte des visites. « Le mois dernier, 518 Share ont apporté 23 000 visites, soit environ 46 nouveaux visiteurs pour chaque Share. C'est ça la logique des Social plug-in et c'est pour cela que nous pensons que Facebook va vraiment se positionner comme un apporteur de trafic, gratuit avec la plateforme ou payant. C'est ce que nous essayons d'expliquer aux grands partenaires : vous allez faire venir sur vos sites du trafic qualifié parce qu'il vient à la suite d'une recommandation d'un ami. Et il s'agit généralement d'un trafic plus engagé que celui qui vient des algorithmes », conclut Julien Codorniou.

Les vertus du cloud public

Au cours de ce rendez-vous consacré aux développeurs, Facebook a également abordé la question de l'hébergement des sites sur les clouds publics « puisqu'il y a des gens dans la salle qui ont l'ambition de servir des millions de clients », a rappelé Julien Codorniou. L'événement se déroulant dans les locaux de Microsoft, ce dernier est venu parler de sa plateforme Azure. Néanmoins, l'interlocuteur choisi, Pierre Couzy, architecte en SI, s'est concentré sur des informations techniques sans s'égarer dans des digressions marketing. Il a dessiné l'anatomie d'une application cloud, un environnement où tout doit être redondant. A ses côtés, Laurent Letourmy, directeur technique de Weka Entertainment, spécialisé dans les jeux en ligne (1,7 million d'utilisateurs par mois dont les deux tiers jouent quotidiennement), passé sur le cloud d'Amazon en 2008. « Nous avons basculé l'application en deux heures et sommes passés en quelques semaines de milliers d'utilisateurs par jour à plusieurs millions. Grâce à Amazon, nous avons pu provisionner de la capacité. »

Plus d'un million d'euros dès la première année

A leur suite, La Redoute a témoigné de son expérience sur Facebook depuis août dernier où le groupe avait simplement 60 000 fans sur le réseau « et pas vraiment d'équipe », explique sa community manager. Avec l'aide d'une agence, la société a testé des opérations pour recruter d'autres fans en essayant de limiter ce coût d'acquisition. « Nous essayons d'être au-dessous de 1,20 euro ». Sur une opération particulière, le groupe a recruté 40 000 fans en 10 jours.

Enfin, le Facebook Developer Garage a donné la parole à trois sociétés de jeux en ligne, Kobojo, MakeMeReach et Antvoice, toutes jeunes start-up et qui pourtant, s'agissant des deux premières, ont atteint ou dépassé 1,5 million d'euros de chiffre d'affaires dès leur première année d'existence. MakeMeReach prévoit entre 6 et 8 M€ la deuxième année. Quant à Antvoice, qui n'existe que depuis trois mois, elle s'attend déjà à passer le cap du million d'euros de chiffre d'affaires sur son premier exercice. Trois sociétés dont les applications de jeux tirent parti de l'interaction sociale et qui misent sur l'effet viral pour se développer. (...)

Au coeur de la Silicon Valley : optimisation des SAN avec Virtual Instruments et cloud collaboratif avec Box.net (Part 4)

La première, Virtual Instruments, est aujourd'hui pilotée par une des légendes de la vallée, John W.Thompson, l'ancien CEO de Symantec, à l'origine du plus gros rachat logiciel (13,5 milliards de dollars par échange d'actions en 2005 pour l'acquisition chaotique de Veritas). Après une courte retraite et l'achat d'un restaurant à Paris avec sa femme, John W.Thompson a investi un peu d'argent dans Virtual Instruments avant de se voir proposer en mai 2010 la direction de l'entreprise. L'arrivée d'une telle personnalité est un atout pour la société issue d'un spin off de Finisar (juin 2008).

Le vétéran très écouté de la Silicon Valley, Jim W.Thompson, CEO de Virtual Instruments, également aux conseils d'administration de Seagate Technplogy, de Symantec et actionnaire d'une équipe de la NBA.

Depuis son détachement, la société a augmenté ses revenues de 150% de 2009 à 2010. « Nous n'avons pas de signes indiquant que nous ne pourrons pas doubler notre croissance en 2011 » assure confiant John W.Thompson. « L'environnement est devenu très complexe et garantir les performances d'un système une gageure ». C'est la base du métier de Virtual Instruments : fournir les outils permettant de mesurer et d'améliorer l'efficacité des solutions pour les réseaux de stockage SAN et d'optimiser les infrastructures virtuelles. Et comme les investissements en SAN sont toujours très lourds, il est possible d'améliorer l'existant avant de penser à étendre les infrastructures.

Une offre matérielle et logicielle

Virtual Instruments a ainsi développé des appliances (Protocol Analyser, ProbeFCX et Rover) et des outils de surveillance (Virtual Wisdom) pour améliorer ou simplement fournir une vision d'ensemble des performances des solutions de stockage en réseau. Le logiciel Virtual Wisdom assure par exemple le monitoring en temps réel des entrées/sorties des infrastructures virtualisées : baies SAN, serveurs et switchs FC. Des informations essentielles pour décider comment bien équilibrer les charges de travail entre les différents systèmes. « Nous avons discuté avec les différents constructeurs du marché pour adapter nos équipements à toutes les configurations », nous a confié le CTO de la petite compagnie, Skip Bacon.

Skip Bacon, CTO de Virtual Instruments très agacé par l'usage immodéré du mot cloud

Pour collecter les données, la solution Virtual Wisdom fonctionne à partir de sondes disséminées dans les différents éléments de l'environnement mis en place. « Notre solution peut d'ailleurs aider les constructeurs comme les clients à régler leurs problèmes. Avec la virtualisation, les utilisateurs ont perdu le contrôle de nombreux éléments et le cloud n'est pas la solution magique pour éviter d'utiliser des outils de monitoring ». Le très flegmatique directeur technique de Virtual Instruments est d'ailleurs très agacé par l'usage immodéré du terme cloud computing auquel il préfère le vocable datacenter automatisé. « Nos outils aident aujourd'hui les clients à améliorer les performances de leurs infrastructures virtualisées et surtout à mieux utiliser leurs équipements ». L'outil DashBoard VI collecte toutes les données sur les solutions de VMware pour comprendre ce qui se passe et mesurer les impacts sur l'infrastructure.

Parmi les clients de Virtual Instruments, on peut citer HP, eBay, Bank of America, Porsche, Bosch, IBM ou encore Logica.

Une start-up installée dans un hangar

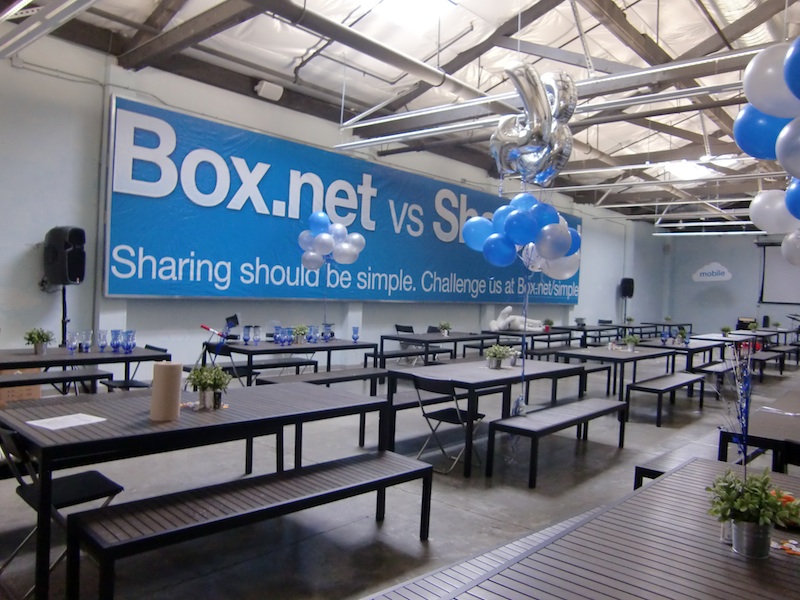

En fin de matinée, changement radical de décor. Après les bureaux cossus de Virtual Instruments, nous nous sommes rendus chez une start-up proposant une offre ECM installée dans un ancien entrepôt à côté du Fry's de Palo Alto. Créée en 2006, Box.net tente de conserver l'esprit bon enfant de ses débuts en proposant des patinettes, des balançoires, des fusils à fléchettes et un bar (sans alcool) gratuit à ses employés dans un vaste open space très bien éclairé (voir photo ci-dessous). L'ambiance est toutefois très studieuse comme l'y engage le très peu souriant directeur général de « la boite », Dan Levin.

Cette start-up, qui a déjà levé près de 70 millions de dollars et emploie 150 personnes aux États-Unis, se présente comme une alternative cloud à SharePoint ou Alfresco et propose un service de stockage et de partage de données en ligne. À la brique de base de Box.net vient s'ajouter de nombreux modules payants développés par des partenaires et disponibles sur une place de marché pour fournir d'autres fonctions ou se connecter à d'autres plates-formes (SAP ou SalesForce.com par exemple). Tous les services sont accessibles depuis un PC ou un Mac via un simple navigateur, mais aussi depuis des terminaux mobiles (iPhone, iPad, Android, Blackberry) depuis un browser ou une app dédiée. 5 millions d'utilisateurs sont déjà inscrits pour accéder aux différents services de Box.net. La version de base (jusqu'à 5 Go d'espace de stockage avec des fichiers ne dépassant pas 25 Mo) est d'ailleurs gratuite.

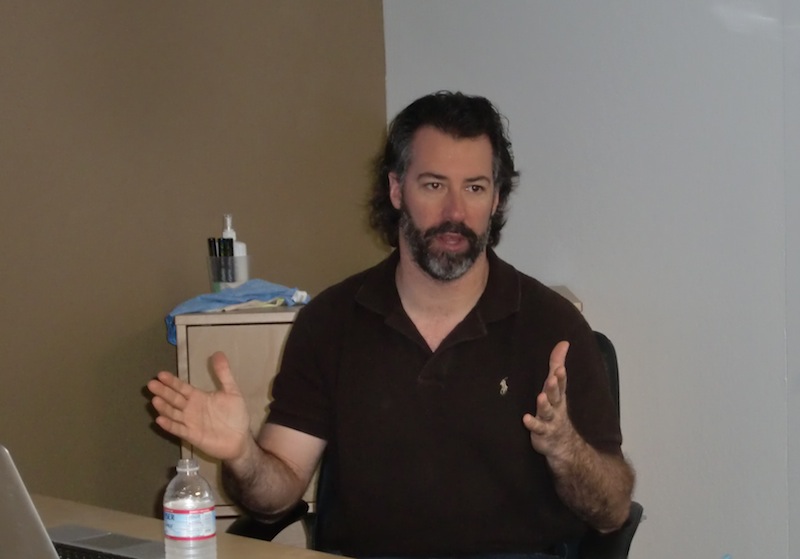

Dan Levin, directeur général de Box.net

Près de 60 000 entreprises utilisent déjà les services en ligne de Box.net et 73% d'entre elles figurent dans le classement Fortune 500 indique Dan Levin qui souligne encore que la start-up affiche huit trimestres de croissance. « Nous proposons des outils qui répondent aux besoins des nouveaux utilisateurs sur smartphones et tablettes sans passer par la complexité habituelle de nos concurrents ». Facturé de 15 à 25 dollars par mois et par utilisateur, le service de Box.net vient toutefois concurrencer l'offre BPOS de Microsoft qui pour 8,52 euros par mois et par utilisateur inclut Exchange, Sharepoint Office Live Meeting et Office Communication Oneline.

La cantine de Box.net sert des repas à midi mais également à 19 heures pour les salariés qui désirent encore travailler après le diner.

Les développements sont toutefois toujours conséquents pour accompagner la croissance de la start-up comme nous l'ont indiqué deux jeunes ingénieurs français (un polytechnicien et un centralien) travaillant chez Box.net. Les investissements en infrastructures restent également importants. Un second datacenter dans l'Est des États-Unis viendra bientôt épauler celui déjà installé en Californie.

(...)(27/04/2011 12:15:20)Avec la Precision R5500, Dell propose un accès distant sur une workstation en rack

Station de travail en rack, « la Precision R5500 effectue le rendu et restitue les pixels aux PC clients sur un réseau, » a déclaré Don Maynard, chef de produit senior pour les workstations chez Dell. Les graphiques sont transmis en 2D ou en 3D au client léger FX100 de Dell, lequel s'appuie sur le protocole graphique à distance PC-over-IP (Protocole Internet). Mais ils peuvent aussi passer par le logiciel View VMware pour être livrés à des ordinateurs de bureaux et des portables classiques. « Cette nouvelle fonctionnalité permet d'augmenter les ressources informatiques en apportant une puissance de traitement supplémentaire, » a indiqué Don Maynard.

La technologie d'accès à distance pourrait permettre de réduire le déploiement de postes de travail multiples et de centraliser les applications d'ingénierie et les applications graphiques en un seul endroit. « La station de travail est destinée aux entreprises impliquées dans des projets de conception ou de création de contenu, » a déclaré le chef de produit. Cette solution peut également s'avérer pertinente dans des industries verticales comme l'exploitation minière et les soins de santé.

Davantage de puissance graphique sur le réseau

« Dell propose déjà des serveurs équipés de processeurs graphiques, mais la station de travail présente des caractéristiques spécifiques bien adaptées aux PC clients, » a ajouté Don Maynard. Celle-ci tourne sous des systèmes d'exploitation client comme Windows 7, sur lequel on peut exécuter des applications d'ingénierie de type AutoCAD. La station de travail peut également fournir davantage de puissance de traitement pour effectuer les tâches graphiques spécifiques de ces applications. « La qualité des images délivrées à distance dépend de la complexité des graphiques et de la bande passante, » explique Don Maynard. Il peut y avoir une certaine latence si les graphiques sont complexes, ou si le PC se trouve loin de la station de travail.

En marge de ces capacités d'accès à distance, le Precision R5500 peut également faire office d'ordinateur de bureau haut de gamme capable de faire tourner des applications scientifiques et graphiques complexes. Le rack double socket intègre des processeurs Xeon d'Intel, et peut accueillir jusqu'à 12 coeurs. Il supporte jusqu'à 192 Go de RAM et possède des emplacements pour intégrer plusieurs unités de stockage. En option, Il peut être équipé de cartes graphiques Nvidia. La Precision R5500 sera disponible aux États-Unis et dans la zone EMEA (Europe, Moyen-Orient et Afrique), à partir du 3 mai, puis dans la zone Asie-Pacifique et au Japon, à partir du 10 mai. Son prix démarre à 2029,83€ HT.

Deux autres stations de travail nomades

Dell a également annoncé des stations de travail Precision portables, comme alternatives à la version desktop. Ces stations, du nom de DM4600 et DM6600 (voir ci-dessous), sont équipées respectivement d'écrans de 15,6 et 17,3 pouces et intègrent les derniers processeurs Core i5 et i7 d'Intel. Ces versions nomades supportent jusqu'à 32 Go de RAM et sont proposées avec un disque dur de 750 Go ou un disque SSD de 256 Go. Ceux-ci pourront recevoir en option des circuits graphiques AMD ou Nvidia. Côté connectique, les portables Precision présentent plusieurs connecteurs USB 3.0/2.0 et plusieurs ports d'affichage pour connecter différents écrans. Le prix de base du DM4600 est de 1 209,05€ HT, contre 1 805,71€ HT pour le DM6600. Ces deux modèles seront disponibles dans le monde entier à partir du 10 mai.

Ubuntu Server 11.04 se pare de ses habits Cloud

Le projet Natty Nahrwal se transforme définitivement en Ubuntu 11.04 le 28 avril. A cette date-là, la version server sera aussi disponible. Les grandes nouveautés de cette édition est l'orientation importante autour du cloud computing, comme le confirme Nicolas Barcet, responsable de l'offre cloud chez Canonical « ce marché devient important pour les serveurs et reste ouvert à l'émergence de nouveaux acteurs. Les OS sont un élément essentiel au sein du datacenter et nous devons donc être présent ». Pour ce faire, l'éditeur s'est reposé sur certains savoir-faire « Ubuntu fonctionne sous Eucalyptus (dont nous fournissons une mise à jour) qui est très axé vers les clouds privés, mais aussi avec « Cactus » d'OpenStack qui s'adresse plus à la gestion des serveurs » indique le dirigeant. Vis-à-vis des clouds publics, Ubuntu Server 11.04 fonctionne dans le cloud d'Amazon EC2 où l'éditeur a depuis 1 an intégré un package baptisé cloudinit, qui gère l'initialisation de l'instance dans le cloud.

Sur l'aspect serveur, Nicolas Barcet insiste sur plusieurs améliorations comme « l'installation automatique du matériel physique, l'intégration d'une base de données nommée Cobbler, une solution « Power Map » pour gérer la problématique des économies d'énergie (capable de mettre en veille et de réveiller les serveurs) et l'administration système via MCollective». Le Kernell a été aussi revu avec un meilleur support des puces Intel, des fichiers XFS, etc. L'éditeur indique également avoir renforcé ses partenariats avec Jonas et Java, Nicolas Barcet précise d'ailleurs qu'« Ubuntu 11.04 server a été homologué JEE 1.5 ».

La version deskstop prête pour les tablettes

A côté de la version serveur. La principale évolution est la disponibilité du gnome Unity. Cette interface graphique est l'ancienne netbook édition capable de gérer la 3D avec les cartes graphiques qui supportent OpenGL. Pour les anciens circuits videos, l'éditeur propose une version plus ancienne de l'interface graphique. L'intégration du multitouch laisse penser que l'éditeur est prêt pour une utilisation au sein des tablettes numériques. Si on ajoute à cela Ubuntu One, outil de synchronisation et de sauvergarde du bureau dans le cloud, la distribution Linux entend bien devenir plus accessible.

En matière de déploiement, Canonical inaugure le test d'Ubuntu Server sur Amazon. Le futur utilisateur pourra exécuter sur une instance du cloud d'Amazon la distribution Linux pendant 1 h. Ce service de test sera disponible à partir du 3 mai prochain.

Google détruit ses vieux disques durs afin de prévenir la fuite de données

Google « suit avec rigueur la vie de chaque disque dur, sa localisation et son état, » et les détruit, si nécessaire, en suivant un processus qui s'achève par l'envoi des différents éléments dans des centres de recyclage. « L'appareil qui sert à détruire les vieux disques durs est un concasseur, » explique le narrateur dans une des vidéos de Google. « Un piston en acier traverse le centre du disque et déforme définitivement les plateaux, ce qui les rend illisibles. »

La vidéo montre ensuite un puissant broyeur recracher des morceaux de disques utilisés pour stocker les données. « Comme vous pouvez le constater, personne ne sera en mesure de récupérer les données de nos clients à partir de ces éléments, » affirme encore le narrateur. En sort une demi-douzaine de boîtes remplies de morceaux de l'ancien disque dur, prêtes à être expédiées vers des centres de recyclage.

30 datacenters aux Etats-Unis

Au moment où Google est épinglé pour avoir collecté et stocké des données privées, y compris des fichiers de recherche et des données de localisation sur des téléphones Android, sa vidéo vient montrer que l'entreprise de Mountain View a peu de chance de perdre les données qu'elle entend conserver. Selon un article paru dans Data Center Knowledge, depuis 2008, Google exploite plus de 30 centres de calcul aux États-Unis et à l'étranger. La nouvelle vidéo dans laquelle on peut voir comment se passent les opérations dans le datacenter d'Hamina, en Finlande, rend compte des méthodes pratiquées dans l'ensemble des centres de Google. Néanmoins, Google fait savoir qu'elle utilise « des méthodes de protection supplémentaires » qu'elle ne peut divulguer publiquement.

Chaque datacenter est composé « de milliers et de milliers de machines » qui permettent de délivrer les résultats des recherches, gère les transactions du commerce en ligne, ou les services proposés aux clients de Google Apps. Chaque serveur, monté sur mesure, intègre une version allégée de Linux avec les éléments système et le hardware requis pour exécuter une tâche spécifique, ce qui réduit aussi les risques de vulnérabilités. D'après les informations de Google, toutes ses données client sont « stockées dans des emplacements multiples pour assurer leur fiabilité...

[[page]]

Les fichiers dans lesquels sont conservées les données ont été affectés de noms aléatoires et ne sont pas stockés en clair, de sorte qu'ils ne sont pas lisibles tel quel. » Une fois les anciens lecteurs détruits, Google affirme qu'elle conserve des sauvegardes supplémentaires sur des lecteurs à bande, ce qui lui permet de disposer « d'un niveau supplémentaire de redondance pour protéger les données de ses clients. » Il y a quelques mois, après une panne de Gmail qui avait entraîné la perte des emails de milliers de comptes, le stockage sur bande s'était avéré en effet très utile.

Un pied de nez à Amazon

C'est le 13 avril, juste avant la panne de l'Elastic Compute Cloud d'Amazon intervenue la semaine dernière, que Google a téléchargé sa vidéo sur YouTube, puis l'a mise sur un blog le lendemain de la panne. Les datacenters de Google sont connectés à Internet via de multiples câbles à fibres optiques redondants à haute vitesse pour se protéger contre les pannes, et disposent de générateurs de secours en cas de coupure de courant. En cas d'incendie, il est prévu que l'accès aux données client bascule automatiquement d'un centre à un autre.

Le problème d'Amazon était différent : la panne de l'EC2 résultait de ce qu'Amazon a appelé un « événement réseau, » qui « a déclenché une grande quantité d'opérations de mirroring » sur les volumes de stockage. Il en est résulté une pénurie des capacités de stockage, et a entraîné la déconnexion des machines virtuelles. » La vidéo de Google insiste beaucoup sur la sécurité physique : l'accès aux sites est étroitement contrôlé, les visites guidées ou les visites sur place sont interdites ; les véhicules sont inspectés avant leur entrée dans l'enceinte du site ; les badges pour accéder à l'intérieur des bâtiments sont difficiles à falsifier ; dans certains centres, Google a mis en place des systèmes biométriques avec reconnaissance de l'iris pour vérifier l'identité des employés ; des systèmes de vidéosurveillance automatisés permettent de détecter toute anomalie et d'alerter le personnel de sécurité ; certains centres utilisent même « des caméras thermiques sophistiquées » pour repérer des intrus potentiels, enfin, le personnel de sécurité de Google est équipé de véhicules électriques, de jeeps et de scooters pour parer à toute éventualité et il est en contact permanent avec les autorités locales, au cas où l'intervention de la police serait nécessaire.

Crédit photos : Jon Brodkin, IDG

| < Les 10 documents précédents | Les 10 documents suivants > |