Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 481 à 490.

| < Les 10 documents précédents | Les 10 documents suivants > |

(11/05/2011 17:26:32)

NetSuite propose un ERP "unlimited" pour les grandes entreprises

L'annonce de NetSuite, une compagnie fondée par Evan Goldberg et Larry Ellison, concerne moins l'arrivée d'un produit spécifique qu'une série de partenariats, de services, d'applications et d'améliorations technologiques destinées à répondre aux exigences des plus grandes entreprises mondiales. Le positionnement représente un changement en soi, puisqu'il éloigne NetSuite de sa base utilisateurs constituée en grande partie, depuis sa création en 1998, de petites et moyennes entreprises. « NetSuite Unlimited comprend notamment un nouveau partenariat avec l'entreprise de services Accenture, » a déclaré le CEO de NetSuite, Zach Nelson, dans une interview.

« Accenture a créé une application ERP (enterprise resource planning) au sein du logiciel de NetSuite, » a-t-il dit. « En outre, NetSuite a commencé à déployer la solution Exadata DataBase Machine d'Oracle dans son propre datacenter, de manière à pouvoir effectuer des opérations conjointes avec des applications tournant dans le centre de calcul de l'entreprise, » a encore déclaré Zach Nelson. « Au final, Exadata pourrait soutenir de plus larges instances d'applications détenues par des clients de NetSuite, et supporter des charges de travail plus gourmandes en ressources, comme dans l'e-commerce par exemple, » a ajouté le CEO de NetSuite.

Un ERP complémentaire

NetSuite ne s'attend pas à remplacer les solutions équivalentes de SAP et d'Oracle pour devenir le premier système ERP des grandes entreprises. Par contre, le vendeur compte bien servir de deuxième pilier dans une stratégie ERP « à deux tiers», selon laquelle son logiciel pourrait être déployé dans une filiale SAP ou auprès d'un nouveau revendeur Oracle s'installant dans le monde, pour le relier au noyau ERP principal. Microsoft, Epicor et d'autres fournisseurs de systèmes ERP ont adopté une stratégie marketing similaire.

Par ailleurs, Qualcomm aurait signé un contrat pour utiliser NetSuite dans certaines situations. Le logiciel de NetSuite « nous offre l'opportunité de centraliser certains éléments de nos systèmes de commerce électronique et de simplifier davantage encore le processus de gestion, » a déclaré dans un communiqué Peter Rubenacker, vice-président Information Technology chez Qualcomm. NetSuite a également l'intention d'étendre un accord signé avec l'entreprise de commerce électronique Groupon. Le site «la-bonne-affaire-du-jour » pourrait se retrouver sur NetSuite et alimenter 26 marchés internationaux. « La solution permettrait de remplacer des centaines de feuilles de calcul par un système hébergé ERP unique, » indique un communiqué. (...)

EMC World 2011 : Accélérer l'adoption du cloud

Paul Maritz, CEO de VMware a été le premier intervenant de ce deuxième jour de l'EMC World 2011 à Las Vegas. Pas d'annonces de la part de la société, mais une vision où il faut repenser l'IT et surtout les différentes couches de l'informatique traditionnelle. Très orienté vers le cloud hybride comme l'avait indiqué la veille Joe Tucci, Paul Maritz a décliné les propositions de VMware sur l'ensemble des briques (sécurité avec Vshield, commutation avec Vswitch, automatisation et design avec vCloud Director) qui composent cet environnement. Tous les composants sont là pour rassurer et accompagner les indécis vers le cloud. Il a indiqué « les mentalités doivent changer et ont changé dans l'IT » et d'ajouter que les prochains travaux de VMware porteront sur l'accompagnement de l'ère post PC et plus particulièrement autour du smartphone. « Les entreprises n'auront plus à payer un téléphone pour leurs employés, mais ils « virtualiseront » le smartphone de ceux-ci ». Cette virtualisation devra s'accompagner de la mise en place de règles de sécurité et d'usage particulier. « On doit être capable dans sa vie privée d'installer une version pirate d'Angry Birds sans se soucier de savoir si mes contacts professionnels risquent d'être transmis par le jeu » schématise le dirigeant de VMware.

Vplex Geo, la fédération de stockage distant prend de la distance

Retour au stockage avec VPlex, la solution d'EMC pour gérer les données sur de longues distances. Elle fédère un ensemble de service de stockage distant au sein d'une même entité de stockage virtuel. En 2010, Pat Gelsinger avait fait la démonstration d'un transfert de quelques machines virtuelles (26) sur une distance relativement faible, d'Hopkinton à Boston, VPlex local et Metro étaient nés. Aujourd'hui, la capacité a augmenté, plus de 2600 machines virtuelles ont été transférées entre Hopkinton et Las-Vegas (soit près de 2700 miles). Brian Gallagher, président de la division Storage a présenté Vplex Geo qui est une solution active/active, c'est-à-dire que la réplication des données se fait en quasi temps-réel. « Nous avons besoin d'un temps de latence inférieur à 50 millisecondes ». EMC a donc noué des partenariats pour l'accélération WAN avec les solutions de Silver Peak, Ciena, Brocade pour optimiser la gestion de la bande passante pour les applications. Brian Gallagher a aussi précisé que « VPlex Geo peut-être le trait d'union entre le cloud des fournisseurs de services et le datacenter des entreprises, il s'agit d'un facilitateur pour aller vers le cloud hybride » et d'ajouter que VPlex Global devrait s'affranchir de la distance en étant disponible sur l'ensemble du globe.

Quelques plus pour VNx et VMax

Si les annonces produits ont déjà été faites il y a quelques semaines, EMC a apporté quelques fonctionnalités supplémentaires sur son offre de stockage. Ainsi sur la partie haut de gamme, Symmetrix VMax va supporter nativement le FCoE (Fiber Channel Over Ethernet) et ainsi se connecter à terme aux infrastructures convergentes. D'autres fonctionnalités comme Federated Live Migration améliore la déplacement des applications d'un ancien système Symmetrix sur des solutions VMax. Enfin en matière de sécurité, EMC se repose sur l'expertise de RSA et propose Data Protection Manager pour sécuriser les données au sein de Symmetrix VMax. Toutes ces fonctionnalités seront disponibles à partir du mois de juin 2011.

Du côté des offres VNx, on notera l'apparition d'un connecteur pour l'appliance Google Search. Cette évolution devrait améliorer l'indexation des données au sein des sous-systèmes de stockage. Cela doit répondre à la problématique soulevée par Joe Tucci, le « déluge de data ». Pour Rich Napolitano, président de la division Stockage Unifié d'EMC « ce partenariat accélère la recherche des données au lieu de prendre des heures, il suffit des quelques secondes. La solution est dynamique, VNx envoie des alertes à l'appliance de Google qui indexe les modifications des données ». Par ailleurs, les baies VNx vont intégrer la Cloud Tiering Appliance, solution capable de déplacer des données obsolètes ou celles inutilisés vers un volume de stockage de bas niveau (dans le cloud par exemple).

(...)(10/05/2011 14:02:30)Dell dope les environnements virtualisés avec un serveur lame quadri-sockets

Pour les environnements virtualisés, Dell vient d'annoncer un serveur lame à quatre sockets intégrant jusqu'à 48 coeurs processeurs. « Le PowerEdge M915 exploite des processeurs Opteron 6100 d'AMD qui acceptent jusqu'à 12 coeurs », a indiqué Mike Roberts, chef de produit senior chez Dell. Le nombre élevé de coeurs permet d'augmenter le nombre de machines virtuelles disponibles. Ce serveur lame est aussi capable de faire tourner d'importantes applications de type bases de données. « Grâce à ses débits rapides, le PowerEdge M915 augmente les performances du serveur en environnements virtualisés », a ajouté le chef de produit. Le serveur quadri-sockets de Dell comporte quatre ports Ethernet 10-Gigabits et accepte des cartes adaptatrices pour ajouter des ports réseaux supplémentaires. Selon Dell, l'agrégation de six ports Ethernet 10-Gigabits permet le transfert de données à 120 gigabits/sec.

Sous Windows Server, RHEL ou SLES

Le serveur précharge sur une carte SD interne l'hyperviseur ESXi de VMware, lui-même un élément du logiciel de virtualisation vSphere 4.1 de VMware. Le serveur peut aussi être livré avec les logiciels de virtualisation Hyper-V de Microsoft et XenServer de Citrix. Il accepte jusqu'à 512 Go de mémoire vive et offre 2 To de stockage en interne. Windows Server, Red Hat Enterprise Linux (RHEL) ou Suse Linux Enterprise Server (SLES) de Novell font partie des systèmes d'exploitation proposés en option. Le PowerEdge M915 s'installe dans un châssis M1000e pouvant accueillir jusqu'à huit lames, soit un total de 384 coeurs processeurs. Il sera disponible partout dans le monde à la fin du mois de mai à un prix démarrant à 3 500 dollars.

Ce serveur sera compatible avec les futures puces Opteron d'AMD - nom de code Interlagos - qui pourront intégrer jusqu'à 16 coeurs. AMD devrait commencer à livrer ces puces, construites sur la microarchitecture Bulldozer, à partir du troisième trimestre de cette année. Pour l'instant, Mike Roberts a indiqué que Dell était en train de tester ces nouveaux processeurs, mais a refusé de préciser la date à laquelle le constructeur commercialiserait les serveurs qui les exploiteront.

Illustration : Châssis M1000e - Le PowerEdge M915 s'installe dans un châssis M1000e pouvant accueillir jusqu'à huit lames. (...)

EMC World 2011 : Cloud et Big Data à la croisée des chemins

Après une édition 2010 rythmée par l'accompagnement des entreprises dans leur voyage dans le cloud, le millésime 2011 d'EMC World qui se déroule à Las Vegas a pris deux orientations : le cloud et les « Big Data ». Pour le premier, il s'agit à la fois d'accélérer l'adoption de l'informatique en nuage en mode privé, mais aussi vers le cloud hybride. Joe Tucci (photo ci-dessus), CEO d'EMC, a indiqué dans sa présentation inaugurale que 30% des entreprises ont sauté le pas vers le cloud en 2010, et que 35% supplémentaires le feront en 2011. « De plus en plus de fournisseurs de services proposent des offres de cloud public et nos clients souhaitent profiter de ces avantages et établir des passerelles avec leur datacenter ». Or pour entrer dans le cloud hybride, les clients sont confrontés à une problématique qui va devenir de plus en plus pesante, le traitement et la gestion des Big Data. « En 2010, 1,2 zetabytes de données se sont échangés, nous prévoyons dans la prochaine décennie la circulation de 35 zetabytes de données », explique Joe Tucci avant d'ajouter : « Nous sommes à l'intersection d'une énorme opportunité ». Il a rappelé que c'est dans ce cadre qu'est intervenu le rachat de Greenplum et Isilon.

Le projet Ligthning se dévoile

A ceux qui attendaient des annonces produits, le millésime 2011 d'EMC World est resté plutôt discret. Il faut dire que la présentation de la refonte de la gamme de stockage du fabricant a eu lieu au mois de janvier dernier à Londres. Pat Gelsinger (ci-dessous), président et COO de la société, a donc égrené la liste des récents lancements, la série VNX, y compris le VNXe pour l'entrée de gamme, jusqu'au VMax pour le haut de gamme. La nouveauté est intervenue sur le projet Lightning. Il s'agit d'une carte PCI express pour serveur capable d'accélérer les échanges d'entrées/sorties entre le serveur et les solutions de stockage. Ces cartes s'appuieront sur la technologie FAST d'EMC et selon Pat Gelsinger, « elles sont similaires à ce que fait Fusion-IO, même si les nôtres seront spécifiques ». Il est par contre resté évasif sur les partenaires technologiques, même si Intel travaille dans cette direction. Le rapprochement vers les serveurs a immédiatement provoqué des interrogations sur les ambitions d'EMC sur ce marché. Pat Gelsinger a été catégorique : « Nous n'irons pas concurrencer HP et IBM » et d'ajouter « dans les démonstrations, nous avons pu migrer une VM sur une baie de stockage, c'est très intéressant ». Les premières cartes ont été livrées en version bêta à certains clients testeurs.

Pat Gelsinger, président et COO d'EMC

Une division Big Data en ordre de marche

Du côté de Greenplum, acquise en juillet 2010, l'intégration a été rapide. Scott Yara, co-fondateur de Greemplum a indiqué qu'une entité spécifique a été créée au sein d'EMC, baptisée Data Computing Product Division. Celle-ci dispose de 150 salariés et prévoit d'atteindre 600 personnes d'ici la fin 2011. Côté produit, il faudra attendre le troisième trimestre pour voir apparaître une appliance de la nouvelle structure. Difficile d'en savoir plus sur le produit, Scott Yara et Luke Lonergan, CTO de Greenplum indiquent seulement que l'appliance intègrera des puces Intel et des disques standards. Autre annonce, le rapprochement avec la distribution Open Source Apache Hadoop. Cette dernière est annoncée comme plus rapide que celle existante (notamment avec Cloudera). L'objectif est à terme de construire « une brique complète d'analyse des Big Data » précise Scott Yara.

Illustration d'ouverture : Joe Tucci, CEO d'EMC.

VMware intègre son outil d'automatisation avec Active Directory

En ajoutant l'intégration de son outil vCenter Orchestrator avec l'annuaire Active Directory de Microsoft, VMWare continue à faire évoluer les produits de gestion automatisée pour les environnements virtuels privés et publics. « Quels que soient les outils ou la quantité de personnel disponible dans une entreprise, l'automatisation est la seule méthode « miraculeuse » pour faire évoluer le cloud computing en accord avec la demande et son mode de fonctionnement », écrit Thomas Corfmat, chef de produit senior chez VMware, dans un post récent. VMware espère que les départements informatiques des entreprises choisiront vCenter Orchestrator pour automatiser des tâches que les administrateurs exécutent manuellement. Selon le responsable de produit, l'outil de VMWare, qui dispose d'une interface graphique pour créer des workflows automatisés, doit permettre à la pile cloud VMware de s'intégrer à l'environnement et aux processus d'un client afin de contribuer « à réduire les coûts et à accroître les performances. »

Créer un compte utilisateur et un mot de passe

Le plug-in vCenter Orchestrator de VMware pour Active Directory (AD) de Microsoft permet d'automatiser la gestion des tâches des services d'annuaire. Compatible avec les versions 2003 et 2008 d'AD, il est livré avec 34 modèles de flux prêts à l'emploi, dont un pour créer un compte utilisateur dans un groupe de travail et définir un mot de passe. « Cette fonction a l'air d'une action de base, mais c'est en réalité une tâche de gestion très importante, car le fait de l'automatiser permet d'atténuer le risque d'erreur de la part de l'administrateur », explique Fredrik Rynger (en photo), chef de secteur chez VMware. Les utilisateurs peuvent modifier ces modèles de workflows prédéfinis pour en créer d'autres plus complexes et les adapter à leurs besoins. En plus du plug-in pour Active Directory, il en existe aussi pour Cloud Director de VMware et Unified Computing System (UCS) Manager de Cisco. « D'autres nouveautés vont arriver, comme la possibilité, très utile, d'intégrer les systèmes de stockage », a également annoncé Fredrik Rynger.

VMware continue à travailler sur vCenter Orchestrator

vCenter Orchestrator est inclus dans vCenter Server de VMware et peut être associé à un certain nombre de solutions existantes déjà proposées par l'éditeur. « De nombreux services informatiques s'appuient encore sur les scripts pour automatiser certaines tâches de gestion, mais à mesure que les systèmes deviennent de plus en plus conséquents, ils sont en train de changer de méthode », explique le chef de secteur. VMware continue à travailler au développement de vCenter Orchestrator. Thomas Corfmat pense que « l'automatisation ne se généralisera pas tant qu'elle ne pourra pas être déployée en quelques minutes plutôt qu'en plusieurs heures ou en quelques jours,» comme il l'a écrit. « C'est ce à quoi nous travaillons », a assuré le responsable produit.

Illustration : Fredrik Rynger, chef de secteur chez VMware (crédit : Joel Asblom / IDG Stockholm)

D'ici à 2015, ARM pourrait capter 15% du marché du processeur pour PC

Alors que ARM accélère le développement de ses processeurs pour ordinateurs portables et ordinateurs de bureau, IDC avance que d'ici 2015, le fondeur captera 15 % du marché des microprocesseurs pour PC. Dans sa prévision, le cabinet d'étude ne comptabilise pas les processeurs ARM pour tablettes, qui, selon l'analyste, dérivent de ceux pour smartphones. ARM, qui vend sous licence ses designs d'architecture à des fabricants de puces, est actuellement quasiment absent du marché des processeurs x86 pour PC, dominé par Intel et AMD. « ARM pourrait récupérer des parts de marché au moment où les consommateurs considèreront les options offertes par Windows 8, puisque le futur OS de Microsoft tournera sur les processeurs basse énergie de ARM, » a déclaré Shane Rau, directeur de recherche dans le domaine des semi-conducteurs pour le cabinet d'études.

Il n'y a pas si longtemps, ARM affirmait qu'une entrée sur le marché du PC n'était pas sa priorité. Warren East, le CEO de l'entreprise, avait même déclaré au début de l'année qu'ARM continuerait à se concentrer sur le marché des tablettes et des smartphones, justifiant que leur volume ne cessait de croitre. Celui-ci avait même confié qu'une introduction de ARM sur le marché du PC serait « extrêmement coûteuse pour l'entreprise, pour un gain franchement minime, » compte tenu de la domination du marché par Intel. Les processeurs ARM équipent déjà la plupart des tablettes et des smartphones du marché, alors que la première puce Intel pour tablette tactile, nom de code Oak Trail, vient seulement d'apparaître dans certains dispositifs ce mois-ci.

Windows 8 sur puces x86 et ARM

Mais la vraie nouveauté, c'est que Windows 8, le prochain système d'exploitation de Microsoft, tournera à la fois sur processeurs Intel et ARM, et pourrait susciter un intérêt pour des ordinateurs portables ARM. Des fabricants de processeurs comme Nvidia, Qualcomm et Texas Instruments ont déjà annoncé que leurs puces ARM pourraient exécuter Windows 8. Nvidia développe également des puces - nom de code Project Denver - destinées aux mobiles, aux PC et aux serveurs. De leurs côtés, Qualcomm et TI disent ne pas avoir l'intention de développer des puces pour PC, et affirment qu'ils continueront à fabriquer uniquement des puces à base d'ARM pour terminaux mobiles. « Mais si les opportunités sont là, les fabricants pourraient développer des puces pour ordinateurs PC à base de processeurs ARM, » a estimé Shane Rau.

[[page]]

« Les netbooks intégrant des processeurs ARM pourraient aider le fondeur à pénétrer le marché des PC, pour s'étendre ensuite aux ordinateurs de bureau, aux portables et aux serveurs, » a ajouté l'analyste. Des serveurs équipés de processeurs ARM pourraient être utilisés pour distribuer des fichiers multimédias ou des pages web, avec des performances largement suffisantes, tout en émettant moins de chaleur. Des netbooks intégrant des processeurs ARM - ils sont appelés smartbooks - sont déjà disponibles, mais ils utilisent des processeurs pour smartphone qui ne sont pas qualifiés pour tourner sur des ordinateurs PC, comme l'a précisé Shane Rau. « La domination d'ARM dans le domaine des tablettes et des smartphones pourrait s'étendre au PC, » estime l'analyste. « Les utilisateurs de tablettes à base d'ARM peuvent opter pour un PC ARM pour pouvoir exécuter les mêmes applications sur les deux machines, de la même façon que les utilisateurs PC tournant sur des puces x86 peuvent être attirés par des tablettes à processeur Intel, » explique Shane Rau.

Attirer les développeurs sur Windows 8 pour ARM

Microsoft a donné à ARM une raison d'envisager une entrée sur le marché du PC. « Mais le fondeur va devoir investir lourdement pour attirer les développeurs et les inciter à écrire des applications pour son architecture, » a ajouté l'analyste, la plupart des PC utilisant des logiciels écrits pour l'architecture x86. « ARM devra également réaliser des améliorations essentielles pour adapter ses puces au profil du PC, » estime encore Shane Rau. Notamment, ARM devra introduire dans ses architectures des fonctionnalités qui répondent aux performances des PC, comme l'adressage 64 bits, des connexions internes rapides, plus de mémoire et le multicoeur.

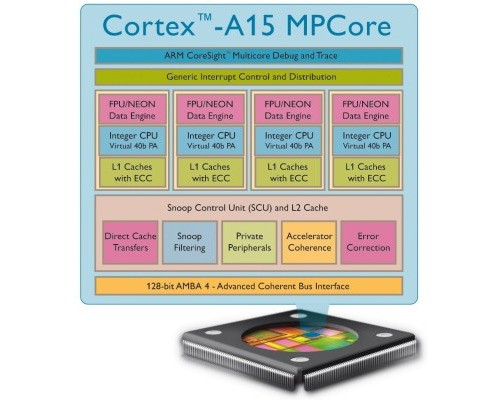

En septembre, le fondeur a annoncé qu'il travaillait sur un processeur Cortex-A15 capable de fonctionner à des vitesses allant jusqu'à 2,5 GHz et extensible à 16 noyaux dans certaines configurations. Pour l'instant, le Cortex-A15 fonctionne avec un adressage 32bits - il peut être étendu à 40 bits - mais les responsables de ARM envisagent d'ajouter l'adressage des instructions 64 bits à leurs futurs processeurs. Des tablettes et des smartphones équipés de processeurs Cortex-A15 devraient également apparaître sur le marché à la fin de l'année prochaine ou début de 2013.

Intel arrive mieux armé sur le marché mobile

De son côté, Intel ne lâche pas la pression sur ARM et fait de rapide progrès dans ses technologies de fabrication. Le fondeur vient ainsi d'annoncer des puces à transistor 3D, plus rapides et plus économes en énergie que les transistors à deux dimensions utilisés dans ses processeurs actuels. « ARM réussira, s'il apporte aux utilisateurs finaux sur PC les bonnes fonctionnalités, » conclut Shane Rau.

Crédit photo : ARM

Après le SAN, Brocade affiche ses ambitions sur le cloud (MAJ)

Brocade, qui annonce des équipements FC 16G et travaille déjà sur une déclinaison 32G, attendue dans les trois ans, affiche également son intention d'accompagner ses clients désirant migrant leurs ressources IT vers le cloud computing. Le programme CloudPlex définit les composants chez Brocade et chez ses partenaires qui sont nécessaires pour arriver à ce que l'équipementier appelle la « entreprise virtuelle ». L'été dernier, la compagnie avait déjà introduit son architecture Brocade One (VCS ou Virtual Cluster Commutation) pour proposer une solution de virtualisation à destination des datacenters ou comment accéder à n'importe quel élément depuis n'importe quel chemin. Avec son programme CloudFlex, l'équipementier désire aujourd'hui montrer aux utilisateurs comment s'y prendre.

Tous les principaux équipementiers poussent aujourd'hui leur vision du cloud computing pour mieux vendre leur architecture. CloudPlex et ses produits associés luttent contre Cisco Nexus / FabricPath, QFabric récemment dévoilé chez Juniper, les commutateurs Arista de la série 7000 et leur Extensible Operating System, Vena d'Avaya, les switchs Applications Fluents d'Alcatel-Lucent, sans oublier les plates-formes et propositions de Siemens Enterasys, d'Extreme Networks et de Force10 Networks.

Un marché très disputé

- Les réseaux composés de fabrics Ethernet et Fibre Channel sont les bases de CloudPlex, à savoir les matrices de commutation Ethernet VDX et Fibre Channel, notamment les nouveaux équipements SAN 16G. Dernière caractéristique, le support du Trill pour améliorer les connexions dans les datacenters.

- Les adaptateurs réseaux multiprotocoles Brocade CNAs qui simplifient la consolidation des Entrée/Sortie des serveurs

- Les outils de répartition de charge Brocade ServerIron - nécessaires pour équilibrer le trafic réseau entre les datacenters distribués.

[[page]]

Les briques à venir dans les prochains mois :

- Les solutions virtualisées, intégrées et rackées, Brocade Virtual Compute Blocks composées de ressources serveur, réseau et stockage. L'équipementier indique qu'il permettra à ses partenaires intégrateurs de systèmes de livrer Virtual Compute Blocks pré-groupé et pré-configuré. "Le souci avec l'entreprise virtuelle, c'est que c'est un problème trop important pour qu'une seule entreprise puisse le résoudre ", a ainsi expliqué Dave Stevens, CTO de l'équipementier lors de la conférence Brocade Technology Day 2011 à San José. La société combine donc des serveurs et des systèmes de stockage fournis par Dell, les équipements réseau maison VDX et l'hyperviseur de VMware pour la partie virtualisation. Les différentes briques porteront le logo Brocade, mais les clients seront en mesure de les commander auprès de Dell un peu plus tard dans l'année.

- Une plate-forme de type fabric capable de supporter un certain nombre de technologies IP, SAN et mainframe, notamment l'extension Virtual Private LAN Services (VPLS), Fibre Channel sur IP (FCIP) et FICON.

- Une extension de la technologie Brocade Fabric ID appelée "Cloud ID" qui permet l'isolement et la mobilité des machines virtuelles pour les environnements de cloud computing nativement multitenant.

- Un cadre de gestion, d'allocation dynamique et d'intégration visant à promouvoir l'interopérabilité entre les fournisseurs de services cloud computing. Il s'agit notamment d'assurer la compatibilité des produits Brocade avec les logiciels libres OpenStack - pour le stockage, les ressources serveur et les capacités réseau - et les fonctionnalités SDN (Software Defined Networking) d'OpenFlow.

L'ouverture vers OpenFlow et OpenStack peut être un autre facteur de différenciation pour Brocade et CloudPlex, affirment certains analystes. « Ils ont été conçus pour être beaucoup plus ouverts», explique Zeus Kerravala du Yankee Group. « Ils essaient de suivre la ligne définie par les standards. Ils sont ouverts beaucoup plus que quiconque dans l'industrie. »

Montée en puissance des produits FC

Brocade espère également ouvrir de nouvelles opportunités de ventes avec ses produits FC 16G. Ces équipements qui ont été conçus pour aider les entreprises à migrer vers des clouds privés exploitant l'architecture CloudPlex, incluent le châssis Fibre Channel DCX 8510, épine dorsale d'un réseau SAN, ainsi que le commutateur FC 6510, l'adaptateur fabric 1860, et le logiciel de gestion Network Advisor 11.1. La version 7.0 de l'OS de Brocade accompagne la sortie de ces équipements.

Le DCX 8510 travaille avec les produits FC Brocade déjà installés. En 2010 la firme de San José détenait 54% du marché de la commutation SAN (929 millions de dollars environ), selon le Dell'Oro Group. En plus de doubler la vitesse, ce châssis améliore l'utilisation de la bande passante, supporte le cryptage et arrive avec des fonctions de diagnostic améliorées, dixit Brocade. Disponible avec quatre ou huit emplacements, le DCX 8510 supporte jusqu'à 384 ports 16 Gbit et offre une bande passante 8,2 Térabits. La consommation d'énergie est de 0,27 watt par Gigabit

Brocade annonce également la commercialisation du switch 6510, qui a été conçu pour accompagner les serveurs notamment dans le cadre de projets de virtualisation de bureau. Il s'agit d'un appareil 1U qui peut accueillir de 24 à 48 ports 10 Gigabit Ethernet et offrant un débit cumulé de 768 Gigabits. Il consomme 0,14 watt par Gigabit.

[[page]]

Pour les serveurs eux-mêmes, Brocade a dévoilé l'adaptateur 1860 Fabric. Le 1860 prend en charge Fibre Channel, Fibre Channel over Ethernet (FCoE) et la connectivité Ethernet sur une seule carte afin de consolider les connexions au réseau local et SAN. Pour la connexion aux commutateurs, il supporte à la fois les liens FC 16G et Ethernet 10G.

Pour gérer les clouds privés, Brocade propose network Advisor 11.1. Cette version du logiciel de gestion des LAN et des SAN de l'équipementier augmente ses fonctionnalités avec le support des adaptateurs pour serveurs et des VM, et apporte une intégration plus étroite les réseaux Ethernet filaire et sans fil, et les environnements SAN pour l'interaction entre le cloud et les ressources disponibles.

Le lien avec les outils EMC Resource Management Suite et HP Virtual Connect Enterprise Storage Provisioning a également été renforcé.

Enfin, Brocade livre une nouvelle version de son système d'exploitation Fabric OS avec ses équipements. Fabric OS 7.0 offre des fonctionnalités spécifiquement conçues pour la virtualisation et les clouds. La société a notamment amélioré les notifications de congestion et le suivi de la performance.

Les nouveaux produits seront disponibles plus tard ce trimestre. Comme Brocade ne vend rien en direct les tarifs sont fournis par les partenaires OEM.

Ethernet pour accompagner le développement du cloud

Pour le cloud public, Brocade étend et améliore sa gamme de produits pour les fournisseurs de service. Une carte Ethernet 100G deux ports - la 100G MLX annoncée l'année dernière - est maintenant disponible. L'équipementier va également ajouter une lame huit ports 10GE au MLX-32 pour permettre au routeur de monter à 256 ports pour les offres de services cloud computing. La carte utilise 45% d'énergie en moins que les précédentes cartes 10GE pour le MLX, selon l'équipementier.

La société propose également le routeur NetIron CER doté du logiciel 5.2 qui offre des fonctions avancées d'interopérabilité avec les protocoles IPv4 et IPv6 et supporte un plus grand nombre de routes.

Brocade a également dévoilé le switch « bon marché » 6910 (12 ports Gigabit Ethernet) pour étendre les services Ethernet, collecter le trafic mobile ou équiper les opérateurs « sur le dernier kilomètre ». Les applications visées sont l'accès métropolitain des entreprises, la collecte des réseaux cellulaires 4G/LTE, ou le routage de datacenter.

Les équipes de Brocade ont également donné quelques détails sur le châssis VDX 10G qui sera en mesure d'accueillir plus de 750 ports 10 Gigabit Ethernet et plus de 100 ports 100 GE. Il supportera également les liens 40 Gigabit Ethernet. Le commutateur sera basé sur la même pile logicielle et le même ASIC que la ligne VDX actuelle.

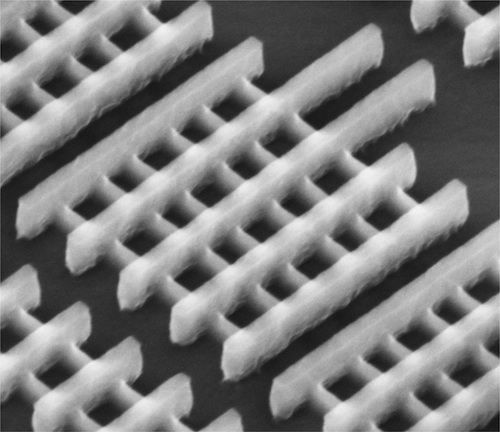

Des transistors 3D dans les futures puces Intel

« Cette nouvelle technologie processeur à transistors Tri-Gate remplacera les transistors plats à deux dimensions par une structure 3D, » a déclaré Mark Bohr, Senior Fellow d'Intel. Le transistor MOS (Metal Oxyde Semiconductor) planar classique à deux dimensions est remplacé par un mince aileron en trois dimensions qui sort verticalement du substrat de silicium. Autrement dit la zone active ne se trouve plus sous la grille, mais insérée dans la grille. « La technologie Intel permettra de créer des transistors plus rapides, plus petits et plus économes en énergie, » a ajouté Mark Bohr.

Cette technologie pourra bénéficier à différentes lignes de produits d'Intel, depuis les serveurs les plus rapides jusqu'aux puces basse énergie que l'on trouve dans les smartphones. « Nous devons continuellement innover pour créer de nouveaux matériels et de nouvelles structures», a déclaré à San Francisco Mark Bohr lors d'une conférence de presse diffusée sur Internet. « Avec le 22 nm nous apportons une nouvelle structure. »

Des puces plus rapides à terme

Les puces à transistors Tri-Gate seront 37 % plus rapides que les processeurs actuels d'Intel fabriqués selon le processus à 32 nm. Les transistors 3D consomment également deux fois moins d'énergie que les transistors 2D intégrés aux processeurs 32 nm. « Is seront également moins chers à produire, » a déclaré le chargé de recherche d'Intel. Comme l'a annoncé Dadi Perlmutter, vice-président exécutif et directeur général de l'Intel Architecture Group, les prochains processeurs Atom basse énergie, dédiés aux tablettes, aux netbooks, aux smartphones et aux terminaux numériques, bénéficieront de cette technologie. Les puces à transistors 3D seront « puissantes » en terme de performance et « économes » sur le plan de la consommation d'énergie, a ajouté le vice-président. « Le nouveau design pourrait aider Intel à rattraper les fondeurs concurrents qui fabriquent des processeurs à base de chip ARM, » a encore déclaré Dadi Perlmutter.

[[page]]

Considérés comme plus économes en énergie que les processeurs x86 d'Intel, ces processeurs ARM sont utilisés dans la plupart des tablettes et smartphones actuels. Selon Mark Bohr, Intel, qui mène des recherches sur le transistor Tri-Gate depuis une dizaine d'années, sera le premier fondeur à mettre cette technologie en fabrication. « D'autres entreprises se sont aussi intéressées aux transistors 3D, mais elles n'envisagent pas de les utiliser avant que la technologie de gravure à 14 nm ne soit au point, soit pas avant plusieurs années, » a avancé le chercheur. « Construire des processeurs, c'est comme construire des gratte-ciel : il faut ajouter plus de transistors tout en maintenant la densité et la taille des puces, » a encore déclaré Mark Bohr.

Revenir dans le cadre de la loi de Moore

Grâce au transistor 3D, Intel peut continuer à inscrire la technologie dans la loi de Moore, qui prône le doublement du nombre de transistors tous les deux ans. « Les difficultés rencontrées pour développer un modèle planar plus performant devenaient extrêmes, » a expliqué le chercheur. « La technologie des transistors 3D à l'air de concerner un détail obscur, mais elle ouvre des perspectives de développement importantes, » a déclaré Dean McCarron, analyste senior chez Mercury Research. « Nous avons tendance à perdre de vue que ce genre de technologie de haut niveau... est liée à la qualité d'un transistor, » a ajouté l'analyste.

« La structure en trois dimensions augmente les zones de contact sur les transistors, plus petits, mais sur lesquels on peut faire passer davantage de courant, » a indiqué l'analyste. C'est essentiel pour étendre la performance des transistors. « Les risques d'avoir un défaut sur une puce augmentent au fur et à mesure que l'on ajoute des couches à la verticale, » explique Dean McCarron. « Le fait qu'Intel ait décidé de se lancer dans la production prouve que le système est au point. Le fondeur doit encore faire les bons choix, » a estimé l'analyste.

Une nouvelle usine en Arizona

Tous les deux ans, Intel fait évoluer ses processus de fabrication et produit des puces plus petites qui offrent de meilleures performances, tout en étant moins gourmandes en énergie. Les premières puces - nom de code Ivy Bridge - à utiliser le processus à 22 nm seront destinées aux PC de bureau. Elles offriront entre autres un support matériel pour les dernières technologies graphiques DirectX 11. Intel a également déclaré qu'elle livrerait des processeurs 22 nm pour tablettes en 2013.

En octobre de l'année dernière, le fondeur avait annoncé qu'il allait investir entre 6 et 8 milliards de dollars US pour la fabrication de nouvelles puces pour PC, smartphones, appareils électroniques grand public et équipements embarqués. Une partie de ces investissements seront consacrés à la mise à niveau des usines pour fabriquer des puces 22 nm. En février dernier, l'entreprise de Redmond a également annoncé qu'elle allait investir 5 milliards de dollars pour construire une nouvelle usine en Arizona destinée à la fabrication de ces nouvelles puces. Celle-ci devrait être achevée en 2013.

Shell installe des outils collaboratifs sur un cloud hybride

Shell devait accroître la collaboration et la fluidité de celle-ci entre des équipes très éclatées. Pour atteindre cet objectif, le pétrolier a décidé de mettre en place des outils en ligne accédant à une base unique mondiale pour partager des documents et échanger des informations. Pour gagner en flexibilité et baisser les coûts, la DSI de Shell a choisi de déployer cette solution en SaaS.

Le pétrolier a signé un contrat avec T-Systems et Microsoft pour déployer BPOS, Sharepoint et Fast Search sur un cloud hybride opéré par T-Systems. Le déploiement mondial a débuté en avril 2011. Selon Microsoft, Shell sera l'un de ses plus importants clients mondiaux pour cette offre.

Le coût du projet n'a pas été dévoilé.

IBM veut porter les technologies de Watson dans les entreprises

« IBM espère que les technologies sous-jacentes de Watson pourront être exploitées dans des domaines où il s'agit de fournir des réponses précises à des requêtes complexes, via des interfaces faisant appel au langage naturel, » a déclaré la semaine dernière Guru Rao, ingénieur système en chef chez IBM. « Appliquées aux entreprises, les technologies sous-jacentes de Watson pourraient analyser des montagnes de données structurées ou non structurées, et donner des réponses auxquelles on pourra accorder un niveau de confiance élevé. »

Selon le chercheur, les technologies de Watson seraient applicables à de nombreux secteurs. Par exemple, les services de santé pourraient bénéficier de réponses précises pour diagnostiquer des maladies ou des banques pourraient détecter des fraudes à la carte de crédit en temps réel. Ces technologies pourraient également être utilisées dans des affaires juridiques pour fournir des réponses pertinentes fondées sur des recherches prenant en compte les éléments de preuves disponibles. « Dans le domaine de la santé, plus on dispose d'informations sur les maladies, plus notre connaissance est précise. Avec un système de requêtes utilisant les formulations du langage naturel, on pourrait profiter d'un degré de précision encore plus élevé, » a déclaré Guru Rao.

Au mois de février, lors de la finale du Jeopardy opposant l'homme à la machine, le supercalculateur Watson d'IBM a battu les champions en titre Brad Rutter et Ken Jennings. Le jeu a montré que des ordinateurs pouvaient répondre à des questions demandant un niveau élevé de réflexion, un peu comme les humains. Watson a répondu aux questions posées par l'animateur (l'ordinateur ne parle pas, mais ses réponses ont été lues par une voix de synthèse). Des statistiques sur le degré de pertinence des réponses étaient aussi affichées sur un écran.

Un supercalculateur conçu dans un but précis

« Watson repose sur une architecture avec des processeurs Power7 en parallèle affichant un total 2 680 coeurs environ, » a expliqué le chercheur. « Sur les 15 To de données stockées dans sa mémoire, seul 1 To a été utilisé pour répondre aux questions, » a ajouté Guru Rao. Des algorithmes spécifiques ont permis le traitement des requêtes en langage naturel, tandis que d'autres logiciels et algorithmes ont pris en charge les requêtes en les associant à des mots-clés, des réponses connues et d'autres informations stockées dans le système. « Ce dernier a pu traiter l'information en parallèle en conservant les données en mémoire, ce qui réduit les temps de latence et les problèmes de lecture/écriture quand les données sont stockées sur un disque, » a déclaré le chercheur.

« Grâce au traitement des données en mémoire, à ses capacités d'analyse et au matériel extrêmement performant dont il est composé, Watson a répondu aux questions en deux à trois secondes, » a ajouté Guru Rao. Celui-ci a notamment utilisé le General Parallel File System d'IBM (GPFS) et des logiciels comme Hadoop, lequel fournit une plate-forme pour analyser des données structurées et non structurées en parallèle à travers plusieurs serveurs. « IBM va probablement travailler avec des partenaires pour construire des architectures serveur autour de Watson, utilisables en entreprise, » a encore déclaré l'IBMer. Les technologies logicielles de Watson pourraient être adaptées à des appareils dédiés à des fonctions spécifiques, comme la sécurité et la conformité.

Des améliorations constantes

Watson atteste des progrès réalisés dans le domaine informatique. En 1996, son ancien collègue Deep Blue avait perdu une finale d'échecs contre le champion du monde Garry Kasparov. Mais il avait pris sa revanche en 1997, remportant plusieurs matchs contre Kasparov, après une mise à niveau améliorant ses performances. « Je ne vois pas IBM fournir un service de jeu vidéo basé sur Watson ! » a déclaré Guru Rao. « Notre but n'est pas de produire des jeux pour ordinateur, mais d'utiliser cette science informatique révolutionnaire pour répondre à des besoins au niveau des entreprises. » IBM veut aussi faire la démonstration de nouvelles interactions possibles entre l'homme et l'ordinateur et montrer comment extraire des informations pertinentes d'une masse de données disponibles.

L'entreprise a ajouté des FPGA (réseau de portes programmables in situ) pour réaliser des traitements de données spécifiques sur les serveurs, tout en ajoutant plusieurs coeurs pour accélérer les processeurs. Big Blue est également en train de redessiner les serveurs pour réduire la latence entre le processeur et la mémoire, de façon à accélérer les performances des applications. Le serveur EX5 conçu par IBM, présenté l'an dernier, s'éloigne de l'architecture traditionnelle des serveurs x86 : le constructeur a découplé la mémoire des processeurs en les intégrant dans des boîtes séparées ce qui permet aux serveurs d'accéder à un pool de mémoire plus grand. Par ailleurs, la firme d'Armonk a conçu une puce particulière, juxtaposée à la CPU, qui réduit la latence entre la mémoire et le processeur. « La technologie EX5 pourrait également inclure un système de stockage flash pour procurer de la mémoire supplémentaire, » a expliqué Guru Rao.

Illustration principale : Guru Rao, ingénieur système en chef chez IBM

| < Les 10 documents précédents | Les 10 documents suivants > |