Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 621 à 630.

| < Les 10 documents précédents | Les 10 documents suivants > |

(16/02/2011 15:01:18)

Selon Forrester, les premiers clouds privés seraient voués à l'échec

Les analystes de Forrester n'ont pas de nouvelles très encourageantes pour les fournisseurs IT qui mettent en place leurs premiers cloud en interne. Selon eux, cette infrastructure est susceptible d'échouer. D'un autre côté, les mêmes analystes insistent sur le fait que « c'est une bonne chose, » parce que cet échec permettra de réussir par la suite. « La plupart de ces entreprises ne sont pas encore prêtes à utiliser un cloud interne. Néanmoins, nous pensons que, en 2011, les départements Infrastructure et Opérations (I&O) vont commencer à en déployer un certain nombre. Ces efforts sont très probablement voués à l'échec. Mais grâce à cette première étape et à l'expérience qu'elle apportera, il sera possible d'en tirer de précieux enseignements sur ce qui est vraiment nécessaire pour gérer un tel environnement, » ont écrit les deux analystes de Forrester, James Staten et Lauren Nelson (en illustration principale), dans leur rapport intitulé « 2011 Top 10 IaaS Cloud Predictions pour I&O Leaders » et destiné aux responsables des départements Infrastructure et Opérations.

Clouds privés : les entreprises ne sont pas encore assez matures

Selon Forrester, « il faut plus de maturité dans la virtualisation et des améliorations dans la normalisation, l'automatisation et l'infrastructure pour s'engager avec succès dans la mise en place d'un cloud interne capable de fournir des services équivalents à ceux offerts par des IaaS (Infrastructure-as-a-Service) comme l'Elastic Compute Cloud d'Amazon. » Toujours selon le rapport, « la plupart des entreprises n'ont pas la maturité nécessaire en terme de virtualisation et ne sont pas prêtes à mettre en oeuvre le niveau d'automatisation et de standardisation exigé par un environnement cloud. » Comme l'expliquent les deux experts, « la perspective architecturale change : le cloud met fin à l'architecture en silos, pour un pool unique de ressources permettant deux niveaux de priorité élémentaires - un concept révolutionnaire et un défi pour les gestionnaires I&O. La gestion des meilleures pratiques viendra avec l'expérience, et le plus tôt sera le mieux. En même temps, même si l'infrastructure n'est pas encore prête, mieux vaut ne pas éviter de considérer une telle mise en route. »

Des solutions clouds déjà pérennes

Cela ne veut pas dire pour autant que toutes les tentatives sont vouées à l'échec et qu'il n'y aura pas de success-story. Comme l'a récemment rapporté notre confrère Network World, de grandes entreprises comme Bechtel et First American Corp ont déjà fait le bilan des avantages acquis grâce à des clouds en interne. De nombreux éditeurs de logiciels comme VMware, Joyent, Red Hat, Platform Computing ou la start-up Nimbula fondée par l'équipe à l'origine d'Amazon EC2, proposent également des outils d'automatisation pour virtualiser l'infrastructure et offrir des fonctionnalités semblables à celle du cloud. Pour ceux qui ne veulent pas mettre en place une nouvelle infrastructure en interne, Amazon, Terremark, Savvis, Rackspace et d'autres proposent également des serveurs virtuels hébergés. Une étude réalisée au cours du troisième trimestre 2010 par Forrester auprès de 1252 décideurs IT en matière de serveurs et de stockage a révélé que 15% d'entre eux prévoient d'acheter des ressources IaaS à Amazon ou à d'autres vendeurs, et 6% ont déjà franchi cette étape. Parmi les entreprises de plus de 20 000 salariés, 20% d'entre elles prévoient d'adopter l'IaaS et 8% ont déjà adopté ce type de solution.

Parmi les points soulevés par le rapport de Forrester on note :

- Dans leurs entreprises, les responsables IT «aguerris» ne doivent pas s'opposer aux adopteurs précoces qui souhaitent acheter de nouveaux services de cloud computing.

- Les cloud privés hébergés par des fournisseurs, avec une offre de ressources dédiées, et non partagées, seront trois fois plus nombreux que les cloud déployés en interne.

- Les cloud publics, mis en place par des associations ou un groupe d'entreprises en vue de partager les coûts, vont se développer dans certains secteurs, notamment la biotechnologie, l'enseignement supérieur et les organismes gouvernementaux.

- Le cloud computing haute performance sera plus largement répandu grâce à de nouvelles applications qui permettent d'accéder à la puissance des technologies de grille sans les complications de leur mise en oeuvre.

- L'économie du cloud va grandement s'améliorer. Les développeurs vont pouvoir créer de petites applications qui pourront, si nécessaire, être élargies pour des usages à grande échelle en fonction des besoins. De nouveaux outils vont permettre de comparer plus facilement les coûts, quitte à avoir recours à plusieurs services cloud pour obtenir le meilleur prix.

- Les outils analytiques du cloud vont stimuler la business intelligence (BI) en proposant des services plus rapides et plus rentables.

- Les nouvelles fonctionnalités de Windows Azure et d'autres nuages vont aider les entreprises à profiter de l'analyse des données, ce qui pourrait potentiellement inciter les clients à devenir eux-mêmes des fournisseurs de BI par une valorisation de leurs données internes et la mise en place de nouveaux services susceptibles de générer des revenus.

- Les normes du cloud vont continuer à bouger en 2011. Cette tendance rend « le marché du cloud... trop immature pour une normalisation. » Cela ne doit pas empêcher les clients d'adopter des services cloud. Ils doivent s'orienter vers des fournisseurs qui ont du souffle et sont suffisamment répandus sur le marché pour ne pas prendre le risque de miser sur un perdant.

- La sécurité du cloud « aura fait ses preuves », mais les professionnels de l'IT doivent analyser attentivement la sécurité, la confidentialité, la conformité, le cadre juridique et contractuel de l'ensemble de leurs applications et ne qualifier que celles qui sont prêtes pour être proposées dans les services cloud. Les utilisateurs doivent aussi se diriger vers des produits « capables de sécuriser les données avant qu'elles ne soient rendues disponibles dans le cloud. »

Illustration principale : Lauren E Nelson, chercheur chez Forrester

RSA 2011 : La virtualisation, clé de la sécurité dans le cloud

Dans une allocution prononcée lors de la RSA Security Conference qui se tient actuellement à San Francisco, Art Coviello, patron de RSA (la filiale sécurité d'EMC), a apporté un peu d'optimisme dans le domaine de la sécurité dans le cloud computing. S'il a reconnu la légitimité des préoccupations des entreprises en matière de déplacement de données et d'applications dans le cloud, celui-ci a affirmé que les méthodes pour traiter ces problèmes étaient plus proches de nous qu'on ne le pensait. « Dès aujourd'hui, nous pouvons faire en sorte que le cloud soit digne de confiance, » a-t-il déclaré. Pour lui, l'une des clefs consiste à cesser de dépendre des modèles de sécurité conçus pour les infrastructures physiques. Au lieu de cela, les entreprises doivent penser à tirer parti des technologies de virtualisation pour renforcer la sécurité, la visibilité et le contrôle dont ils veulent bénéficier dans les environnements cloud.

La sécurité doit évoluer avec le cloud

Une solution de sécurité reposant sur VMware

« Les économies et l'adaptabilité que permet le cloud, poussent un nombre croissant d'entreprises à l'adopter, indépendamment des questions de sécurité et du contrôle dont elles peuvent disposer, » a déclaré le patron de RAS. Aussi contre-intuitif que cela puisse paraître, «si l'effet de levier agit correctement, la virtualisation peut devenir une solution pour dépasser le niveau de contrôle et de visibilité qui existe aujourd'hui dans les environnements physiques, » a-t-il estimé. « Dans le cadre du travail propre à RSA pour aller vers ces modes de sécurisation, l'entreprise a lancé un service Cloud Trust Authority, » a indiqué Art Coviello. Celui-ci tire profit des outils de virtualisation de VMware (une autre filiale d'EMC) pour délivrer un ensemble de services pour gérer les identités et surveiller la conformité dans le cloud.

Illustration : Art Coviello, patron de RSA

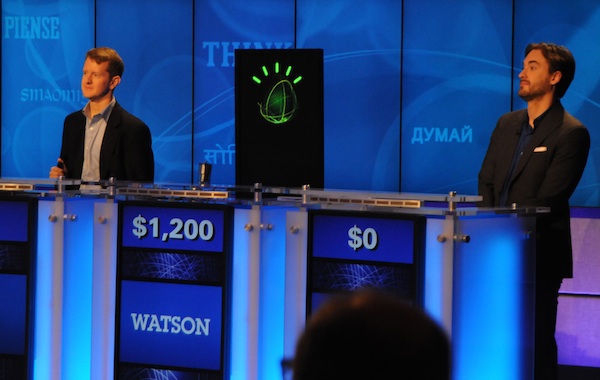

Le supercomputer Watson d'IBM défie les candidats du jeu Jeopardy (MAJ)

En 1997, IBM avait fait une percée avec Deep Blue, qui était parvenu à vaincre le champion mondial d'échecs Gary Gasparov. En 2011, la société revient à la charge avec un autre ordinateur, Watson, nommé en l'honneur du fondateur d'IBM, Thomas J. Watson.

Cette fois-ci, l'ordinateur se mesurera aux deux plus grands gagnants de l'histoire de Jeopardy, soit Ken Jennings et Brad Rutter. Ken Jennings détient le record du plus grand nombre de parties consécutives gagnées à Jeopardy, soit 74. Ses gains à vie se chiffrent à 2,5 millions de dollars. Brad Rutter détient quant à lui le record des gains à l'émission, soit 3,2 millions de dollars.

Ken Jennings et Brad Rutter, les deux lauréats du jeu Jeopardy

Autopsie d'un superordinateur

Le Watson est particulièrement impressionnant. Cet ordinateur est composé de 10 racks contenant chacun 9 serveurs Power 750 montés en réseau. Chaque serveur, dont la valeur se chiffre à environ 300 000 dollars, possède 32 coeurs qui peuvent gérer un total de 128 tâches en parallèle. L'ordinateur dans son ensemble compte 2 880 coeurs, peut effectuer 11 520 tâches en parallèle, possède une mémoire vive de 15 000 gigaoctets (Go) et une puissance totale de 80 téraflops. Selon les dirigeants d'IBM, ces performances placent Watson dans le Top 100 des ordinateurs les plus puissants au monde en ce moment.

À titre comparatif, Deep-Blue avait une puissance totale de 1 téraflop et celle de la salle des serveurs de l'usine d'IBM Canada à Bromont frôle les 4 téraflops. Pour chaque téraflop de puissance, un ordinateur peut effectuer mille milliards d'opérations à la seconde.

Une intelligence artificielle de plus en plus fine

Si le matériel qui compose Watson est imposant, le vrai défi pour l'équipe d'IBM fut tout autre qu'avec Deep Blue, selon Éric Paradis, spécialiste consultant en technologies de l'information chez IBM Canada à l'usine de Bromont. « En matière de logiciel, les échecs, c'est relativement simple. Avec Deep Blue, en 1997, il s'agissait surtout d'un exploit matériel. Il s'agit d'une planche de 64 cases avec des règles et des pièces qui ont toutes un rôle limité. L'algorithme était assez simple: à chaque coup, il fallait prévoir le prochain mouvement de l'adversaire et ensuite établir quel serait le meilleur mouvement à partir de toutes les combinaisons possibles », dit-il.

Dans le cas de Watson, le défi est de traiter le langage naturel. L'ordinateur est équipé d'une série d'algorithmes qui ont nécessité plusieurs années de recherche et même certains partenariats avec des universités. M. Paradis précise que contrairement à la croyance populaire, Watson n'entend pas et ne peut donc reconnaître la voix. Il reçoit les questions en texte, de même que les réponses de ses concurrents. À défaut d'entendre, il doit donc comprendre les questions : « Les questions de Jeopardy peuvent contenir des jeux de mots, des farces, des doubles sens... Par exemple, si vous cherchez Mercury dans un moteur de recherche Internet, vous pouvez obtenir des résultats sur un métal, sur une planète, sur une vieille marque de voitures et même sur le chanteur Freddy Mercury. Un seul mot peut donc avoir différents sens, ce qui rend le défi de la compréhension très complexe », dit-il.

Entretien réalisé par Denis Lalonde, rédacteur en chef du magazine Direction informatique.

[[page]]

A défaut d'Internet, une base de connaissance interne

De plus, Watson n'a pas accès à Internet. Il contient l'équivalent de 200 millions de pages de contenus, structurés (anatomie, atlas géographiques...) et non structurés (tels que journaux, documents historiques, scénarios de films...). Il est également doté de connaissances élémentaires logiques, par exemple que la pluie est mouillée, qu'un père est toujours plus vieux que son fils et que quelqu'un qui est décédé ne peut revenir à la vie. Les questions à Jeopardy peuvent toucher à une multitude de catégories, allant du sport à l'histoire et à la littérature, en passant par la géographie, ce qui nécessite des connaissances générales très poussées. « Un algorithme très important est aussi celui de l'acquisition et de l'indexation dynamique de connaissances. Cela signifie que Watson s'améliore avec l'usage », affirme M. Paradis, rencontré à Bromont quelques jours avant l'affrontement entre la machine et l'homme.

L'ordinateur possède également la capacité de s'adapter à une catégorie. Si, à un moment durant l'émission, on recherche uniquement des noms de joueurs de hockey et que Watson ne l'a pas réalisé au début, il peut faire l'ajustement pour répondre aux questions restantes dans cette catégorie précise. Comme les mauvaises réponses à Jeopardy font perdre des points, Watson doit également autoévaluer le degré de confiance en ses réponses.

Préparer l'après-Jeopardy

Évidemment, l'objectif ultime derrière la conception de Watson est de réaliser une percée au niveau de l'intelligence artificielle qui permettrait à IBM de vendre des clones de son superordinateur pour divers types d'applications commerciales, industrielles ou publiques.

Éric Paradis explique que Watson pourrait par exemple servir de référence au niveau médical. « L'ordinateur, avec ses algorithmes et son architecture, pourrait contenir l'ensemble de la littérature médicale et tirer des conclusions à partir de symptômes, de résultats et de tous les outils à la disposition des médecins. Ces derniers ont accès à des connaissances phénoménales, mais qui ne sont pas toujours organisées. Le système pourrait alors intervenir », dit-il. C'est pourquoi IBM tient à ce que Watson soit capable d'évaluer lui-même sa capacité à donner de bonnes réponses. Dans le cas d'un diagnostic médical, la marge d'erreur est nulle.

Un match en deux manches

Après la première manche, Watson et Brad Rutter ont terminé à égalité avec 5 000 dollars chacun, alors que Ken Jennings a remporté seulement 2 000 dollars. Et lors de la seconde et dernière manche, Watson a pris le pas sur ses deux adversaires : le supercomputer d'IBM a remporté des gains d'un montant de 35 734 dollars contre 10 400 pour Brad Rutter et 4 000 pour Ken Jennings. Big Blue a indiqué qu'il reverserait cette somme rondelette à des oeuvres.

(...)

Dernières puces AMD Opteron 6100 avant Bulldozer

Le fondeur de Sunnyvale renforce son offre avec des puces toujours gravées en 45 nm : trois Opteron 6100 12 coeurs (2 x 6) qui fonctionnent entre 1,8 GHz et 2,5 GHz. L'Opteron 6166 HE (873 $) travaille à 1,8 GHz et consomme jusqu'à 65 watts en TDP. L'Opteron 6180 SE (1 514 $) affiche une fréquence de 2,5 GHz, pour un TDP de 105 watts. L'Opteron 6176 reste cadencé à 2,3 GHz, mais ne consomme plus que 80 watts. Selon Bernard Seité, directeur technique chez AMD, il s'agit du dernier bond pour cette famille de produit avant l'arrivée de l'architecture Bulldozer annoncée en 32 nm. « La technologie s'est considérablement améliorée depuis la mise en fabrication du Magny-Cours et les meilleurs rendements permettent aujourd'hui de produire ces processeurs en volume ». La firme a également commencé à livrer deux autres Opteron 6100 huit coeurs (2 x 4). L'Opteron 6132 HE (591 $) fonctionne à 2,2 GHz (60 watts) tandis que le 6140 (989 $) travaille à 2,6 GHz (80 watts).

Dell et Hewlett-Packard vont adopter sans délai ces nouveaux processeurs dans leurs serveurs, nous précise Bernard Seité, puisqu'il n'y pas de rupture au niveau de la plate-forme. Seuls les Bios ont besoin d'être mise à jour pour reconnaître ces processeurs. Dell a par exemple déjà annoncé le PowerEdge C6145, un serveur huit sockets qui peut accueillir jusqu'à 96 coeurs.

Une génération cruciale pour AMD

Ces produits arrivent à un moment où AMD tente de revenir sur le marché des serveurs. La firme de Sunnyvale a perdu des parts de marché au profit d'Intel et ces nouvelles puces Opteron - avec un maximum de 12 coeurs - reposent encore sur une architecture vieillissante. Pour revenir dans la course, AMD compte sur les puces connues sous les noms de code Interlagos (jusqu'à 16 coeurs) et Valence (jusqu'à huit coeurs) qui reposent sur l'architecture Bulldozer. Fabriquées en 32 nm, ces dernières sont attendues au deuxième trimestre 2011 chez les constructeurs pour une commercialisation effective fin 2011, annonce prudemment Bernard Seité. Les processeurs de la classe Bulldozer seront jusqu'à 50% plus rapides et supportent un débit mémoire plus élevé (+ 20%) que les puces serveur actuelles, ajoute le responsable d'AMD. La microarchitecture recombinée avec des unités de calcul flottant partagées entre les coeurs entiers des coeurs de processeurs permettrait d'exécuter plusieurs opérations par cycle d'horloge tout en consommant moins. Ces puces Bulldozer sont également compatibles avec les sockets des Opteron 6100, qui devrait faciliter le travail des clients qui désireront mettre à jour leurs serveurs.

SmartDatacenter de Joyent arrive dans sa version 6

L'heure est à l'automatisation pour la création de clouds. Les entreprises qui souhaitent sauter le pas vers les clouds privés se confrontent rapidement à l'écueil de la répétition de certaines tâches et les constructeurs proposent des outils pour systématiser et automatiser ces contraintes. Joyent, vu récemment lors de notre visite des start-up californiennes, avait présenté une appliance pour de tels déploiements. Aujourd'hui, la société a présenté une solution logicielle, baptisée SmartDatacenter 6. Pour David Young, CEO de Joyent « la version 6 montre que notre produit a été testé et éprouvé depuis quelques années et nous que nous avons acquis un vrai savoir-faire ». Connu aux Etats-Unis pour proposer des offres de cloud public, la firme dispensait aussi son expérience auprès des opérateurs.

SmartDatacenter 6 s'adresse à ce type de clients et présente plusieurs fonctionnalités. La brique de base permet une automatisation complète du datacenter avec virtualisation des architectures complexes et multiples, des réseaux locaux virtuels (VLAN), des répartiteurs de charge (load balancing), du routage et des réseaux privés virtuels (VPN), etc. La gestion client sur l'affectation des différentes ressources du cloud s'effectue via un portail web.

A la question sur la possible arrivée de Joyent comme acteur de cloud public en France, David Young est formel « nous proposons une solution logicielle directement auprès des ISP et des opérateurs, nous n'avons pas vocation à les concurrencer via une offre de cloud public. Nous leur apportons une brique simple et ergonomique pour qu'ils puissent commercialiser des services clouds rapidement ».

Rackspace acquiert Anso Lab

Rackspace, basée au Texas, a co-fondé OpenStack avec la NASA en tant que projet Open Source de cloud. Cette initiative comprend plus de 50 membres, dont Dell et Citrix Systems. Il s'est intéressé à Anso Labs, car le fournisseur de logiciel pour les infrastructures de cloud privé basé à San Francisco a également contribué à OpenStack.

Rackspace souhaite créer un environnement donnant aux clients les moyens de déplacer des charges de travail d'un prestataire de services cloud à l'autre sans être verrouillé. Les besoins d'expertises et de contributions externes sont cruciales pour le développement et la reconnaissance d'OpenStack face à des logiciels comme vCloud de VMware et Eucalyptus, qui sont compatibles avec Amazon Web Services.

« Anso Labs est un contributeur essentiel pour OpenStack », a déclaré Lew Moorman, CTO et PDG de Rackspace Cloud. « Grâce à cette acquisition stratégique de talents, nous allons accélérer le développement de notre projet Open Source ». La semaine dernière a vu le lancement de la version « Bexar » d'OpenStack, qui améliore le stockage et ajoute des fonctionnalités de sauvegarde des images.

Satya Nadella remplace Bob Muglia à la division Serveurs et Outils de Microsoft

Satya Nadella, âgé de 43 ans, prend la présidence de cette division, un poste que Bob Muglia a laissé vacant depuis l'annonce de son éviction en janvier dernier. En publiant cette nomination, Microsoft a souligné l'expertise de Satya Nadella dans le cloud computing, une compétence de l'entreprise considère comme essentielle pour trouver sa place dans le marché émergent des services de l'informatique en nuage. Steve Ballmer a souligné que le promu « a une expérience profonde sur le marché des serveurs et des services en ligne de Microsoft qui nous permettra d'accélérer le rythme de sortie de nos solutions et de travailler dans le même temps sur les offres cloud à venir ».

Satya Nadella était depuis 2007 en charge de l'ingénierie de la division des services en ligne de l'éditeur. Il a dirigé les travaux de lancement du moteur de recherche Bing, ainsi que les mises à jour du portail grand public Microsoft MSN et l'intégration des services publicitaires entre Yahoo et Bing. Avant cela, il était en charge des solutions Business de la firme de Redmond, en s'occupant notamment de la gamme Dynamics, qui comprend des ERP et des logiciels et services de CRM. Il est chez Microsoft depuis 19 ans.

L'activité Serveurs et Outils supervise notamment le système d'exploitation Windows Server, ainsi que le développement des outils d'administration. La division s'occupera également des offres de l'entreprise en matière de cloud computing, y compris la plateforme Windows Azure. Dans son nouveau rôle, Satya Nadella devra élaborer un plan technologique et une vision stratégique pour les serveurs et des outils logiciels dans un environnement cloud, précise Microsoft. Bob Muglia qui quittera la société à la mi-2011, va accompagner et aider son successeur dans son nouvel emploi.

Les éditeurs de logiciel créent un site dédié au grand emprunt

L'Afdel a poussé à la roue pour que le grand emprunt intègre une dimension IT en particulier dans le domaine du cloud. Elle passe aujourd'hui à la vitesse supérieure pour faciliter aux éditeurs l'accès à ce grand emprunt, en créant un site dédié : http://www.investirdanslenumerique.fr/

« Le site est avant tout ergonomique et pédagogique », note Loïc Riviere délégué général de l'Association, « nous n'avons pas fait du simple copier-coller » de textes existants, mais pensé le site en fonction des demandes et des démarches des éditeurs ». Outre cette accessibilité, le site est collaboratif. C'est une exigence de l'Etat qui va privilégier les projets portés à la fois par des entreprises et par des laboratoires de recherche. Le site permet donc aux éditeurs de s'associer et de trouver un partenaire public ou parapublic. « Dans la démarche du grand emprunt, l'éditeur doit démontrer sa capacité à évoluer dans un écosystème. L'Etat est également attentif à l'impact économique du projet, en particulier en matière de création d'emplois ». Prochaine étape, le site proposera de liens vers des financements : JEI, CIR, Oséo, fonds européens.

L'Afdel se lance dans un nouveau rôle de catalyseur, autour de la démarche du grand emprunt, en intégrant la logique donnant/donnant de l'Etat : des subventions en échange de retombées économiques.

Datacore dévoile SanSymphony-V

Pour le CEO de Datacore Software, Georges S.Texeira « la montée en puissance de la virtualisation au sein des entreprises pose trois questions de management, les capacités, les performances et la protection des données ». Pour répondre à ces problématiques spécifiques à la virtualisation des environnements serveurs et poste de travail, le spécialiste des solutions logicielles pour le stockage propose depuis le 31 janvier dernier, une évolution de son offre phare SanSymphony-V. Le dirigeant explique « lorsqu'on parle de virtualisation des serveurs, tout le monde entend VMware, Citrix, etc. pour autant il arrive souvent que des projets soient arrêtés car la question du stockage n'a pas été prise en compte » et d'ajouter « à la différence de nos concurrents comme 3Par ou Compellent, nous ne fournissons pas des box, mais uniquement du logiciel, nous sommes ainsi compatibles avec beaucoup d'environnements».

Plusieurs fonctionnalités

SANsymphony-V donne aux utilisateurs la possibilité de créer des disques virtuels partagés dans les environnements virtuels de VMware, Microsoft et Citrix. Parmi les autres fonctionnalités, la solution intègre la protection continue des données (CDP), la copie inverse rapide, une sélection automatique de port (pour réduire l'erreur humaine) et une planification des tâches comme la réplication et les snapshot. L'objectif de ce service est par exemple « de simplifier le processus de migration du monde physique à l'univers virtuel, il ne sera plus nécessaire de faire une copie lors de ce transfert » souligne Georges S.Texeira. Ce dernier rappelle que la dernière solution garde les fonctionnalités de l'offre d'origine, comme le pooling de disques virtuels, le mirroring, la mise en cache des I / O, des captures d'état en ligne, du thin provisioning et de gestion des charges de travail. En matière de prix, SanSymphony-V sera proposé à 10 000 euros comprenant 2 licences pour 2 serveurs, avec une maintenance d'un an.

Oracle livre une gestion de fichiers pour clouds privés

L'offre Cloud File System permet de disposer d'un système de fichiers clusterisé installé au-dessus d'une gestion du stockage automatisée, a récemment exposé Bob Thome, directeur produit chez Oracle, à l'occasion de l'annonce faite par l'éditeur californien. Cette solution intéressera les entreprises bâtissant des clouds internes. Mais elle pourra également servir à tester des applications cloud avant de les envoyer vers un service d'hébergement externe, a-t-il expliqué à nos confrères d'IDG News Service.

Cloud File System, c'est le nouveau nom choisi par Oracle pour ses technologies basées sur ASM, Automatic Storage Management, qui est conçu pour gérer les fichiers de la base de données Oracle. L'offre inclut les logiciels ASM Cluster File System et ASM Dynamic Volume Manage. Le premier des deux logiciels permet d'effectuer des sauvegardes sur un ensemble de serveurs et d'y accéder ensuite depuis n'importe lequel d'entre eux. En plus de cet accès direct aux données depuis tout noeud du cluster, il est possible d'utiliser des protocoles de gestion de fichiers réseaux tels que NFS (Network File System) ou CICS (Common Internet File System) de Microsoft.

Parmi les fonctions avancées proposées aux administrateurs figure un système d'autorisation permettant de spécifier quand il est possible d'accéder à un fichier et avec quelles applications. On peut aussi indiquer quels fichiers se rapportent à quelles applications pour effectuer des actions groupées, par exemple, les sauvegarder. « C'est un peu comme un répertoire virtuel qui vous permet d'effectuer des opérations sur plusieurs fichiers qui se trouvent sur différents répertoires », explique Bob Thome. Le logiciel peut fonctionner comme un système de fichiers indépendant ou être secondé par un autre système, comme EXT3, NTFS (Network File System) ou ZFS (Zetabyte File System) pour profiter en même temps de leurs approches. En revanche, dans ce cas, les utilisateurs perdent la possibilité de répartir à travers les serveurs.

Testé dans des déploiements de plus de 100 noeuds

De son côté, le logiciel ASM Dynamic Volume Manager permet d'ajouter des disques à un système sans devoir rééquilibrer les données entre les ressources disponibles. « Vous pouvez étendre le système de fichiers, le réduire, le faire migrer d'un pool de stockage à un autre sans interruption d'aucune sorte, assure Bob Thome. ASM produit aussi des snapshots en lecture seule du système de fichiers ».

Cloud FS n'est pas la première offre du genre chez Oracle. L'éditeur gère aussi le projet Open Source Lustre. Toutefois, ce dernier est mieux adapté aux environnements HPC (high performance computing) dans lesquels sont déployés un millier de serveurs ou plus, rappelle Bob Thome. A l'inverse, Cloud FS convient mieux aux petits déploiements, autour de 25 noeuds, même s'il a été testé dans des environnements comportant plus de cent noeuds.

Cloud FS fonctionne sur les serveurs Sparc sous Solaris, PowerPC sous AIX ou x86 sous Linux et Windows. L'offre coûte 5 000 dollars par processeur Oracle. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |