Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 261 à 270.

| < Les 10 documents précédents | Les 10 documents suivants > |

(04/10/2011 12:24:29)

HP finalise l'acquisition d'Autonomy

Les actionnaires détenant 87% des actions d'Autonomy ont accepté l'offre d'achat de HP de 42,11 dollars par action, valorisant ainsi l'éditeur de logiciels à environ 10,3 milliards de dollars. De fait « toutes les conditions liées à l'offre ont été remplies, ce qui permet à HP de prendre le contrôle d'Autonomy » précise un communiqué du constructeur.

HP avait annoncé au mois d'août dernier son intention d'acquérir l'éditeur britannique. L'opération, a été orchestrée par l'ancien PDG du groupe, Leo Apotheker. Cette décision a été controversée, estimant que le prix offert était trop élevé. HP a depuis nommé un nouveau PDG, ancien chef d'eBay Meg Whitman.

Renforcer les analyses de données non structurées

Autonomy, basée à Cambridge, est le plus important éditeur indépendant de logiciels au Royaume-Uni. Il dispose d'une large gamme de produits de gestion de l'information, y compris des solutions de recherches dans des données non structurées (e-mails, des appels téléphoniques ou des tweets). La société exploite également un cloud public qui stocke des pétaoctets de données d'entreprise.

HP explique que l'accord va renforcer son offre d'analyses de données, ses solutions cloud pour aider ses clients à gérer un volume sans cesse croissant de données. Autonomy fonctionnera comme une entité distincte et garde son PDG Mike Lynch, qui rapportera directement à Meg Whitman.

HP précise que le programme de rachat des actions minoritaires reste ouvert.

Illustration: Autonomy Visio

Crédit Photo: Autonomy

Juniper lance une offre cloud de réseaux virtuels pour les tests

Juniper a présenté Junosphere Lab, un environnement virtuel pour la conception, le test et l'exploitation des réseaux utilisant des éléments du constructeur. Junosphere Lab est une offre cloud, conçue pour permettre aux entreprises et les clients des fournisseurs de services, de créer et exécuter des environnements réseaux à la demande pour modéliser, tester et planifier à une échelle impossible à supporter sur un environnement physique.

Les entreprises peuvent «louer» les réseaux de Junosphere Lab pour 50 dollars par jour, soit 5 dollars par machine virtuelle, avec un minimum de 10 VM. Le constructeur souligne que le coût est plus bas que l'exploitation d'un laboratoire physique sur site. Avec le laboratoire virtuel, les clients peuvent déployer des services plus rapidement, améliorer la planification et mieux se préparer aux changements du réseau, précise l'équipementier.

Un connecteur et des partenaires technologiques

Les entreprises peuvent également utiliser cette offre comme un substitut ou un complément à à leur laboratoire physique. Pour ce faire, Juniper a également introduit Junosphere Connector, une application optionnelle qui permet de relier les deux types d'environnement.

L'offre comprend et fonctionne avec des applications et des produits de partenaires de Juniper, comme la gestion du trafic et la simulation de Cariden Technologies, la modélisation d'application par Mu Dynamics, Spirent pour le test et la validation de la performance sur des environnements virtualisés et dans le cloud, enfin Wandl s'occupe de la planification de réseau, la conception et l'optimisation.

Junosphere Lab est disponible dès maintenant.

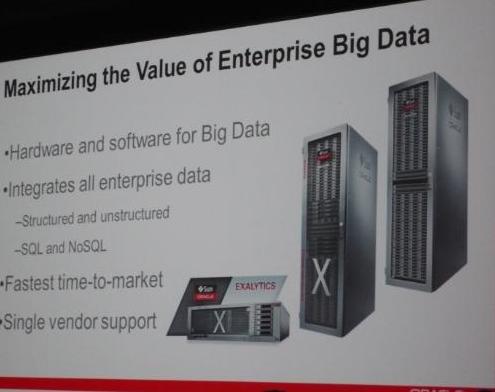

OpenWorld 2011 : Oracle bâtit une solution pour traiter les Big Data

Les Big Data, avalanche de données générée par les réseaux sociaux, les capteurs mobiles, compteurs électriques et autres dispositifs ne peuvent généralement pas être traitées en l'état par les solutions de BI. Trop d'informations déversées sans discernement, mais qui peuvent receler des « pépites », expliquait Andy Mendelsohn, senior vice-président, responsable des technologies serveur d'Oracle, en introduction de son keynote au deuxième jour d'OpenWorld. Oracle n'avait jusque-là pas présenté d'offres spécifiques pour les prendre en compte. C'est chose faite sur OpenWorld 2011. Avec la « Big Data Appliance », le fournisseur combine une plateforme matérielle et un ensemble de logiciels pour acquérir les données, les organiser et les charger dans Oracle Database 11g, afin de les analyser.

Un châssis de 18 serveurs Sun X4270 M2

Cette fois, la solution ne repose pas exclusivement sur des logiciels Oracle puisqu'elle recourt, d'une part, au framework Hadoop adapté au traitement intensif de données, d'autre part au langage Open Source R, conçu pour l'analyse statistique. Oracle les associe à sa nouvelle base de données NoSQL pour gérer et subdiviser les gros volumes aux formats changeants. Une base qu'il complète de son ETL, Data Integrator for Hadoop, et de l'outil Loader for Hadoop qui permet d'utiliser MapReduce pour créer des jeux de données à charger dans la base 11g.

La partie matérielle fonctionne sous Oracle Linux et héberge une machine virtuelle Java Hotspot. Son châssis, similaire à celui de l'Exadata, loge 18 serveurs Sun X4270 M2, propose 12 coeurs Intel par noeud (216 au total), 48 Go de mémoire par noeud (soit au total 864 Go) et 24 To de stockage par noeuds (432 To). Elle s'utilise en association avec la machine Exadata et la prochaine Exalytics. L'ensemble peut gérer les donnés structurées et non structurées dans des bases SQL ou non SQL.

Surveiller les patients à distance

Pour justifier l'arrivée d'Oracle sur ce terrain où plusieurs concurrents ou partenaires ont poussé leurs pions (EMC/Greenplum, notamment, ou IBM/Netezza), Andy Mendelsohn a éclairé les champs d'applications possibles. La santé, en premier lieu : au moyen de capteurs, la surveillance à distance des patients permet de remonter des données brutes en continu, de les analyser pour déceler l'anomalie et intervenir en cas d'urgence. Les services basés sur la localisation en temps réel des personnes pour des services de recherche, ou des invites promotionnelles. Ou encore le marketing pour segmenter l'analyse des ressentis sur les réseaux sociaux.

Entre lundi et mardi, plusieurs sessions plus détaillées ont abordé l'analyse statistique avancée avec le langage R, la gestion des Big Data reposant sur Hadoop et Exadata, ou encore l'utilisation d'Hadoop avec Oracle Database 11g.

Illustration : Andy Mendelsohn, senior vice-président, responsable des technologies serveur d'Oracle, sur OpenWorld 2011 (crédit : MG).

Ci-dessus : L'utilisation de l'appliance Big Data se combine avec celle des machines Exadata et Exalytics (source : Oracle)

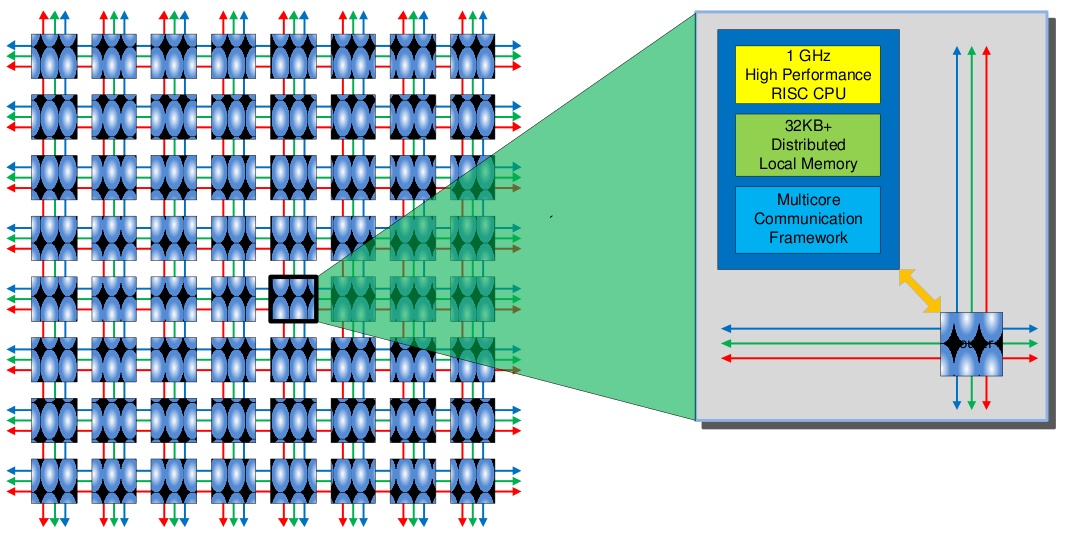

Une puce 64 coeurs pour tablettes et smartphones

Le fondeur Adapteva a dévoilé une puce « intégrant 64 coeurs et capable de fournir une puissance de 70 gigaflops pour une consommation de 1 watt, » comme l'a déclaré Andreas Olofsson, CEO de la firme. « Un watt peut représenter beaucoup d'énergie pour les smartphones, mais il est possible de réduire les performances et la consommation des noyaux pour accélérer des fonctions comme la reconnaissance gestuelle et la reconnaissance faciale, » a ajouté le CEO.

La puce n'est pas destinée à héberger un OS complet et vise plutôt le rôle de co-processeur pour supplanter le processeur principal dans certaines tâches. Par exemple, le maillage de l'Epiphany IV est optimal pour l'échange plus rapide des données, et ses noyaux parallèles disposés en carré offrent de multiples points de contact pour la réception et le transfert des données. Il est également possible de moduler le nombre de coeurs en fonction de la performance souhaitée, et les points de communication multiples sont adaptés pour résoudre les problèmes de bande passante. «Nous n'avons pas pour ambition de prendre des parts de marché à des fondeurs comme Intel ou ARM, mais nous essayons de proposer quelque chose de complémentaire », a déclaré Andreas Olofsson. Les ambitions de l'entreprise dans le secteur du mobile font suite à une première incursion dans le domaine des supercalculateurs où la puce a suscité un certain intérêt pour effectuer, par exemple, certains types de tâches dans des systèmes en grille (clusters de puissance) utilisés pour la modélisation de l'environnement.

Déjà un client intéressé par cette puce

A ce jour, l'entreprise, qui emploie cinq personnes, a déjà vendu sa licence à un fabricant, mais son CEO a refusé d'en dévoiler le nom. « La petite taille et les qualités basse énergie de l'Epiphany IV en font aussi un bon co-processeur pour les smartphones et tablettes, » a encore affirmé le CEO de Adapteva. L'entreprise espère vendre son composant sous licence à des fabricants de puces pour terminaux mobiles. « Leur accueil a été favorable, » a ajouté Andréas Olofsson. L'accélérateur pourrait tenir à l'intérieur d'un système-sur-une-puce, qui permet d'associer le processeur principal avec d'autres puces, comme c'est le cas pour les processeurs graphiques ou les circuits pour l'accélération vidéo. « Notre objectif est d'intégrer notre puce à la prochaine génération de smartphones et de tablettes, » a encore déclaré le CEO.

« L'Epiphany IV est construit autour d'un processeur RISC (Reduced Instruction Set Computing), » a expliqué Andréas Olofsson. À plein rendement, les coeurs de la puce d'Adapteva consomment jusqu'à 25 milliwatts. La puce prévue pour les smartphones et les tablettes pourra contenir jusqu'à 64 coeurs. Celle-ci sera fabriquée selon le processus de gravure à 28 nanomètres, donc plus fin que le modèle précédent, fabriqué à 65 nanomètres et annoncé plus tôt cette année. Cette dernière affiche 16 coeurs et consomme un peu moins de 1 watt. « La nouvelle version 64 coeurs de l'Epiphany IV sera disponible au premier trimestre de l'année prochaine, » a précisé le PDG. « La puce d'Adapteva n'est pas un processeur tous usages et diffère d'autres accélérateurs de performance, comme les processeurs graphiques par exemple, beaucoup plus gourmands en énergie, et utilisés pour certaines applications scientifiques et mathématiques, » a déclaré Nathan Brookwood, analyste principal chez Insight 64. La puce d'Adapteva coûtera sans doute aussi moins cher que les FPGA (Field-programmable Gate Array), ces unités reprogrammables conçues pour exécuter des tâches spécifiques telles que le traitement XML. « Le noyau de l'Epiphanie IV est minuscule», a déclaré l'analyste. « Même avec 64 coeurs, la puce reste toujours une petite puce. »

[[page]]

« Cependant, Adapteva trouvera davantage d'opportunités dans le domaine du calcul haute performance, car les supercalculateurs font de plus en plus appel à des accélérateurs pour booster les performances, » a estimé Nathan Brookwood. « Une puce Intel Xeon couplée avec une puce Epiphany IV pourrait surpasser un tas de processeurs Xeon, » a affirmé l'analyste. «Si un smartphone avait besoin de ce niveau de performance, ce serait intéressant. Mais pour l'instant, je ne pense pas que ce soit le cas, » a déclaré Nathan Brookwood.

Selon Andréas Olofsson, la puce Adapteva a peu d'intérêt pour les centres de calcul où dominent les serveurs intégrant des puces basées sur l'architecture x86. Si l'Epiphany sait travailler avec des puces Intel ou AMD, elle ne sait pas accélérer des applications écrites pour l'architecture x86. « Adapteva va continuer à chasser sur les terres de l'informatique haute performance où les superordinateurs peuvent profiter du parallélisme de l'Epiphany, » a déclaré le CEO d'Adapteva. La puce peut héberger des applications écrites selon le standard OpenCL, un ensemble d'outils de programmation qui servent à développer et à gérer l'exécution des tâches parallèles. Avec OpenCL, les programmeurs peuvent écrire du code et le déployer ensuite dans des environnements informatiques multiples. Apple, Nvidia, Intel et AMD font parti du grand nombre d'entreprises qui supportent l'OpenCL. « Pour répondre aux besoins du calcul haute performance, la puce Epiphany IV pourrait contenir jusqu'à 4 096 coeurs, » a déclaré le CEO d'Adapteva. « Ce n'est pas de la science-fiction. Nous pouvons le faire. Il suffit juste qu'un client nous demande de la concevoir», a ajouté Andréas Olofsson.

(...)(03/10/2011 09:45:29)OpenWorld 2011 : Avec Exalytics, Oracle analyse des To de données en mémoire

Après les machines Exadata et Exalogic Elastic Cloud, combinant matériel et logiciels pour optimiser la gestion des bases de données (pour l'une) et des applications sous Java (pour l'autre), on se doutait qu'Oracle n'en resterait pas là. A quelques indices avant-coureurs (notamment une phrase du président Mark Hurd lors du lancement de la Database Appliance), on pressentait que des ajouts seraient faits à cette gamme à l'occasion d'OpenWorld (du 2 au 6 octobre à San Francisco). De fait, un troisième produit y a fait son apparition, sous le nom d'Exalytics. Comme ce dernier le laisse deviner, la machine est cette fois-ci optimisée pour les analyses de données, qu'elle réalise en mémoire. « Elle délivre des résultats instantanés, en moins de temps qu'il ne faut pour saisir sa question », a décrit dimanche soir le PDG du groupe, Larry Ellison.

« Oracle parallélise tout »

Le fondateur d'Oracle a annoncé le produit Exalytics en deuxième partie d'un keynote d'ouverture intitulé « Extreme Innovation » au cours duquel il a largement décrit les mérites des actuelles architectures Exadata (au stockage hiérarchisé entre disques durs, DRAM et Flash) et Exalogic Elastic Cloud où tout est parallélisé : le matériel (serveurs, réseau, stockage) et le logiciel (machines virtuelles, OS, bases de données et middleware). Avec au bout, des données qui transitent dix fois plus vite entre les bases de données et les serveurs de stockage. Larry Ellison est aussi revenu sur l'annonce du serveur SuperCluster à base de processeurs Sparc T4 qu'il a confronté au serveur P795 d'IBM (PowerPC 7). Les caractéristiques listées par le PDG (nombre de processeurs, de coeurs, stockage totalisé) donnent l'avantage à Oracle, mais Larry Ellison insiste surtout sur les performances comparées de la bande passante du stockage qu'il estime 7,6 fois plus rapide sur son serveur (336 Gb/s), et sur le nombre d'entrées/sorties par seconde (IOPS) qui serait huit fois supérieur (9 600 000).

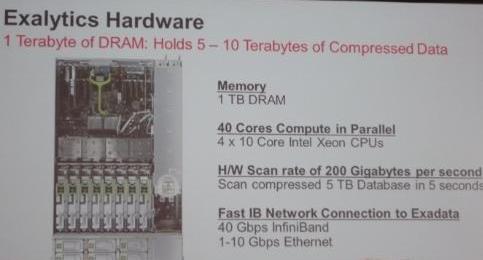

Exalytics fonctionne avec Exadata

La machine Exalytics associe elle aussi de façon étroite le matériel et le logiciel, de façon à optimiser les échanges de données et leur traitement. D'une part, elle repose sur quatre processeurs Intel Xeon à 10 coeurs fonctionnant en parallèle, une mémoire vive physique de 1 Téraoctet, pouvant accueillir de 5 à 10 To de données compressées, et une connexion InfiniBand de 40 Gbps vers une machine Exadata. Car Exalytics est bien sûr conçue pour fonctionner avec Exadata, avec laquelle l'échange de données est accéléré lors des requêtes. La compression des données passées en mémoire se fait à la cadence de 200 Go par seconde. D'autre part, elle exploite, en mémoire, des versions parallélisées de la suite décisionnelle OBI (Oracle Business Intelligence), de la base multidimensionnelle Essbase et de la base de données en mémoire d'Oracle, TimesTen, rachetée en 2005.

L'architecture matérielle d'Exalytics

[[page]]

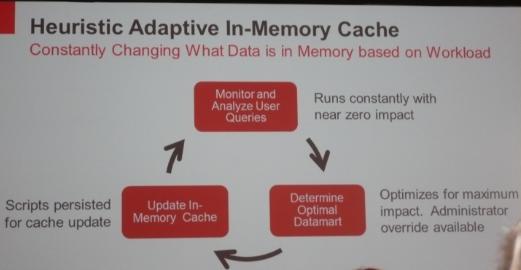

Un cache « heuristique » qui s'adapte

« Ne raisonnez plus en termes de temps de réponse », a poursuivi hier Larry Ellison. Il décrit un processus où la machine devine la question posée et livre sa réponse avant que sa saisie ne soit achevée, en modifiant sa réponse instantanément si la question ne correspondait pas à son anticipation. L'analyse en mémoire s'appuie sur un cache « heuristique » qui décide ce qu'il doit conserver en mémoire en fonction des analyses qui sont réalisées.

Un cache qui décide ce qu'il doit garder

« Exalytics n'analyse pas seulement les données relationnelles et multidimensionnelles, mais aussi les données non structurées, dans tous types d'associations, a encore indiqué le PDG d'Oracle. « Lorsque vous avez des réponses instantanées, vous utilisez un autre type d'interface », a-t-il aussi ajouté. Une visualisation interactive des données qui fournirait « les clés pour analyser à la vitesse de la pensée », suggère Oracle. Une démonstration d'Exalytics doit être donnée lundi, au cours de laquelle sera présentée cette interface qui fonctionnera de la même façon sur un PC et la tablette iPad d'Apple.

Illustration : Larry Ellison, PDG d'Oracle, présente Exalytics sur OpenWorld 2011 (crédit : MG)

(...)(30/09/2011 10:15:57)Gartner donne des conseils pour économiser sur les coûts d'infrastructures

1-Se concentrer sur le court terme

Il faut d'abord différer tout ce qui ne concerne pas des infrastructures critiques. Et se poser trois questions. Est-ce bien une initiative de haute priorité qui doit être achevée rapidement ? Sera-t-elle réalisable dans des structures de coûts et dans des délais prévus ? Permettra-t-elle d'éviter des pannes majeures ou des dégradations de performances ?

2-Ré-examiner les coûts réseau

Ces coûts en général s'offrent la part du lion dans les coûts de l'entreprise. Il faut donc renégocier les contrats avec les fournisseurs pour s'assurer que leurs tarifs contractuels sont basés sur le marché. Des mesures importantes peuvent également être prises pour optimiser les coûts de réseau en affinant la conception et l'approvisionnement de ces réseaux.

3-Consolider les infrastructures

Cette partie est liée à la normalisation, l'intégration et la virtualisation des infrastructures. Dans le passé, la montée de l'informatique distribuée et d'autres tendances ont contribué au déclin des grands sites de traitement. Maintenant, les datacenters reviennent et Gartner prévoit que cette tendance se poursuivra durant toute la décennie à venir. D'autres tendances vont arriver : la rationalisation du serveur, la croissance matérielle, la limitation des coûts, la consolidation des données d'entreprise dans les sites de traitement de données plus importants.

4-Virtualiser

Les serveurs fonctionnent avec un très faible taux d'utilisation moyenne (moins de 15 pour cent). Les logiciels de virtualisation multiplient cette utilisation généralement par quatre ou plus, ce qui signifie, pour une charge de travail donnée, qu'une entreprise peut généralement réduire le nombre de serveurs physiques par quatre. Cela signifie des coûts de matériel et d'énergie réduits chacun de plus de 50 pour cent.

5-Réduire les besoins d'alimentation et de refroidissement

Dans le passé, les centres de données étaient souvent ouverts sur d'immenses zones de surface au sol d'un blanc immaculé, entièrement alimentés et soutenus par une alimentation sans coupure (UPS), l'eau étant refroidie par air. Avec le coût des équipements mécaniques et électriques, ainsi que le prix de l'énergie, ce modèle ne fonctionne plus.

[[page]]

Les centres de données utilisent beaucoup moins d'énergie, prennent moins de place et coûtent beaucoup moins.

6-Contenir la croissance du stockage

Le réseau et la capacité de stockage sont tous en croissance annuelle à deux chiffres. Le Gartner prédit que, d'ici 2016, les entreprises vont installer, en téraoctets, 850 pour cent de plus que ce qu'ils ont installé en 2011. De multiples approches doivent être adoptées, notamment l'utilisation de la virtualisation du stockage, la hiérarchisation et de stockage automatisé de gestion des ressources (MRS) des outils.

7-Réduire le coût du support utilisateur

Le support pour les utilisateurs est généralement d'environ 8 % du total des dépenses IT, et la plupart des entreprises ont au moins quatre niveaux de soutien, chacun avec un coût et un niveau d'expertise différents. Pour réduire ces coûts, les entreprises ont besoin de réduire d'un tiers les appels au support par l'utilisateur.

8-Simplifier les opérations IT

Pour contenir et dénombrer les coûts associés à la gestion des opérations et des infrastructures, les processus doivent être rationalisés et aussi efficaces que possible. Ceci implique généralement la mise en oeuvre d'ITIL, le cadre standard de facto dans les opérations informatiques. L'objectif principal est d'améliorer la gestion du service et sa qualité, mais ITIL a été connu aussi pour réduire les charges d'exploitation.

9-Renforcer l'IT Asset Management (ITAM)

ITAM en soi ne réduit pas les coûts, mais c'est un outil très efficace pour identifier et évaluer les possibilités de réduction des coûts. ITAM peut aider à déterminer la durée de vie de certains actifs, reporter les mises à niveau et éliminer ou combiner les licences de logiciels, ainsi que le remplacement de certains contrats de services de maintenance. Les référentiels actifs informatiques sont généralement des outils les plus efficaces pour cette entreprise. Ces outils peuvent maintenir les dates, gérer les changements et envoyer des courriels des rappels pour s'assurer que le processus de cycle de vie est géré de manière proactive.

10-Optimiser le multi-sourcing

Le sourcing est peut-être la décision la plus stratégique. Les critères de décision clés sont le contrôle sur les aspects qui sont d'une importance stratégique et critique pour l'entreprise, en jouant de la force du personnel disponible, en définissant les lignes de démarcation claires, en réduisant le nombre de fournisseurs impliqués à un petit nombre gérable et en déterminant ce qui rend solide le plan financier.

(...)(29/09/2011 17:03:17)Bull met de l'extreme computing dans ses mainframes gcos 7

Le groupe français Bull fait passer ses mainframes gcos 7 à l'échelon supérieur en leur faisant profiter de l'architecture MESCA (multiple environment in a scalable architecture) qu'il exploite dans ses supercalculateurs bullx et ses grands serveurs novascale gcos 8.

Les modèles novascale gcos 7010 que le constructeur vient d'annoncer apportent deux fois plus de puissance que la précédente génération de systèmes gcos 7, avec lesquels ils sont compatibles. Les utilisateurs pourront continuer à faire fonctionner leurs applications tout en interopérant avec d'autres environnements, Windows, Linux, Unix, ainsi qu'avec d'autres mainframes. Au sein des novascale gcos7, on peut exploiter des applications Windows et gcos 7 dans des environnements indépendants (processeurs, mémoire et sous-système de stockage). Du côté des bases de données, le logiciel SQL XT permet d'accéder à Oracle, Microsoft SQL Server, ainsi qu'à la base Open Source PostgreSQL, sans installer d'environnements spécifiques sur gcos 7. Bull propose une offre de services associant conseil et mise en oeuvre pour aider ses clients à faire migrer leurs bases de données existantes vers PostgreSQL, afin de réduire leurs coûts de possession.

21 modèles à base de Xeon E7

La gamme novascale gcos 7010 se compose de 21 modèles de serveurs, exploitant des processeurs mono-coeurs et multi-coeurs Intel Xeon E7 serie 4800. L'architecture MESCA permet d'héberger sur un seul système novascale 7010 jusqu'à quatre serveurs gcos 7 qui seront administrés à partir d'une seule console. Bull souligne l'intérêt de cette option pour consolider les infrastructures dans les grands datacenters. Le constructeur a cherché à réduire la facture d'électricité liée à l'utilisation de ses systèmes, par l'utilisation de composants à basse consommation, le recours à des blocs d'alimentation active/passive brevetée par Bull, et par une meilleure dissipation thermique. L'encombrement des serveurs au sol a également été réduit.

En France, la Régie des Transports de Marseille a déjà adopté le système novascale gcos 7010. Une autre société est intéressée en Allemagne, Sonepar, spécialisée dans la distribution de matériel électrique.

Illustration : Novascale 7010 de Bull (crédit : D.R.)

Oracle parle de l'avenir de Sparc et (maj)

Oracle a dressé pour sa famille de processeurs Sparc une feuille de route particulière, une manière de se détacher un peu plus de l'héritage de Sun Microsystems.

En rachetant Sun, début 2010, Oracle mettait dans son panier une entreprise en difficulté qui venait aussi d'abandonner le développement d'une puce Sparc 16 coeurs nom de code Rock. Sun travaillait depuis 5 ans sur ce projet, à un moment où l'ensemble du marché se tournait de plus en plus vers des systèmes x86 moins chers. A l'origine, elle prévoyait de livrer sa puce Rock en 2008. Jusqu'à ce que Sun abandonne le développement de sa puce Rock, l'avenir de Sparc, et par extension, celui du système d'exploitation Solaris, est resté incertain. Puis il y a eu la reprise de Sun par Oracle, et des bénéfices en baisse pour Solaris - moins 3,2% en 2010 - « les utilisateurs finaux affichant un certain scepticisme quant à l'engagement d'Oracle pour la plateforme Solaris », avait rapporté Gartner à l'époque

L'annonce d'une puce Sparc T4 et de systèmes prêts à la supporter, clarifie l'avenir et montre qu'Oracle veut tourner la page. Cette orientation s'affirme d'autant plus que Mark Hurd, vice-président Oracle, a déclaré cette semaine que l'entreprise investissait dans le développement de Sparc, et qu'elle fournirait la semaine prochaine une roadmap traçant la voie à plusieurs générations de puces. Notamment, le successeur à la puce T4, le T5, est déjà programmé, « ce qui signifie en fait que celle-ci est déjà en phase finale de conception, » comme l'a précisé le vice-président d'Oracle dans une interview. « Il existe évidemment des opportunités qui nous incitent à davantage développer Sparc », a déclaré Mark Hurd. Solaris profitera aussi de ces investissements, de façon à « coupler » la puce au système d'exploitation et profiter « de la meilleure association possible», a-t-il ajouté.

Le haut de gamme visé en priorité

Nathan Brookwood, analyste chez Insight 64, a déclaré que le T4 était « le processeur Sparc le plus sophistiqué et le plus performant depuis longtemps ». L'analyste pense que sous la direction d'Oracle, les objectifs de l'équipe d'ingénierie de Sparc sont « beaucoup mieux ciblés », notamment en termes de prise de risque pour le projet et également pour ce qui concerne la livraison de mises à jour à date donnée. L'idée de Sun était de construire une famille de puces T1 pour faire tourner ses systèmes bas de gamme, et de concevoir en parallèle un processeur Rock pour des systèmes haut de gamme. « Après le rachat, Oracle a estimé que le développement simultané de deux types de semi-conducteurs était trop ambitieux et trop risqué, » a déclaré James Staten, analyste chez Forrester Research. « A la place, Oracle a pensé pouvoir s'engager dans la conception d'un seul processeur haut de gamme et répondre aux exigences élevées, liées à son développement, » a déclaré l'analyste. « La conception était plus cohérente, avec une feuille de route et des délais beaucoup plus réalistes », a ajouté James Staten.

Chacun des huit coeurs du T4 peut tourner à 3 GHz, contre 1,65 GHz pour le précédent T3. Mais la puce apporte aussi un traitement des données différent. « C'est ce qui fait que la puce gagne autant en performance, » a déclaré Nathan Brookwood. En effet, « La T4 est la première puce Sparc à utiliser un traitement des données out-of-order (OOE), » a déclaré Brookwood. « Cette technique permet au processeur de réordonner les instructions afin d'optimiser les performances. Il exécute les instructions selon un ordre guidé par la disponibilité des données, ce qui permet d'éviter les retards. Par opposition à l'approche classique, où le processeur prend les instructions dans l'ordre où elles sont codées, » a-t-il expliqué

Cloud Personal : Microstrategy cible les utilisateurs Excel

MicroStrategy espère que, avec le service Cloud Personal, offert gratuitement pour l'instant, son logiciel de business intelligence (BI) trouvera un public auprès des utilisateurs de Microsoft Excel qui souhaitent élargir leur environnement de travail. Pour utiliser Cloud Personal, actuellement disponible en version bêta publique, rien de plus simple : après avoir créé un compte pour accéder au service, les utilisateurs envoient leurs données vers le datacenter de MicroStrategy, pour ensuite les exploiter à l'aide d'une série d'outils de visualisation et enfin les partager éventuellement avec d'autres personnes via les sites de réseautage social ou par mail.

Ce service de création de tableaux de bord personnels en mode hébergé prêt à l'emploi accepte des fichiers Microsoft Excel et les organise en tableaux. Une contrainte, la première ligne de chaque colonne doit être identifiée par un titre. Par ailleurs, « pour le moment, les fichiers comportant des tableaux croisés dynamiques, ou d'autres formats de fichiers, ne sont pas traités », comme l'a expliqué Microstrategy dans une FAQ. « Cloud Personal peut notamment travailler avec des ensembles de données publiques, comme celles que l'on trouve sur des sites institutionnels du genre Data.gov (nom adopté aux Etats-Unis), » a ajouté Microstrategy. Grâce à un framework de sécurité, les utilisateurs peuvent déterminer qui a le droit de voir leurs rapports et révoquer les autorisations données à un individu pour voir ses tableaux de bord à tout moment. La solution tourne entièrement dans l'interface d'un navigateur Internet, et ne nécessite pas d'installation locale. Cependant, elle a besoin du Player Flash d'Adobe pour fonctionner. MicroStrategy a prévu, pour les possesseurs d'iPad, une application mobile gratuite qui leur permet de télécharger les fichiers PDF et voir les tableaux de bord créés avec Cloud Personnal.

Une adoption par le gratuit

Microstrategy aimerait inciter les utilisateurs à soumettre « leurs tableaux de bord les plus pertinents» sur un site web, et en faire profiter tout le monde. Environ 20 modèles de tableaux de bord ont déjà été mis en ligne sur le site. Cloud Personal prend un peu exemple sur des entreprises comme Tableau, qui a offert pendant un certain temps une version gratuite de ses outils de visualisation de données. L'objectif est de sensibiliser les utilisateurs au produit et de rendre ses fonctionnalités indispensables, pour ensuite vendre des licences payantes aux entreprises qui les emploient.

MicroStrategy poursuit ainsi sa stratégie de fournir des services de BI prêts à l'emploi et de proposer des outils que les salariés d'une entreprise peuvent adopter sans passer par le service informatique.

L'UEFA choisit le cloud d'Interoute pour son informatique et les télécoms

L'Union des associations européennes de football (UEFA) a choisi les services cloud paneuropéens d'Interoute pour supporter l'ensemble de son activité, les compétitions et les événements, durant les trois prochaines années. Interoute hébergera tous les systèmes et applications directement utilisés par l'association européenne, dont la plateforme FAME (Football Administration and Management Environment) et le site web uefa.com.

FAME est la plateforme informatique sur laquelle reposent les principaux services de l'UEFA, comme les réservations des médias, les accréditations, la gestion des compétitions, mais aussi les services pour les arbitres et les partenaires commerciaux. Quant au site web, il nécessite une infrastructure robuste, en raison du grand nombre de visiteurs et de contenus multimédias proposés. Lors de la finale de l'euro, la plateforme a été visitée par 343 millions d'internautes.

Daniel Marion, Directeur des Technologies de l'Information et de la Communication de l'organisation, explique: « Interoute a conçu, construit et déployé avec succès une plateforme qui nous fournit à la fois la fiabilité et la stabilité que nous demandions, mais aussi une souplesse d'adaptation aux événements. Le site uefa.com est l'un des dix sites web les plus visités au monde pendant les grands rendez-vous de football, il fournit des vidéos de haute qualité aux amateurs de football à travers le monde. Nous avons trouvé en Interoute le partenaire capable d'allier les hauts niveaux de performance avec la qualité dont l'UEFA et ses compétitions ont besoin.»

(...)| < Les 10 documents précédents | Les 10 documents suivants > |