Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 51 à 60.

| < Les 10 documents précédents | Les 10 documents suivants > |

(27/10/2011 12:24:03)

Les entreprises incapables d'analyser 90% de leurs données, selon IBM

D'après Jeff Jonas, chercheur responsable de l'Entity and Analytics Group d'IBM, « à mesure que les ordinateurs deviennent plus rapides, les entreprises deviennent plus bêtes - aujourd'hui, elles ont la chance de bien comprendre 7% de leurs données, mais cela ne va pas durer. » Avant de se retrouver chez Big Blue, Jeff Jonas dirigeait SRD, une entreprise qui fournissait des systèmes aux casinos, et acquise en 2005 par IBM.

La multinationale américaine voudrait pousser les entreprises vers des solutions de gestion de données avant que la quantité de données générées ne se retrouve hors de contrôle pour la plupart d'entre elles. Pour cela, elle veut proposer aux services informatiques de s'appuyer sur sa solution de gestion et d'analyse des données de type BigData et ses solutions d'analytiques portées dans le cloud et pour mobiles, pour l'accès aux données.

Pour Sarah Diamond, d'IBM Global Business Services, « les banques devraient pleinement adopter les programmes de transformation de données pour satisfaire les régulateurs et offrir plus de croissance à leurs investisseurs. » Selon elle, « la crise dans le secteur des services financiers s'est prolongée, et le FMI considère qu'il a déjà effacé 2 200 milliards de dollars de créances douteuses et autres pertes. » Sarah Diamond affirme que « la transformation est devenue une nouvelle «norme», les silos de données et les tableurs ne suffisant plus pour gérer ses datas. » Ajoutant que « les entreprises doivent offrir de la transparence pour satisfaire les autorités règlementaires et créer de la croissance. »

Pendant cette semaine de conférence, IBM va en profiter pour donner plus de contenu à sa stratégie de gestion de données. La technologie BigInsights de l'offre SmartCloud de Big Blue vise à aider les clients à donner du sens aux masses de données non structurées provenant de diverses sources, y compris les réseaux sociaux et les appareils mobiles. Si l'on estime que 80 % des datas d'une entreprise sont des données non structurées, on comprend la difficulté à les gérer et à les interpréter pour un usage professionnel.

L'application IBM Cognos Mobile pour iPad inaugure aussi le support pour appareil mobile, et le logiciel SPSS Statistics 20.0 (voir illustration principale) intègre une fonction de cartographie qui permet aux utilisateurs d'ajouter une dimension géographique à l'analyse de données et au reporting. Grâce à cette fonction, ils pourront cibler, faire des prévisions et des prospections par zones géographiques.

(...)(26/10/2011 11:58:03)

IBM critique l'acquisition d'Autonomy par HP

Dixit IBM, HP devra « lutter » pour réussir à intégrer les solutions de gestion de l'information de l'éditeur Autonomy et les ressources combinées des deux sociétés ne seront pas une menace sérieuse pour ses offres de gestion et d'analyse des données. Cette déclaration a été rapportée par notre confrère de ComputerWorld UK, Antony Savvas, à l'occasion de la sixième édition de l'événement Information On Demand (IOD) d'IBM (du 23 au 27 octobre à Las Vegas). 10 000 clients et partenaires étaient attendus sur ce salon dédié aux solutions de gestion des données de Big Blue.

Interrogé à cette occasion sur l'impact attendu suite au rachat d'Autonomy par HP, Steve Mills, senior vice-président en charge de l'activité logiciels et systèmes d'IBM, a été particulièrement critique. M.Mills a ainsi déclaré: « Ça va être dur pour HP d'exploiter Autonomy et obtenir un retour sur investissement, ils ont dépensé beaucoup d'argent pour ça [cette acquisition] et il n'y a aucune certitude quant à ce retour. (...) Nous étions déjà en compétition avec Autonomy sur ce marché avant l'acquisition et faire partie de HP sera ou ne sera pas une difficulté pour eux. »

Une course frénétique aux acquisitions

HP a récemment finalisé l'acquisition d'Autonomy pour un montant de 11,7 milliards de dollars et même IBM a récemment acquis l'éditeur canadien d'analyses de risques Algorithmics, qui travaille notamment avec HSBC et Société Générale, pour un montant plus modeste, 387 millions de dollars. Steve Mills a indiqué sur ce dernier point : « Nous sommes un peu plus réfléchi quant à la façon de dépenser l'argent des actionnaires ! »

Cela dit, ces dernières années IBM a effectué une vingtaine d'acquisitions dans le domaine de la gestion de l'information et de l'analyse des données. La firme d'Armonk estime d'ailleurs qu'elle est sur la bonne voie pour capter une bonne partie d'un marché estimé à 16 milliards de dollars en 2015.

Oracle toujours dans le collimateur d'IBM

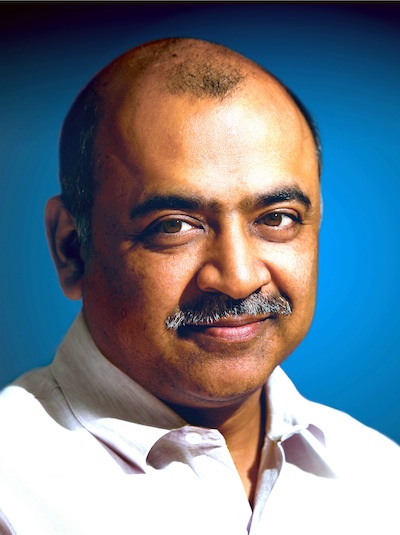

La compétition avec le duo HP / Autonomy n'était pas la seule cible d'IBM lors de cette discussion avec le dirigeant d'IBM, Oracle est également venu sur le tapis. A la question de savoir si le nombre d'inscrit à événement IOD n'était pas plutôt modeste par rapport aux 45 000 personnes qui participent tous les ans à la manifestation OpenWorld, Arvind Krishna, directeur général d'IBM en charge de l'activité gestion de l'information, a rejeté la comparaison. « Alors qu'Oracle a choisi d'organiser un grand événement, nous avons cinq manifestations différentes qui se concentrent sur des domaines différents : cet événement IOD, la conférence Impact, Lotusphere, Rational et Tivoli, et nous pensons que cela fonctionne beaucoup mieux ainsi. »

Arvind Krishna, directeur général d'IBM en charge de l'activité gestion de l'information

Pendant la keynote d'Arvind Krishna, Curt Cotner, employé au sein de la division gestion de l'information d'IBM, a tapé sur les capacités de traitement des bases de données d'Oracle, indiquant que le nombre de coeurs et processeurs utilisés dans les résultats publiés par l'éditeur de Redwood était «incertain».

Un autre dirigeant d'IBM dans le New Hampshire, qui a préféré resté anonyme, a également cogné sur Oracle en affirmant à notre confrère de ComputerWorld UK : « Nous sommes meilleurs quant à l'intégration de technologies issues d'entreprises que nous avons achetées, il suffit de regarder Oracle, ils ont parlé de « Fusion » pendant des années après les acquisitions de PeopleSoft et JD Edwards, et ces technologies ne sont pas encore totalement intégrées. »

Illustration principale : Steve Mills, senior vice-président en charge de l'activité logiciels et systèmes d'IBM, crédit photo D.R.

Qlikview 11 privilégie le collaboratif

Le spécialiste de la Business Intelligence conduite par l'utilisateur, Qliktech, a présenté la dernière version de sa solution Qlikview. La 11ème édition comprend plusieurs fonctionnalités complémentaires et l'éditeur a travaillé sur cinq thèmes en particulier rappelle Stéphane Briffod, commercial avant-vente chez Qliktech. En premier lieu, le collaboratif car « il est nécessaire de partager l'information, mais aussi de savoir d'où viennent les sources » précise le responsable. Pour cela, Qliktech a intégré un système d'annotation au sein d'une session de Qlikview. Par exemple, si un directeur commercial travaille sur une analyse des parts de marché de certains produits dans une zone géographique particulière, il peut lorsqu'il affine sa recherche, annoter la page et la transmettre par mail à ses collaborateurs pour avoir des informations en retour. Stéphane Briffod indique que cette fonctionnalité est disponible avec des outils de collaboration existant comme Chatter de Salesforce.com et Sharepoint de Microsoft.

Le partage d'écran avec des utilisateurs extérieurs fait aussi son apparition. La partie mobile est aussi un des thèmes importants de Qlikview 11, la solution est d'ailleurs portée sur les smartphones et les tablettes comme l'iPad, mais aussi la Playbook de Blackberry ou les terminaux fonctionnant sous Android.

Autre axe de l'offre décisionnelle, le développement rapide d'applications. Pour ce dernier, Stéphane Briffod indique « nous avons affiné la récupération de sources d'information pour créer sa propre application de BI à partir des données les plus pertinentes (tableur, graphes, rapports, etc.) ». De plus, Qlikview s'interface avec d'autres plateformes comme Powercenter d'Informatica, mais aussi SAP et Salesforce.com.

IBM intègre de l'analytique dans les mainframes et les serveurs

IBM a décrit ses serveurs Smart Analytics System comme des packs comprenant du hardware et des logiciels analytiques, de la BI (business intelligence) et des systèmes de traitement d'importants volumes de transactions. Big Blue en a également profité pour annoncer une appliance de business analytics (BA) d'entrée de gamme capable de traiter des données à la volée, pour les transactions réalisées dans le cloud par exemple.

Le constructeur fait le choix de s'orienter vers une offre de serveurs conçus pour des charges de travail spécifiques, comme les bases de données et la gestion des processus d'entreprise (BPM). Les serveurs Smart Analytics sont basés sur des matériels IBM existants et tournent sur des puces x86 et sur des processeurs Power. Comme le fait valoir IBM, les solutions Smart Analytics 9700 et 9710, basées sur l'architecture zEnterprise, ont pour objectif de fournir une appliance analytique opérationnelle à un prix abordable. Ces serveurs peuvent tourner sur SUSE ou Red Hat Linux.

Le constructeur a également annoncé un Smart Analytics System 7710 basé sur le processeur Power, et le 5710, basé sur le processeur x86, deux solutions « que l'on peut déployer en quelques jours, et qui comprennent notamment des fonctions de reporting en BI, d'exploration de données et d'analyse des données non structurées, » a ajouté le constructeur dans sa présentation. « Basé sur le serveur P740, le Smart Analytics System 7710 tourne sous l'OS AIX et convient à l'entreposage de données en-dessous des 10To, » a encore détaillé IBM. Quant au 5710, basé sur une architecture System X, il tourne sous Linux et est livré avec InfoSphere Warehouse 10, ainsi que le logiciel de BI Cognos 10. Pour l'instant, on ne connaît ni le prix, ni la date de disponibilité de ces serveurs.

Une vue sur la concurrence et sur le cloud

Sur le marché du serveur unifié, IBM est en concurrence avec Oracle, lequel propose une Exadata Database Machine, un système préconfiguré conçu pour l'entreposage de données et le traitement des transactions. La solution Exadata associe un logiciel d'Oracle à du hardware et des solutions de stockage Sun.

IBM a également annoncé une technologie DB2 Analytics Accelerator, qui doit aider les clients à traiter beaucoup plus rapidement les quantités massives de données circulant à travers le cloud. « Au lieu d'attendre la sortie des rapports, les clients peuvent disposer d'une analyse approfondie et prendre des décisions alors que les transactions sont en cours de traitement dans le cloud, » a déclaré une porte-parole d'IBM. L'appliance analytique se branche sur le serveur d'entreprise zEnterprise 196 d'IBM, et l'accélérateur se connecte à la base de données DB2 pendant que les transactions sont traitées dans le cloud.

L'accélérateur intègre une technologie héritée de Netezza, un fournisseur de données analytiques basé aux Etats-Unis, acquis par IBM l'an dernier pour 1,7 milliard de dollars. « C'est la première fois que la technologie de Netezza est portée sur le cloud, » a indiqué la porte-parole d'IBM. L'appliance pour serveurs sera disponible en novembre, mais IBM n'a pour l'instant fourni aucune indication sur son prix.

Crédit Photo : IBM

Oracle rachète Endeca, spécialiste de l'analyse des données non structurées

Oracle rachète Endeca Technologies pour un montant non dévoilé. L'opération doit être finalisée avant la fin de l'année. Cette acquisition s'apparente à une réponse d'Oracle sur le rachat d'Autonomy par HP. Endeca est connue pour son moteur MDEX pour le traitement des données non structurées, telles que les emails et les informations textuelles d'autres provenances, mais aussi pour sa plateforme applicative d'analyse Latitude et son produit CEM (Customer Experience Management) InFront.

Les entreprises font face à une explosion du volume d'informations non structurées générées par leurs sites web, les réseaux sociaux, les centres d'appels et d'autres sources. HP et Oracle veulent offrir aux entreprises la capacité d'analyser en détail et rapidement les données pour mieux les comprendre et réaliser des économies.

Avec les application ATG Commerce et de BI (Business Intelligence) d'Oracle, les solutions d'Endeca créeront « une suite d'outils analytiques pour corréler et analyser les données structurées et non structurées grâce à un ensemble commun d'interfaces utilisateur, » précise la firme de Redwood . Des applications analytiques préconfigurées pour certaines industries sont également envisagées.

Sur le plan de la distribution, Oracle bénéficie aussi du portefeuille client d'Endeca qui comprend 600 clients, parmi lesquels Toyota, Ford, Raytheon et Walmart.

SGI lance un package Cloudera Hadoop

Le constructeur de serveurs haute performance SGI a annoncé hier qu'il prévoyait de proposer des clusters pré-construits exploitant la plate-forme d'analyse de données Apache Hadoop. Les clusters Hadoop du groupe exécuteront des versions de la distribution Cloudera (CDH), sur la ligne de serveurs Rackable. SGI, qui rejoint le programme Cloudera Partner Connect, proposera une seule ligne téléphonique de support pour répondre aux questions des clients sur le matériel de SGI ou sur le logiciel Hadoop.

SGI va commercialiser ces clusters sur ses marchés traditionnels qui sont les administrations et les institutions financières, en se concentrant sur ceux qui ne disposent pas de compétences internes pour construire de tels clusters. Les principaux utilisateurs d'Hadoop, parmi lesquels des géants de l'Internet comme Yahoo ou des agences de renseignements américaines, se sont constitués une expertise dans ce domaine, en construisant leur propre déploiement Hadoop. Toutefois, la plupart des entreprises n'ont pas cette capacité. Cela ne les empêche pas de vouloir utiliser Hadoop pour analyser des volumes de données de plus en plus important, a souligné Bill Mannel, responsable des produits chez SGI.

De telles entreprises ont des budgets moins conséquents et sont à la recherche de solutions logicielles robustes et de services de support, a t-il ajouté.

Spécialisé sur le marché des supercalculateurs, SGI est bien placé pour fournir aux clients de grands clusters à des coûts intéressants, considère Ed Albanese, responsable du développement chez Cloudera, qui rappelle que SGI s'est toujours concentré sur le ratio prix/performance.

Dans le cadre d'un benchmark Terasort que SGI a réalisé ce mois-ci, un cluster Hadoop SGI de 20 noeuds a pu classer 100 Go de données en 130 secondes. Il s'agissait de serveurs Rackable C2005-TY6 demi-profondeur, chacun exploitant des processeurs Intel Xeon E5630, 48 Go de mémoire et 4 disques SATA de 1 To. Le constructeur dévoilera les prix, les références, les configurations et d'autres détails supplémentaires lors de la conférence Hadoop World, qui se se déroulera à New-York, les 8 et 9 novembre prochains.

Préparation d'un cluster Hadoop dans les usines américaines de SGI dans le Wisconsin (crédit : SGI) - Cliquer ici pour agrandir la photo (...)

Trimestriels IBM : une hausse de 8% tirée par les marchés émergents

IBM vient d'annoncer un bénéfice net de 3,8 Md$, en hausse de 7%, au troisième trimestre 2011, et un chiffre d'affaires de 26,16 milliards de dollars, qui progresse de 8% mais se situe un peu au-dessous des prévisions des analystes. En tenant compte des variations des taux de change, le chiffre d'affaires a progressé de 3%. Le bénéfice par action est de 3,19 dollars sur une base GAAP, soit une augmentation de 13%.

Le directeur financier Mark Loughridge (en photo) a souligné l'importance des marchés émergents pour la croissance future du groupe. Les revenus provenant des marchés chinois et brésilien ont augmenté de 19 et 13% à taux de change constant. Les marchés en croissance pèsent 23% du chiffre d'affaires d'IBM sur la période. Selon le directeur financier, les revenus ont été tirés par la croissance de ces marchés, en cohérence avec le modèle du groupe et en conjonction avec ses autres initiatives clés visant à assurer sa progression.

Les activités cloud ont doublé en un an

Pendant la conférence téléphonique de présentation de ces résultats financiers, les analystes ont, de façon répété, interrogé IBM sur l'atonie des ventes sur le secteur public et dans les services financiers, de même que, de façon générale, sur les principaux marchés. Mark Loughridge a demandé aux investisseurs de regarder les solides performances réalisées par divisions, notamment sur l'activité logiciels et services. Il estime qu'il ne faut pas considérer le secteur des services financiers en se bornant aux marchés principaux et explique que les problèmes économiques que chacun évoque ne se retrouvent pas sur les marchés en croissance.

Les activités relatives aux logiciels d'IBM ont généré un chiffre d'affaires de 5,8 milliards de dollars, en hausse de 13%. La division services a progressé de 8%, à 15,1 Md$ et la division Systems et Technology de 4%, à 4,5 Md$. Parmi les réussites du trimestre, les ventes des systèmes Power ont augmenté de 15%.

D'autres domaines ont porté leurs fruits, notamment les solutions analytiques dont les revenus ont augmenté de 19%. Quant aux initiatives Smarter Planet, elles affichent une augmentation de 50% et les revenus générés par les activités cloud ont doublé par rapport à l'an dernier, indique IBM sans fournir plus de précisions. Cette croissance a conduit le groupe dirigé par Sam Palmisano à relever ses prévisions de résultats pour l'année 2011, les faisant passer de 13,25 à 13,35 dollars par action.

Illustration : Mark Loughridge, directeur financier d'IBM (crédit : IBM)

SAS Forum 2011 : Analyser intelligemment les Big Data

L'éditeur d'outils décisionnels SAS a réuni ses clients et partenaires au CNIT (Paris La Défense) les 13 et 14 octobre 2011 à l'occasion de son forum annuel. Il a proposé une cinquantaine de sessions en plus de l'habituel village de partenaires. Au-delà des sessions plus techniques, l'intervention d'ouverture a été l'occasion de prendre un peu de recul face aux bouleversements actuels de notre monde.

Edouard Fourcade, DG de SAS France, a ainsi interpellé les participants : « comment s'assurer que la décision prise est bonne quand le volume de données explose mais que l'on ne peut pas en analyser plus qu'avant ? En effet, la proportion d'information analysée baisse. » Pour lui, le concept de « Business Intelligence » doit laisser la place à celui de « Business Analytics » qui assimile autant les informations internes classiques que tous les signaux externes. Les informations ainsi compilées intègrent ce qui peut ressortir des médias sociaux au sens le plus large et tous les échanges avec les clients, les prospects et l'écosystème.

Haute performance, e-reputation et mobilité

Il a revendiqué pour SAS une place majeure dans l'innovation grâce aux investissements considérables en R&D (un quart du chiffre d'affaires). Cette innovation, pour répondre aux nouveaux défis, se focalise sur trois points principaux : la haute performance pour permettre de traiter de gros volumes de données en un temps raisonnable, l'analyse de e-réputation et l'accès mobile en tous lieux et tous moments à tous les rapports dynamiques sur les nouveaux terminaux (smartphones, tablettes...). Il s'agit ainsi d'être plus réactif face aux exigences du marché.

Cette « révolution mobile » a été décrite et défendue par Chibout Morald, actuellement DG d'Autolib (groupe Bolloré) comme étant avant tout celle de l'instantanéité. Cette révolution est donc plus comportementale que réellement technique, même si, pour lui, il y aura d'ici un an plus de smartphones que de PC.

PASS Summit 2011 : Microsoft saute dans le wagon Hadoop avec Hortonworks

Microsoft va collaborer avec Hortonworks pour développer la mise en oeuvre du framework Apache Hadoop sur son environnement Windows Server et sa plateforme cloud Azure. Cette société, issue de Yahoo, lui apportera son expertise pour intégrer Hadoop dans Windows. On savait depuis cet été que l'éditeur de Redmond s'était attelé à ce projet, l'équipe de SQL Server ayant publié un billet à ce sujet sur son blog officiel.

Une pré-version du service pour Azure est prévue pour la fin de cette année, a indiqué Microsoft sur sa conférence utilisateurs PASS Summit consacrée à SQL Server (du 11 au 14 octobre à Seattle). Tandis que celle destinée à Windows Server arrivera courant 2012 et fonctionnera avec les outils de Business Intelligence de Microsoft. Ces outils permettront aux clients de l'éditeur de mieux appréhender la prise en compte des Big Data (flux d'informations remontés des capteurs, des connexions web, données non structurées provenant des réseaux sociaux, fichiers vidéo, etc.), a confirmé Ted Kummert, vice-président corporate de la division Plateforme Business de Microsoft.

Oracle a aussi adopté Hadoop et IBM racheté Platform Computing

La semaine dernière, dans ce domaine, Oracle a annoncé la solution Big Data Appliance (matériel + logiciel) qui exploite également Hadoop, ainsi qu'une base de données NoSQL maison et une distribution du langage de programmation R pour l'analyse statistique, afin de pouvoir traiter les volumes de données importants.

Hier, IBM a de son côté annoncé le rachat de l'éditeur canadien Platform Computing, spécialisé sur la gestion des clusters et des traitements en grille dans les environnements distribués, dans lesquels Hadoop est typiquement exploité. Ce framework Open Source, qui supporte les applications portant sur les Big Data, suscite de plus en plus l'intérêt des responsables informatiques pour ses capacités à traiter les énormes flux de données qu'ils doivent prendre en compte. Un nombre croissant d'entreprises cherche à les collecter afin de les analyser pour en tirer des informations significatives pour les activités. Jusqu'à présent, elles se trouvaient limitées pour le faire par les limites des bases de données relationnelles traditionnelles, avant tout conçues pour manipuler les données structurées.

Les premiers à l'avoir adopté, parmi lesquels Yahoo, AOL, Google et d'autres, se sont servis d'Hadoop pour stocker et analyser des petaoctets d'informations non structurées. Les autres technologies de datawarehouse se sortent moins bien de ce type de traitements.

Une belle visibilité pour Hortonworks

Pour Merv Adrian, analyste au Gartner interrogés par nos confrères de Computerworld, l'alliance entre Microsoft et Hortonworks n'est pas surprenante. Pour lui, chacun des principaux fournisseurs de base de données doit prendre garde de ne pas amener les clients qui voudront s'atteler aux Big Data à puiser dans d'autres offres. La question principale restant : vont-ils aller seuls sur ce terrain ou vont-ils s'attacher l'expertise d'un spécialiste. Merv Adrian souligne que le partenariat avec Microsoft constitue un « plus » important pour l'éditeur Hortonworks qui réunit une équipe d'experts très spécialisés sur la technologie Apache Hadoop. Cette entreprise, fraîchement émoulue de Yahoo, a pris son indépendance cette année, rappelle l'analyste de Gartner. Sur le marché commercial des systèmes Hadoop, le leader est actuellement Cloudera, cite par ailleurs Merv Adrian.

Selon l'analyste de Gartner, il est probable que de nombreux clients de Microsoft qui commencent à pense aux Big Data pour la première fois n'auront pas entendu beaucoup parler d'Hortonworks. Voilà qui devrait donner une belle visibilité à cette société.

De son coté, Stephen O'Grady, analyste chez Red Monk, considère qu'il est important pour Microsoft de disposer d'une solution compétitive pour mettre en oeuvre Hadoop sur sa plateforme. Il est clair que Microsoft estime qu'il est important d'optimiser et d'ajuster sa plateforme dans ce domaine pour se différencier.

France Domaine choisit Qlikview pour son décisionnel

Par ailleurs, il fallait que France Domaine -en partenariat avec le Ministère de l'Ecologie- puisse mieux piloter l'atteinte de ses objectifs en matière environnementale dans le cadre du Grenelle de l'Environnement. C'est le sens du projet OCAPI (Outil de Centralisation des Audits et de Prévision des Investissements). Cet outil vient se substituer aux tableaux générés sous SAP Chorus qui étaient vus exclusivement sous un angle financier et est utilisé par les 450 responsables du plan bâtiment (RPB) pour auditer 6000 sites et bâtiments dans le cadre du paln de relance.

Le Bureau des Missions Domaniales (BMD) de France Domaine a fait, en 2009, le choix de la solution QlikView de Qliktech pour réaliser ces deux projets. Le coût des projets n'a pas été dévoilé.

| < Les 10 documents précédents | Les 10 documents suivants > |