Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 41 à 50.

| < Les 10 documents précédents | Les 10 documents suivants > |

(02/12/2011 10:50:11)

CIO.PDF 45 : Le décisionnel 2.0 sous la contrainte de la qualité des données

Réseaux sociaux, tablettes tactiles, Cloud Computing et mobilité sont les quatre sésames des systèmes d'information en 2011. Les managers informatiques sont sous pression pour intégrer ces évolutions au coeur de leurs applications les plus anciennes. En voici des exemples clés dans ce numéro 45 de CIO.pdf.

Ainsi, le décisionnel 2.0 se heurte aux difficultés et au coût de garantir la qualité des données à exploiter. Même si les volumes de données montent en flèche avec l'arrivée des médias sociaux. Des règles et des outils spécifiques doivent donc être mis en place.

Dans ce contexte, l'intégration du DSI aux autres directions, le dialogue avec les CxO et les directions générales, sont vitaux. Nos confrères américains reviennent sur le comment d'une telle nécessité en se basant sur l'histoire du DSI de Toyota Motor Sales alors même qu'une crise majeure frappait l'entreprise.

Le dialogue CxO/CIO peut notamment viser à l'innovation. CIO.PDF 45 revient ainsi sur l'exemple de Carrefour.

(...)(01/12/2011 16:31:44)Oracle fait coexister Fusion Applications avec l'existant

Quelques semaines après l'ouverture de son cloud public annoncé sur OpenWorld 2011, Oracle a dépêché à Paris son vice-président Chris Leone, responsable de la stratégie sur les applications pour le groupe. Sa mission : présenter l'offre Fusion Applications aux clients français. Annoncée en disponibilité générale sur OpenWorld 2011, cette offre modulaire résulte de six années de réécriture et rassemble une centaine de modules qui peuvent être installés sur site, en cloud privé ou s'utiliser dans un cloud public. Les modules de gestion de la relation client (Fusion CRM) et de gestion des ressources humaines (Fusion HCM) sont disponibles sur le cloud public d'Oracle.

Ce matin, Chris Leone a rappelé la complémentarité de Fusion Applications avec les solutions d'Oracle que les entreprises ont déjà installées, notamment ses ERP (E-Business Suite, JD Edwards et PeopleSoft), mais aussi le CRM Siebel. Sur ce point, Chris Leone a été très clair. Fusion Applications ne vient pas déloger l'existant. « Nous continuons à investir dans toutes nos suites applicatives et à les faire évoluer. Continuez à les mettre à jour. Regardez ensuite dans notre offre middleware s'il n'y aurait pas une ou plusieurs briques qui pourraient vous intéresser et envisagez des opportunités de coexistence avec Fusion Applications. »

Lui-même a présenté plusieurs scénarios de coexistence, en insistant sur Fusion CRM et sur les modules de gestion des talents utilisés en mode SaaS (software as a service). Il a également évoqué l'intégration de Fusion Applications avec les solutions de gestion non Oracle, notamment via un module intermédiaire (Accounting hub). Sans oublier la dimension mobile et l'utilisation des logiciels sur tablettes.

Chris Leone a rappelé que les outils entourant Fusion Applications permettaient de configurer différents rôles d'utilisateurs dans l'entreprise. Il a également souligné la mise à disposition de modèles de processus métiers et d'une série d'outils pour personnaliser les applications à différents niveaux (données, processus, reporting, pages).

Réseau social et BI au sein des processus métiers

A l'heure de Facebook et Chatter, Oracle n'a pas oublié d'insérer la dimension « réseau social » dans Fusion Applications. « Nous savions dès le début qu'il nous faudrait le faire », a affirmé ce matin Chris Leone. « Je peux créer des groupes et des équipes de personnes qui interagissent, avec des flux d'activité mis à jour en temps réel. Ce que nous avons voulu faire, c'est intégrer les fonctionnalités de réseau social dans les processus métiers ». De la même façon, Oracle a intégré la Business Intelligence au sein de Fusion Application, sous différentes formes : tableaux de bord, BI mobile, support à la décision, optimisation en temps réel. Dans ce domaine, Chris Leone a expliqué comment Oracle avait répliqué, dans l'offre gestion des talents, certaines fonctions BI qui avaient montré leur efficacité dans le CRM. En l'occurrence, afin de repérer les collaborateurs qui risquaient de quitter l'entreprise, l'éditeur applique aux données RH des modèles utilisés pour lutter contre l'attrition des clients.

Le vice-président d'Oracle explique que de nombreux entreprises s'intéressent à des déploiements hybrides combinant des applications existantes installées sur site et en cloud privé, tandis que d'autres seront exploitées en cloud public. Il cite plusieurs clients (Principal Financial Group, Green Mountain Coffee, Alcoa), déjà présentés sur OpenWorld 2011, représentatifs des multiples possibilités de déploiement. Au passage, Chris Leone souligne que l'outil de réseau social d'Oracle est proposé en mode SaaS, comme un produit indépendant, et qu'il peut aussi être installé par les entreprises à l'intérieur de leur pare-feu.

Illustration : Chris Leone, VP d'Oracle, responsable de la stratégie pour les applications, sur OpenWorld 2011 (Photo Courtesy of Hartmann Studios)

HP combine Autonomy et Vertica pour traiter toutes les données

Hewlett-Packard a rapidement mis à profit ses récentes acquisitions, Vertica racheté en mars dernier et Autonomy en octobre, en rassemblant ces deux logiciels dans une seule solution baptisée Next Generation Information Platform. Avec cette offre disponible fin janvier, les utilisateurs pourront rechercher et analyser des données structurées et non structurées, a expliqué Mike Lynch, ancien CEO d'Autonomy et désormais en charge de l'entité Information Optimization Business Solutions chez HP, lors de l'événement Discover 2011 à Vienne, un rendez-vous qui mêle infrastructures et solutions logicielles.

La plate-forme Vertica Analytics est un logiciel dédié au stockage et à l'analyse de très grandes quantités de données structurées, ou de données qui ont été stockées dans une base de données relationnelle. La solution Autonomy IDOL (Intelligent Data Operating couche) peut quant à elle indexer les données non structurées au sein d'une entreprise, et fournir aux utilisateurs une interface de recherche.

IDOL arrive dans sa version 10

HP propose aujourd'hui une mise à jour de la solution d'Autonomy, IDOL 10, optimisée pour les plates-formes serveurs maison Proliant, et qui inclut un ensemble de liens qui lui permettent de s'intégrer plus facilement avec Vertica. IDOL, dans sa version 10, sera disponible le 1er décembre, et offrira aux utilisateurs la possibilité de travailler avec des données structurées stockées dans la base de données Vertica. Si la force d'Autonomy repose sur ses capacités de traitement de données texte, audio et vidéo, Vertica apporte en sus les ressources d'une base de données en colonnes et des capacités analytiques.

L'interface de recherche unifiée pourrait se montrer particulièrement utile pour afficher dans un seul flux une synthèse reposant sur des données structurées et non structurées. Dans les entreprises, ces informations sont généralement traitées par des systèmes distincts. Par exemple, les informations issues de réseaux sociaux tels que Twitter, qui sont généralement capturées en tant que données non structurées, pourraient être explorées en utilisant les fonctionnalités graphiques et analytiques de Vertica. Les flux vidéo et audio qui peuvent être tous deux ingérés par IDOL, pourraient être couplés avec les données liées à des événements historiques stockés dans Vertica pour fournir un suivi en temps réel. À titre d'exemple, une banque pourrait suivre une conversation téléphonique avec un client qui demande un crédit et certains mots clefs analysés par Autonomy pourraient déclencher une alerte dans Vertica. Si lors de cette conversation, l'appelant laisse échapper quelque chose qui pourrait indiquer un risque élevé, la société de crédit pourrait être immédiatement alertée par la fonction d'analyse de Vertica, nous a expliqué un responsable de HP.

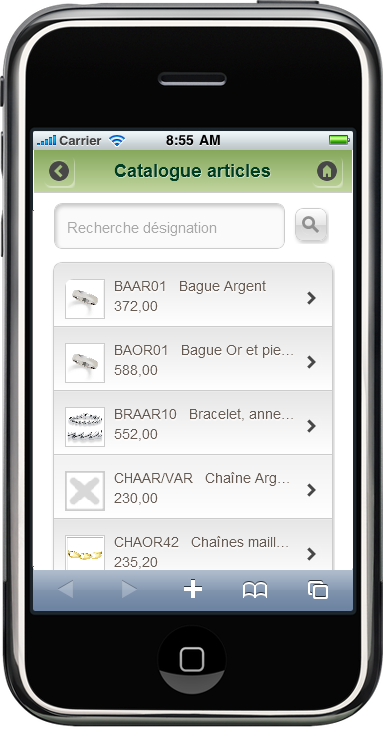

Les gammes Sage 30 et 100 s'affichent sous iOS et Android

Sage veut gagner des utilisateurs au-delà de sa sphère habituelle. Dans les PME de 5 à 200 salariés, où ses gammes Sage 100 et Sage 30 ont pris leurs aises au fil des ans, l'éditeur compte en moyenne 12% d'utilisateurs, ratio classique pour une solution de gestion qui cible les fonctions comptables, commerciales et logistiques et les ressources humaines.

Avec la Génération i7 qu'il lance cette semaine, Sage vise plus large. Il propose de paramétrer des interfaces simplifiées pour des utilisateurs plus occasionnels qui accéderont uniquement aux outils et données qui leur sont utiles. Ce peut être l'annuaire des clients ou des fournisseurs, par exemple, pour retrouver une adresse, ou encore une interface de saisie de commande.

L'objectif est de rendre l'usage du logiciel aussi simple que celui d'un site de e-commerce. Cette amélioration, apportée par l'arrivée de la technologie SET sur Sage 30 et 100, permet à l'ensemble des utilisateurs d'accéder aux logiciels à partir d'une connexion web. Et de travailler ainsi à distance si nécessaire.

cliquer pour agrandir l'image

cliquer pour agrandir l'image

L'accès aux données (catalogue produits, commandes passées, etc.) peut aussi se faire depuis un terminal mobile fonctionnant sous iOS (iPhone, iPad) ou sous Android.

Objectif : 400 000 utilisateurs d'ici 12 à 18 mois

Actuellement, Sage dénombre environ 210 000 utilisateurs de ses gammes 30 et 100 (une même base de produit déclinée suivant la profondeur fonctionnelle requise par les clients et la taille de l'entreprise). En simplifiant l'accès à cette offre, il espère passer à 400 000 utilisateurs d'ici 12 à 18 mois. A terme, il a l'ambition d'en atteindre 600 000, « compte tenu des observations faites sur d'autres marchés », souligne Hémeric de Saint-Chamas, directeur général de la division PME de Sage.

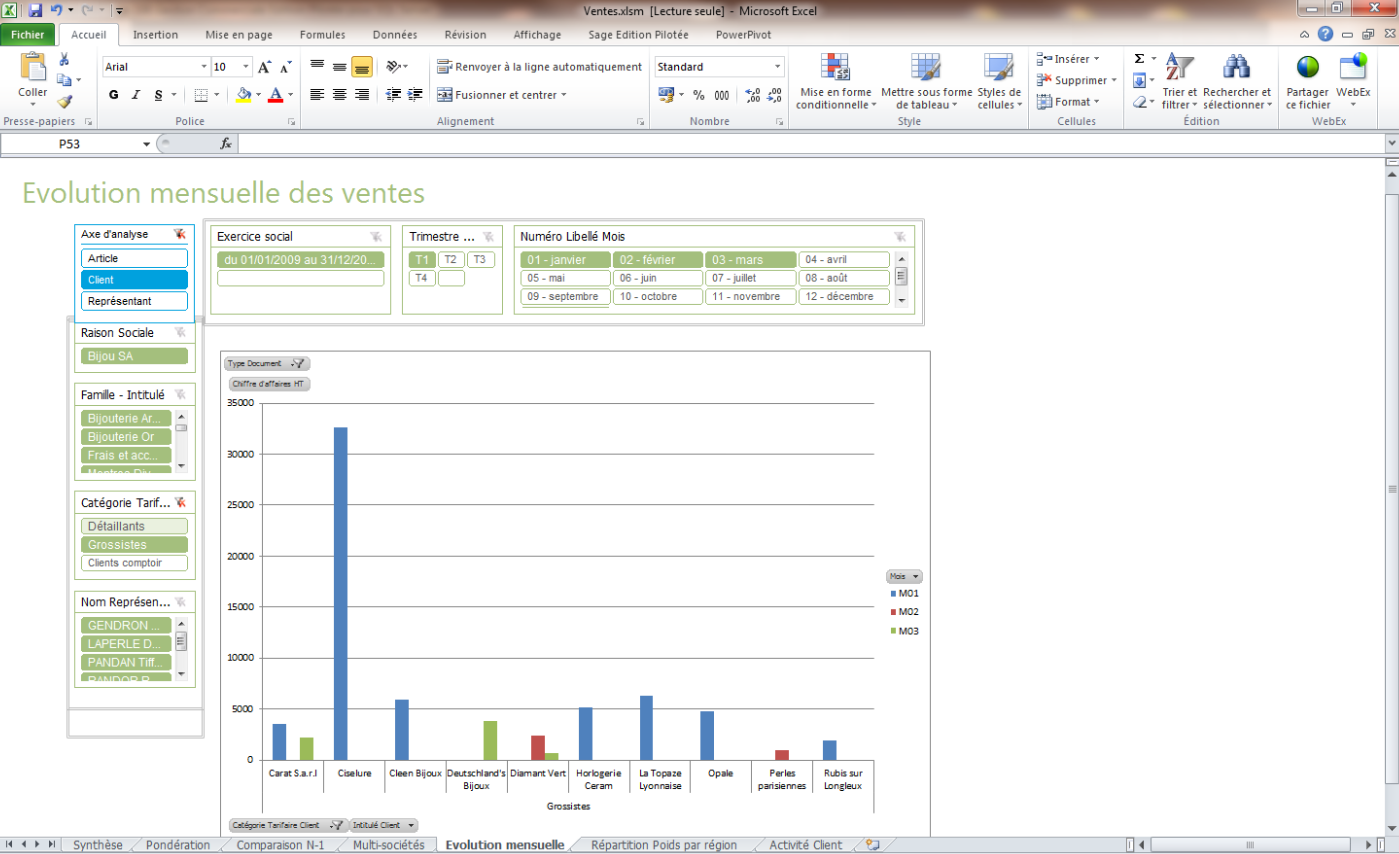

Ces deux gammes fonctionnent sur base de données propriétaire Sage, sur SQL Server ou sur SQL Express. L'utilisation d'une base Microsoft permet de disposer des « états pilotés » qui fournissent à l'entreprise les indicateurs clés de son activité, à des fins décisionnelles. Avec la Génération i7, ces états peuvent être récupérés à partir du tableur Excel, ce qui autorise les utilisateurs à les modifier (cf écran ci-dessous).

Production et Gestion des affaires

Pour les utilisateurs métiers, les versions i7 s'enrichissent de deux offres complètes. D'une part, la gestion de production acquise par Sage avec le rachat d'Alcior, désormais intégrée à la gamme avec les technologies .Net. D'autre part, un module de gestion des affaires adapté aux besoins des sociétés de services. L'éditeur propose par ailleurs en standard quatre profils métiers présentant des interfaces utilisateurs type pour les fonctions de la vente, des achats, de la logistique et de la comptabilité.

Les clients existants pourront accéder aux versions i7 à partir de 500 euros HT. En complément, il existe un service de migration effectué à distance par Sage ou l'un de ses partenaires, pour environ 800 euros HT. Pour les nouveaux clients, le prix d'une licence Sage 100 Comptabilité est fixé à 1 400 euros HT et celui de la licence Sage 100 Gestion Commerciale à 2 400 euros HT.

Prêt pour l'entreprise, Hadoop stimule la demande de compétences

Sur la conférence Hadoop World, qui s'est tenue à New York au début de ce mois, les analystes et responsables IT présents ont à plusieurs reprises souligné que l'accès à des compétences spécialisées constituerait l'une des principales difficultés des entreprises souhaitant opter pour Hadoop. Et celles qui disposeront des bonnes compétences bénéficieront d'un sérieux avantage sur les autres.

Parmi les conférenciers présents à New York, les responsables IT de la banque JP Morgan Chase et du groupe d'enchères en ligne eBay, ont profité de l'occasion pour indiquer à leur auditoire qu'ils recrutaient dans ce domaine, ont rapporté nos confrères de Computerworld. Hugh Williams, vice-président, responsable des plateformes chez eBay, a précisé que sa société recherchait des professionnels d'Hadoop et invité ceux qui étaient intéressés à s'adresser à lui. Un peu plus tard, c'est Larry Feinsmith, directeur général pour les opérations IT chez JP Morgan Chase, qui a surenchéri et proposé, en semblant ne plaisanter qu'à moitié, de payer 10% de plus qu'eBay.

« Hadoop, c'est le nouveau datawarehouse, la nouvelle source de données » au sein de l'entreprise, décrit James Kobielus, analyste de Forrester Research. On s'intéresse beaucoup aux personnes qui en savent suffisamment sur les rouages d'Hadoop pour aider les entreprises à en tirer avantage », explique-t-il.

Des compétences en datamining et en modélisation prédictive

Le framework Open Source Hadoop aide à collecter et stocker d'importants volumes de données structurées et non structurées. Les entreprises ont commencé à s'en servir de façon croissante pour analyser les petaoctets de données telles que les connexions web, clics et contenus multimédias, afin d'obtenir davantage d'informations sur leurs activités et leurs clients. Cette adoption entraîne la demande de compétences nécessaires aux analyses avancées, ajoute James Kobielus. Cela inclut les personnes ayant des connaissances en matière d'analyse statistique, de datamining, de modélisation prédictive, de traitement en langage naturel, d'analyse de contenus, de textes et de réseaux sociaux, explique-t-il.

« Les Big Data, dans leur sens large, et Hadoop en particulier, génèrent de la demande pour des gens expérimentés utilisant de nouvelles approches telles que MapReduce et le langage R, pour la modélisation statistique et prédictive », poursuit-il. « Il s'agit de personnes spécialisées dans l'analyse de données ou de scientifiques qui travailleront dans les environnements Hadoop pour pénétrer plus avant dans les données et leur donner un nouveau sens ».

Des administrateurs de clusters Hadoop

L'intérêt suscité par Hadoop est aussi en train de créer une demande pour des professionnels de cette plateforme, ajoute James Kobielus. Leur rôle consistera à mettre en oeuvre des clusters Hadoop, à les sécuriser, les gérer, les optimiser et faire en sorte que le cluster reste disponible pour l'entreprise. Selon l'analyste de Forrester Research, les administrateurs de base de données qui interviennent sur Teradata ou sur l'appliance Exadata d'Oracle sont les mêmes profils qui commencent maintenant à redéfinir leurs rôles comme administrateurs de clusters Hadoop. C'est un nouveau monde qui s'ouvre, estime-t-il en ajoutant qu'on s'attend aussi à voir une demande pour les professions de la gestion de stockage et pour celles permettant d'intégrer les environnements Hadoop avec les technologies existantes de bases de données relationnelles.

(Crédit illustration : D.R.)

[[page]]

Martin Hall, PDG de Karmasphere, fournisseur de logiciels pour les environnements Hadoop, confirme que trois catégories de professionnels sont concernées. Les professionnels de la gestion de données seront ceux qui choisiront, installeront, géreront et feront évoluer et monter en puissance les clusters Hadoop. Ce sont eux qui décideront si l'infrastructure Hadoop doit se situer dans le cloud ou sur site, quels fournisseurs il convient de choisir, quelle distribution d'Hadoop retenir. Ils définiront la taille du cluster et s'il doit être utilisé pour exploiter des applications de production ou à des fins de test qualité. Les compétences requises pour ces fonctions sont similaires à celles que l'on demande pour effectuer les mêmes tâches dans des environnements de SGBDR traditionnels ou de datawarehouses, précise Martin Hall.

Des professionnels pour construire des algorithmes MapReduce

La deuxième catégorie de professionnels sera chargée de créer les processus de traitement des données. Ils construiront les algorithmes MapReduce distribués qui seront utilisés par les personnes qui analyseront ensuite les données. Les ingénieurs possédant des compétences en Java et en C++ auront davantage d'opportunités à mesure que les entreprises commenceront à déployer Hadoop, prévoit le PDG de Karmasphere.

La troisième catégorie de professionnels recherchés seront ceux qui disposent d'expérience sur les logiciels d'analyse statistique (SAS, SPSS), ainsi que dans les langages de programmation comme R. Ce sont eux qui généreront, analyseront, partageront et intégreront les informations rassemblées et stockées dans les environnements Hadoop.

Pour l'instant, le manque de compétences autour d'Hadoop signifie que les entreprises ont besoin d'être aidées par les fournisseurs de services pour déployer cette technologie. L'un des indicateurs de cette situation, pointe l'analyste James Kobielus, de Forrester, c'est que les revenus générés autour d'Hadoop par les professionnels du conseil et de l'intégration de systèmes sont bien plus importants que les revenus provenant des ventes des produits Hadoop. Des sociétés telles que Cloudera, MapR, Hortonworks et IBM proposent aux entreprises des formations pour qu'elles puissent elles-mêmes construire leur propre centre d'excellence Hadoop, indique-t-il.

[[page]]

En effet, même s'il subsiste des inquiétudes sur la sécurité et sur d'autres points, Hadoop est prêt à être utilisé en entreprise si l'on se réfère à l'avis de responsables IT qui sont intervenus sur la conférence Hadoop World, à New-York. Ainsi, depuis trois ans, la banque JPMorgan Chase utilise de façon croissante le framework Open Source de stockage et d'analyse de données, a expliqué Larry Feinsmith, le directeur général des opérations IT pour le groupe. La banque continue à s'appuyer fortement sur les systèmes de bases de données relationnelles pour les traitements transactionnels, mais elle utilise la technologie Hadoop pour un nombre croissant d'applications, parmi lesquelles la détection de fraude et la gestion des risques informatiques. Elle gère près de 150 petaoctets de données stockées en ligne, 30 000 bases de données et 3,5 milliards de connexions à des comptes utilisateurs. La capacité d'Hadoop à stocker d'énormes quantités de données non structurées lui permet de collecter les connexions web, les transactions et les informations recueillies sur les médias sociaux. « Nous conservons des données que nous stockions pas auparavant », a pointé Larry Feinsmith. Celles-ci sont agrégées sur une plateforme commune afin d'être explorées, pour mieux comprendre les clients, avec un ensemble d'outils de datamining et d'analyse.

eBay stocke 9 Po de données sur des clusters Hadoop et Teradata

De son côté, le groupe eBay utilise la technologie Hadoop et Hbase, qui supporte l'analyse en temps réel des données, afin de constituer un moteur de recherche pour son site d'enchères en ligne. Hugh Williams, vice-président, responsable plateformes et recherche chez eBay, a expliqué que ce projet de moteur (nom de code Cassini) va remplacer la technologie dont la société s'est servie depuis le début des années 2000. La mise à jour est notamment nécessaire pour prendre en charge les volumes croissants de données. eBay rassemble plus de 97 millions d'acheteurs et de vendeurs actifs et plus de 200 millions d'articles en vente dans 50 000 catégories. Il gère 2 milliards de pages vues, 250 millions de requêtes et 10 millions d'appels à des bases de données chaque jour, a indiqué Hugh Williams. Le groupe stocke 9 petaoctets de données sur des clusters Hadoop et Teradata, un volume qui grossit vite, a ajouté le responsable plateforme et recherche. Il précise que 100 ingénieurs d'eBay travaillent sur le projet Cassini, ce qui en fait l'un des plus gros efforts de développement de la société.

Le moteur, prévu pour entrer en fonction l'an prochain, devra répondre aux requêtes des utilisateurs en fournissant des résultats contextuels et plus affinés que ceux que propose l'actuel système, promet Hugh Williams.

Larry Feinsmith, de JP Morgan Chase, met en garde les départements informatiques qui seraient intéressés par Hadoop. Ils doivent être vigilants sur les questions de sécurité. Il explique que l'agrégation et le stockage des données provenant de sources multiples peut créer de nombreux problèmes liés au contrôle d'accès et à la gestion des données, tout en faisant remonter des questions liées à la possession des données.

L'AEFE optimise le reporting de ses données avec Talend et Actuate

L'agence pour l'enseignement français à l'étranger (AEFE) gère 480 écoles, collèges et lycées établis hors de France, dans 130 pays, qui proposent un enseignement conforme à l'exigence des programmes de l'Éducation nationale française. Ces établissements, de la maternelle aux classes préparatoires, accueillent 300 000 élèves, dont 110 000 enfants d'expatriés français et 190 000 nationaux et étrangers tiers désirant bénéficier d'un enseignement du type de celui des écoles françaises. L'AEFE fonctionne avec 6 400 titulaires de l'Éducation nationale et 15 000 collaborateurs recrutés localement mais est rattachée au Ministère des Affaires Etrangères.

Les gestionnaires de l'agence utilisaient, pour le pilotage et les rapports, Microsoft Excel pour traiter des extractions brutes à partir des systèmes informatiques de production. De fait, les équipes informatiques étaient donc sollicitées pour effectuer régulièrement de telles requêtes, chaque décideur ayant ses propres exigences. Afin de développer l'autonomie des 100 à 150 décideurs concernés et, partant, leur réactivité, l'AEFE a décidé de déployer un véritable système décisionnel.

Une optimisation des reportings

Talend extrait les données de six systèmes : le SIRH, la paye du siège (système distinct du SIRH), la gestion des bourses scolaires, la comptabilité et le budget et la gestion de la formation continue. Les données sont stockées dans un infocentre puis un datawarehouse sous PostgreSQL. Enfin, les solutions d'Actuate sont sollicitées pour créer un cube, des cubeviews, des rapports, des générations de feuilles Excel (certains utilisateurs souhaitant conserver un traitement de ce type) et enfin un tableau de bord synthétique.

« Bien qu'il y ait peu d'indicateurs et une faible volumétrie, nous devions faire de très nombreux croisements de données et nous avions besoin de fluidité et de réactivité » souligne Maryam Khiali, chef de projet maitrise d'oeuvre pour le système d'information décisionnel (SID) de l'AEFE. Avec la solution implémentée, les utilisateurs peuvent aisément fabriquer des rapports à partir des cubeviews, la navigation au sein des données disponibles empruntant une logique d'explorateur de fichiers.

Le projet a été mené à partir de janvier 2011. Il a notamment permis à la directrice de l'AEFE de disposer d'un rapport avec les chiffres dont elle avait besoin pour une audition au Sénat en moins d'une demi-heure contre de nombreuses heures auparavant.

Sapphire Madrid : SAP pointe les gains obtenus avec HANA

Simplifier le paysage IT figure parmi les ambitions qu'affiche SAP avec son appliance HANA (High-performance analytic appliance). Vishal Sikka, directeur technique de la société, l'a redit sur les conférences européennes Sapphire et TechEd, à Madrid, la semaine dernière. La technologie d'analyse in-memory mise à l'oeuvre dans HANA traite en temps réel d'énormes volumes d'informations, issues de bases décisionnelles ou transactionnelles, sans pré-agrégation des données. A la clé, une capacité à explorer davantage de données, avec une interactivité accrue, dans des délais plus courts.

Dans les cas les plus notables, les améliorations sont surprenantes. « Des résultats obtenus en 4 à 8 secondes contre 18 heures auparavant », expose par exemple Vishal Sikka, même s'il reconnaît que l'accélération ne sera pas aussi spectaculaire avec toutes les applications. Le directeur technique affirme que de nombreux clients HANA ont déjà multiplié par un facteur 1 000 la rapidité de leurs analyses. Et certains ont obtenu leurs réponses 10 000 fois plus vite. Dans ce club des « 10K », on trouve la multinationale indienne Essar (acier, énergie, communications...), le Chinois Nongfu Spring (fournisseur de boissons), l'Américain The Charmer Sunbelt (vins et spiritueux), l'Université Cornell, située dans l'Etat de New York, et SAP lui-même.

Deux secondes contre trois jours

Un seul client fait mieux : le Japonais Yodobashi, distributeur de produits électroniques. C'est l'unique membre du club 100K pour l'instant. Il utilise HANA pour calculer les avantages gagnés par les 5 millions de clients engagés dans son programme de fidélité. « Et cela va 129 000 fois plus vite qu'avant », assène Vishal Sikka, puisque deux secondes suffisent maintenant à Yodobashi pour le faire, contre trois jours auparavant. Ce qui permet de calculer les avantages acquis lorsque le client est encore dans le magasin. « The Charmer Sunbelt devrait bientôt rejoindre ce club des 100K », pressent le directeur technique.

Vishal Sikka suggère à chacun de tester à son tour les performances d'HANA. « Vérifiez les choses par vous-mêmes, jouez avec la sandbox », invite-t-il. SAP a ouvert un site pour consulter des démonstrations en direct : « Experiencesaphana.com ». Deux scénarios y sont proposés. Le premier propulse au coeur d'un conglomérat de plusieurs milliards de dollars dont on explore les données opérationnelles à l'aide de CO-PA (Profitability Analysis) Accelerator. Le deuxième scénario simule les énormes volumes d'informations générés dans les circuits de distribution de la mode. Il faut s'enregistrer pour les consulter.

Red Bull a installé Business Warehouse sur HANA

A Madrid, SAP a annoncé que HANA pouvait remplacer la base de données sur laquelle s'appuie son datawarehouse BW. Pour démontrer les bénéfices de cette solution, l'éditeur a donné la parole à Red Bull, dont les deux représentants ont déboulé sur la scène de Sapphire en combinaison de pilote de Formule 1 (le producteur de boissons énergisantes possède l'écurie de course avec le champion du monde Sebastian Vettel). En moins de deux semaines, ces utilisateurs de BW ont installé HANA et compressé leur base de données à 80%, passant de 1,5 teraoctet à moins de 300 Go. Parmi les avantages, plus de réplication vers des infocubes et le responsable des applications d'entreprise de Red Bull, Christian Stoxreiter, explique que le processus de reporting a été dopé de bout en bout, surtout par la réduction du temps de chargement des données. Ces dernières sont récupérées pendant la nuit sur différentes zones horaires (Red Bull est présent dans 160 pays). L'année prochaine, la société prévoit d'étendre l'application à la gestion des promotions et à la planification.

SAP fournit HANA sous la forme d'une appliance logicielle. Pour la partie matérielle (serveurs et stockage virtualisé), il s'appuie sur une dizaine de partenaires : IBM, HP, Dell, Fujitsu, Cisco, Lenovo, EMC/VMware et Hitachi. Dernier arrivé de la liste, ce dernier combine ses offres Adaptable Modular Storage 2000 et Compute Blade 2000 avec HANA. De son côté, EMC va associer HANA à ses technologies de stockage multi tiers (FAST) et l'appliance pourra s'installer dans des baies VMAX.

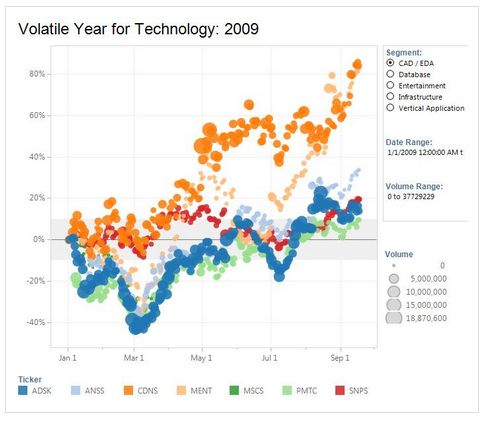

Analyse de données : Tableau Software pousse ses pions en France

L'éditeur américain Tableau Software propage ses solutions décisionnelles sur le marché européen. A la tête de sa filiale européenne depuis décembre 2010, Bruno Saint-Cast, vice-président EMEA, indique que le chiffre d'affaires sur cette région a égalé au premier trimestre 2011 l'activité réalisée sur l'ensemble de l'Europe l'année précédente. La déclinaison française de l'offre, lancée fin juin, a été très bien accueillie sur l'Hexagone où les ventes du dernier trimestre sont équivalentes à celles des douze mois précédents. Créée en 2004 et installée à Seattle, Tableau Software est une société privée dirigée par Christian Chabot, co-fondateur avec Chris Stolte et Pat Hanrahan, responsables du développement. Elle compte 350 collaborateurs dans le monde et 6 500 clients dont une centaine en France, parmi lesquels BNP Paribas, Areva, Thalès, SNCF, GDF, EDF, Orange, Ipsos, le CEA ou encore, Sanofi. L'éditeur s'est déjà entouré d'intégrateurs bien implantés sur ce marché comme Sopra, Micropole, Keyrus (partenaire historique), ou encore Mydral, qui compte parmi les plus actifs, et sous peu, Business & Decision.

Visualisation interactive avec VizQL

L'analyse des données se fait en mémoire ou en connexion avec la base. On peut combiner plusieurs sources en une seule vue. L'éditeur utilise la technologie VizQL pour visualiser les données sur un mode interactif. Parmi les acteurs de la Business Intelligence (BI) qui mettent l'accent sur la facilité d'exploration des données (outils de Data discovery), Tableau Software est placé par Gartner aux côtés d'acteurs comme QlikTech et Tibco/Spotfire, notamment. Le cabinet d'études insiste sur les fonctionnalités de visualisation interactive de l'offre, mises au service de l'analyse, des tableaux de bord, de la diffusion d'information et des applications analytiques.

La technologie de visualisation interactive VizQL, issue de l'Université de Stanford.

Selon les enquêtes menées par Gartner auprès des utilisateurs de Tableau, la facilité d'usage du logiciel est souvent mise en avant, de même qu'un coût de mise en oeuvre intéressant et un déploiement aisé sans assistance des ressources IT. En revanche, Gartner pointe des capacités moins développées sur le reporting de production, l'analyse prédictive ou les meta-données (couche sémantique).

Renforcer le poids de l'Europe dans les revenus

Début janvier 2011, la société a communiqué un chiffre d'affaires proche de 40 millions de dollars, en progression de 106% sur un an. Pour l'instant, l'Europe ne pèse encore que 10% des revenus globaux de l'éditeur. L'objectif est de faire progresser sensiblement cette part pour la porter à 20 ou 25% d'ici un à deux ans, projette Bruno Saint-Cast. « Nous remportons deux à cinq affaires par semaine en Europe en ce moment », précise le responsable du marché EMEA(*). De ce côté-ci de l'Atlantique, l'éditeur se retrouve souvent face à l'offre QlikView et dit ne pas perdre d'affaires contre des tenants du marché BI. Bruno Saint-Cast évoque pour l'expliquer un rythme de nouveautés plus élevé chez Tableau Software que chez certains concurrents, une mise en oeuvre plus simple et une plus grande autonomie de l'utilisateur final. Quant aux applications, elles sont « d'une variété inouie », souligne-t-il. De la comptabilité analytique à la GRH, en passant par la gestion de la qualité, les analyses de marché, le support aux ventes, les tableaux de bord de performances... Aux Etats-Unis, la solution BI est utilisée pour analyser les trajets des ouragans, la criminalité (à Seattle) ou les micro-crédits.

Avec la version Tableau Desktop du logiciel (environ 1 500 euros), l'utilisateur non-informaticien accède à ses données en quelques instants, pointe le responsable EMEA. La version Serveur permet de partager les tableaux de bord en mode web (à partir de 7 500 euros pour dix utilisateurs nommés minimum). Ces produits peuvent être testés gratuitement pendant quinze jours. La tarification comprend la maintenance de la première année, fixée ensuite à 25%.

(*) Bruno Saint-Cast fut précédemment DG de Salesforce.com France et vice-président EMEA de Brio Technology.

Crédit illustration : Tableau Software

Trimestriels : SAP France dit gagner des parts de marché

SAP France est en forme. Ses ventes de licences ont progressé de 63% au troisième trimestre, partie Sybase non incluse, a indiqué hier Nicolas Sekkaki, son directeur général, sans toutefois fournir de chiffre d'affaires. En englobant les revenus de la maintenance, la progression de SAP France est ramenée à 15% sur le trimestre (+16% au niveau mondial, Sybase inclus). L'an dernier, à même époque, la filiale française venait de retrouver la croissance, après la crise de 2008. Cette fois-ci, elle a réalisé le meilleur troisième trimestre de son histoire, en termes de chiffre d'affaires, souligne le dirigeant. Il rappelle les orientations prises pour y parvenir : être plus proche des clients, avoir une meilleure segmentation, déployer les écosystèmes et investir sur les métiers.

« Nous savons que nous gagnons des parts de marché, nous avons remporté de nombreux affaires sur nos concurrents », a-t-il affirmé hier. Les ventes réalisées sur de nouveaux clients ont augmenté de 39% sur le trimestre, ce qui permet à la filiale d'envisager de nouvelles perspectives de croissance. Par ailleurs, si SAP et Sybase conservent un fonctionnement indépendant, les deux sociétés unissent leurs forces de vente sur certains secteurs, en particulier dans la banque, où Sybase est très présent avec Business Objects.

Sur les trois mois écoulés, deux contrats ont dépassé les 5 millions d'euros de chiffre d'affaires pour SAP France et quatre ont été supérieurs à un million d'euros. Deux d'entre eux ont porté sur des systèmes de gestion des ressources humaines (RH), notamment sur des solutions de gestion des talents. Parmi les gros contrats remportés ce trimestre figurent des noms tels que La Banque de France, Natexis, Lactalys, Atos, Total ou Vinci Autoroutes.

La filiale annonce aussi une bonne performance sur son volume d'affaires en général, dans les différents domaines applicatifs. Au nombre des nouveaux clients, on trouve Radio France (qui a acquis des solutions d'EPM, gestion de la performance de l'entreprise), le Conseil général de la Nièvre (sur la BI), le cimentier Vicat et le groupe agro-industriel Soufflet (sur l'ERP) ou encore Monoprix (sur la gestion de patrimoine immobilier).

36 clients Business ByDesign en France

Business ByDesign, l'offre hébergée pour PME, compte maintenant 36 clients en France (maj*). Dans le monde, l'éditeur en dénombre 650 et vise le millier pour la fin de l'année. SAP s'emploie depuis plusieurs mois à renforcer son réseau de partenaires pour revendre cette offre de gestion intégrée en mode SaaS. La filiale française annonce avoir signé la plus grosse affaire en indirect au niveau mondial sur Business ByDesign (màj). Dans un autre domaine, Nicolas Sekkaki signale aussi que le premier client pour l'offre Disclosure Management (validation de la clôture des comptes) a été signé en France.

* (mise à jour : il y a un an, la filiale française comptait moins d'une dizaine de clients en production)

[[page]]

Pour ce troisième trimestre, le directeur général communique des progressions à trois chiffres sur les ventes de licences pour certains secteurs d'activité : le manufacturing et les services. Côté produits, sur les solutions entourant l'ERP (gestion logistique, relation client, RH...), SAP France dit récolter les fruits des recrutements réalisés pour étoffer ses équipes. « Nous n'avions pas les ressources pour amener les produits sur le marché, reconnaît Nicolas Sekkaki. Nous avons embauché massivement dans ces lignes de métiers ». La société enregistre ainsi des progressions très fortes sur les solutions RH (de gros contrats signés, cf plus haut), ainsi que sur le CRM. Le directeur général pointe l'intérêt de proposer aux forces de vente des entreprises des solutions mobiles qui puissent relier à leurs outils spécifiques les fonctions décisionnelles tout en accédant au back-office et à la gestion logistique.

La croissance repart sur le décisionnel

Sur les solutions analytiques, la filiale française « a renoué avec la croissance ». Elle affiche une progression de 38%, davantage tirée par l'intégration de données (+54% sur l'EIM) et les outils de pilotage (+40% sur l'EPM et +86% sur la gestion des risques) que sur la BI proprement dite (+26%).

Nicolas Sekkaki met aussi l'accent sur les comptes stratégiques de SAP (dont le chiffre d'affaires a progressé de 48%) et sur l'avancée réalisée dans les régions (en croissance de 60%). « Avec plus d'un million d'euros d'affaires signé en province depuis deux trimestres », pointe le dirigeant. La filiale a aussi soutenu le mode indirect sur les grands comptes (+73% depuis le début de l'année), ce qui permet aux partenaires d'améliorer leur taille critique. Accenture a inauguré avec SAP un centre d'innovation sur la partie temps réel et Capgemini s'est investi sur les solutions de mobilité.

Mieux armé qu'en 2008 pour affronter la crise

Sur l'exercice fiscal 2011, SAP France s'estime en avance sur son plan de marche, même si tout se joue sur le quatrième trimestre. Et pour 2012, il pense que la société est mieux armée qu'elle ne l'était en 2008 pour faire face à la crise. Il y a trois ans, « nous étions monoproduit et nous venions d'acquérir Business Objects. Depuis, nous avons bien consolidé la base décisionnelle qui représente une part significative de notre activité. Nous avons désormais la partie Sybase et une roadmap claire sur notre agenda produits que nous trouvons très innovant car nos solutions répondent aux besoins des clients en temps de crise en permettant un pilotage plus fin de l'entreprise ».

La semaine prochaine se tient à Madrid la conférence Sapphire de l'éditeur dont les thématiques porteront sur l'innovation, a indiqué Nicolas Sekkaki. Trois mille clients et partenaires y sont attendus. Il y sera question de mobilité, de Big Data et de temps réel. Depuis un an et demi, SAP porte une grande partie de ses efforts de R&D sur HANA (high performance analytics appliance), sa solution d'analyse des données en mémoire et en temps réel qui établit une convergence entre les données transactionnelles et le décisionnel. En France, Casino l'a adoptée et d'autres contrats devraient se clore au 4e trimestre.

« Pratiquement tous les développements que nous sommes en train de réaliser se font sur une base HANA », a souligné le directeur général France en rappelant que SAP proposait ici une rupture technologique qui n'impliquait pas un changement de système d'information. « HANA pourra s'intégrer quelle que soit la version de l'ERP utilisé par le client. Il n'y aura donc pas de coût rédhibitoire pour accéder à l'innovation » et aux gains de productivité induits. Il donne notamment en exemple, la possibilité pour une entreprise de refaire son budget quasiment en temps réel, si l'évolution de son activité le requiert.

| < Les 10 documents précédents | Les 10 documents suivants > |