Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 601 à 610.

| < Les 10 documents précédents | Les 10 documents suivants > |

(02/03/2011 14:45:36)

IBM affine ses outils pour automatiser et accélérer la virtualisation

Dennis Quan, directeur du laboratoire de développement Tivoli Chine d'IBM, est resté assez vague sur la manière dont le logiciel pouvait atteindre ces vitesses de déploiement de VM, indiquant simplement qu'il utilisait un certain nombre de techniques, dont le streaming de l'image. Selon lui, « le logiciel permettrait d'améliorer les performances dans des entreprises où les personnels des services informatiques doivent consacrer plusieurs minutes, voire même une heure, à installer une seule machine virtuelle. » Et ce se serait pas son seul avantage. Une des raisons pour laquelle les entreprises déplacent leurs activités vers le cloud, c'est pour n'utiliser que les ressources informatiques dont elles ont besoin. « Cette idée suppose également que, quand ces ressources ne leur sont plus nécessaires, elles peuvent les restituer au cloud et les rendre disponibles à d'autres utilisateurs, » ajoute Dennis Quan. Or, certains rechignent à se séparer de ces ressources, même si elles ne sont plus utiles. En particulier, à cause du temps qu'il leur faudra consacrer à nouveau pour les remettre en place. « Si vous offrez aux utilisateurs la possibilité de retrouver leurs ressources en quelques secondes, voire quelques minutes, ils ne vont plus se demander combien de temps il leur faudra pour les récupérer rapidement et ils accepteront de s'en défaire au moment voulu, » a déclaré le directeur du laboratoire de Big Blue. « Le logiciel permettra également aux entreprises d'agir plus rapidement, pour effectuer des modifications, par exemple, » a-t-il ajouté.

IBM a également annoncé que Tivoli Provisioning Manager prenait désormais en charge la fédération d'image et le déploiement sous infrastructure hétérogène. « Cet outil apporte un système de gestion unique pour différents hyperviseurs » a déclaré Dennis Quan. « Une entreprise peut utiliser VMware, PowerVM et des hyperviseurs Xen et les gérer depuis la même console, » explique-t-il. IBM annonce également le lancement « imminent » de la version bêta d'un nouveau logiciel qui étend les capacités de gestion aux clouds hybrides. « Les utilisateurs pourront surveiller et diriger des services hébergés en interne ou sur des clouds publics. Ces modalités sont très adaptées aux services financiers et aux organismes publics qui préfèrent conserver les données importantes dans leurs systèmes internes et acceptent de mettre des applications moins sensibles dans un cloud public, » déclare encore le responsable de Tivoli Chine. Ce dernier n'a pas communiqué la liste des clouds publics qui seraient supportés, mais a affirmé que le logiciel serait en mesure d'être relié à de nombreux services. Celui-ci compte affiner cette liste avec le déploiement de la version bêta. IBM annonce également que Tivoli Storage Manager, son logiciel de gestion des besoins de stockage, de récupération et de protection des données, prend désormais en charge la virtualisation. « Celui-ci offre un meilleur contrôle sur l'environnement et applique une politique plus uniforme, » explique encore Dennis Quan.

Ces nouvelles fonctionnalités et produits seront probablement bien accueillis par les directeurs financiers, mais pas forcément par les services informatiques. « L'automatisation de la gestion et la réduction du temps d'approvisionnement font que les services informatiques auront besoin de moins d'administrateurs, » estime le responsable d'IBM. « Dans un environnement informatique, c'est la ressource humaine qui coûte le plus cher, » ajoute-t-il. « Avec des milliers de machines virtuelles, chaque minute de l'activité humaine requise par chacune d'elle fait grimper la facture. Plus ce secteur sera automatisé, et plus une entreprise pourra réaliser avec le cloud des retours sur investissement. »

Illustration principale : Denis Quan, crédit photo H. Parkey-Coney/IBM

Cebit 2011 : les yeux de Chimène pour l'ouverture, le cloud et les tablettes

A la soirée d'inauguration du Cebit 2011, Angela Merkel, Chancelière allemande recevait à l'occasion de la manifestation sur les nouvelles technologies, la Turquie avec la présence de Recep Teyyip Erdogan, Premier Ministre Turc. Ce dernier a vanté les mérites de son pays en matière de nouvelles technologies et des efforts qu'il reste à faire en matière d'éducation et de déploiement de l'Internet, mais il a insisté aussi sur la nécessité que la Turquie rentre dans l'Union européenne. Il a par exemple souligné les freins que constitue le besoin de visa pour les entrepreneurs turcs qui se rendent en Allemagne. Angela Merkel lui a proposé avec humour d'intégrer une puce dans les passeports pour améliorer les choses. Celle-ci a insisté sur l'importance des technologies dans les mouvements de protestations dans les pays arabes. Elle a aussi parlé en fin de discours du cloud computing en soulignant le potentiel de croissance que cela représente, tout en appelant les acteurs de ce marché à le rendre sur et facile d'accès. Le PDG d'IBM Sam Palmisano a dans son intervention rappelé l'importance d'avoir des standards ouverts pour apporter des réponses aux interrogations sur la sécurité. « De nombreux citoyens se sont interrogés sur qui détient toutes les données, qu'en font ils et peut-on avoir confiance en eux ? » précise le dirigeant.

Un cloud encore éparpillé dans le salon

Du discours à la réalité il n'y a qu'un pas que l'on franchi dès le hall 2 du Cebit. Le stand IBM où Angela Merkel s'est vue remettre un processeur Power PC d'IBM et a remercié... Intel pour l'occasion, montrait les bénéfices du cloud en affichant les différentes solutions hardware et software. D'autres halls intégraient à des degrés divers le cloud computing. Un espace dédié aux datacenters était visible montrant principalement le savoir faire en matière de réduction de consommation énergétique. Emerson avait installé un camion de démonstration devant le hall et semblait un peu isolé. Difficile par contre de trouver de réelles annonces, le Cebit n'étant pas un salon où les constructeurs et les éditeurs dévoilent des produits à destination des professionnels de l'IT. Ainsi, en matière de sécurité, le cloud n'est pas encore sur les lèvres des exposants qui disposent d'un hall pour eux. L'évangélisation sur la lutte contre le spam et les antvirus auprès du grand public restent un discours important. Et c'est peut-être un des enseignements du salon, si le cloud va bénéficier aux entreprises, les acteurs de l'IT doivent rester en veille sur les besoins du grand public, qui sont les vecteurs de la vague actuelle de « consumérisation de l'IT ».

Les tablettes fleurissent

MSI, Asus, TazTag ont présenté plusieurs tablettes lors du salon. 7'', 9'', 10'', Android, Windows 7, NFC, etc. toutes les technologies et les formats de tablettes sont présentes. L'offensive contre l'iPad est bien entamée surtout à quelques heures de la présentation de l'évolution de la tablette d'Apple. Les fabricants asiatiques présents sur les stands chinois montrent une variété impressionnante d'ardoises. Une course de vitesse s'est engagée pour répliquer, dupliquer et apporter une réponse au « time to market » des constructeurs. Cette accélération entraîne quelque fois des inattentions comme sur ce stand où Android est devenu Andriod. Devant cette hégémonie médiatique, les présentations de terminaux mobiles, de PC ou de périphériques sont passées plutôt inaperçues. Au final ce cru 2011 du CEBIT aura surfé sur la vague des deux tendances de l'année, le cloud et les tablettes.

Cebit 2011 : Software AG devient cloud ready

Karl Heinz Streibich, le PDG de Software AG (1 milliard d'euros de chiffre d'affaires désormais), estime que « la transformation vers une véritable entreprise numérique est le prochain défi de la décennie. Rendre les process plus flexibles, plus agiles et les intégrer au sein des différentes activités de l'entreprise sont l'ambition de nos solutions entreprises de BPM ». Le cloud va donc faire évoluer l'entreprise vers ce que le dirigeant nomme « l'extreme collaboration », c'est-à-dire la fin du dialogue en mode silo entre le monde applicatif et l'univers du marché (client, produits, etc...). Pour établir ce lien, Software AG dispose de deux outils, ARIS et WebMethod, qui se chargent, d'un coté, de gérer et de modéliser les processus de gestion et, de l'autre, d'appliquer les meilleures méthodes d'intégration ainsi que leur contrôle. Pour devenir cloud ready, l'éditeur allemand a travaillé sur une meilleure coordination entre les deux solutions en implémentant deux nouveaux composants. Le premier est CEP (Complex Event Processing) issu de l'acquisition de la société allemande RealTime Monitoring au début de 2010. Il effectue des requêtes sur des flux continus d'événements, une approche qui fournit des résultats suivis et redondants. Cette méthode permettra aux entreprises, via l'outil MashZone du logiciel ARIS, de visualiser les événements d'entreprise en temps réel. Par ailleurs, le second composant est l'intégration des outils de MDM (Master Data Management), issus du rachat de Data Foundation en octobre dernier, au sein de webMethods OneData.

Montée en puissance progressive

Le potentiel du cloud est très important selon le dirigeant de Software AG qui envisage de réaliser des grosses acquisitions toutes les deux ou quatre ans et pas uniquement en Allemagne. Cette démarche est poussée par le fait que seuls 25% des processus métiers des entreprises sont numérisés. Devant l'intérêt de certaines entreprises pour le cloud public, l'éditeur allemand a décidé de rendre compatible sa couche logicielle avec la plate-forme EC2 d'Amazon. Le cloud privé n'est pas oublié avec un support pour VMware. La majorité des annonces seront disponibles au troisième trimestre 2011. Un ensemble de service de conseil « cloud ready » sera aussi proposé aux clients lors du lancement officiel des solutions. Ces services comprendront « préparation avancée, la formulation de stratégies, la numérisation et l'analyse des processus pour les besoins du cloud ». Aucun prix n'a été communiqué sur les différentes solutions annoncées.

Illustration principale : ARIS MashZone (...)

256 puces Atom double coeur dans un serveur SeaMicro

Après un premier ballon d'essai en juin dernier, SeaMicro semble bien décidée à poursuivre son effort avec le SM10000-64. Ce serveur dispose de 256 puces Atom N570 cadencées à 1,66 GHz (soit 512 coeurs au total), qui se combinent pour offrir une puissance de traitement de 850 GHz, a indiqué la compagnie. Chaque noyau est capable de fonctionner avec deux threads simultanément, ce qui contribue à stimuler les performances des applications. Les processeurs Intel Atom de faible puissance sont généralement utilisés dans les netbooks. Mais ces puces sont considérées comme plus économes en énergie que les processeurs traditionnels pour serveur et conviennent plutôt bien pour certaines tâches telles que les transactions Web, qui contiennent de petites quantités de données rapidement traitées.

Ce serveur est destiné aux datacenters de nouvelle génération qui prennent en charge des services Internet, tels que la messagerie, la recherche en ligne et le réseautage social, a déclaré Andrew Feldman, CEO de SeaMicro. La société cherche également à convaincre les fournisseurs de solutions d'hébergement et les prestataires de services cloud. En fonction de l'application utilisée, une collection de coeurs Atom pourrait fournir une meilleure performance par watt que des puces Intel Xeon ou AMD Opteron, qui consomment plus d'énergie et sont mieux adaptées aux calculs d'ingénierie, de mathématiques ou aux bases de données, poursuit Andrew Feldman. Par exemple, les moteurs de recherche Internet ne récupèrent pas toutes les données sur une machine géante, précise le CEO. Les informations sont réparties sur plusieurs groupes de petits serveurs qui se regroupent pour réaliser rapidement les opérations demandées. Les serveurs avec des puces de faible puissance utilisent moins de ressources pour l'exécution de ces tâches, explique encore le Californien.

Alléger la consommation des datacenters

«Il y a un mouvement des matériels et des logiciels « lourds» vers des solutions plus légères. Nous construisons des systèmes qui sont conçus pour optimiser les opérations de calcul par watt. » L'intérêt pour la construction de serveurs avec des puces basse consommation augmente à mesure que les entreprises cherchent à réduire leur facture énergétique. Dell propose des serveurs avec des puces x86 de faible puissance et Microsoft a récemment demandé à Intel de mettre au point une puce Atom avec 16 coeurs pour équiper les serveurs de ses datacenters. AMD évalue actuellement l'utilisation de ses puces Fusion pour netbook sur des plates-formes serveurs. Les processeurs ARM basse consommation, généralement utilisés dans les smartphones et les tablettes, pourraient aussi bientôt arriver sur le marché des serveurs. Le fondeur Marvell a déjà annoncé une puce serveur basée sur l'architecture ARM et un peu plus tôt cette année Nvidia a dévoilé le projet Denver, le nom de code d'un processeur ARM pour PC, serveur et supercalculateur.

[[page]]

SeaMicro est l'une des rares sociétés qui tente exclusivement de construire des serveurs équipés de puces pour netbook. La firme est sortie de l'anonymat en juin dernier avec le lancement du serveur SM10000, qui comprenait 512 puces mono coeur Atom Z530. Selon Andrew Feldman, beaucoup d'entreprises, comme les fournisseurs de services cloud computing et des sociétés de télécommunication, ont montré un réel intérêt pour son produit et l'ont utilisé pour des différentes tâches. Le SM10000-64 est plus rapide et plus économe en énergie que la première version du constructeur. Le passage à une puce double coeur plus rapide, la N570, a diminué le nombre de processeurs dans le serveur, ce qui a réduit sa consommation d'énergie. Le serveur consomme 15 à 17 % d'énergie en moins. Il prend également en charge les systèmes d'exploitation 64 bits, et supporte jusqu'à 4 Go de mémoire par puce. Le précédent serveur, le SM10000, ne prenait en charge que les applications 32 bits avec un plafond de 2 Go de RAM.

Des améliorations souhaitées

Pour améliorer ses plates-formes, SeaMicro attend d'Intel qu'il développe les fonctionnalités de ses puces basse consommation avec les instructions pour l'instant réservées à ses processeurs Xeon. « Le N570 fournit la meilleure performance sur le segment des puces basse consommation », ajoute encore Andrew Feldman. SeaMicro évalue également des processeurs ARM. Ce dernier n'a toutefois pas l'écosystème logiciel indispensable ce qui le place dans une situation désavantageuse, puisque la plupart des centres de calculs sont aujourd'hui équipés de serveurs avec des puces x86. Mais ARM travaille à l'édification d'un tel écosystème et SeaMicro garde un oeil sur les progrès accomplis dans ce domaine.

Sur le plan technique, le SM10000-64 repose sur des puces Atom intégrées sur des mini lames de la taille d'une carte de crédit et reliées entre elles par un lien offrant un débit de 1,28 Térabit par seconde. La carte mère dispose d'un circuit dédié de type ASIC (Application-Specific Integrated Circuit), qui virtualise les fonctions telles que les entrées/sorties et qui réduit la nécessité de recourir à des composants spécifiques pour le réseau et le stockage. Le SM10000-64 peut accueillir jusqu'à 1 To de mémoire vive DDR3 et jusqu'à 64 disques durs ou SSD. La taille de ce serveur en rack est de 10 U, soit 17,5 pouces.

Le prix du serveur commence à 148 000 $. Il est disponible aux États-Unis et dans le reste du monde, indique la compagnie.

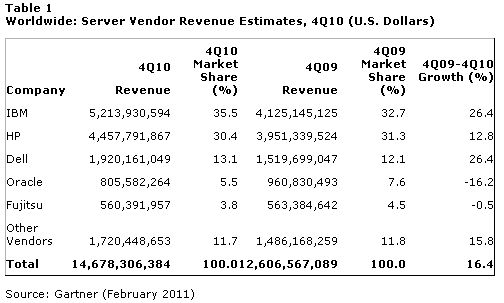

IBM et HP tirent le marché des serveurs au 4e trimestre, Dell suit, Oracle baisse

La remontée des ventes de serveurs s'est poursuivie au quatrième trimestre 2010 dans le monde, mais la croissance risque de ralentir en 2011, estime Gartner. Sur cette période, le chiffre d'affaires généré par toutes les catégories de serveurs a augmenté de 16,4% par rapport au quatrième trimestre 2009. En volume, les livraisons n'ont progressé que de 6,5%. Le cabinet d'études l'explique par le remplacement des serveurs x86 que les entreprises avaient conservé pendant la crise économique, ainsi que par l'arrivée des processeurs Nehalem d'Intel et des nouvelles puces Opteron d'AMD fin 2009. Selon Gartner, ce remplacement a passé un pic et va diminuer cette année.

Au total, sur l'ensemble de l'année, il s'est vendu plus de 8,8 millions de serveurs (+16,8%) pour un chiffre d'affaires total de 48,8 milliards de dollars (+13,2%)

Bonnes ventes de System X et Z pour IBM

Au quatrième trimestre, c'est IBM qui a réalisé le chiffre d'affaires le plus élevé, avec des ventes de 5,2 milliards de dollars qui représentent 35,5% du marché. Les livraisons des serveurs System X et des mainframes System Z (voir illustration) y ont beaucoup contribué, avec une progression de 68,3% des revenus sur la ligne System Z, selon Gartner.

HP est le second fournisseur en valeur sur la période, avec 30,4% des parts du marché mondial des serveurs. Il arrive en revanche premier sur le nombre de serveurs livrés ce trimestre : 767 026 serveurs sur un total de 2 381 428 machines, soit 32,2% de l'ensemble des livraisons. Dell prend la deuxième place avec 515 274 serveurs, soit 21,6% du marché. En termes de revenus, le constructeur texan est à la troisième place.

Fujitsu s'en sort, Oracle baisse et Cisco reste modeste

Fujitsu a progressé d'une année sur l'autre en volume (+12,4%), mais pas en valeur (-0,5% avec 3,8% de parts de marché). Oracle, de son côté, a subi une forte baisse (-40,8%) dans ses livraisons et a vu son chiffre d'affaires baisser de 16,2% par rapport au quatrième trimestre 2009, alors que l'activité serveurs était encore détenue par Sun Microsystems.

Quant à Cisco Systems, à l'issue de sa première année complète en tant que fournisseur de serveurs (sa gamme Unified Computing System a été livrée en 2009), il ne détient encore qu'une part de marché à un chiffre, très modeste, pointe Gartner.

Les ventes mondiales de serveurs, en valeur, au 4e trimestre 2010

Cliquer ici pour agrandir le tableau (Gartner)

Les ventes de serveurs blade progressent de 29,5%

Les ventes de serveurs ont augmenté en valeur dans toutes les régions du monde au dernier trimestre 2010, excepté au Japon, pays sur lequel elles ont enregistré une baisse de 4,4%. C'est l'Amérique du Nord qui tire l'ensemble, avec une progression de 24,5%, suivie de la région Asie/Pacifique, en croissance de 22,4%, l'Amérique Latine (+12,3%) et la zone EMEA (Europe, Moyen-Orient, Afrique) où les ventes de serveurs ont crû de 10 ,4% en valeur.

Les serveurs x86 ont représenté 97% de toutes les livraisons du trimestre. Cette catégorie a augmenté en volume de 7,1% et en valeur de 20%, a calculé Gartner. Sur l'année 2010, les ventes de serveurs blades ont augmenté de 29,5% en valeur et de 12,6% en volume. Au quatrième trimestre, elles ont pesé 14% du marché total des serveurs, souligne l'analyste Jeffrey Hewitt.

Illustration : Le System Z d'IBM

L'appel à une norme de log pour le cloud ne fait pas l'unanimité

La sécurité, la conformité réglementaire et la transparence des opérations et des systèmes font partie des grands défis à relever pour accélérer l'adoption du cloud, que ce soit pour les déploiements en interne, et davantage encore pour les solutions externalisées. Dans le cloud, la simple requête d'un utilisateur final peut parcourir le réseau local d'une entreprise, des serveurs externes, des cloud publics, et solliciter un certain nombre d'autres ressources avant d'être traitée. Pour beaucoup, ce parcours rend la lecture et la compréhension des logs relatifs aux opérations qui traversent les systèmes cloud hautement virtualisés, assez difficile. D'où la demande, par certains, d'une nouvelle norme pour les logs dans le Cloud. Mais celle-ci ne fait pas l'unanimité.

La question des logs au sein du Cloud mobilise depuis un certain temps l'entreprise de Misha Govshteyn, vice-président de la technologie et des solutions pour fournisseurs de service chez Alert Logic. L'entreprise, qui propose des services de sécurité et de management de logs, est encore plus concernée par le problème depuis qu'elle a pour client des fournisseurs de services d'hébergement. « Les états que nous recevons ne nous permettent pas vraiment de vérifier ce qui se passe chez eux, » explique-t-il. « Cette masse d'informations, déversée par la plupart des matériels et des logiciels, ne permet pas de savoir quelles ressources ont été sollicitées, qui a demandé le service, en quoi d'autres services ont contribué à la transaction, ou même ce qui a effectivement été utilisé par le demandeur, » ajoute t-il. C'est pourquoi, Alert Logic - avec le soutien de DataPipe, Eucalyptus Systems, Hosting.com, Mezeo Software, et Perimeter E-Security - a récemment proposé une norme, CloudLog, qui vise à simplifier la gestion des états de log pour les plates-formes Cloud et chez les fournisseurs de services.

Une meilleure visibilité et traçabilité

Actuellement en cours d'étude auprès de l'Internet Engineering Task Force (IETF) en vue de la rédaction d'un document informel Request For Comments (RFC), le CloudLog permettrait de savoir plus simplement sur quel matériel tournait telle ou telle machine virtuelle, ou à quelles ressources les utilisateurs, et leurs rôles associés, ont eu accès. « Les machines virtuelles bougent en permanence, et tournent sur différentes machines physiques. Si vous vous retrouvez avec une machine physique qui a été endommagée, c'est un vrai défi de savoir quelle machine virtuelle tournait sur cette machine physique à un moment donné, » explique John Eastman, CTO de Mezeo Software, une entreprise qui vend des services de stockage aux fournisseurs. « La seule information dont on dispose, c'est que le système tournait dans le Cloud, » ajoute-t-il. En l'état actuel, Mezeo a intégré CloudLog dans sa plate-forme Cloud Storage pour simplifier l'enregistrement des données essentielles. « Avant d'utiliser le format CloudLog, nous avons dû comprendre comment rendre cette information intelligible, parce que même si nous disposions des logs, il restait difficile d'associer un système avec les machines virtuelles, » explique le patron de Mezeo. « CloudLog nous a aidé à résoudre certaines questions de sécurité, relatives à la transparence notamment, et à identifier exactement qui utilisait telle ou telle machine virtuelle, » indique John Eastman.

Quelques réfractaires

Mais tout le monde n'est pas convaincu de la nécessité d'une standardisation. C'est notamment l'avis de Raffael Marty, fondateur et directeur de Loggly qui fournit des services de log pour le cloud. « Je tiens à souligner que le cloud, que ce soit le SaaS, PaaS, ou IaaS, n'a pas besoin d'une nouvelle norme de log ! Depuis des années, nous travaillons avec des architectures multi-niveaux et virtualisées qui sont à la base de la construction du Cloud. Aucun des attributs spécifiques du Cloud, comme l'élasticité, le paiement à l'usage, etc... n'exigent une gestion de log particulière, » écrit-il sur son blog dans un article intitulé « Pourquoi une norme de log pour le Cloud n'a pas de sens. » Selon lui, s'il y a un effort à faire en matière de log dans le Cloud, pour des architectures virtualisées, asynchrones, et distribuées, c'est plutôt du côté du standard Common Event Expression (CEE) qu'il faudrait regarder. Mais, selon Misha Govshteyn, il n'existe encore aucune implémentation du standard CEE, ni aucun projet de publication d'une quelconque spécification à l'étude. « Nous devons avancer dans cette direction,» estime-t-il.

CIO.PDF 32 : le cloud public décortiqué

Il n'y a pas de repas gratuit, disent les américains. Le Cloud public y ressemble pourtant beaucoup. Plus flexible et donnant une meilleure visibilité sur les coûts qu'une informatique interne, il séduit de plus en plus d'entreprises. Où est le piège? Ce numéro de CIO.pdf présente les choix de dix entreprises. Sous la pression de la crise économique et grâce à une meilleure maturité des offres, le Cloud séduit de plus en plus, d'autant que la sécurité et la qualité de service sont moins perçues comme des obstacles. Il faut cependant tirer le maximum de ses contrats et faire évoluer les informaticiens de l'entreprise vers de nouvelles responsabilités.

10 décideurs IT témoignent dans ce dossier : Vincent Brillot (Ceva Santé Animale), Hervé Dumas (Valeo), Pascal Thomas (Pages Jaunes), Christophe Suffys (Bittle), Joël Bentolila (TalentSoft), Raphaël Mansuy (Air Liquide - Caliatys), Dominique Guiffard (LVMH), Massimo Spada (Alstom), Patrick Del Vecchio (Taxis Bleus), Eric Harand (Eden Park).

Ce numéro comprend aussi une interview d'Eric Baudson, directeur des opérations de la banque de financement et d'investissement du Crédit Agricole. Il a du transformer les SI du groupe bancaire en pleine crise des subprimes. Nos confrères de CIO Etats-Unis vous invitent, au travers d'un autre article, à gérer correctement votre présence sur les outils sociaux, notamment Twitter.

Enfin, CIO.PDF 32 inclut une interview exclusive de Christiane Féral-Schuhl, première avocate spécialisée dans les TIC à être élue à la tête d'un barreau, en l'occurrence le plus grand de France, celui de Paris. Elle revient sur les bonnes pratiques juridiques à avoir lorsque l'on est DSI.

Téléchargez CIO.PDF 32 (...)

QFabric de Juniper repense l'infrastructure réseau des datacenters

Après 4 ans de préparation, QFabric (Quantum Fabric) tient la promesse de rénover l'architecture réseau des datacenters en passant des 3 couches dévolues à l'infrastructure réseau à une seule entité logique. « L'architecture QFabric est dix fois plus rapide, consomme 77 % d'énergie en moins, est nettement moins complexe et nécessite 90% d'espace en moins dans le datacenter », argumente le CEO de Juniper Kevin Johnson. Cette architecture repensée s'apparente à un commutateur unique pour datacenter, supervisée par une plate-forme de gestion qui donne une vue sur l'ensemble de la matrice de commutation. La solution dévoilée par Juniper comprend trois dispositifs - la plate-forme de gestion administrateur, l'interconnexion et la commutation de la Fabric et le noeud, qui gère les ports d'entrée et de sortie. A ces trois axes sont associés des produits dédiés, QF Director, QF Internconnect et le QFX3500 pour la partie node.

Les améliorations de performances promises par QFabric donneraient à Juniper une avance sur Cisco et HP, dit Rob Whiteley, analyste chez Forrester Research. Brocade est le concurrent direct avec une approche similaire, même s'il faut attendre de pouvoir observer des déploiements complets pour comparer les deux éléments, ajoute le consultant.

Un déploiement en étape

Le premier élément de QFabric commercialisé est le QFX3500, un commutateur fonctionnant sous l'OS Junos. Cette première brique devrait au troisième trimestre subir une mise à niveau logicielle le transformant en un noeud dans l'architecture QFabric. Elle lui permettra d'affecter les politiques de routage en mode peer-to-peer ce qui limitera le taux de congestion dans le cadre d'un plan de contrôle distribué.

Le QF Director est un serveur x86 avec des ports Gigabit Ethernet assurant la connexion à tous les noeuds dans le centre de calcul. Le châssis QF Interconnect prend en charge 128 ports QSFP. Le QFX3500 dispose de 48 ports 10G Ethernet QSFP + ainsi que des interfaces Fibre Channel 2G, 4G et 8G et quatre liaisons montantes Ethernet 40G QSFP. Le prix de ce dernier équipement est de 34 000 dollars, les deux autres ne sortiront qu'au troisième trimestre 2011 et leur prix n'est pas encore connu.

Le fondateur et CTO de Juniper, Pradeep Sindhu, a expliqué que les clients pourraient migrer progressivement vers la solution globale, même s'ils utilisent des équipements d'un autre fournisseur. Comme ils sont standardisés (via des interfaces Ethernet ou Fiber Channel), les modules de QFabric pourront être déployés en tandem avec l'infrastructure existante. QFabric ne sera pas limité aux centres de calcul, précise le dirigeant. Plus tard cette année, Juniper expliquera comment sa solution peut améliorer les performances de connexion du datacenter au WAN. Tom Nolle, président of CIMI Corp, société de conseil considère cette possibilité comme importante, car elle autoriserait une plus grande évolutivité et souplesse à une infrastructure cloud en lui procurant des performances fiables et prévisibles sur des ressources dispersées.

Frédéric Dussart prend la direction EMEA de la division ESSN d'HP

En 2003, il quittait HP pour rejoindre EMC. Aujourd'hui, il fait le chemin inverse. Frédéric Dussart devient le patron (senior vice-président et regional country manager) de la division ESSN (Enterprise servers, storage and networking) de HP au plan EMEA. Il remplace un certain Wolfgang Wittme qui resterait chez HP ESSN.

Frédéric Dussart a débuté sa carrière chez HP en 1985. En 2000 il arrive au poste de directeur général de la division informatique d'entreprise France. En mai 2002, il devient vice-président directeur général de PSG (Personal System Group, les PC) après la fusion entre HP et Compaq. L'année suivante, il quitte le navire devenant « DG » de EMC France puis « DG » de la région sud Europe.

| < Les 10 documents précédents | Les 10 documents suivants > |