Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 541 à 550.

| < Les 10 documents précédents | Les 10 documents suivants > |

(08/04/2011 17:20:06)

Recap IT : Cloud, Failles, Tablettes et Windows 8

Paris est devenu en l'espace d'une semaine le lieu de convergence du cloud. SalesForce.com a ouvert le bal avec un Marc Benioff au meilleur de sa forme, qui a mis en garde contre les risques de développement de faux clouds. De son côté, Oracle a rappelé lors d'une conférence à Paris sa présence sur l'ensemble des types de clouds, privés et publics. Enfin IBM a annoncé aussi son saut dans l'informatique dans les nuages en misant sur la qualité de service et la sécurité. De son côté, Facebook donne des indications stratégiques sur son projet de datacenter, Open Compute. Les annonces de la semaine ont concerné aussi le matériel et plus exactement les composants. Intel a lancé sa gamme de processeurs Xeon E7 à destination des serveurs haut de gamme.

Entre vulnérabilité et conservation des données

Sur ce dernier point, il en a été question au sujet d'IE9. En effet une société française a découvert une faille dans le navigateur pouvant pirater Windows 7, y compris dans sa dernière version SP1. Symantec a dévoilé en début de semaine son rapport sur la sécurité et souligne la montée en puissance des attaques depuis les réseaux sociaux et contre les smartphones. En ce qui concerne les données personnelles, certains éditeurs réunis autour de l'association ASIC ont saisi le Conseil d'Etat pour demander l'annulation d'un décret qui oblige les sites à sauvegarder pendant 1 an les données de leurs clients.

Les tablettes et Windows 8

La semaine a été plus discrète dans le monde des tablettes, même si on annonce la sortie de la Xoom de Motorola, qui semble ne pas séduire grand monde. Intel a promis des ardoises numériques équipées des puces Oak Trail pour le mois de mai prochain. L'actualité micro est plutôt à chercher vers les OS et notamment la prochaine version de Windows. En effet, encore secrète, quelques révélations ont été faites sur la possible adoption du ruban Office ou du web immersif et un lecteur PDF. Des interrogations se sont faites jour sur l'ouverture d'Android, avec des risques de fragmentation certains.

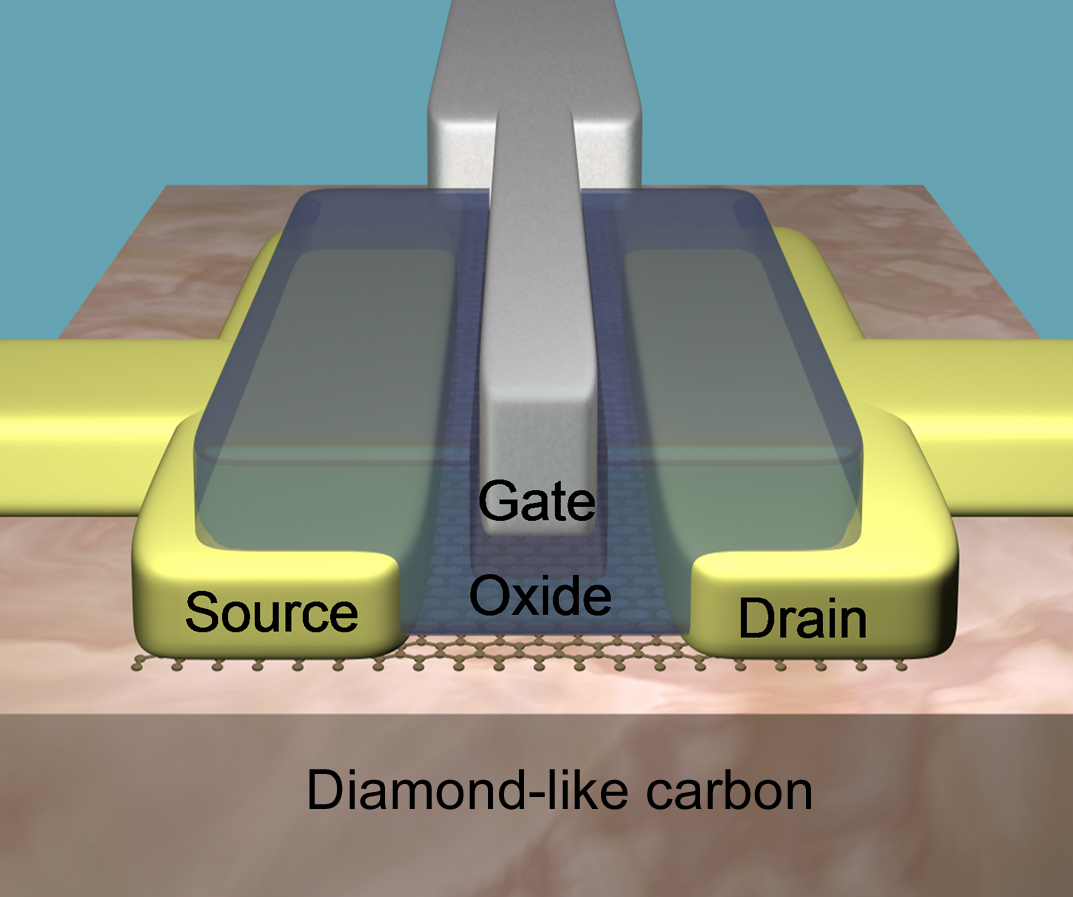

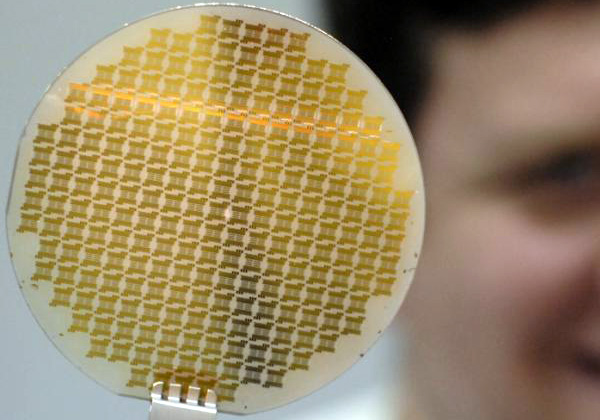

Un transistor IBM au graphène plus petit et cadencé à 155 GHz

Avec une fréquence de 155 GHz, le transistor haute performance au graphène (un cristal de carbone dont l'empilement constitue le graphite) dévoilé par les labs d'IBM est le plus rapide du moment : « il surpasse le modèle 100 GHz montré en février de l'année dernière par le fabricant, » a indiqué Yu-Ming Lin (voir illustration principale), un chercheur de Big Blue. « Cette recherche prouve également qu'il est possible de produire à faible coût des transistors haute performance, à base de graphène, en utilisant des procédés de fabrication identiques à ceux des semi-conducteurs classiques, » a ajouté le chercheur.

Cela pourrait ouvrir la voie à la production industrielle de processeurs au graphène. Mais Yu-Ming Lin ne s'est pas avancé sur une date de mise en fabrication de telles puces. « Des transistors au graphène permettraient d'améliorer les performances d'applications utilisées dans la communication sans fil, les réseaux, l'imagerie et les radars, » a indiqué Phédon Avouris, un chercheur-enseignant d'IBM.

Des recherches entamées pour la défense américaine

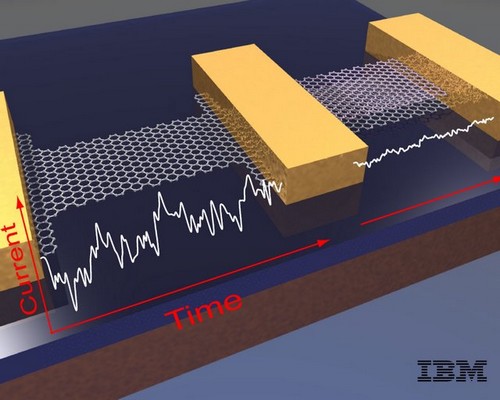

Le graphène se présente comme une couche d'atomes de carbone d'une seule d'épaisseur avec une structure hexagonale en nid d'abeille. Les recherches sur le transistor ont été entreprises par IBM dans le cadre du programme DARPA (Defense Advanced Research Projects Agency) à la demande de département américain de la Défense en vue de développer des transistors RF (fréquence radio) de haute performance. Selon Phédon Avouris, l'armée est très intéressée par les transistors au graphène. « Le flux d'électrons de ces transistors est plus rapide que celui des transistors classiques, ce qui permet des transferts de données plus rapides entre les puces, » a expliqué Yu-Ming Lin.

C'est la raison pour laquelle cette technologie est très prometteuse en matière d'applications réseau, laquelles nécessitent des communications à vitesses rapides et à fréquences élevées. « Les transistors au graphène sont capables d'effectuer des calculs plus rapidement que les transistors classiques, mais ils ne sont pas encore adaptés aux ordinateurs PC, » a-t-il ajouté. En effet, le graphène naturel ne présente pas d'écart énergétique, et les transistors au graphène ne permettent pas d'avoir le ratio de cycle requis pour les opérations de commutation numérique, ce qui est par contre le cas des processeurs conventionnels.

« En revanche, le flux continu d'énergie que procure le graphène permet un meilleur traitement des signaux analogiques, » explique encore le chercheur. « La vitesse élevée des électrons du graphène permet un traitement plus rapide des applications en électronique analogique, pour lesquelles un ratio élevé de compensation n'est pas nécessaire. »

Le plus petit transistor crée par IBM

Le transistor au graphène a bénéficié de l'utilisation d'un nouveau substrat appelé « carbone de type diamant» mis au point par IBM, grâce auquel le composant a fait preuve d'une excellente stabilité en température, entre la température ambiante et jusqu'à moins 268 degrés Celsius, la « température de l'hélium, » comme la définit IBM. « Les performances de ces dispositifs au graphène ont montré une excellente stabilité en température. Ce comportement est en grande partie du a l'utilisation d'un nouveau substrat de carbone de type diamant, » a déclaré IBM.

[[page]]

« Le transistor au graphène est également le plus petit transistor qu'IBM a mis au point à ce jour, » selon les chercheurs. La longueur de grille de la radio-fréquence du transistor au graphène est passée de 550 nanomètres à 40 nanomètres. La longueur de grille du transistor au graphène montré l'an dernier, lequel utilisait un substrat de carbure de silicium, était de 240 nanomètres.

« Mais plus important encore, la performance a été réalisée en utilisant des technologies de fabrication compatibles avec celles utilisées pour les supports à base de silicium, » a déclaré Yu-Ming Lin. « Si bien que la production industrielle de puces au graphène devient encore plus probable, » a-t-il ajouté.

Une découverte réalisée en 2004

Les possibilités du graphène sont devenues attrayantes pour les scientifiques. C'est en 2004 que André Geim et Konstantin Novoselov de l'Université de Manchester au Royaume-Uni ont isolé le graphène, jetant les bases de nouvelles recherches pour lesquelles ils ont reçu le prix Nobel de physique en 2010. « Le graphène offre un grand potentiel en matière de semi-conducteurs, mais l'industrie cherche encore à comprendre quels seraient ses avantages, » a déclaré Jim McGregor, spécialiste des stratégies en matière de technologie chez In-Stat.

Le graphène ne peut pas encore fonctionner comme un transistor numérique pour remplacer les puces en silicium actuelles. Cependant, il pourrait servir de technologie de complément à d'autres appareils utilisant le carbone pour effectuer des tâches de traitement de signal par exemple. « Comme toute nouvelle technologie, il faut des milliards de dollars d'investissement pour qu'elle devienne une alternative viable à une technologie existante.

Ensuite, cette alternative peut devenir une nécessité si la technologie actuelle se heurte à une limite physique indépassable, » a ajouté Jim McGregor. « Le graphène doit d'abord pouvoir répondre à trois exigences en matière de fabrication de semi-conducteurs : le matériau, le design et la gravure, » a-t-il encore déclaré. « Si le graphène peut être traité par les procédés de gravures actuels et futurs et répondre aux contraintes de design, alors il pourra devenir une technologie viable, mais seulement si ces deux conditions sont remplies, » a-t-il déclaré.

Projet Open Compute : Facebook partage les secrets de son datacenter

En partageant ces informations stratégiques, Facebook pense qu'elle peut contribuer à améliorer les datacenters partout dans le monde. « C'est une bonne chose pour Facebook, mais également pour les nouvelles entreprises qui doivent traiter un grand nombre de données, » a déclaré Mark Zuckerberg, le PDG de Facebook lors d'une conférence de presse (voir illustration principale). « Nous essayons de favoriser un écosystème dans lequel les développeurs peuvent mettre facilement sur pied des start-ups, et nous pensons que, en partageant ce savoir-faire, nous allons aider à rendre cet écosystème plus efficace et favoriser sa croissance, » a-t-il ajouté.

Illustration : Le datacenter de FaceBook à Prineville, Oregon

« Les besoins de Facebook en terme de centres de calcul vont aller croissant, à mesure que nous ajoutons davantage d'applications en temps réel, » a encore déclaré le fondateur. « Il faut donc être capable de concevoir des serveurs plus efficaces, tant en améliorant le rapport puissance/efficacité que le coût. Cela conditionne en grande partie notre manière de faire, » a-t-il poursuivi.

Voilà un an maintenant que Facebook travaille à mettre au point et à peaufiner son cahier des charges pour ses serveurs de données : réduction des systèmes d'alimentation, conception d'un bâtiment qui peut se passer de climatisation, concertation avec des fabricants de serveurs pour réaliser des systèmes plus légers, qui chauffent moins et sont faciles à réparer. « Nos serveurs sont 38 % plus efficaces que ceux que nous possédions auparavant, » a déclaré Jonathan Heiliger, vice-président des opérations techniques chez Facebook. « Ils sont également 24 % moins chers à fabriquer que les modèles standards de l'industrie, » a-t-il ajouté.

Partenariat direct avec plusieurs fournisseurs

Pour mener à bien son projet Open Compute, Facebook a conclu un partenariat avec Advanced Micro Devices, Intel et Quanta, et travaille également sur de nouveaux modèles avec Dell, Hewlett-Packard, Rackspace, Skype et Zynga. Du point de vue visuel, les bare-bones n'ont pas grand intérêt - Facebook qualifie leur design de « débarrassé de toute vanité » - mais ils font leur travail. Selon la norme Power Usage Effectiveness, qui mesure l'efficacité des centres de calcul, Facebook affirme que son centre de Prineville se situe à 1,07 PUE. C'est bien en deçà - et donc bien meilleur - que la norme industrielle dont la moyenne se situe à 1,5 PUE.

Cliquer sur l'image pour agrandir la photo de ce chassis AMD

Les serveurs de Facebook pèsent environ 6 kilos de moins, mais sont plus épais qu'un système classique 1U (1,75 pouce) monté sur rack. D'une épaisseur de 1,5 U (soit 2,6 pouces), ses serveurs peuvent intégrer des radiateurs plus grands et sont dotés de ventilateurs plus efficaces. Ce qui signifie aussi moins de ventilation externe pour refroidir les serveurs. Par ailleurs, ceux-ci peuvent être ouverts et réparés sans outils - des clips et des systèmes à ressort suffisent à tenir tout en place. Seul luxe visible sur ces boîtes : une LED bleue inondant le centre de Prineville d'une lueur à la Facebook, et dont le prix par ampoule est supérieur de 5 cents par rapport à l'option la moins chère.

Un supercalculateur Bull de 1,92 Tflops à la Réunion

Le supercalculateur choisi est de la famille Bullx, de Bull. Il est composé de 20 noeuds R422-E2 et un noeud SMP BullX S6030 reliés par un réseau InfiniBand. Au total, 200 coeurs offriront une puissance de calcul de 1,92 Tflops. 36 To de données seront partagées. Le coût du projet n'a pas été communiqué.

Illustration principal : Chassis Bullx 7u, crédit D.R. (...)(08/04/2011 10:52:27)

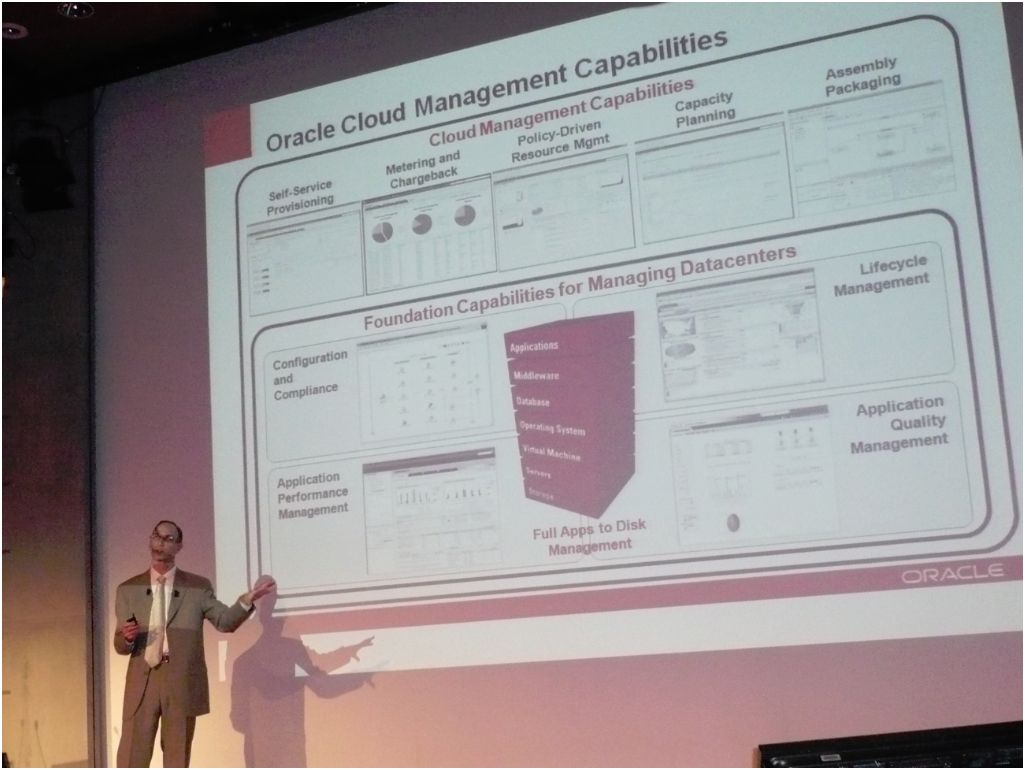

Que le cloud soit privé ou public, Oracle a réponse à tout

Si le PDG de Salesforce.com, présent mardi à Paris, a une idée très resserrée du cloud, public et multitenant, Oracle revendique de son côté une vision très large de la question. Hasard ou pas des calendriers, deux jours après son compatriote californien Marc Benioff, la société de Larry Ellison avait programmé son propre événement, à deux pas du Cnit de la Défense. Rick Schultz (en photo), vice président marketing technologie produit, y a donné la version du cloud selon Oracle. L'éditeur de Redwood reprend simplement la définition générique de l'agence américaine NIST (National Institute of Standards and Technology), soit « un modèle pour accéder à la demande à un pool de ressources informatiques configurables qui peut être rapidement mis à disposition, avec un minimum d'intervention de la part des fournisseurs qui le mettent en oeuvre ». Ce qui laisse à Oracle un terrain de jeu suffisamment étendu pour couvrir, avec ses matériels, middleware et applications, les trois modèles de services (SaaS, PaaS et IaaS) et les quatre modèles de déploiement (cloud public, privé, communautaire et hybride).

Les clouds privés prennent la corde

Rick Schultz a repris ce matin le b.a.-ba du glossaire cloud et des mérites respectifs des modèles privé et public. « Les entreprises vont adopter un mix de modèles, suivant ce qui s'adapte le mieux aux applications qu'elles utilisent déjà ». Fin 2010, une étude conduite par l'IOUG (Independent Oracle Users Group) auprès de 267 responsables IT a montré que 29% avaient déjà déployé un cloud interne (pour la plupart sur un périmètre limité) et que 37% donnaient déjà accès à certains processus à partir d'un cloud privé. Quant aux réticences autour du cloud public, elles portent avant tout sur la sécurité (à 43%), avant le coût (25%) et la qualité de service (25%). « Les clouds privés suscitent de plus en plus d'intérêt, pointe Rick Schultz. Le PaaS privé, notamment, maximise la flexibilité et le contrôle en réduisant les interventions manuelles. »

Si Oracle a une vision très large du cloud, sa stratégie est en revanche très ciblée, affirme-t-il. En version privée, il dispose de tous les ingrédients pour installer des applications sur une plateforme partagée, offrir base de données et middleware en PaaS et jusqu'au matériel et systèmes pour bâtir PaaS ou IaaS (cf ses offres Exadata et Exalogic*, cette dernière associant clustering et virtualisation), ainsi que les outils d'administration du cloud (solution Enteprise Manager). En version publique, il propose son offre applicative (les composants ERP de Fusion Applications par exemple peuvent être déployés sur un cloud public) ou l'accès à ses bases de données ou à son middleware sur un cloud tel que celui d'Amazon. Il y a deux mois, ce dernier a indiqué qu'il allait également supporter Oracle VM, la technologie de virtualisation de serveurs de l'éditeur qui repose sur Xen. « Nous poursuivons nos investissements dans nos différents produits de virtualisation », a précisé Rick Schultz par la suite, lors d'une session de questions/réponses, en insistant sur l'effort réalisé par le groupe en R&D (4 milliards de dollars prévus sur 2011 - contre 3,25 Md$ en 2010, soit 12% du chiffre d'affaires de l'exercice). « Nous continuons d'investir sur les technologies rachetées », rappelle le VP marketing technologie product.

250 applications sur une infrastructure partagée

Rick Schultz illustre son propos par quelques cas d'écoles. Le Crédit Suisse, notamment, a déployé trois clouds privés internes, PaaS et IaaS. Succédant au VP marketing d'Oracle, Massimo Pezzini, de Gartner, zoome sur le cas. La banque dispose notamment d'une plateforme pour des applications Java (rassemblant WebLogic Portal, WebLogic Server, JMS, Application Integration Components, RAC [Real Application Cluster], des outils de sécurité et de gestion de système et le framework applicatif). Le modèle de déploiement est double : partagé pour certaines applications ou consacré à une application. Bilan : le Crédit Suisse exploite 250 applications sur une infrastructure Solaris partagée (reposant sur 180 serveurs) et 20 applications déployées sur des serveurs strictement dédiés, pour la banque sur Internet et les systèmes de paiement.

(*) Pour Rick Schultz, les premiers clients d'Exalogic, offre toute récente lancée sur OpenWorld 2010, seront très probablement les utilisateurs des solutions middleware WebLogic.

Illustration : Rick Schultz, vice président marketing technologie produit (crédit : M.G.)

Rick Schultz, VP marketing technologie produit d'Oracle, expose les capacités d'administration du cloud proposées par l'éditeur (crédit : M.G.) (...)

Un cluster Linux HPC de 10 000 coeurs dans le cloud d'Amazon

« C'est un chiffre rond très agréable», explique Jason Stowe, le PDG et fondateur de Cycle Computing, un fournisseur qui aide les clients à acquérir un accès rapide et efficace aux supercalculateurs habituellement réservés aux universités et aux grands laboratoires de recherche. Cycle Computing avait déjà construit quelques clusters sur le Cloud d'Amazon Elastic Compute qui pouvaient évoluer jusqu'à quelques milliers de coeurs. Mais Jason Stowe veut passer à une étape supplémentaire : l'allocation de 10 000 coeurs sur Amazon dans un cluster HPC. Cela implique d'utiliser une technologie d'ordonnancement de commandes et d'exécuter une application HPC optimisée.

« Nous n'avons pas trouvé de références sur quelque chose d'aussi grand », précise le dirigeant. Sur les tests de capacité de traitement, l'architecture de cluster basé sur Linux proposée sur Amazon serait assez importante pour intégrer le Top 500 des supercalculateurs les plus rapides du monde. Il revendiquerait la 114ème position avec 66 Terflops. Une des premières étapes a été de trouver un client qui bénéficierait d'un tel grand cluster. Il n'y a pas beaucoup d'utilisateurs pour ce type de supercalculateur. L'heureux élu est l'entreprise de biotechnologie Genentech, basée à San Francisco, où Jacob Corn, scientifique indique avoir besoin des capacités de calcul pour examiner comment les protéines se lient les unes aux autres. Cette recherche pourrait éventuellement mener à des traitements médicaux. Le scientifique indique par rapport au cluster de 10 000 coeurs, « nous sommes à un dixième de la taille en interne».

Du cloud et une dose de savoir-faire

Cycle Computing et Genentech ont déployé ce cluster le 1er mars dernier, un peu après minuit, sur les conseils d'Amazon, car il s'agissait du moment idéal pour mobiliser les 10 000 coeurs. Même si Amazon propose des instances de machines virtuelles optimisées pour l'informatique haute performance, les deux protagonistes du projet ont plutôt opté pour un cluster Linux reposant sur le standard « Vanilla CentOS » afin d'économiser de l'argent, souligne Jason Stowe. CentOS est une version de Linux basée sur une distribution Red Hat.

Les 10 000 coeurs sont composés de 1 250 instances avec huit coeurs chacun, ainsi que 8.75 To de RAM et 2 Po d'espace disque. 45 minutes ont été nécessaires pour mettre à disposition l'ensemble du cluster. Ce dernier a été utilisé pendant huit heures à un coût de 8 500 dollars, incluant toutes les redevances à Amazon et Cycle Computing. Pour Genentech, cet exercice n'était pas cher et se révèle plus simple que d'acheter 10 000 coeurs pour son propre centre de données et de les utiliser sur une courte durée. Jacob Corn explique qu'en utilisant ses propres ressources, les simulations auraient pris des semaines ou des mois car l'approche avec Amazon repose sur du calcul brut et ne s'embarrasse pas du dialogue entre les noeuds et certains effets du traitement massivement parallèle.

Cycle Computing a utilisé son propre logiciel CycleCloud, le système de planification pour le cluster et Chef Condor, un framework Open Source pour la gestion et la configuration. La société a également utilisé une partie de son logiciel pour détecter les erreurs et redémarrer les noeuds si nécessaire, un système de fichier partagé, et quelques noeuds supplémentaires au-dessus des 10 000 pour traiter certaines tâches. Pour assurer la sécurité, le cluster a été conçu avec Secure-HTTP et un chiffrement de 128/256 Advanced Encryption Standard (AES).

Crédit Photo: D.R

(...)

Pour baisser ses coûts IT, Essilor fait appel à moins de prestataires

Jeudi 31 mars, Bénédicte Bonnet Roussey, Business Services Sourcing Manager chez Essilor a exposé les bonnes pratiques mises en place à la DSI du numéro un mondial du verre ophtalmique dans le cadre de la coopération avec la direction des achats IT afin de réduire les coûts des prestations informatiques. Elle s'exprimait à l'occasion d'une table ronde organisée par Luc Domissy dans les locaux de l'ESCP à Paris sur le thème de la Gouvernance IT, dans le cadre du groupement des grandes écoles G9+ et plus particulièrement du GP Informatique Arts & Métiers ParisTech.

La direction des achats IT d'Essilor s'est penchée en 2008 sur le coût des prestataires auxquels les différentes équipes informatiques font appel sur les 5 continents, et 100 pays. La facture à l'époque s'élevait à 28 millions d'euros. Les deux tiers de cette facture concernaient la traditionnelle assistance technique en mode régie, assez peu structurée. L'autre tiers se séparait pour moitié entre des prestations d'intégration réalisées au forfait et pour l'autre moitié en TMA, structurée.

Réduction du nombre de prestataires

On peut constater l'extrême émiettement des prestations puisque l'assistance technique était réalisée via 128 personnes travaillant pour 54 sociétés différentes. « Notre objectif, commun avec la DSI, était de rationaliser auprès de 15 fournisseurs uniquement, dont 3 fournisseurs principaux dits VIP auxquels nous proposerions en priorité et en exclusivité les projets et 12 challengers. Ceux-ci se verraient consultés si les trois fournisseurs principaux n'arrivaient pas à répondre » décrit Bénédicte Bonnet Roussey.

Un appel d'offres a été lancé début 2009 auprès du panel de 54 sociétés. Les critères de choix pour déterminer les prestataires conservés étaient multiples : compétences technologiques, possibilité d'accéder à des prestations offshore, ... « Nous avons défini une grille tarifaire à partir du référentiel de compétences du Cigref qui comprend 50 profils où nous en avons retenu 13 » ajoute la responsable des achats. Les 3 fournisseurs VIP n'étaient pas forcément les moins chers. « Leur capacité à aider à la réflexion stratégique sur l'IT a été prise en compte » déclare Bénédicte Bonnet Roussey.

Au terme de cette expérience, on peut en retenir quelques éléments de réflexion. Tout d'abord, tout le business qui était confié aux prestataires qui n'avaient pas été retenus, et qui donc ont été déréférencés, n'a pu être rebasculé vers les trois prestataires principaux. La raison en est très humaine : les relations personnelles qui ont ...

Photo D.R.

[[page]]

... pu être créées entre un patron de l'IT et son prestataire ne s'interrompent pas si facilement. « Il faut suivre cela de près pour faire respecter les règles du jeu définies avec la DSI » note la responsable des achats. Elle attire l'attention sur les risques que peut faire courir une relation trop intime sur le long terme entre une direction des systèmes d'information et son prestataire : le délit de marchandage.

Au bout d'un certain temps, on ne fait plus suffisamment attention à qui fait partie de l'entreprise ou pas. « Afin de ne pas tomber dans ce travers, il faut éviter tous les signes qui auraient tendance à montrer que le prestataire est traité comme un salarié de l'entreprise. Par exemple, il ne doit pas avoir d'email d'entreprise, ni de ligne directe, ni voir ses congés être validés par le manager de l'entreprise cliente. Pour notre part, nous avons mis en place des contrats de 3 mois qui doivent être renouvelés » dit-elle. L'économie réalisée par Essilor grâce à cette remise à plat des prestations IT a atteint 10% sur la masse d'achat.

« Pour le futur, il faut évidemment que nous allions vers la forfaitisation, et vers la massification, avant même de recourir à l'offshore » retient-elle. Le déréférencement s'avère difficile à réaliser jusqu'au bout, d'autant plus dans une période de crise et de resserrement des budgets IT. Un prestataire qui est présent dans une entreprise depuis des années, dix ou quinze ans, a tout intérêt d'y rester, d'autant plus qu'il a perdu de la valeur sur le marché pour son employeur en restant trop longtemps dans l'entreprise.

En conclusion, Bénédicte Bonnet Roussey attire l'attention sur un moyen qu'elle utilise afin d'avoir une vision plus juste du coût d'un prestataire : « Je demande à ce qu'il chiffre sur un projet non seulement sa propre prestation mais également la charge qu'il estime que cela représente côté Essilor, et on peut choisir selon la bottom-line parmi les prestataires. »

Intel lance les puces Xeon E7 pour les serveurs haut de gamme

La gamme Xeon E7, plus connue sous le nom de code Westmere-EX, serait selon Intel 40% plus rapide que son prédécesseur, la Xeon7500, a déclaré Kirk Skaugen, vice-président et directeur général du groupe Intel Data Center. Pour mémoire, la série Xeon 7500 était équipée de processeurs huit coeurs et avait été lancée en 2010. Avec Xeon E7, Intel vise le marché des serveurs haut de gamme qui font tourner des applications critiques telles que les bases de données et ERP. Les processeurs sont gravés en 32-nanomètre et reposent sur la microarchitecture Westmere.

Un seul serveur Xeon E7 sera en mesure de remplacer 18 serveurs dual-core, ce qui devrait aider la consolidation du nombre de serveurs dans les centres de calcul, explique Kirk Skaugen. La puce E7 propose un bon rapport puissance-efficacité, grâce à un mécanisme de capable de ralentir la vitesse des coeurs et ainsi de réduire la consommation d'énergie.

Selon le dirigeant, un serveur à quatre sockets avec une puce E7 sera en mesure de prendre en charge jusqu'à 2 To de mémoire, ce qui est le double de la capacité gérée par le Xeon 7500. Intel propose 10 puces 10 coeurs, comprenant la E7-8870, E7-4870-2870, qui sont cadencées à des vitesses allant jusqu'à 2,4 GHz et consomment jusqu'à 130 watts. Un serveur 4U sera en mesure d'accueillir jusqu'à 64 emplacements de mémoire.

Des partenaires déjà prêts et une alternative à Itanium

Les constructeurs de serveurs ont annoncé dans la foulée de la présentation de l'E7 leurs produits ad hoc. Ainsi, Dell propose une évolution de son serveur PowerEdge avec Xeon E7 puces « Nous avons constaté un gain de performances de 49 % par watt avec des mémoires basse tension par rapport à la précédente génération de puces Xeon huit coeurs, a déclaré Brian Payne, directeur exécutif de la ligne de serveurs Dell PowerEdge. La consommation globale d'énergie au niveau d'un noeud de serveurs est plus faible, ce qui contribue à réduire les coûts liés à la consommation énergétique.

La puce comprend également l'amélioration de la techologie RAS (fiabilité, disponibilité et facilité de maintenance) qui aide les serveurs à maintenir une disponibilité élevée, a déclaré Brian Payne. Les serveurs PowerEdge de Dell comprennent également des outils de gestion des systèmes visant à réduire les coûts de maintenance du serveur.

Certaines fonctionnalités RAS se retrouvent aussi sur les puces Itanium d'Intel dédiées au serveur haut de gamme. Kirk Skaugen explique que la Xeon E7 peut dans certains cas offrir de meilleures performances que les puces Itanium, et pourrait être une alternative, selon le système d'exploitation choisi. En effet HP et son OS HP-UX privilégie Itanium tout comme certaines distribution Linux, alors que les serveurs tournant sur du Windows ou du Red Hat s'appuient sur des architectures x86. Ce débat intervient quelques jours après la décision d'Oracle de mettre fin au développement de logiciel et de middleware sur Itanium. Oracle faisait état de discussions avec Intel lui assurant qu'Itanium était en fin de vie. Le fondeur avait été alors obligé de démentir et d'annoncer la roadmap d'Itanium sur les 10 prochaines années.

Kirk Skaugen a souligné les performances d'Oracle 11g Release 2 base de données sur les puces Xeon E7. Il a ajouté que grâce à la technologie AES-NI (Advanced Encryption Standard Instructions) le cryptage des données a été accéléré par 10. Un certain nombre de clients pourraient ainsi voir des avantages à la migration vers les serveurs équipés de puces Xeon E7.

Intel a également annoncé les puces Xeon E3-1200 dédiées aux serveurs d'entrée de gamme, que le fondeur appelle microserveurs. Les processeurs sont basés sur la microarchitecture Sandy Bridge et sont conçus pour des applications d'entreprise telles que le stockage, sauvegarde et les services web.

(...)

L'IEEE travaille sur la standardisation du cloud computing

Institut à but non lucratif, l'IEEE (Institute of Electrical and Electronics Engineers) compare l'état du cloud computing actuel à celui dans lequel se trouvait l'Internet à ses débuts. Le cloud computing est promis à une croissance explosive, mais « sans un cadre commun et flexible capable de garantir l'interopérabilité, l'innovation pourrait s'essouffler et confiner les utilisateurs dans un écosystème fonctionnant en vase clos, » avertit l'organisme dans un communiqué.

Dans le cadre de son action de promotion du cloud, l'IEEE a mis sur pied deux groupes de travail, P2301 et P2302, lesquels sont chargés de plancher sur une grande variété de domaines. Ainsi, le groupe de travail P2301 doit prendre en charge la normalisation de la portabilité du cloud et son management, qui fait intervenir un certain nombre de formats de fichiers et d'interfaces. Quant au groupe de travail P2302, il s'attachera à avancer sur la question de l'interopérabilité de nuage à nuage et sa fédération. Il travaillera, par exemple, sur la normalisation des passerelles qui peuvent gérer l'échange de données entre clouds.

La standardisation, un frein à l'innovation ?

Selon David Bradshaw, directeur de recherche pour l'European SaaS et les services cloud d'IDC, « d'une manière générale, la normalisation dans le domaine du cloud computing est considérée comme une excellente chose, car elle permettra aux entreprises d'utiliser le cloud computing de façon plus efficiente et avec plus de confiance. » Cependant, étant donné que le «cloud computing» en est encore à ses débuts, il y a aussi, selon David Bradshaw, « un risque à vouloir définir trop précisément la façon dont les choses devraient fonctionner. » Selon lui, cela pourrait avoir un effet contraire et empêcher l'innovation.

Le nombre d'organismes travaillant à la standardisation du cloud computing est pléthorique. Même la Commission européenne s'est impliquée dans le domaine. Pour le directeur de recherche d'IDC, la meilleure chose qui puisse arriver serait qu'ils aient la bonne idée de travailler ensemble de façon à éviter la fragmentation des standards normatifs. C'est au niveau de la plate-forme que le besoin de normalisation est le plus urgent. « Cela permettrait aux entreprises de déplacer la charge de travail d'un fournisseur de cloud à l'autre, » a t-il dit. La Cloud Computing Initiative de l'IEEE est présidée par Steve Diamond d'EMC et les groupes de travail sont présidés par David Bernstein, directeur général de la société de conseils Cloud Strategy Partners.

(...)(05/04/2011 12:36:08)

L'iPhone 5 retardé suite à la paralysie d'une usine Sony

Seth Weintraub, du site 9to5Mac, assistait à l'entretien sur la scène du Cargenie Hall entre Walt Mossberg,du Walt Street Journal, et le PDG de Sony, Howard Stringer. Il en a fait un compte rendu en direct sur son blog. Voici ce qu'il a écrit : « Howard Stringer vient de dire que leur usine de Sendaï (voir illustration ci-dessous) qui fabrique les capteurs de la caméra a été touchée par le récent séisme suivi par le tsunami. Dans un même souffle, il a dit quelque chose concernant les capteurs et que leur livraison à des sociétés comme Apple serait retardé. En d'autres termes : « Nos meilleurs capteurs sont fabriqués dans l'une des usines touchée par le tsunami... Ce sont ceux destinés aux iPhone et iPad d'Apple. »

« Ils nous achètent nos meilleurs capteurs ? »

« Donc, le PDG de Sony semble avoir confirmé une rumeur entendue un peu plus tôt, selon laquelle l'iPhone serait équipé d'une caméra de 8 mégapixels dont le capteur est fabriqué par Sony, » conclut John Stokes de Art Technica. Cependant Jessica Vascellaro, une blogueuse du Wall Street Journal, qui a également couvert l'événement de Carnegie Hall, fait remarquer que Sony n'était pas le fournisseur actuel d'Apple. « On ne sait pas de quels appareils parlait le PDG de Sony, d'autant que l'entreprise n'est pas connue pour fournir à Apple des composants clés pour sa caméra, notamment le capteur d'image. Une porte-parole de Sony a refusé de commenter et un porte-parole d'Apple n'a pas pu être joint pour commentaire, » écrit-elle.

Une première pour Sony

Selon TheStreet.com, cela fait un an qu'Apple a choisi une puce Sony pour l'appareil photo de 8 mégapixels de l'iPhone 2011 (sans doute l'iPhone 5) en remplacement de son fournisseur actuel OmniVision. Le site tient cette information de Rodman Renshaw, analyste chez Ashok Kumar, qui avait prédit ce changement en se basant sur des éléments recueillis auprès de fournisseurs et de fabricants. Si les informations concernant le capteur photo sont vraies, cela signifie que les utilisateurs d'iPhone pourront profiter d'une bien meilleure qualité d'image sur leurs appareils mobiles. Actuellement, l'iPhone 4 est équipé d'un capteur photo de 5 mégapixels avec flash LED.

| < Les 10 documents précédents | Les 10 documents suivants > |