Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 531 à 540.

| < Les 10 documents précédents | Les 10 documents suivants > |

(12/04/2011 16:24:23)

Convergence 2011 : Microsoft projette ses ERP Dynamics dans Azure

Microsoft vient d'annoncer, à l'occasion de Convergence, où se rassemblent les utilisateurs de ses applications de gestion (Atlanta, 10-13 avril), qu'il proposerait l'ensemble de ses ERP sur sa plateforme cloud Azure. « Cela commencera avec Dynamics NAV 7 dans un an », précise Virginie Garlasain, chef de produit Dynamics ERP chez Microsoft France. C'est une évolution majeure pour ces gammes qui sont distribuées en mode indirect depuis leur origine et dont la mise en oeuvre repose sur un important réseau de distributeurs bien implantés. L'éditeur adopte pour ces offres une démarche similaire à celle déjà choisie pour son application de CRM (gestion de la relation client). Celle-ci a été redéveloppée il y a plusieurs années pour pouvoir être exploitée « as a service » dans une architecture partagée dite « multitenant ». Désormais, Microsoft la propose mondialement en mode SaaS (Dynamics CRM Online), hébergée sur ses propres datacenters, et en version classique (dite « on premise ») que les entreprises installent chez elles. En complément, les clients peuvent aussi choisir un mode infogéré dans lequel l'application de CRM est hébergée chez des prestataires, HP par exemple.

C'est un modèle équivalent qui devrait être mis en place à l'avenir avec les ERP de la gamme Dynamics (il y a quatre produits, mais seuls deux d'entre eux, NAV et AX, disposent d'une base significative en Europe). « Cette évolution technologique des ERP vers le cloud a été entamée depuis longtemps », explique Virginie Garlasain, « avec l'idée d'avoir une solution utilisant le même code pour la solution traditionnelle et pour l'offre en ligne, en permettant le passage de l'une à l'autre ».

Un guide d'accompagnement pour les partenaires

A Atlanta, conscient de l'inquiétude que cette annonce pourrait susciter parmi les partenaires, Kirill Tatarinov (en photo), responsable de la division Microsoft Business Solutions, s'est voulu rassurant. « Quoique nous fassions, nous emmènerons l'écosystème ERP avec nous dans le cloud. Il est extrêmement important pour nous de le faire. Tous ceux qui ont amené Dynamics jusqu'à vous seront là dans le cloud », a-t-il promis aux quelques milliers d'utilisateurs réunis devant lui (9 300 personnes attendues en quatre jours).

L'éditeur de Redmond a prévu d'aborder cette semaine la façon dont ses partenaires pourront profiter de ce modèle de déploiement des ERP dans le cloud. D'abord, les partenaires vont pouvoir vendre des applications verticales adaptées au cloud, des services et des add-on à travers la place de marché Dynamics. « Microsoft a par ailleurs sorti un guide d'accompagnement des partenaires vers le modèle cloud », indique Virginie Garlasain.

Cela dit, on ne voit pas comment Microsoft pourrait se passer de partenaires pour accompagner les clients de ses ERP dans l'environnement cloud, compte-tenu de la nécessité d'adapter la solution en fonction des besoins de chaque entreprise. Il serait de toutes façons très imprudent de la part de l'éditeur de mettre de côté son vaste réseau de distributeurs.

Parmi les concurrents de Microsoft sur le terrain des PME, SAP propose trois offres dont deux à installer classiquement (Business One et All-in-One) et la troisième uniquement accessible dans le cloud, Business ByDesign.

Le concept du multitenant pourrait évoluer

Le déploiement des ERP Dynamics sur Azure se fera donc en mode multitenant, architecture qui permet à de nombreux clients de partager la même instance applicative, tout en conservant un mode privé pour leurs données. Il se différencie du modèle hébergé infogéré dans lequel chaque client dispose de sa propre instance d'application. En dehors des économies d'échelle qui réduisent les coûts, le mode multitenant permet à l'éditeur de mettre son application à jour régulièrement et facilement. Marc Benioff, PDG de Salesforce.com, est l'un des défenseurs les plus vibrants du multitenant. Il compare cette architecture à un immeuble de bureaux où de nombreuses entreprises ont des locaux fermés et privés, mais partagent les lignes électriques, les canalisations et les autres éléments de l'infrastructure. Cela constitue toujours une technologie importante pour le cloud, mais sa pertinence décline à mesure que l'industrie IT réalise des avancées dans la gestion des machines virtuelles, estime pour sa part Kirill Tatarinov, de Microsoft. Il considère aussi que l'expérience acquise par l'éditeur avec la mise à disposition mondiale de CRM Online(*) conjuguée aux progrès techniques, aideront à baisser le coût de l'ERP dans le cloud.

(*) uniquement disponible aux Etats-Unis pendant deux ans, l'application est maintenant proposée sur quarante marchés.

Illustration : Sur Convergence 2011, Kirill Tatarinov, responsable de la division Microsoft Business Solutions

[[page]]Cela dit, le vice-président ne donne encore que peu de détails sur la tarification des gammes dans le cloud. « Nous pourrions faire des choses différentes suivant les produits », a-t-il indiqué. De nombreux clients paient déjà le logiciel sur un modèle de souscription qui sera aussi proposé pour les produits Azure Dynamics.

Microsoft ne s'attend pas à une forte migration des clients Dynamics dans le cloud, a reconnu Kirill Tatarinov. « Dans le monde des ERP, vous voyez principalement des déploiements mixtes ». Par exemple, une entreprise pourrait décider d'utiliser Azure pour donner accès à l'ERP à ses équipes de ventes ou de techniciens itinérants, tandis que ses équipes administratives utiliseraient un ERP installé en interne.

Ecrire du code à exploiter sur site et dans le cloud

Les processus de personnalisation des ERP Dynamics pour Azure devraient se mettre en place en douceur pour les partenaires qui conçoivent actuellement des extensions et des applications verticales pour les actuels modèles de déploiements, a annoncé Kirill Tatarinov. Un nouvel outil de configuration arrivera avec la version 2012 de Dynamics AX (prévue pour août de cette année), ERP qui sera lui aussi disponible sur Azure à terme. Selon le vice-président, cet outil devrait permettre d'améliorer sensiblement le logiciel sans écrire de code. Les développeurs pourront aussi continuer à utiliser C# ou d'autres langages de l'environnement .Net.

Microsoft prévoit de fournir aux partenaires et clients des guides et méthodologies pour écrire du code qui s'exploitera indifféremment sur site ou dans le cloud, a assuré Kirill Tatarinov. Mais il est toujours possible qu'une personnalisation donnée ne soit pas entièrement compatible avec un déploiement dans le cloud, suivant la façon dont elle a été écrite.

Pour Frank Scavo, associé de la société de conseil IT Strativa, l'option cloud peut faire la différence sur les nouvelles ventes d'ERP ou dans le cas de clients qui cherchent quelque chose de nouveau. En revanche, il pense que les actuels utilisateurs de Dynamics pourraient trouver plus confortable de conserver leurs installations telles quelles. Surtout s'ils n'ont rien qui les presse de passer au cloud. Mais il faut bien que Microsoft apporte une réponse face à la pression concurrentielle qu'exercent sur lui les éditeurs d'ERP qui opèrent déjà en mode cloud (outre SAP, on trouve aussi NetSuite aux Etats-Unis et bientôt Oracle avec Fusion Apps).

Dynamics AX 2012 pour le secteur public[[page]]

Dynamics AX 2012 pour le secteur public

Sur Convergence, Microsoft a également parlé de Dynamics AX 2012, dont la bêta sera livrée ce mois-ci. « Cette prochaine version a déjà suscité un certain enthousiasme lorsqu'elle a été présentée en février à Seattle, à l'occasion de la conférence Technical Summit », assure Virgine Garsalain, responsable de produits Dynamics au sein de la filiale française. « Elle sera intégrée avec les toutes dernières versions des produits collaboratifs et son interface inspirée d'Office sera améliorée [à la façon de ce que NAV propose dans ce domaine]. L'intégration Excel, par exemple, est bidirectionnelle sur les aspects de budgétisation », explique-t-elle. Il est possible d'une part d'envoyer un budget sous Excel puis de réintégrer les informations budgétaires dans la base de données AX ».

Par ailleurs, aux quatre fondations métiers que Dynamics AX propose déjà sur quatre secteurs d'activités (distribution, retail, services, industrie) s'en ajoute maintenant une cinquième : le secteur public. « Toutes ces macro-verticalisations, développées par la R&D de Microsoft en s'inspirant de ce qu'ont fait nos partenaires -GFI, par exemple, en France- coexistent dans une seule solution », rappelle Virginie Garlasain en ajoutant que ces améliorations se font sans « sacrifier à l'agilité puisque l'on peut faire cohabiter des processus métiers gérés de façon séparés. Au niveau du développement, pour permettre cette agilité, on réduit la logique applicative codée en dur dans la solution pour travailler sur des modèles naturels et unifiés avec des workflows graphiques et disposer d'une couche de développement faisant appel à des composants modélisés ».

Nouveau également sur Dynamics AX 2012 : les développements pourront se faire à partir de Visual Studio. « Jusqu'à présent, on utilisait plutôt l'IDE MorphX ». Enfin, comme avec Dynamics NAV, la nouvelle interface combine une navigation en mode web et Office. S'y ajoute la possibilité de disposer pour les utilisateurs en atelier d'interfaces qui s'utiliseront à partir d'écrans tactiles.

Tableau de gestion de production Kanban (cliquer ici pour agrandir l'image)

(...)

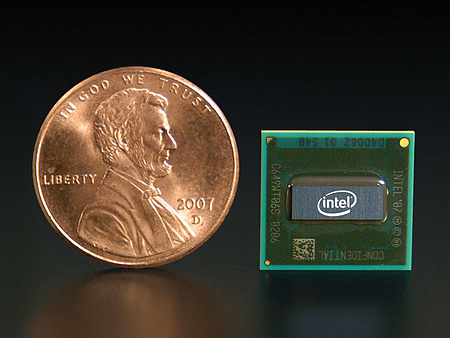

IDF Pékin : Intel va montrer sa puce Cedar Trail pour netbook

Lors de l'Intel Developer Forum (IDF), qui se tient les 12 et 13 avril à Pékin, Intel devrait montrer ses futures puces Atom à faible consommation d'énergie pour netbooks et tablettes, une manière d'entretenir la concurrence avec son rival ARM sur le marché de la tablette tactile. Notamment, le fondeur de Santa Clara pourrait dévoiler son futur processeur pour netbook, nom de code Cedar Trail, dont la livraison est prévue pour l'année prochaine.

Selon Bill Kircos, directeur général du marketing pour les netbooks et les tablettes chez Intel, la société « livrera des détails conséquents sur ses puces pour netbooks et tablettes programmées pour 2013. » Toujours selon le directeur marketing, on pourra également voir des tablettes intégrant le processeur Atom, nom de code Oak Trail, lors de l'événement.

Une puce spéciale tablette pour contrer ARM

La puce Oak Trail, laquelle marque la première incursion d'Intel sur le marché de la tablette grand public, sera présente dans plusieurs modèles de tablettes qui doivent être commercialisées dès le mois de mai prochain. Afin de renforcer sa présence sur le marché de la tablette où il est pratiquement inexistant, le fondeur a mis sur pied, fin de décembre, une unité distincte pour les netbooks et les tablettes. La plupart des dispositifs, y compris l'iPad 2, intègrent des processeurs ARM, considérés comme plus économes en énergie que les puces Atom.

Selon Bill Kircos, « d'ici 2013, Intel espère avoir comblé l'écart en terme de puissance et de performance avec ARM. » Selon lui, à cette échéance, Intel devrait être à égalité avec son rival en matière de consommation d'énergie. Intel investit également des milliards de dollars pour moderniser ses usines, afin d'intégrer plus de fonctionnalités dans ses puces et trouver des solutions pour réduire la fuite de données. Mais, alors qu'Intel cherche à avoir sa part dans le marché de la tablette, les processeurs ARM gagnent en rapidité tout en maintenant une faible consommation d'énergie.

[[page]]

Les tablettes intégrant des processeurs ARM double coeur sont à peine arrivées sur les étagères que les fabricants de puces montrent déjà des versions quad-core pour périphériques. Ainsi, au mois de février dernier, Nvidia a montré une puce quad-core Tegra, nom de code Kal-El, qui, selon l'entreprise, pourrait déjà se retrouver dans les tablettes plus tard cette année. « Intel veut offrir une expérience plus complète avec les tablettes, » explique Bill Kircos. « La bataille avec ARM ne consiste pas nécessairement à multiplier le nombre de core, mais se joue aussi sur l'ajout de fonctionnalités uniques qui permettront de faire la différence entre ses puces et l'offre de son rival. »

De nouvelles fonctions pour les netbooks

« C'est ce qu'Intel est en train de faire avec sa puce Cedar Trail, laquelle comprendra 10 nouvelles fonctionnalités pour rendre les netbooks plus attractifs, » a déclaré Bill Kircos. Parmi les fonctionnalités, on note un écran sans fil pour diffuser du contenu depuis le netbook sur des téléviseurs, un système de diffusion de musique sans fil Wireless DJ pour transmettre le son vers des haut-parleurs, et une technologie sans fil pour transférer des données directement d'un PC à un autre. « D'autres caractéristiques de Cedar Trail seront dévoilées lors de l'IDF de Beijing, » a déclaré le responsable d'Intel. « Toutes ces technologies pourront être ajoutées à des puces Atom pour tablettes, » a-t-il ajouté.

Intel envisage également d'inclure dans ses processeurs pour tablettes des fonctionnalités propres aux puces PC, comme la technologie VPro qui apporte des fonctions de sécurité et d'administration. Par exemple, la technologie antivol VPro d'Intel permettrait aux responsables informatiques de désactiver à distance des tablettes volées ou perdues, en envoyant des instructions par réseau filaire, sans fil ou cellulaire. Une fois l'appareil récupéré, l'utilisateur pourrait le réactiver par un code fourni par le service informatique. Intel a déjà fait savoir qu'il voulait intégrer des fonctionnalités radios 3G/4G et de sécurité dans ses futures puces Atom. Cette année, Intel a finalisé ses acquisitions du spécialiste de la sécurité McAfee et de l'unité sans fil d'Infineon qui lui donne accès à la technologie radio.

Encore du travail sur la consommation électrique

Mais, comme l'explique Bill Kircos, « Intel doit en priorité se pencher sur la consommation d'énergie pour fournir aux tablettes une autonomie en veille prolongée, » grâce aux progrès qu'elle a effectué dans la technologie de fabrication. Cedar Trail sera fabriqué selon le procédé de gravure 32 nanomètres, celui-là même qui est utilisé pour les derniers processeurs Core i3, i5 et i7 (Sandy Bridge). Les puces actuelles destinées aux netbooks sont fabriquées selon le procédé à 45 nm. « En 2013, Intel renouvellera simultanément ses lignes de processeurs pour tablettes et netbooks, » annonce Bill Kircos. Ceux-ci seront fabriqués selon le processus de gravure 22-nm dont Intel lancera la fabrication un plus tard cette année. Les premières puces 22-nm seront destinées aux ordinateurs PC.

Un cloud made in Lozère

Le cloud computing atteint aussi la Lozère, à l'initiative de deux chefs d'entreprise, les frères Lefevre, qui ont créé la société Gosis, il y a un an. Ils bâtissent un datacenter (enterré 10 mètres sous terre) avec deux unités, une à La Canourgue, l'autre à Mende (sur la zone économique POLeN, Pôle LOzérien d'économie Numérique). Un datacenter très Green IT, basé sur le climat frais et l'hygrométrie des lieux. Il sera disponible dans un an.

Gosis a également mis au point un logiciel, Sied Dced (en mode Saas), chargé d'automatiser l'analyse de l'empreinte carbone d'un système d'information. Il cartographie ce dernier, en déduit un plan d'action et un reporting technique et financier des actions engagées. Elles peuvent être reprises dans le bilan RSE de l'entreprise. Par ailleurs, Gosis a créé une filiale, Hcbox, chargé de développer un assistant personnel de santé pour le patient.

Un projet soutenu par Cisco et Oséo

Gosis constitue un réseau de partenaires intégrateurs en France, une trentaine doit être recrutée cette année, une centaine en France et en Europe d'ici deux ans. Ils vont commercialiser l'offre cloud de Gosis auprès de clients qui paieront à l'usage.

Pour soutenir ses ambitions, la société développe un plan de financement particulier. Son capital est de 300 000 euros, elle bénéficie du soutien du Conseil général (Lozère) et du Conseil régional (Languedoc-Roussillon) pour son implantation. Cisco a financé les serveurs UCS, 600 000 euros de matériels, et Pillar les baies de stockage. Oséo a accompagné le développement du logiciel, ainsi que l'Ecole des Mines.

SAP s'invite dans le cloud d'IBM

A l'occasion de ses annonces Smart Business pour faciliter le passage des entreprises aux clouds, IBM a dévoilé la certification des solutions SAP sur ses services cloud computing. Cela signifie que les utilisateurs SAP pourront disposer de la souplesse des ressources proposées par Big Blue. « Si une base de données SAP a besoin de plus de stockage, nous pouvons en ajouter dynamiquement - c'est l'avantage du cloud » a ainsi expliqué Ric Telford, vice-président en charge des services cloud chez IBM, lors d'une conférence de presse à New York.

SAP est le premier système ERP qu'IBM supportera dans un environnement de cloud computing, mais d'autres sont prévus, a poursuivi Ric Telford. Si les utilisateurs ont bien la possibilité de basculer toutes leurs applications dans le cloud, il ne les voit pas encore ces derniers complètement abandonner leurs infrastructures. « La plupart des clients continueront à garder un certain nombre de leurs charges de travail dans leurs propres centres de calcul » dit-il. « C'est aussi pourquoi IBM propose des solutions clouds hybrides qui mélent des services en ligne et dans le datacenter du client. Le cloud leur donne maintenant des options qu'ils n'avaient pas auparavant ».

L'offre SAP, qui sera proposée dans le cadre de la plate-forme Smart Cloud d'IBM, est attendue un peu plus tard dans l'année.

(...)(11/04/2011 15:04:45)BMC tire parti des performances de DB2v10 sur System z

« Les clients veulent migrer vers la version 10 de DB2 plus rapidement qu'ils ne l'avaient souhaité lors des précédentes évolutions de la base de données, en raison des promesses de réduction de coût faites par IBM », constate Robin Reddick, directeur marketing de BMC pour la gestion de service mainframe en ajoutant que BMC avait fait évoluer 23 de ses applications de gestion de service mainframe pour qu'elles supportent la version 10 de DB2 sur System z9 et z10 (en photo).

Les derniers modèles System z exploitent des co-processeurs zIIPs (Integrated information processor) qui viennent décharger le processeur principal de certains traitements, ce qui permet aux clients de réduire le coût au Mips (million instructions par seconde) des systèmes. Lorsqu'IBM a lancé DB2 10 pour z/OS l'an dernier, il a annoncé qu'en migrant vers cette version, les clients verraient une amélioration automatique des performances, de l'ordre de 10%, grâce à l'utilisation de ces co-processeurs. Selon lui, il était même possible d'obtenir des gains supérieurs si le client procédait à des réglages fins du système. Dans ce domaine, Robin Reddick, indique que les solutions BMC qui tirent parti des co-processeurs zIIP aideront à réaliser ces ajustements.

Parmi les produits pour DB2 que l'éditeur a mis à jour figurent System Performance, Database Administration, Database Performance, Recovery Management et SQL Performance. Ce dernier identifie les requêtes SQL qui surconsomment les ressources et il a justement été réécrit pour fonctionner avec les zIIP. « Parmi les outils qu'un client peut avoir, les produits d'optimisation sont typiquement ceux qui font le plus appel au CPU », souligne Robin Reddick. En déplaçant le logiciel vers le processeur zIIP, les clients peuvent l'exploiter sans monopoliser les ressources du processeur principal.

Un datawarehouse sur DB2 10 au Florida Hospital

Le groupe hospitalier Florida Hospital est au nombre des clients susceptibles de tirer profit de ce nouveau jeu d'outils. Son système d'information rassemble 42 applications médicales et de back-office prenant appui sur une instance de DB2 exploitée sur un mainframe IBM. La base de données reçoit près de 400 millions d'accès chaque jour. L'établissement va passer à DB2 version 10 et l'utilisera en premier lieu pour une application de datawarehouse. DB2 supporte le mode « time-based data » (enregistrement périodique des données), ce qui permettra à l'hôpital d'interroger le datawarehouse à tout moment. « Nous pourrons obtenir des réponses [sur les données enregistrées] au jour le jour], ce qui nous ne pouvions pas faire auparavant », explique Bob Goodman, administrateur senior de la base de données de l'hôpital.

L'établissement va également déployer différentes mises à jour de produits BMC, parmi lesquelles le logiciel de monitoring MainView pour DB2 qui facilitera la résolution des problèmes sur le datawarehouse. Ce dernier va répondre à de nombreuses requêtes dynamiques, ou bien à des requêtes uniques qui n'ont pas encore été optimisées pour un usage répété. « MainView donne la possibilité de se tourner vers Dynamic SQL », ajoute Bob Goodman. Il explique que contrairement à d'autres outils de monitoring qu'il a utilisés par le passé, MainView propose de conserver un historique des appels SQL et des chemins qu'ils ont empruntés dans le système. « Avec MainView, nous pouvons revenir à une connexion pour l'examiner. Cela constitue pour nous une aide à la productivité. Nous avions l'habitude de faire la chasse aux dysfonctionnements. Maintenant, nous pouvons voir où se situe le problème. »

Illustration : le mainframe z10 (crédit photo : IBM) (...)(11/04/2011 14:29:16)Dell va investir 1 milliard pour construire 10 datacenters

A mesure que le marché des services de cloud computing se développe, les fournisseurs de solutions informatiques investissent pour développer des offres de ce type. Dell a ainsi déclaré cette semaine qu'elle prévoit de dépenser 1 milliard de dollars en 2011 pour construire 10 datacenters automatisés dans le monde et fournir des services cloud computing aux entreprises. Un investissement conséquent, IBM pour sa part a dépensé 300 millions de dollars depuis 2009 pour renforcer ses datacenters avec notamment la création d'un nouveau centre de calcul dédié au cloud à Singapour pour un montant de 36 millions de dollars. Plus près de nous, la première tranche du programme d'extension du datacenter d'IBM à Clichy va bientôt entrer en service.

Les chiffres publiés cette semaine par Gartner soulignent la nécessité de construire des services cloud computing, notamment pour proposer des plates-formes IaaS, ce qui implique de rassembler des ressources virtualisées en serveurs, stockage et réseau auxquelles les clients pourront se ravitailler. Gartner s'attend à ce que le marché mondial de l'IaaS passe de 3,7 milliards de dollars en 2011 à 10,5 milliards en 2014. « Le marché des services Cloud est encore très fragmenté et il est encore accessible à tout le monde », a déclaré Matt Eastwood, analyste chez IDC.

Des systèmes automatisés privés pour les clients

Aujourd'hui, Dell fournit des bureaux virtuels et des services d'hébergement. Avec cette nouvelle offre, la société pourra également proposer de l'IaaS, ainsi que des services pour aider ses clients à déployer et à gérer ces environnements. Dell proposera de nouveaux produits - des systèmes pré-dimensionnés, testés et validés - qui permettront aux clients de créer en interne des clouds privés. Selon les analystes, avec cette offre, Dell est susceptible de mettre l'accent sur les petites et moyennes entreprises.

Au sujet de Dell, Matt Eastwood estime que la firme n'avait pas d'autre choix que d'aller dans cette direction. « Si Dell ne prenait pas ce chemin, ils risquaient fort d'avoir des conversations difficiles avec leurs clients, car ils ne seraient pas en mesure de fournir ce que leurs clients leur demandent de faire » , a-t-il ajouté.

(...)(11/04/2011 11:32:38)Selon le Gartner, l'IaaS est encore immature

Un gros potentiel, mais encore un faible impact, telle est, en résumé, l'analyse que fait le cabinet Gartner du marché du cloud Iaas. Ce marché devrait passer de 3,7 à 10,5 milliards de dollars entre 2011 et 2014. Mais aucun service en particulier, ni aucun fournisseur ne semble encore le tirer vers l'avant.

« Nous ne sommes qu'au début du cycle d'adoption du cloud IasS », note Lydia Leong, vice-président recherche chez Gartner. « Ce marché est en évolution rapide sur 10 à 20 ans, les 5 prochaines années représenteront une opportunité importante pour les fournisseurs qui ont intérêt à poser des fondations pour l'avenir ».

Un contrôle partiel de l'infrastructure

Le client, rappelle le Gartner, ne gère ni ne contrôle l'infrastructure cloud sous-jacente, mais exerce un contrôle sur les systèmes d'exploitation, le stockage et les applications déployées. Autre rappel : l'IaaS peut être internalisé ou bien exercé par un prestataire externe. L'infrastructure sous-jacente pouvant être hébergée dans les centres de données internes d'une entreprise ou dans un centre de données externe. Cette infrastructure sous-jacente peut être dédiée à un seul client ("nuage privé"), partagée entre un consortium de clients («nuage communauté»), ou partagée avec la clientèle d'un fournisseur en général («nuage public»).

En fait, souligne le Gartner, le marché et les technologies associées sont immatures, les clients ont actuellement tendance à opter principalement pour des décisions tactiques plutôt que pour du long terme. Les fournisseurs de services doivent donc travailler dur pour s'assurer de conserver ces clients » conclut Lydia Leong. Elle ajoute que, pour comprendre l'évolution du marché, les fournisseurs doivent d'abord comprendre ce que les clients potentiels ont l'intention de faire avec l'IaaS. Ils doivent aussi se rendre compte que les clients ne sont souvent pas pleinement conscients de leurs besoins.

IBM plonge dans le cloud public et privé

Sur la bataille qui s'engage pour la domination du marché du cloud, IBM a réorganisé et complété ses forces. Après le rachat d'Arsenal Digital, un spécialiste du stockage en ligne, et de Cast Iron Systems, spécialisé dans les logiciels d'intégration de cloud, IBM dévoile une offre cloud modulaire (IaaS et PaaS) mâtinée d'infogérance, un logiciel d'aide à la création de datacenter automatisé, Cloud Workload Deployer, et LotusLive, la version SaaS de la suite collaborative de Big Blue.

Pour l'occasion Philippe Jarre, directeur général d'IBM France, en charge de l'activité Global Technology Services, nous a présenté la stratégie et les objectifs d'IBM dans le monde du cloud computing. Une présentation qui a commencé par un petit rappel, « le cloud n'est pas totalement étranger à IBM puisque nous travaillons sur le sujet depuis 2006 [...] 6 milliards de dollars sont dépensés par IBM en R&D et une part considérable est dédiée aux infrastructures ». Aujourd'hui, le marché des fournisseurs de technologie pour les infrastructures se résume à deux acteurs, IBM et Intel, poursuit Philippe Jarre, et avec la plate-forme Watson nous avons démontré un savoir-faire qui sera disponible dans 5 ans dans les puces pour mobile.

13 centres cloud dans le monde

Treize centres de compétences cloud dont deux en France à Montpellier et à La Gaude aident les clients de Big Blue à automatiser leurs datacenters. « L'approche d'IBM est pragmatique, on regarde toujours avec les clients ce qui peut tout d'abord aller dans le cloud. Aujourd'hui, nous travaillons avec plus de 100 000 entreprises dans le monde pour transférer leurs activités dans le cloud ».

La firme d'Armonk ambitionne de réaliser un chiffre d'affaires de 7 milliards de dollars dans le cloud (dans le monde), avec un déplacement de 4 milliards de l'activité traditionnelle et donc 3 milliards de nouveau business. Impossible de savoir, malgré nos nombreuses requêtes, quels sont aujourd'hui les revenus réalisés par IBM dans le cloud. On apprendra juste que la société attend une croissance de 24% des dépenses IT sur ce marché en France selon une étude Markess consacrée aux plates-formes Iaas et PaaS.

Parmi les clients d'IBM dans le cloud, Philippe Jarre a tenu à mettre en avant plusieurs clients. L'opérateur SK Telecom en Corée qui a déployé une plate-forme PaaS pour proposer à ses clients un cloud privé réservé aux développements d'apps pour mobiles. Plus ambitieuse dans ce domaine, la banque ING a décidé de transférer de 5 à 20% de son parc applicatif dans un cloud interne. Enfin, le portail français Altares a choisi la plate-forme IaaS d'IBM pour développer ses solutions analytiques (finance, marketing...) sur les entreprises.

Un mixte de cloud et d'infogérance

Pour revenir aux annonces du jour, Fady El Kaddoum, responsable des offres se services Cloud chez IBM, nous a détaillé les services Smart Cloud. Le premier, baptisé Smart Business Cloud Enterprise et auparavant connu sous le nom de Tests & Dev, est une offre IaaS similaire à celle d'Amazon Web Services et de Microsoft Windows Azure. Les clients peuvent déployer des applications Linux et Windows sur des VM KVM dans les centres de données IBM, avec une disponibilité de 99,5 % par an. La société destinant en effet cette plate-forme aux applications non critiques et aux tests de solutions.

Fady El Kaddoum insiste bien sur le support proposé par IBM bien plus complet selon lui que celui d'Amazon. « Un technicien et un point de contact français sont proposés en support et comme plusieurs pays sont opérés, il est possible d'aider une société en paris et sa filiale à Dubai ». Dernier point d'importance, cette offre est sans engagement et peut être stoppée en moins d'une heure, nous garantit l'évangéliste d'IBM.

Tous les hyperviseurs supportés

Le deuxième niveau de service, Smart Business Enterprise + offre plus de sécurité avec une garantie de disponibilité passant à 99,9 % et la possibilité d'exécuter des machines virtuelles sur matériel dédié, plutôt que sur des serveurs partagés avec les autres clients, et la possibilité d'utiliser AIX ainsi Windows et Linux. Les hyperviseurs supportés sont les quatre principaux, à savoir VMware VSphere, Microsoft Hyper-V, Citrix Xen et Red Hat KVM. Smart Business Enterprise + permet également aux clients d'obtenir plus de souplesse de gestion, de connexion, de sécurité et d'autres options de disponibilité.

IBM prend en charge tout le matériel et les hyperviseurs, avec n'importe quelle combinaison OS, applications ou processus d'entreprise. Si ces services cloud n'ont rien d'originaux, IBM essaie d'aller un pas plus loin que les offres de cloud standard, en termes de prix, de sécurité, de fiabilité et de disponibilité. Philippe Jarre souligne ainsi que les prix proposés par IBM seront de 25 à 30% moins chers qu'une infrastructure traditionnelle. Cette offre est disponible dans une version complètement hébergée ou simplement gérée par IBM avec un paiement au mois en Opex. IBM entre ici en concurrence avec les services cloud computing proposés par Hewlett-Packard. Mais alors que HP n'a pas encore indiqué quand ses offres seront disponibles, IBM a déclaré que son service Smart Business Cloud Enterprise est disponible dès maintenant à travers le monde, et que l'Enterprise + suivra plus tard dans l'année.

Un outil d'aide à la migration cloud

En complément de ses services cloud, Big Blue propose également des produits tant matériels et logiciels que les entreprises peuvent déployer dans leurs propres centres de calcul. Il comprend de nombreux produits et systèmes Tivoli, notamment Tivoli Service Automation Manager et Tivoli Provisioning Manager for Images. Et pour aider les entreprises à concevoir et déployer des architectures cloud privé, IBM commercialise le logiciel Cloud Workload Deployer. Cet outil doté d'une interface graphique supporte les logiciels maisons pour la construction de cloud privé. Toujours coté software, IBM annonce l'arrivée de LotusLive et la certification des solutions SAP sur ses clouds.

Enfin, IBM propose une solution cloud totalement privée, en mode Capex, pour les entreprises qui ont peur du cloud public. Cela ne veut pas dire qu'IBM n'a pas beaucoup de clients qui utilisent déjà ses services cloud public, mais simplement que les entreprises ,en particulier dans les secteurs où les données sont sensibles comme la santé et la finance, ne sont pas encore prêtes à passer au cloud public. Philippe Jarre ne prétend pas autre chose quand il nous confie en aparté que la vraie différence entre cloud privé et public c'est la sécurité.

Signalons pour conclure que Big Blue lance à son tour une alliance pour standardiser le cloud computing. Baptisée Open Cloud Standards Alliance, cette dernière regroupe principalement des clients - sponsors mis à part - dont AT&T, Lockheed Martin, ADP, StateStreet, pour travailler et imposer une architecture de référence et des standards d'interopérabilité.

| < Les 10 documents précédents | Les 10 documents suivants > |