Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 171 à 180.

| < Les 10 documents précédents | Les 10 documents suivants > |

(23/11/2011 10:11:27)

Le salon Partner VIP veut accélérer l'adoption du SaaS

« La révolution induite par le SaaS et le cloud en général touche avant tout les fournisseurs et leurs partenaires plutôt que les clients eux-mêmes », expliquait Jack Mandard, le PDG de Compubase, la société organisatrice de Partner VIP. Mais que l'on se rassure, indique ce dernier, la révolution du cloud est un phénomène lent qui mettra du temps pour rivaliser avec l'informatique traditionnelle. Et c'est heureux, car les discours évangélisateurs des fournisseurs présents à Partner VIP montraient qu'il faut encore aider les revendeurs et les prestataires de services à se positionner. A la mi-journée, ils étaient 500 participants aux ateliers et autres conférences organisés lors de Partner VIP, l'organisateur tablant sur une population de 700 personnes pour la journée entière.

Les sessions plénières et les 44 ateliers proposé aux visiteurs étaient animés par quatre types d'intervenants : les VAD, les éditeurs, les opérateurs télécoms et les sociétés de financement. Certains avec des annonces à partager, la plupart étant engagés dans des partenariats. Petit tour d'horizon :

Parmi Les VAD, on comptait Tech Data Azlan, Arrow, et Magirus. Le premier a profité de Partner VIP pour officialiser le lancement de TDCloud, une offre de cloud privé et public. Son homologue Magirus a joué quant à lui sur le registre de l'annonce en avant-première en dévoilant un accord signé avec l'opérateur télécom Colt. De son côté Arrow a profité de son temps d'intervention pour faire une large présentation de son approche du cloud sans toutefois dévoiler les détails d'un chantier de grande ampleur dans lequel il s'est lancé. Pour préparer ses prochaines annonces, le VAD a mené une enquête auprès de 300 VARs, 35 éditeurs, 8 prestataires de services externalisés ainsi que 5 intégrateurs dans plusieurs pays d'Europe. Arrow se présente comme un fournisseur de solutions de cloud privé et référence désormais les offres de cinq fournisseurs : IBM, Trend Micro, McAfee, Mitel et Symantec. Dans l'assistance, ces grossistes étaient écoutés et même observés. On pouvait en effet croiser dans l'assistance des représentants de grossistes de taille plus modeste qui ne cachaient pas en aparté qu'ils étaient aux aussi sur le point de lancer leur propre offre de services cloud.

Du changement à prévoir dans la relation revendeur / client

IBM a bénéficié d'un large temps de parole. Il y a un an, celui-ci a défini sa stratégie cloud jusqu'en 2015 en misant sur le développement de ses ventes auprès des PME via ses partenaires. Le constructeur s'attache également à inciter les ISV à se lancer dans le cloud grâce à ses technologies. Outre des produits, il dispose du club des partenaires, une structure à travers laquelle IBM incite les éditeurs à proposer du SaaS en utilisant ses propres formules.

Sage était également de la partie. L'éditeur a notamment évoqué les changements induits par le SaaS dans la relation revendeurs / éditeurs. « Le client n'appartient à personne et donc pas plus à un éditeur qu'à son partenaire, expliquait Violaine Fontaine, la directrice marketing stratégie et communication de la division Sage MGE. La répartition des rôles de chacun sera fonction des compétences, des capacités et de la volonté des partenaires ». Attention cependant à ne pas non plus sous-estimer les changements dans la relation entre le revendeur et son client. Avantagé par des investissements initiaux relatifs à la mise en place d'une solution SaaS par rapport à une solution classique, ces derniers pourraient se montrer plus volatiles. Avec le SaaS, l'ère du client captif pourrait donc être révolue. D'où l'importance du fait que les revendeurs devront étoffer leur capacité à offrir des services d'accompagnement au-delà de la prestation de mise en oeuvre initiale d'une solution.

Du côté des opérateurs télécoms, Colt a annoncé en avant-première européenne un accord avec Magirus pour que ce dernier commercialise vCloud, l'offre de l'opérateur. « Magirus dispose non seulement d'un réseau de revendeurs bien maillé mais aussi d'un centre de formation, le Magirus Academy situé à Strasbourg » expliquait Michel Calmejane, directeur général France de Colt. Quant à l'opérateur Mitel, il a utilisé la tribune que lui donnait Partner VIP pour mettre en avant son association avec Arrow. L'opérateur Acropolis, toujours pragmatique, disposait d'un stand commercial.

Seule société de financement présente en tant que telle, Leasecom lançait une formule de financement pour les éditeurs en SaaS. Ils sont invités à signer une convention avec Leasecom, moyennant quoi ce dernier règle immédiatement l'intégralité de la partie logicielle des redevances d'abonnement dues par le client (déduction faite des frais Leasecom). En cas de disparition de l'éditeur, cette formule assure également la continuité de service.

D'autres acteurs du financement, tels qu'IBM (avec IMB FS qui dispose d'un milliard de dollars pour financer des offres en cloud) ou Arrow (avec Arrow FCG) ont également mis en avant leurs filiales de financement lors de différentes interventions.

Datacenters et clouds privés : l'écosystème stimule la demande, selon Markess

Stratégique, l'évolution des datacenters et des clouds privés d'entreprise va amener une transformation profonde de la IT, rappelait mardi matin Emmanuelle Olivié-Paul, directrice associée de Markess International, en soulignant que, sur ce marché, « c'est tout un écosystème qui dynamise la demande ». Les directions techniques des prestataires, notamment, font évoluer leurs propres datacenters, explique l'analyste. Markess estime à environ 3 milliards d'euros le marché français des logiciels et services IT consacrés aux datacenters en 2011, et à 570 millions d'euros celui des logiciels et services IT associés aux clouds privés (*).

Pour approcher les datacenters, le cabinet d'études a pris comme curseur le parc de serveurs. Entre septembre et novembre 2011, plus de 140 décideurs ont été interrogés, au sein d'organisations privées et publiques, dont un tiers dans le secteur IT, ainsi que 53 prestataires actifs sur le marché français des datacenters et du cloud computing. Premier constat : la moitié des décideurs sondés a consacré cette année un quart de son budget informatique aux datacenters, que ceux-ci soient internes à l'entreprise ou externes (**). « Et 46% indiquent que ce budget va augmenter d'ici 2013 », ajoute Emmanuelle Olivié-Paul. Contre 14% pensant qu'il va baisser, 27% ne sachant pas et 13% le voyant stable.

Datacenters : Un serveur sur trois serait virtualisé

Deuxième tendance, le nombre de serveurs hébergés dans des datacenters externes augmentera à un rythme plus soutenu qu'au sein des datacenters internes. Sur 140 décideurs interrogés, 62% envisagent en effet d'ici 2013 une hausse de leurs serveurs hébergés à l'extérieur, contre 25% prévoyant une hausse de leur parc de serveurs en interne.

Markess International s'est ensuite penché sur la part de serveurs virtualisés hébergés au sein des datacenters (internes ou externes). Le cabinet note qu'une majorité de décideurs mentionne faire du cloud privé alors qu'ils ont simplement virtualisé. Un sur dix a indiqué que 100% de ses serveurs étaient actuellement virtualisés tandis que 17% de l'échantillon n'en avaient aucun. Au total, le cabinet d'études estime qu'en 2011, près d'un serveur sur trois hébergé dans des datacenters serait virtualisé. D'ici à 2013 et à isopérimètre, il devrait y en avoir deux sur trois.

Le cloud privé, associé à de meilleures garanties

Pour Markess, la progression de la virtualisation témoigne d'une dynamique pour les clouds privés d'entreprise. Le cabinet rappelle qu'à la différence du cloud public, le cloud privé implique la mise en place d'un hébergement spécifique, soit en interne dans l'entreprise, soit dans le datacenter d'un prestataire. Selon Emmanuelle Olivié-Paul, dans un contexte économique tendu, c'est l'optimisation des coûts d'exploitation IT qui amène les entreprises vers le cloud public, alors que le choix de clouds privés internes relève plutôt de la recherche d'agilité et, pour beaucoup, de l'assurance d'obtenir de meilleures garanties.

[[page]]

La directrice associée de Markess International note par ailleurs une forte corrélation entre le niveau de recours au cloud privé et la maturité de certaines approches : la virtualisation des serveurs, mais aussi la consolidation des environnements hébergés dans les datacenters. Si ces deux démarches tirent aujourd'hui les investissements réalisés, on note aussi une progression des projets visant à standardiser les environnements, à les rationaliser et à mutualiser les ressources. L'étape suivante étant l'automatisation de l'approvisionnement. « Certaines entreprises vont plus vite, indique Emmanuelle Olivié-Paul. Toutes celles qui ont des besoins de time to market sont plus matures sur ces sujets-là. Le modèle de business de l'entreprise, de même que sa culture, ont une influence certaine. L'industrie, par exemple, a l'habitude d'automatiser ses process ».

Un mouvement lent de transformation

36% des 140 décideurs interrogés disent recourir déjà à du cloud privé, 24% comptent le faire d'ici 2013 et 14% après 2013. Mais 18% ne l'envisagent pas. En revanche, dans cette dernière catégorie, qui semble réfractaire au cloud privé, 47% recourent ou comptent recourir à du cloud public.

En 2011, environ 32% des serveurs hébergés dans des datacenters seraient concernés par du cloud privé externe et 7% par du cloud privé interne, note enfin le cabinet d'études. D'ici 2013 et à isopérimètre, cette part devrait presque doubler dans le premier cas. Quant à la part des serveurs concernés par le cloud privé interne, elle devrait tripler.

Néanmoins, note Markess, l'adoption du cloud privé reste un mouvement lent de transformation en raison des impacts conséquents sur les datacenters (révision des architectures informatiques et des processus existants, changement des missions de la DSI...) et des enjeux associés (performance réseaux, gestion des engagements de services, confidentialité et localisation des données). Le cabinet prévoit donc des étapes intermédiaires avant « l'étape ultime du cloud privé incluant l'automatisation de l'approvisionnement ». Une démarche qui s'appuiera obligatoirement sur des soutiens externes : éditeurs, sociétés de services et cabinets de conseil.

Source : Markess International (cliquer ici pour agrandir l'image)

Outre l'évolution des datacenters d'ici 2013, l'étude Markess (150 pages) présente aussi leur localisation en France et les contrats d'infogérance associés, le point de vue des offreurs, ainsi que des retours d'expérience d'entreprises sur des projets de cloud privé.

(*) Des chiffres qui n'incluent ni le matériel, ni les revenus réseaux, ni les volets BTP et énergétiques des datacenters. Ils ont été établis en évitant tout double compte, précise Markess. Les revenus d'offreurs situés hors de l'Hexagone sont compris.

(**) Ce budget informatique inclut les dépenses internes (frais généraux et charges de personnel) et externes (achats d'équipements, solutions logicielles, services...).

Les axes stratégiques de SFR Business Team : cloud, international et fibre

Récemment arrivé à la tête de l'activité entreprise de SFR, Pierre Barnabé, ancien responsable d'Alcatel-Lucent, a profité d'une rencontre avec les journalistes pour donner sa feuille de route stratégique. Concrètement, elle tourne autour de 3 axes, le premier est le cloud et les services « parmi les différents marchés que nous adressons, téléphonie fixe, mobile et hébergement, c'est vers ce troisième marché que nous souhaitons porter notre effort ». Il a rappelé que le marché du cloud est très compétitif avec beaucoup d'acteurs, mais il pense que « les opérateurs télécoms sont les mieux à même de proposer des offres cloud, stables, disponibles et sécurisées ». Comment vont se traduire les efforts dans ce domaine ? « Nous allons renforcer notre partenariat avec HP » explique Pierre Barnabé sans toutefois préciser les modalités de cette montée en puissance comme par exemple l'utilisation du cloud public du constructeur. Il évoque seulement des actions communes au niveau de la distribution entre les VARs informatiques et les revendeurs télécoms. Sur la distinction des offres, l'opérateur va proposer du cloud privatif, plus sécurisé, géolocalisé en France, redondant et un cloud privé, hautement sécurisé et disponible.

Est-ce que des recrutements et d'autres partenariats sont prévus dans cette orientation ? « Tout est ouvert concernant les associations, les partenariats ou les acquisitions, mais dans un premier temps, j'ai demandé à mes équipes de monter en compétence dans l'intégration et dans la sécurité pour répondre à cette montée en charge ». Le dirigeant réfléchit aussi à des offres verticalisées sur le cloud « vers certains secteurs, cela peut avoir du sens. Après il faut regarder les avantages et les inconvénients. A court terme, la verticalisation est une bonne chose, mais sur le long terme, il peut y avoir un phénomène de silos et d'éloignement des standards technologiques qui évoluent ». Autre surprise pour Pierre Barnabé, l'appétence des PME pour le cloud, « le changement a eu lieu en cours d'année, elles veulent en savoir plus sur le cloud qui devient un mot qui les rassure ».

International et Fibre

Parmi les autres axes de travaux de Pierre Barnabé, l'internationalisation de SFR Business Team vise à démontrer que le groupe est « multinational » et non plus un acteur perçu souvent comme trop hexagonal. Pour développer cette stratégie, l'activité entreprise de l'opérateur va s'appuyer sur son partenariat historique avec Vodafone ou via ses participations au sein de Maroc Telecom, mais aussi sur des partenariats avec des acteurs dans des régions comme l'Amérique du Sud, l'Asie, etc. Ces différents accords seront formalisés au sein d'une alliance (dont le nom reste encore à définir) pour respecter des niveaux de qualité de service, de certification, de couverture et répondre plus facilement à des appels d'offres internationaux.

Enfin, le dernier axe est la fibre optique avec notamment l'accord entre Orange et SFR sur le déploiement du très haut débit dans les zones peu denses. L'objectif de Pierre Barnabé est de « fibrer » une grande partie des zones d'activités. « La fibre est essentielle pour apporter de meilleurs débits pour nos clients, mais elle est bénéfique aussi pour notre gestion du réseau », précise le dirigeant en pensant notamment à la collecte du trafic data mobile qui explose d'année en année.

Au final, ce plan de bataille de SFR Business Team doit avoir pour but de faire fructifier les 2 milliards d'euros de revenus annuels et améliorer sa part de marché notamment sur les services et l'hébergement. « Nous avons été discrets ces quelques mois, nous repartons à l'offensive », conclut Pierre Barnabé.

Huawei affiche ses ambitions pour le cloud

Au coeur de l'empire Huawei, sur le gigantesque campus de Shenzhen, le constructeur chinois a présenté à une brochette de journalistes français ses solutions télécoms et réseaux, ses terminaux mobiles, ses serveurs, ses systèmes de stockage et sa plate-forme de cloud computing. Si en Europe, le nom de Huawei ne fait pas spontanément penser à des serveurs ou à des baies de stockage, en Asie, le constructeur est déjà un fournisseur global d'infrastructures pour datacenter. Les salles informatiques de géants chinois comme Baidu (le Google national) ou Alibaba (le numéro de la vente en ligne en Chine) sont par exemple équipés avec des solutions serveur et stockage, nous a confié Leon He, vice-président en charge des ventes enterprises chez Huawei. Sans état d'âme, le dirigeant avoue volontiers être désormais en compétition avec HP, Dell, EMC ou Cisco, mais exclut encore IBM.

Un géant chinois à l'assaut du reste du monde

Crée en 1987, Huawei a réalisé l'an passé un chiffre d'affaires de 29 milliards de dollars US et a investi près de 2,5 milliards en R&D en 2010. Si les revenus de l'activité entreprise sont encore modestes, 2 milliards de dollars, le marché est porteur et aucun nouvel entrant majeur n'est venu le chahuter sur ce segment. Huawei se fait donc fort de réveiller le marché. Parmi les serveurs proposés par le constructeur chinois, deux modèles ont particulièrement retenu notre attention. Les modèles E6000 et X6000. Le premier peut accueillir 10 lames verticales équipées d'un ou deux processeurs Xeon 5500/5600 avec quatre ou huit coeurs épaulés par un maximum de 192 Go de RAM. Le second peut recevoir des demi-lames animées par un Xeon 3400 quatre coeurs avec 32 Go de RAM max (XH-310), un ou deux Xeon 5500/5600 avec 192 Go de RAM (XH-320) et, enfin, un ou deux Xeon 5500/5600, mais avec 288 Go de RAM (XH620). Le design modulaire du X6000 peut combiner 4 demi-lames dans un noeud occupant 2U dans l'armoire qui fait au total un maximum de 84 blades (voir illustration principale).

Impossible d'obtenir des prix pour ces serveurs. Catherine Hu, directrice de la branche IT chez Huawei, nous a simplement précisé que ces produits seront commercialisés en France à des tarifs très compétitifs. La responsable fonde notamment de grands espoirs sur le modèle X6000, baptisé Cloud Server. C'est la seconde brique dans la stratégie du chinois qui a construit une plate-forme cloud de type IaaS et une offre de stockage cloud reposant sur des stacks Open Source. « Nous sommes clairs, nous poussons une plate-forme ouverte », précise Leon He. « Sur le marché français, nous recherchons des partenaires et poursuivons nos études marketing pour bien affiner notre offre. Nous travaillons d'ailleurs avec les opérateurs télécoms pour évaluer le marché. Notre ambition est de les aider à réduire leurs coûts et à améliorer leurs revenus. » Un centre de compétences va également ouvrir en région parisienne pour accélérer le mouvement.

[[page]]

Huawei n'arrive pas les poches vides sur le marché du cloud. « 10 000 personnes dans la Silicon Valley à Santa Clara, en Europe et en Chine travaillent à l'intégration de notre offre cloud privé avec l'écosystème et les partenaires », indique Catherine Hu. 55 300 employés sur un total de 120 000, soit près de 44%, travaillent ainsi à la R&D du chinois. Ce cloud repose sur quatre fonctions clefs : virtualisation, automatisation, distribution et parallélisme. En Europe, Huawei travaille déjà avec Deutsche Telekom et sa filiale T-System sur le sujet. « L'année prochaine, un de nos clients européens pourra témoigner de son expérience », confie encore Catherine Hu. A la question de savoir pourquoi Huawei serait mieux placé qu'un autre pour démarrer un cloud privé, la responsable répond sans détour que « nous n'avons pas seulement du matériel ou du logiciel, nous apportons une plate-forme cloud complète ». Il s'agit ici encore d'une question de confiance et c'est ce qui est le plus long à construire.

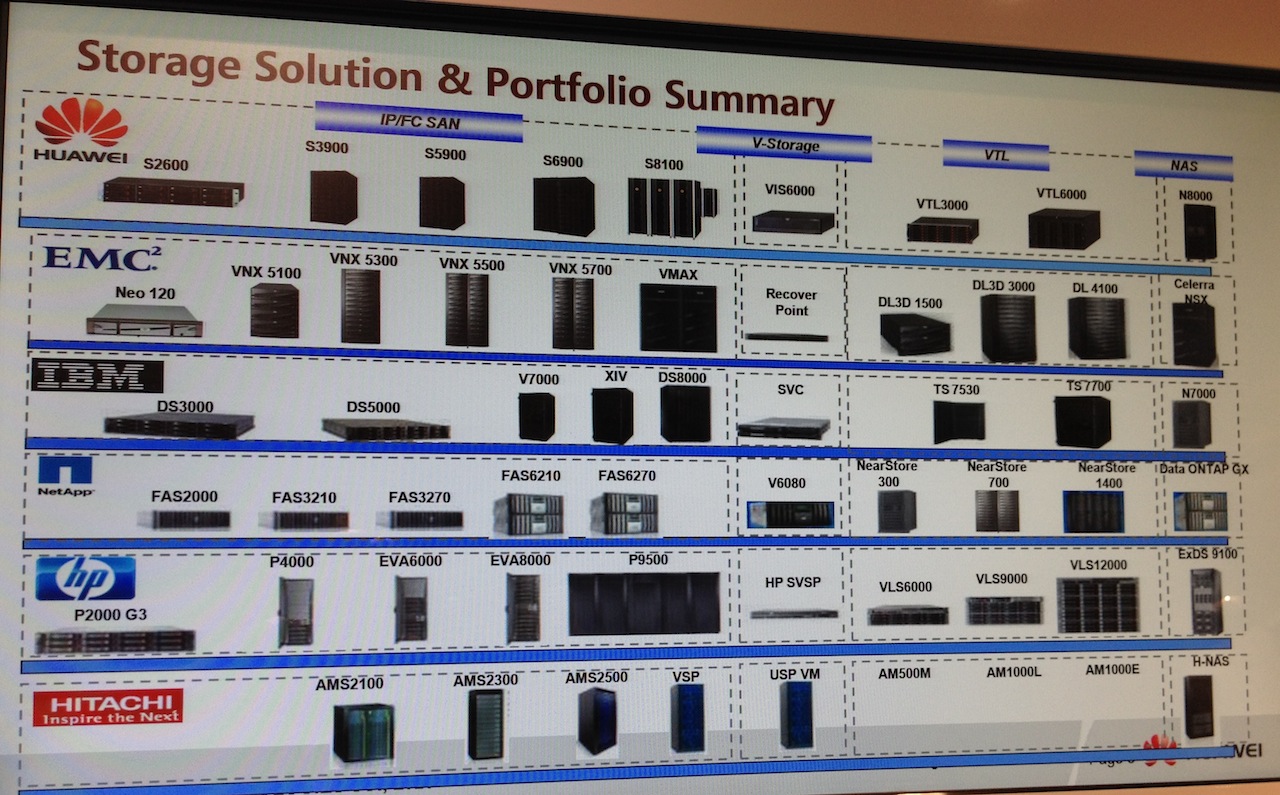

« Par nos succès européens avec les opérateurs, nous pensons avoir les atouts pour percer sur le marché avec nos solutions cloud. Le cloud computing est une opportunité de revoir l'informatique dans les entreprises, voilà pourquoi nous poussons nos solutions aujourd'hui. » Mais le cloud chez Huawei passe également par une offre stockage baptisée CloudStor. Cette solution qui propose stockage et sauvegarde en ligne repose sur des produits maison. En sus des serveurs, Huawei propose en effet une ligne stockage complète avec SAN (les S3900 et S5900), NAS (N8000), bandes (VTL 3000 et 6000) et plate-forme de virtualisation (VIS-6000). Le chinois se mesure d'ores et déjà à IBM, EMC, HP, Hitachi ou NetApp comme le souligne la présentation ci-dessous. Un marché fort disputé où les rachats récents n'ont pas fini de redistribuer les cartes. Nous verrons bien dans les mois qui viennent si Huawei réussit à placer ses solutions. (...)

(...)

Annuels HP : forte chute du bénéfice net sur le 4e trimestre

Empêtré dans ses problèmes de leadership et d'organisation, l'Américain Hewlett-Packard a subi une baisse de plus de 90% de son bénéfice net par rapport à l'an dernier, sur son quatrième fiscal clos fin octobre. Celui-ci s'établit à 200 millions de dollars contre 2,5 milliards de dollars sur le quatrième trimestre 2010, avec un bénéfice par action de 0,12 dollar (-89%).

Le chiffre d'affaires du trimestre a reculé de 3% à 32,1 milliards par rapport à 2010.

Il y a trois semaines, le PDG du groupe, Meg Whitman, qui a repris la tête de la société à la suite du départ de Léo Apotheker, avait annoncé que HP garderait son activité PC (moins rentable que d'autres domaines), après avoir étudié l'éventualité d'une scission de cette division.

Sur l'ensemble de son exercice fiscal, HP annonce un chiffre d'affaires GAAP de 127,2 milliards de dollars, en hausse de 1% par rapport à l'année 2010 (126 Md$). Sa marge opérationnelle a baissé de 1,5 point sur un an, à 7,6%. Quant à son bénéfice net annuel, il a reculé de 19% à 7,1 Md$ (contre 8,8 Md$ l'an dernier).

Une activité Services en légère hausse à 9,3 Md$

Sur le quatrième trimestre fiscal de HP, c'est l'activité Logiciels qui enregistre les meilleurs résultats, avec une progression de 28% sur les ventes de licences et de services associés, entre début août et fin octobre 2011. Mais cette division ne pèse que 976 millions de dollars de chiffre d'affaires, soit moins de 3% des 32,1 Md$ engrangés au total par le groupe sur le trimestre. Les revenus de la division Services financiers affichent également une progression à deux chiffres (+18%), mais là aussi sur un chiffre d'affaires inférieur à 1 Md$ (952 M$).

En revanche, la division Services n'a augmenté que de 2%, à 9,3 milliards de dollars sur le trimestre. Les ventes de l'activité Serveurs d'entreprise/Stockage/Réseau ont baissé de 4% par rapport à l'an dernier, à 5,6 Md$, tandis que celles de la division Imagerie et impression ont subi un recul de 10% sur un an, à 6,3 Md$ (avec une marge opérationnelle de 12,8%). Enfin, la division PSG (Personal Systems Group), qui a fait couler tant d'encre depuis cet été, n'a finalement reculé que de 2%, à 10,1 milliards de dollars.

Les investisseurs semblent enclins à envisager un peu de stabilité chez HP après la valse des dirigeants à la tête du groupe. Meg Whitman, sans doute mieux connue pour avoir été PDG du site d'enchères en ligne eBay, a remplacé Léo Apotheker qui était à ce poste depuis moins d'un an après avoir pris la suite de Mark Hurd, remercié en août 2010.

Pendant la direction de Léo Apotheker, HP avait décidé d'arrêter de produire des smartphones et des tablettes numériques basées sur le système d'exploitation WebOS, acquis avec le rachat de Palm. Dans la foulée, le groupe avait suscité une ruée sur sa tablette TouchPad lorsqu'elle fut bradée pour écouler les stocks. On attend maintenant de savoir ce qu'HP a décidé de faire de WebOS. Le groupe a entre temps expliqué qu'il miserait sur Windows 8 pour ses prochaines tablettes et PC.

Affaire Itanium : Selon Oracle, HP a payé Intel pour maintenir le processeur

Oracle pense que Hewlett-Packard a conclu secrètement un accord avec Intel pour que ce dernier continue à fabriquer des processeurs Itanium. Ceci afin qu'HP puisse maintenir l'apparence « qu'un microprocesseur mort est toujours vivant » et continue à engranger des revenus sur « sa base de clients Itanium verrouillée », tout en empêchant Oracle de réaliser des ventes sur ses serveurs Sun. C'est ce que l'éditeur de Redwood a exprimé dans un document adressé au tribunal vendredi dernier, dans le cadre de la bataille juridique qui l'oppose à HP. Ce dernier reproche en effet au groupe de Larry Ellison d'avoir abandonné ses développements de logiciels pour les systèmes à base d'Itanium.

Selon Oracle, le marché n'a jamais été informé que le processeur Itanium perdurait parce que HP payait Intel pour le maintenir. Dans le document qu'il a transmis vendredi dernier, l'éditeur estime qu'Intel aurait sinon arrêté de lui-même le processeur Itanium il y a des années.

HP considère qu'il s'agit là, de la part d'Oracle, « d'une tactique dilatoire désespérée visant à étendre l'incertitude paralysante sur le marché » qui, selon lui, a été générée lorsque l'éditeur a annoncé en mars 2011, par rupture de contrat, « qu'il ne supporterait plus la plateforme Itanium d'HP ».

Intel ne fait aucun commentaire

Une version du document adressé par Oracle à la cour est accessible sur un blog d'AllThingsD (du Wall Street Journal). On peut encore y lire que les déclarations faites au marché par HP avaient pour effet de laisser penser que l'engagement d'Intel envers l'Itanium était de son propre fait, et qu'il reposait sur les estimations normales d'investissement dans les processeurs ayant de l'avenir. Il ajoute que bien que tout en gardant l'accord secret, HP a révélé dans un document qu'il avait avec Intel un engagement contractuel par lequel l'Itanium serait poursuivi sur les deux prochaines générations de processeurs.

Intel a indiqué par mail (à nos confrères d'IDG News Service) qu'il n'était pas partie prenante de ce procès et qu'il n'avait pas conséquent aucun commentaire à faire à son sujet. En ajoutant qu'il ne faisait pas non plus de remarques sur les accords commerciaux qu'il pourrait avoir ou ne pas avoir avec ses clients.

En résumé, Oracle pense que la stratégie d'HP était de l'empêcher des vendre des serveurs issus de l'offre Sun, société qu'il a racheté en 2010. L'éditeur de Redwood considère que HP a voulu conserver des revenus lucratifs provenant de sa base de clients Itanium, dans la mesure où il récupère peu de contrats de service avec des OS comme Linux fonctionnant sur processeurs x86.

En juin dernier, HP a intenté un procès à Oracle pour avoir décider d'arrêter de développer des logiciels pour l'Itanium, processeur qu'il utilise dans ses serveurs haut de gamme, estimant que cette décision entrait en violation des engagements faits envers HP et envers les 140 000 clients communs aux deux sociétés.

Illustration : Première page du document adressé par Oracle au tribunal (crédit : D.R. / Montage LMI) (...)

Intel célèbre le 40e anniversaire de sa puce 4004

Annoncée au monde dans le numéro d'Electronic News daté du 15 novembre 1971, la célébrité de la puce Intel 4004, petit processeur à architecture 4-bits atteignant une fréquence de 108 kHz, repose surtout sur le fait qu'il a été le premier microprocesseur à être commercialisé.

Intégrant 2300 transistors (les microprocesseurs en ont aujourd'hui jusqu'à 1 milliard), ses concepteurs, Martian Hoff (surnommé Ted Hoff) et Federico Faggin, étaient absolument convaincus que le 4004 transformerait le marché dans un secteur dominé par un produit, à l'époque très prisé, les calculatrices électroniques de bureau. Et ils ont eu raison. Certains se sont gentiment moqués des prévisions des deux ingénieurs d'Intel : à l'époque, l'Amérique était encore embourbée dans la guerre du Vietnam, et la priorité de créer une informatique personnelle abordable ne semblait pas peser grand-chose. Mais l'impact du 4004 vient aussi de l'entreprise à l'origine du projet : Intel.

Une activité annexe pour Intel à l'époque

Intel - créée en 1968, soit trois ans seulement avant le lancement du processeur 4004 - n'a plus besoin d'être présentée. Pourtant, l'entreprise ne doit son existence qu'à un événement commercial fortuit. Busicom, un important fabricant japonais de calculatrices, a demandé à Intel de développer des circuits intégrés dont elle avait conçu l'architecture. Après étude du projet à 12 circuits proposé par les ingénieurs de Busicom, Ted Hoff, chef de projets chez Intel, a imaginé une solution à 4 circuits, dont un circuit central, le 4004. A l'époque, Busicom possédait les droits exclusifs sur le processeur. Mais, en contrepartie d'un prix inférieur à l'unité, le fabricant a accepté de renoncer à certains droits sur la conception. C'est ainsi que le géant américain a mis la main, si ce n'est sur une grande source de revenus, au moins sur une part importante de la propriété intellectuelle de la puce. Busicom a, par la suite, fait faillite.

Des années plus tard, la pression aidant, Intel a conservé son activité sur les puces mémoire mais a décidé de s'investir plus sérieusement dans les microprocesseurs. Quand IBM est arrivé en 1981 avec son PC d'entreprise, l'activité marginale démarrée avec le 4004 est brusquement devenue son coeur de métier.

Un composant devenu clef aujourd'hui

Le microprocesseur est considéré aujourd'hui comme le composant le plus important de l'industrialisation informatique, juste derrière le transistor. Surtout, il a apporté la pièce qui a permis de mettre de l'électronique bon marché dans n'importe quel appareil, du PC jusqu'aux automobiles.

Si dans certains ouvrages savants et bien documentés, la puce 4004 n'est pas créditée comme étant le premier microprocesseur, c'est le premier à avoir été commercialisé. Et, pour certains, c'est ce qui compte. Ce qui est sûr, même si tout le monde s'en moque aujourd'hui, c'est que le 4004 a permis à Busicom de vendre - à un prix élevé - une quantité énorme de calculatrices de bureau.

(...)(17/11/2011 17:11:18)Oracle livre un Solaris 11 prêt pour le cloud

Oracle vient de mettre à jour son système d'exploitation Solaris. L'éditeur a notamment ajouté plusieurs fonctionnalités qui rendraient l'OS plus apte à faire du déploiement dans le cloud. Mais son système Unix profiterait aussi d'une meilleure intégration avec les autres produits Oracle, comme l'a annoncé l'entreprise.

« Nous avons pris en compte certains besoins exprimés par nos clients et leurs difficultés à effectuer des déploiements dans des clouds privés ou publics, » a déclaré Charlie Boyle, directeur senior du marketing produit. « Cette version permet de prendre en charge des tâches complexes en infrastructure cloud, et d'exécuter n'importe quelle application Solaris en environnement cloud. » Comme l'a fait remarquer Markus Flierl, vice-président du développement logiciel chez Oracle, « les déploiements dans le cloud exigent des niveaux d'automatisation et de rationalisation beaucoup plus avancés que ceux d'un environnement informatique standard. » Une entreprise peut utiliser des centaines de serveurs Solaris. Mais quand elle déplace ses applications vers une infrastructure cloud, elle peut les faire tourner sur des milliers d'instances virtuelles Solaris.

Des partitions baptisées Zones

Solaris est une implémentation d'Unix initialement développée par Sun Microsystems, une entreprise acquise par Oracle l'année dernière. Moins connue pour ses solutions logicielles pour le cloud, Oracle a axé sa promotion de Solaris en le présentant comme un système d'exploitation convivial pour le cloud. Dans l'architecture d'Oracle, les utilisateurs peuvent configurer différentes partitions, appelées Zones, dans une implémentation Solaris. Ce mode de fonctionnement devrait permettre de traiter différentes charges de travail simultanément, chacune dans leur propre environnement, sur une seule machine. Selon la documentation marketing d'Oracle, Solaris Zones demande 15 fois moins de ressources qu'une implémentation VMware. L'éditeur fait également valoir que ces Zones n'auraient pas de limitations artificielles en terme de ressources mémoire, réseau, CPU ou stockage.

Selon le VP du développement logiciel d'Oracle, « de nombreuses fonctionnalités ont été conçues pour faciliter l'administration d'infrastructures cloud. Parmi elles, une fonctionnalité, appelée Fast Reboot, va permettre de redémarrer le système en passant les habituels contrôles matériels. Selon Oracle, cette fonction pourrait réduire le temps de démarrage du système de deux fois et demi. Cela peut s'avérer très utile pour un administrateur, lors de l'application de patchs ou de mises à jour logicielles, pour redémarrer plus rapidement des milliers VM Solaris. « Cette fonction permet de mettre à niveau la totalité de l'environnement en toute sécurité, » a déclaré Markus Flierl. Solaris s'enrichit également d'un nouveau logiciel de gestion système, appelé Image Packaging System, qui garde la trace des dépendances, des bibliothèques et autres logiciels dont le programme a besoin pour fonctionner. L'Image Packaging System conserve tous ces groupes logiciels dans une image système à jour, y compris celles en environnement virtuel.

[[page]]

Parmi les autres fonctionnalités de Solaris pour le cloud computing, on trouve de nouveaux contrôles administrateur pour verrouiller les paramètres dans les Zones individuelles. Les modifications que les utilisateurs ont la possibilité d'effectuer au niveau du fichier système ou des paramètres réseaux, peuvent être limitées. De même, l'administrateur peut également fixer la quantité de bande passante disponible pour chaque Zone. Enfin, cette version de l'OS est aussi la première qui permet aux utilisateurs de virtualiser les ressources réseaux, ce qui signifie que, avec des cartes réseaux compatibles, il est possible de diriger le trafic vers d'autres machines virtuelles, sans solliciter le CPU du serveur lui-même.

En plus de ces ajouts pour rendre Solaris plus adapté au cloud computing, Oracle a également restructuré certains de ses produits afin qu'ils puissent mieux travailler avec son OS. En particulier Database 11g, Fusion Middleware 11g et le pack logiciel d'administration Enterprise Manager Ops Center. « La possibilité pour une entreprise de contrôler une pile logicielle complète lui permet de prendre des décisions holistiques , par exemple savoir quelle partie de la pile il vaut mieux ajuster pour obtenir des gains de performance, » a déclaré Markus Flierl.

Solaris 11 est conforme aux spécifications de l'Open Group pour les implémentations Unix, et supporte donc tout programme écrit pour des versions antérieures de Solaris, jusqu'à la version 6. Oracle répond aussi à son programme Oracle Solaris Binary Application Program, lequel certifie plus de 11 000 applications en mesure de tourner sur Solaris 6.

Solaris 11 tourne à la fois sur processeurs x86 et sur les puces Sparc d'Oracle.

(...)(17/11/2011 17:19:43)Supercalculateurs : Bull renforce l'efficacité énergétique des bullx

Sur le terrain du calcul haute performance, Bull redouble d'efforts pour améliorer l'efficacité énergétique de ses supercalculateurs. Le constructeur national vient d'annoncer pour le deuxième trimestre 2012 le premier modèle de sa série bullx B700 DLC, pour Direct Liquid Cooling. Celui-ci recevra des lames double largeur équipées des futurs processeurs Xeon E5 (architecture Sandy Bridge) d'Intel. Bull indique que ce système est capable d'évacuer beaucoup plus de calories qu'un serveur lame classique (jusqu'à 80 kW par rack contre 40 kW actuellement), ce qui lui permettra aussi d'intégrer les prochaines générations d'accélérateurs de calcul (GPU) ou de processeurs MIC (many integrated core) d'Intel, multi coeur, ultra denses.

Le groupe français a par ailleurs annoncé sa série de lames de calcul bullx B510, destinée à des systèmes de quelques noeuds de calcul jusqu'aux HPC multi-pétaflopiques. Il indique que celles-ci ont déjà été retenues pour le supercalculateur Curie installé au centre TGCC, en France, ainsi que pour le système Helios pour F4E, à Rokkasho, au Japon, dans le cadre du projet ITER du CEA. Basée sur des noeuds de calcul bi-socket regroupés par paire sur une lame, la série bullx B510 offre une puissance en crête supérieure à 37 Tflops par rack. Elle s'appuie sur des processeurs Xeon E5 d'Intel, avec une capacité mémoire pouvant aller jusqu'à 256 Go par lame. L'interconnexion entre les noeuds est assurée par des liens InfiniBand QDR ou FDR. Les lames bullx B510 seront commercialisées de façon générale au premier trimestre 2012, lorsque les processeurs Xeon E5 seront disponibles.

Le châssis bullx 7U reçoit 9 lames doubles, soit 18 noeuds de calcul (crédit photo : Bull)

Un circuit d'eau à température ambiante

Pour réduire l'énergie consommée par ses systèmes, Bull utilisait déjà la technologie de porte froide. Avec la technologie DLC, ses équipes de R&D ont tablé sur un principe de refroidissement qui évacue la chaleur par un liquide situé au plus près des composants qui la génèrent. « Le refroidissement s'effectue à l'intérieur de la lame, par contact direct entre les composants chauds (processeurs, mémoires...) et une plaque froide dans laquelle circule un liquide caloporteur », explique le constructeur dans un communiqué. Dans la mesure où les processeurs fonctionnent à plus de 50° et les disques SSD à plus de 40°, un circuit d'eau à température ambiante suffit pour assurer le refroidissement. Le système peut donc être raccordé au circuit d'eau du site. En évitant de devoir produire de l'eau froide, on réduit d'autant la consommation électrique.

Un indicateur PUE réduit à 1,1

L'ensemble de ces dispositifs permet d'atteindre pour le système un indicateur d'efficacité énergétique (PUE*) de 1,1 dans des conditions normales d'utilisation, contre 1,8 pour les datacenters qui doivent recourir à d'autres équipements électriques, en particulier des climatiseurs. Bull précise en outre que ces serveurs présentent un niveau sonore très inférieur à celui des systèmes refroidis par air.

L'armoire bullx DLC a une capacité de montage de 42U (202 x 60 x 120 cm). Ses châssis 7U peuvent contenir 9 lames doubles, soit 18 noeuds de calcul. Le bullx B710 DLC fonctionne sous Red Hat Enterprise Linux et la suite bullx supercomputer.

(*) Le PUE (power usage effectiveness) mesure le ratio entre l'énergie consommé par l'ensemble de l'installation et l'énergie réellement consommée par les serveurs, établie à 1.

Illustration : bullx (crédit : Bull)

SC11 : Les futurs HPC exaflopiques doivent réduire leur consommation

A la Supercomputing Conference 2011 (SC11) qui se tient à Seattle du 12 au 18 novembre, l'objectif de parvenir au calcul exaflopique (exascale en anglais) dans la décennie, semble presque obsessionnel. Cette puissance de calcul multiplie par 1000 tout ce qui existe dans ce domaine aujourd'hui. Pour la plupart d'entre nous, une perspective à huit ou neuf ans est de l'ordre du long terme. Mais à la SC11, l'horizon de la décennie est déjà en vu. Une partie de la pression vient du département Américain de l'Énergie (DOE), lequel s'est engagé à financer ces énormes systèmes. Cet été, le DOE avait déclaré aux industriels qu'il voulait disposer d'un système exaflopique autour de 2019-2020, et que celui-ci ne devait pas consommer plus de 20 MW. Depuis, le gouvernement étudie les propositions sur la manière d'y parvenir.

Pour ce qui est de l'exigence de consommation de 20 MW, il y a déjà le supercalculateur qu'IBM construit pour le Lawrence Livermore National Laboratory, un laboratoire du Département de l'Énergie. En terme de puissance, ce système sera capable d'atteindre les 20 pétaflops (20 millions de milliards d'opération par seconde). Ce sera l'un des plus grands supercalculateurs au monde, mais aussi l'un des plus économes en énergie. Sauf que l'année prochaine, date à laquelle il sera complètement achevé et opérationnel, il consommera toujours entre 7 à 8 MW, selon IBM. Comparativement, un système exaflopique fournit une puissance de calcul de 1 000 pétaflops (soit mille millions de milliards d'opérations en virgule flottante par seconde). « Le monde dans lequel nous vivons désormais nous impose des contraintes en terme d'énergie, » a déclaré Steve Scott, CTO en charge de l'activité Telsa au sein de Nvidia Corp. « Si bien que la performance que nous pouvons obtenir sur un puce est limitée, non pas par le nombre de transistors que nous pouvons y mettre, mais plutôt par sa consommation énergétique. »

Combiner CPU et GPU pour améliorer le rendement énergétique

Selon le CTO, l'informatique x86 est limitée par ses processus de traitement qui impliquent des surconsommations. Alors que les processeurs graphiques, GPU, peuvent fournir du débit avec très peu de surcharge, et en consommant moins d'énergie par opération. Nvidia a construit des systèmes de calcul haute performance HPC avec ses GPU et des CPU provenant souvent de chez AMD. Une autre approche hybride, impliquant un GPU et un CPU, commence à se retrouver avec des processeurs ARM, un type de puce largement répandu dans les smartphones et les tablettes. Steve Scott pense que l'objectif de 20 MW demandé par le DOE peut être atteint en 2022. Mais si le programme exascale que veut lancer le gouvernement est accompagné par des financements, alors Nvidia pourrait mettre plus de ressources dans les circuits et les architectures. Dans ce cas, l'objectif pourrait être atteint en 2019. Selon le CTO de Nvidia, pour atteindre ce niveau d'efficacité, il faudra améliorer l'usage énergétique de 50 fois. Par ailleurs, si 20 MW semblent une puissance encore élevée, Steve Scott fait remarquer que les installations de cloud computing nécessitent jusqu'à 100 MW pour fonctionner.

Rajeeb Hazra, directeur général de l'activité Technical Computing chez Intel, avait déclaré que le fondeur comptait satisfaire aux exigences d'un exascale à 20 MW d'ici 2018, soit avec un an d'avance sur les attentes du gouvernement américain. Celui-ci avait apporté cette précision lors de l'annonce du processeur 50 coeurs Knights Corner, capable de fournir une puissance soutenue de 1 téraflop. Alors que les fabricants de matériel doivent résoudre des questions liées à la consommation d'énergie et à la performance, l'exaflopique, comme l'informatique pétaflopique, confronte les utilisateurs HPC à des défis de mise à l'échelle des codes, nécessaires pour utiliser ces systèmes à leur pleine capacité. Avant l'exascale, les fabricants vont produire des systèmes de l'ordre de la centaine de pétaflops, comme IBM, par exemple, qui affirme que son nouveau système Blue Gene/Q fournira une puissance de 100 pétaflops.

Pour l'heure, Kim Cupps, chef de la division informatique et directeur du projet Séquoia au Lawrence Livermore, se dit comblé, avec son système de 20 pétaflops à venir. « Nous sommes ravis d'avoir bientôt cette machine, » a t-il déclaré. « Grâce à ce système, nous allons résoudre de nombreux problèmes d'importance nationale, qui ce soit dans le domaine de la modélisation des matériaux, l'armement, le changement climatique et l'énergie.» Quant à l'annonce par IBM d'un système à 100 pétaflops. « C'est IBM qui le dit ! Je me porte garant pour 20 pétaflops ! » a t-il répondu.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |