Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 181 à 190.

| < Les 10 documents précédents | Les 10 documents suivants > |

(17/11/2011 14:19:09)

Aerohive simplifie et sécurise les connexions sans fil des succursales

Aerohive a présenté une offre à destination des petites structures, succursales ou télétravailleur, nommée « Branch on demand ». Elle comprend une paire de routeurs WiFi, avec en option la connectivité 3G/4G WAN, un service cloud de terminaison VPN s'exécutant sur VMware et la capacité d'intégrer des offres de sécurité du cloud proposées par Websense (filtrage anti-malware, inspection du trafic SSL) et Baracuda. Le résultat, selon les dirigeants d'entreprise, est une couche réseau de niveau 3 complète avec DHCP en local et des services DNS, via le « proxy cloud » d'Areohive.

Aerohive propose ainsi deux routeurs pour les succursales. Le premier a être commercialisé sera le BR100, un routeur low cost fonctionnant en 2,4 GHz et compatible avec le standard 801.11n. Il comprend 5 ports Fast Ethernet et un port USB et intègre en option la connectivité 3G/4G. Les prix commencent à 99 $ par année par site et sera disponible à la mi-décembre. Le BR200 est un routeur haut de gamme comprenant un port USB pour une option 3G/4G WAN, mais il offre des antennes radio 3x3 MIMO (Multiple in-Multiple out) qui peuvent fonctionner soit en 2,4 GHz ou 5 GHz, 5 ports Gigabit Ethernet, dont deux sont en PoE. Le BR200 sera disponible au « début 2012 » pour un prix non encore annoncé.

Les deux routeurs fonctionneront sur la version 5.0 de HiveOS. Elle intègre notamment différentes fonctionnalités cloud comme les terminaisons VPN ou la gestion des des WLAN avec une version rénovée de HiveManager 5.0. Une fois l'installation faite, les administrateurs IT peuvent suivre l'identité des utilisateurs et le type d'appareil utilisé, les autorisations attribuées automatiquement, les paramètres réseaux au sein des succursales. Le tout est géré par HiveManager via une page web, contrôle et modification à distance des routeurs et des points d'accès.

Un gain de temps dans la prise en charge des VPN

Par ailleurs, l'offre « Branch on demand » comprend Cloud VPN Gateway (CVG) est une application logicielle pour la terminaison VPN. Elle est conçue pour fonctionner sur des serveurs virtuels sous VMware, de sorte qu'elle peut rapidement évoluer pour gérer de nombreux clients. Une fois les routeurs branchés, un tunnel est automatiquement établi vers le CVG.

« Une constante des difficultés avec les VPN quand on a de nombreux sites, en particulier des bureaux distants, est la nécessité d'allouer et de mapper des adresses IP et des sous-réseaux en configurant des routes pour garder le trafic en local, tandis que le tunneling oriente les autres trafics vers le VPN » , explique Lisa Phifer, consultante en réseaux chez Core Competence . « De ce que j'ai vu dans la démo Aerohive, ils auto-génèrent les sous-réseaux et le routage à partir de simples curseurs comme, par exemple,« J'ai 10 utilisateurs au bureau X ». Cela pourrait être un gain de temps énorme si vous avez des centaines ou des milliers de bureaux à traiter », ajoute la consultante.

(...)

Dell, HP et IBM annoncent leurs serveurs Opteron 6200

Dell, HP et IBM, soit les 3 principaux fournisseurs de serveurs, ont fait part de leur intention de proposer des machines exploitant les Opteron 6200 d'AMD qui repoussent les limites du genre avec pas moins de 16 coeurs par processeur. Également connues sous le nom de code Interlagos, ces puces sont de 25 à 30% plus rapides que les précédentes (Opteron 6100 avec 12 coeurs) selon le fondeur de Sunnyvale.

Un plus grand nombre de coeurs sur les puces d'AMD pourrait apporter plus de performances aux serveurs avec certaines applications tout contribuant à la réduction de la consommation d'énergie, a déclaré Dan Olds, analyste chez Gabriel Consulting Group.

Des puces pour les bulles virtuelles

Les serveurs animés par ces processeurs travailleront plus vite dans les environnements fortement virtualisés accueillant des bases de données et calcul haute performance, a précisé M.Olds. Plus de coeurs sur les serveurs offrent une plus grande granularité dans la répartition des charges de travail et contribuent également à la consolidation des plates-formes serveurs dans un centre de calcul. «AMD a augmenté de manière plus significative qu'Intel le nombre de coeurs et ils offrent une certaine parité en milieu et haut de gamme » a déclaré Olds. Pour l'instant, Intel ne propose que 10 coeurs max sur ses puces serveur Xeon.

Si les processeurs Intel fournissent de meilleures performances brutes, AMD propose une meilleure réactivité avec sa puce, selon l'analyste. Alors que les entreprises cherchent à réduire leurs coûts, AMD offre de meilleures performances par watt avec ses dernières puces par rapport à celles d'Intel. Les Opteron 6200 puces sont basées sur une nouvelle micro-architecture processeur baptisée Bulldozer (voir détails sur la plate-forme).

5 serveurs attendus chez HP

HP a introduit pas moins de cinq serveurs ProLiant G7 avec des puces AMD Opteron 6200. On peut ainsi monter jusqu'à 2048 coeurs par rack, soit 33% en plus par rapport à la génération précédente, a indiqué le constructeur. Ces machines amélioreraient leurs performances de 35 % pour l'exécution de certaines applications. Ces serveurs seront disponibles à partir du 29 novembre aux États-Unis aux prix suivants : à partir de 2 679 $ pour le BL465c, 9 559 $ pour le BL685c, 3699 $ pour le DL385, 6309 $ pour le DL585 et 1 559 $ pour le DL165.

De son coté, IBM mettra à jour son serveur System x 3755 M3 en rack avec ces puces, a déclaré Jim Smith, un porte-parole d'IBM. La plate-forme sera probablement disponible dans le courant décembre. Reposant sur une carte mère quatre sockets, ce serveur se destine aux environnements virtualisés ou aux applications intensives comme les bases de données, a déclaré le speaker d'IBM. Avec ses 16 coeurs, cette machine est également une option pour ceux qui veulent des serveurs haute performance à un prix abordable. Signalons enfin que l'x 3755 M3 est le seul serveur d'IBM sur base AMD. Les mesures de performances de cette machine seront publiées très bientôt selon M.Smith.

Si Dell va également mettre à jour ses serveurs avec les dernières puces d'AMD, aucun communiqué n'a été publié à ce jour. On sait juste que le PowerEdge 815 passera de 48 à 64 coeurs avec les Opteron 6200.

Cray et Amax poussent la puce sur le HPC

Dans les prochaines semaines, ces processeurs seront également disponibles dans les serveurs d'Acer et de Cray, a indiqué AMD. Avant la conférence SC11 à Seattle, Cray a précisé qu'il construisait un supercalculateur baptisé Blue Waters pour le compte du National Center for Supercomputing Aplications à l'Université de l'Illinois. Ce système aura 49 000 processeurs Opteron 6200 16 coeurs et fournira des performances en pointe de 11,5 Pétaflops. Rappelons que Cray a remplacé au pied levé IBM, qui avait initialement été contactée pour construire le système.

Toujours à l'occasion du SC11, un petit constructeur spécialisé dans le HPC, Amax, a montré deux serveurs - 1U et 2U - pouvant accueillir jusqu'à quatre processeurs 16 coeurs. La machine 1U, la HA-1402, peut accueillir jusqu'à quatre puces 16 coeurs dans son châssis, avec trois disques durs dans les emplacements 3,5 pouces. Le HA-2403 au format 2U possède un peu plus d'espace pour le stockage et peut accueillir en sus des unités SSD.

Intel dévoile sa puce HPC Knight Corner avec 50 coeurs (MAJ)

A l'occasion de la conférence SC11 (SuperComputing) à Seattle, Intel a montré pour la première fois sa puce connue sous le nom de code Knight Corner, qui comprend plus de 50 coeurs pour gérer des calculs haute performance. Le fondeur a aussi parlé de ses puces serveurs Xeon E5 qui vont bientôt arriver et sont basées sur la microarchitecture Sandy Bridge. Il a été question du processeur E5-2600 qui offre le double de performance par rapport à la puce serveur Xeon 5600 basée sur l'architecture Westmere, précise Joe Curley, directeur du marketing au sein du technical computing group chez Intel.

Les deux puces seront jumelées au sein d'un superordinateur appelé Stampede et qui sera déployé en 2013 au Texas Advanced Computing Center de l'Université du Texas. Le supercalculateur disposera d'une performance de 10 pétaflops (10 millions de milliards d'opération par seconde). Les processeurs E5 assumeront 20% de la performance du supercalculateur, tandis que les puces Knight Corner contribueront aux 80% restant, soit environ 8 Pétaflops.Une puce confrontée à une forte concurrence

La puce Knight Corner combine des coeurs de processeurs standards x86 avec des coeurs spécialisés pour accélérer le calcul en parallèle. Intel précise que sa puce est la première à atteindre 1 téraflop en double précision (64 bits), ce qui donnera des résultats plus exacts. Gravée en 22 nanomètres, ce composant est un élément important dans stratégie d'Intel pour atteindre l'exascale computing en 2018, souligne Joe Curley. Ce concept informatique est un point essentiel dans plusieurs domaines, la médecine, la défense, l'énergie, etc. Des pays comme le Japon, la Chine et les Etats-Unis sont engagés dans une compétition pour arriver à des supercalculateurs atteignant l'exaflop. Cependant, les contraintes de conception et une importante consommation énergétique ont limité le développement des projets exaflopiques.

La puce Knight Corner repose sur l'architecture MIC (many integrated core), qui s'insère dans un emplacement PCI-Express. Cette architecture est considérée comme un accélérateur dans la même veine que les processeurs graphiques utilisés par les concurrents comme AMD ou Nvidia mais sans recourir à des technologies dédiées comme CUDA. Joe Curley indique que « MIC est une rupture dans les calculs parallélisés au sein des architectures de processeurs traditionnels, car vous pouvez réutiliser une grande partie du code. S'il faut modifier l'ensemble du code, votre système sera plus difficile à utiliser ». Sensible aux critiques portant sur la complexité de CUDA pour utiliser les GPU en calcul intensif, Nvidia a réussi à contourner ce problème en exploitant des directives, qui sont des « astuces » que les développeurs intégrent dans un compilateur pour identifier les zones où le code doit être accéléré. Le fondeur a annoncé cette semaine OpenACC, un standard ouvert pour la programmation des directives. Cette initiative est soutenue par plusieurs entreprises dont le constructeur de superordinateur Cray.

(...)(16/11/2011 11:48:02)

10 ou 20 To en flash sur les cartes ioDrive Octal de Fusion-IO

Fusion-IO a annoncé l'augmentation de la capacité de sa carte PCIe ioDrive Octal à 10 To et à 20 To pour serveur 1U. La version 10 To de l'ioDrive Octal repose sur 8 modules ioMemory (essentiellement DIMM) de 1,28 To en MLC (Multi-Level Cell). Cette carte peut atteindre plus de 1,3 million d'E / S par seconde (IOPS) avec un débit de 6.7Gbit/s. Fusion-io a déclaré que son produit est optimisée pour des environnements exigeants tels que l'entreposage de données, les infrastructures haute disponibilité, les supercalculateurs et les applications de recherche. Comme les autres sociétés proposant des cartes PCIe avec mémoire flash, l'ioDrive Octal intègre à la fois de la mémoire (DIMM) non volatile, à l'inverse de la DRAM qui est volatile. EMC travaille sur le sujet des cartes PCIe Flash, via son projet Lightning. Pat Gelsinger, directeur général d'EMC, n'a pas désigné le partenaire technologique sur ce sujet, mais des sociétés comme Intel ont été pressenties.

Des appliances personnalisées en préparation

« Les entrepôts de données d'une capacité de 10 To à 20 To ne sont pas rares. Si c'est votre cas, c'est la taille que propose les appliances avec de la flash aujourd'hui » a déclaré Ruck White, co-fondateur et directeur du marketing chez Fusion-IO « Cela ouvre un nouveau marché pour nous. »

« Il y a seulement une poignée d'appels I/O que vous pouvez utiliser. On peut lire, écrire et ajouter, cela n'a pas changé dans les dernières décennies. Ce que nous faisons, c'est de mettre une petite extension entre la mémoire et de stockage, qui donne une interface mémoire au stockage. Nous émulons du stockage » explique Ruck White. Comme la ioDrive Octal 10To offre maintenant une capacité similaire à la mémoire de nombreuses baies de stockage, elle permet aux partenaires de Fusion-IO, ainsi qu'aux membres de son programme d'alliance technologique de créer des appliances personnalisées. « Auparavant, un serveur 4U pouvait contenir 10 ioDrive Duos pour une capacité totale de 20 To, mais maintenant jusqu'à quatre ioDrive Octals 10 To peuvent être intégrés dans un serveur 4U, tels que le HP ProLiant DL585 G7, offrant 40 To de capacité au total » conclu David Flynn, PDG de Fusion-IO.

La ioDrive Octal 10 To sera disponible au cours du premier trimestre 2012. La firme n'a pas communiqué les prix.

Eurocloud se penche sur le financement du cloud via une commission ad hoc

Avec l'aide de deux associés du cabinet KPMG, Eurocloud a mis sur pied une commission finances dont la première réunion se tiendra en fin de mois. Elle va traiter de sujets sensibles pour tous les éditeurs de taille moyenne. « Le succès de l'intervention de KPMG lors de nos derniers Etats Généraux montre que l'écosystème SaaS/cloud se pose des questions en matière de finances», souligne Henry-Michel Rozenblum, le délégué général d'Eurocloud.

La commission va sortir des Livre Blanc sur les finances du cloud et de ses acteurs. Des Livres Blancs rédigés par les membres de la commission. De nombreuses questions se posent déjà, par exemple : comment calculer un prix de vente de prestations en SaaS, les paramètres à prendre en compte dans sa facturation, la valorisation de l'entreprise, la trésorerie. Les experts de KPMG vont également apporter des précisions sur les prochaines normes européennes en préparation qui impacteront le SaaS.

La commission devrait aborder aussi des thèmes plus généraux, nous précise Henry-Michel Rozenblum, comme l'influence du SaaS sur le SI, ou le management d'une entreprise qui délivre du SaaS.

L'Espagne construit un supercalculateur avec des puces ARM 4 coeurs

Avec son prototype de supercalculateur construit autour de processeurs ARM quad-core, le Centro nacional de Supercomputación (CNS) espagnol, également connu sous le nom de Barcelona Supercomputing Center (BSC), veut apporter l'efficacité énergétique aux systèmes haute performance. Le serveur en question, conçu pour traiter des charges de travail complexes, intégrera des processeurs Nvidia Tegra 3 quad-core à1,4 GHz (nom de code Kal-El), des puces d'abord destinées aux smartphones et tablettes, et livrées par le fondeur au début novembre. Les 1 000 processeurs Tegra 3 seront jumelés avec de circuits graphiques Nvidia (architecture CUDA), pour accélérer les calculs scientifiques et mathématiques.

Le système pourrait offrir à ARM une porte d'entrée dans le marché de l'informatique haute performance, actuellement dominé par des concurrents comme Intel, AMD, IBM et Oracle. Si aujourd'hui on trouve des processeurs ARM dans la plupart des smartphones et tablettes, ceux-ci sont pratiquement absents du marché du serveur. Cependant, l'intérêt d'utiliser des puces ARM dans des serveurs ne cesse de croître : « ces processeurs offres des performances élevées et permettent de surmonter les contraintes énergétiques, » comme l'a déclaré Steve Scott, Chief Technology Officer de la division Tesla chez Nvidia. « Nous sommes très intéressés par l'entrée de ARM dans l'écosystème HPC, » a ajouté le CTO.

Un prototype censé concourir dans le Green500 seulement

« Le prototype de supercalculateur Tegra 3 ne délivrera pas les performances pétaflopiques de certains ordinateurs, parmi les plus rapides au monde, » a expliqué Steve Scott. Mais celui-ci pourrait entre dans la liste Green500, qui établit le classement des supercalculateurs les plus éco-énergétiques du monde. Nvidia n'a pas communiqué de chiffres sur les performances de la machine, ni indiqué le nombre de processeurs graphiques présents dans le supercomputer Tegra 3. Mais, « l'association de milliers de coeurs ARM avec des GPU permettra d'effectuer des calculs scientifiques complexes, tout en réduisant la consommation d'énergie et les coûts, » a précisé le CTO de Nvidia. Le BSC dispose déjà d'un serveur prototype ARM équipé de 256 puces Tegra 2 double coeur.

Grâce au processeur ARM, Nvidia élargit ses compétences dans le domaine des supercalculateurs, essentiellement concentrées autour de ses processeurs graphiques Tesla, utilisés dans des supercalculateurs pour effectuer des calculs complexes. Le supercalculateur que construit le laboratoire national d'Oak Ridge va coupler un GPU Tesla avec des CPU 16-core Opteron d'AMD pour une performance de 20 pétaflops. Il sera plus rapide que le K japonais, qui délivre une performance de 8 pétaflops et détient actuellement le titre d'ordinateur le plus rapide au monde, selon le classement établi par le Top500 au mois de juin.

Les initiatives serveur se multiplient autour d'ARM

Nvidia a également rejoint un petit groupe d'entreprises qui s'intéressent aux processeurs ARM comme alternative aux processeurs x86 d'Intel et d'AMD. Début novembre, Hewlett-Packard a annoncé qu'elle travaillait à la construction d'un serveur autour d'une puce de Calxeda qui intègre un processeur ARM quatre coeurs consomme à peine 1,5 watts. Si les processeurs ARM ne font pas faire le poids en terme de performances brutes avec des serveurs x86, les analystes pensent que l'agrégation de milliers de processeurs ARM pourrait offrir de meilleures performances par watt pour des charges de travail légères et demandant beaucoup de fluidité, comme le traitement de transactions volumineuses sur Internet.

Le prototype sur base Tegra fait parti d'un plan de développement, en grande partie financé par la Commission européenne, qui vise à faire montrer que des systèmes, capables d'offrir les performances de l'Exascale, consomment 15 à 30 fois moins d'énergie que les serveurs actuels. Le prototype Tegra 3 du BNS doit encore obtenir une validation finale, bien qu'il ait déjà été utilisé pour le développement de logiciels. Les spécifications du nouveau système seront établies l'année prochaine. Ce projet, appelé Mont-Blanc, est coordonné par le Barcelona Supercomputing Center et dispose d'un budget de plus de 14 millions d'euros.

[[page]]

Mais, comme tout nouveau venu sur le marché des serveurs, ARM a de nombreux défis à relever. En particulier, la plupart des logiciels serveur existants sont conçus pour tourner sur des puces x86, et il faudrait donc réécrire l'ensemble de ces logiciels pour leur permettre de fonctionner sur processeurs ARM. Ces derniers manquent aussi de fonctions de corrections d'erreurs et offrent un adressage 32 bits, ce qui limite le plafond de la mémoire à 4 Go. Malgré ces difficultés, Nvidia devait bien commencer quelque part. L'entreprise a choisi d'affirmer sa position de leader en mettant en avant les processeurs ARM dans les serveurs et supercalculateurs. « Ça ne va pas arriver du jour au lendemain, » a déclaré Steve Scott. « Cela va demander un certain nombre d'années. »

En attendant, Nvidia met au point un autre processeur sur base d'ARM, nom de code Project Denver, destiné aux smartphones, tablettes, PC et supercalculateurs. « Il n'est pas impossible que Nvidia intègre des coeurs ARM dans les produits Tesla à long terme, » a indiqué le CTO. « Nous allons considérer cette option et l'intégrer au bon moment », a ajouté Steve Scott. Récemment, ARM a également annoncé une architecture 64-bit, qui comporte de nombreuses fonctionnalités spécifiques au serveur. Cela va permettre à ARM de franchir une étape clé et rendre sa présence effective sur le marché du HPC. « Pour bien faire les choses, il faut une architecture 64 bits dans ce domaine, » a déclaré Steve Scott.

(...)(15/11/2011 14:51:58)Salesforce.com acquiert Model Metrics, spécialiste de la mobilité dans le cloud

Salesforce.com a annoncé l'acquisition de Model Metrics. Les termes financiers de l'acquisition n'ont pas été divulgués, mais l'éditeur s'attend à conclure la transaction dans son quatrième trimestre fiscal clos le 31 janvier.

Model Metrics est une entreprise basée à Chicago et comprend plus de 500 clients. Elle a réalisé plus de 1000 déploiements des solutions de Salesforce.com pour les entreprises de toutes tailles. Elle a indiqué en début de mois que 80% de ses clients ont des projets d'intégration des smartphones et tablettes dans leurs déploiements cloud. Ces projets de mobilité ont été multipliés par 6 en 2011 souligne Model Metrics. En conséquence, elle a étoffé son expertise sur le mobile en proposant des offres multi-plateforme. Ainsi, elle a développé des applications pour iPhone, iPad et quelques terminaux Android pour donner un accès hors-ligne aux données de Salesforce.com

(...)

CA World 2011 : CA Technologies propulse les applications dans le cloud

Une informatique en phase avec le rythme d'évolution de l'entreprise, « IT at the speed of business ». C'est le mot d'ordre de CA Technologies pour sa conférence CA World 2011 qui accueille 5 000 personnes à Las Vegas jusqu'au 15 novembre, clients et partenaires. « L'un des principaux problèmes pour un chef d'entreprise, c'est de voir ce qu'il veut faire et de ne pas pouvoir avancer assez vite, parfois à cause de l'informatique », a exprimé dimanche soir Bill McCracken, PDG de l'éditeur américain spécialisé dans les solutions de gestion du système d'information.

A sa suite, Vivek Kundra, premier DSI (CIO) de la Maison Blanche, de 2009 à 2011, a expliqué comment il avait taillé dans les dépenses informatiques du gouvernement américain en rationalisant les systèmes et en réduisant les duplications.

Vivek Kundra, ancien CIO de la Maison Blanche, sur CA World 2011 (crédit : M.G.)

A ce poste, il a expliqué avoir plaidé pour une politique axée d'abord sur le cloud, soulignant qu'il fallait repenser la façon dont les services étaient apportés au citoyen. Il a déploré les sommes investies dans des applications inopérantes, soulignant que les utilisateurs des services publics se souciaient moins du nombre de datacenters mis en oeuvre que du temps passé à faire la queue.

3 milliards de dollars

Ces deux dernières années, CA a déboursé 3 milliards de dollars pour acquérir diverses technologies (celles d'Oblicore de 3Tera, Nimsoft, 4Base, Hyperformix, ITKO, WatchMouse...) et développer les outils adaptés à un paysage IT où, désormais, l'existant doit cohabiter avec les clouds publics, privés ou hybrides. « Les nouvelles options accroissent la complexité et requièrent un autre modèle de gestion IT capable d'apporter des services à la demande », a poursuivi lundi matin David Dobson, vice-président exécutif de CA, numéro deux du groupe. CA décline sa stratégie en actions : modéliser les services IT, les assembler, les automatiser, en garantir la disponibilité et les sécuriser. Le tout en restant agnostique vis-à-vis des plateformes.

David Dobson, vice-président exécutif de CA Technologies (crédit : M.G.)

En regard de ces besoins, l'éditeur propose notamment CA AppLogic, une solution issue du rachat de 3Tera, pour déployer et gérer des applications dans le cloud. En amont, pour déterminer quelles applications peuvent migrer vers quel type de cloud, il avance maintenant CA Cloud 360, l'une des nouveautés de ce CA World. Pour améliorer la performance des services, que ceux-ci soient dans le cloud ou dans les environnements traditionnels, il apporte CA Business Service Insight (ex CA Oblicore Guarantee). Enfin, a rappelé David Dobson, CA Clarity PPM (Project Portfolio Management) fournit le cadre et les outils pour gérer le portefeuille de projets IT.

Trois mois pour porter un service dans le cloud

Dans le domaine du cloud, cette édition 2011 de CA World n'a pas été chiche en annonces. En premier lieu, CA Cloud 360 Intelligence Methodology fournit une approche normative pour aider les DSI à valider quelles applications peuvent être installées dans un cloud privé, conservées dans un environnement classique, ou encore celles qui sont adaptées à un cloud public ou éligibles à un environnement de cloud hybride. Un processus en quatre étapes qui associe plusieurs produits CA à l'intervention de consultants experts de la virtualisation et du cloud, pour la plupart issus des rangs de 4Base Technologies, acquis en 2010.

[[page]]

Face au modèle hybride et à la pression subie pour accélérer la mise à disposition des applications et services, la DSI se trouve confrontée à des choix difficiles, a exposé Andi Mann, vice-président, responsable des solutions Enterprise et Cloud chez CA Technologies. « Quel serait le coût d'une erreur ? », figure parmi les questions sensibles. La démarche CA Cloud 360 commence par la découverte et l'analyse du portefeuille d'applications, au cours d'un atelier d'une journée, suivi par une analyse approfondie conduite par CA. Les niveaux de service des applications sont ensuite définis, avant d'évaluer les ressources physiques et virtuelles nécessaires, puis de simuler le comportement de l'application cloud ou hybride en environnement de production. A chaque étape, CA recourt à l'une de ses offres : Cloud Services, Clarity PPM On Demand, Oblicore Guarantee On Demand, la suite Capacity Management and Reporting, Virtual Placement Manager et, pour la simulation, la suite CA Lisa, développée par ITKO (société rachetée en juin 2011). Cloud 360 permettrait, selon CA, de créer certains services cloud en trois mois.

Une place de marché sur Cloud Commons

Les annonces de CA World 2011 concernent par ailleurs l'écosystème Cloud Commons. Cette communauté de 3 000 membres, créée pour favoriser partage et collaboration, accueille tant les entreprises que les fournisseurs de services, les développeurs et les éditeurs de logiciels (ISV). Elle s'enrichit désormais d'une « place de marché » où il est possible d'acheter, de vendre ou de comparer des solutions cloud. « Nous y avons déjà plus de 25 services cloud et appliances disponibles, a indiqué Andi Mann, en assurant que le nombre de références allaient s'étendre rapidement. On peut aussi y acheter des produits CA tels que ARCserve, Service Desk Manager ou Oblicore Guarantee, configurés sous la forme d'appliances destinées à être exploitées dans des clouds mis en oeuvre avec AppLogic.

Pour les développeurs et les éditeurs indépendants, membres de la communauté, qui veulent collaborer autour de projets de logiciels pour le cloud, CA annonce aussi le Studio Cloud Commons Developer. Il permet de concevoir des solutions prêtes à tourner, sans coût, en cloud privé ou public en s'appuyant sur la plateforme AppLogic.

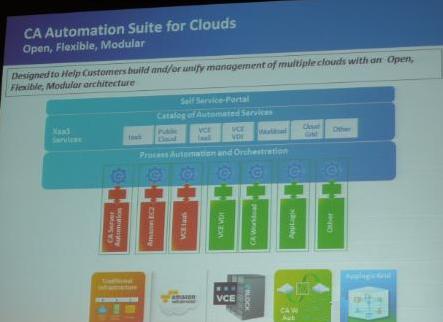

Déjà annoncé en juin dernier, CA Automation Suite for Clouds permet de faire évoluer les datacenters existants en déployant des services en cloud privé. La suite fournit des workflows pré-conçus pour mettre à disposition des infrastructures physiques et virtuelles, ainsi que des services applicatifs. Un système de tarification s'appuie sur un moteur de facturation et de reporting financier qui associe l'utilisation des services à des centres de coût, ou bien à des clients ou des utilisateurs.

CA Automation Suite for Clouds

Gestion des accès et des identités

Enfin, CA Technologies a ajouté deux services à ses solutions IAM as-a-service, destinées à gérer les identités et les accès dans le cloud. CA IdendityMinder as-a-service permet aux utilisateurs de gérer eux-mêmes certains éléments : ils peuvent réinitialiser les mots de passe, demander d'accéder à certaines ressources et gérer leur profil. Le logiciel peut donner autoriser les utilisateurs à accéder à des services disponible dans le cloud et sur site. L'autre produit, CA FedMinder as-a-service, permet de mettre en place un accès unique (SSO) entre des domaines sécurisés, à la fois dans le cloud et sur site. Il supporte SAML 1.1 et 2.0 et facilite la fédération avec des sites web partenaires. L'administrateur peut par ailleurs déterminer quelles sont les informations qu'il peut partager avec les partenaires et sous quelles conditions. La suite IAM comprend déjà deux autres logiciels que CA vient de renommer : CA AuthMinder as-a-service (anciennement CA Arcot A-OK for WebFort) et CA RiskMinder as-a-service (ex CA Arcot A-OK for RiskFort).

L'Europe veut se doter d'une plateforme technologique sur le HPC

Beaucoup d'acteurs industriels comme Allinea, ARM, Bull, CAPS entreprise, Eurotech, Partec, STMicroelectronics et Xyratex se sont associés à des organismes de recherches comme le BSC (Barcelona SuperComputer), le CEA, le CINECA, le Fraunhofer, Forschungszentrum Jülich et le LRZ HPC pour créer une plateforme technologique européenne.

L'objectif de l'ETP (European Technology Platform), selon les partenaires, est de définir les priorités de recherche en Europe pour développer une technologie européenne dans l'ensemble de la chaîne de valeur du HPC. Avec cette collaboration, ils souhaitent par ailleurs « renforcer la compétitivité européenne en matière de HPC, une capacité essentielle pour la recherche future et de l'innovation ». La gestion du parallélisme extrême dans des architectures HPC et la réduction de la consommation d'énergie sera deux domaines clés du programme européen.

Dans le cadre de l'initiative, le consortium qui se met en place sera ouvert à toutes les entreprises ou les personnes qui ont des activités européennes de R&D relatives au HPC. Un plan de recherches sera également présenté à la Commission européenne pour trouver des financements supplémentaires.

Cette opération rappelle l'initiative de la Chine de vouloir construire des supercalculateurs avec des puces chinoises.

Les AMD Opteron 6200 16 coeurs enfin livrés

Après plus d'un an de confidences, AMD a annoncé la disponibilité de sa puce Opteron 6200 avec 16 coeurs, qui fait de lui le processeur x86 le mieux doté en coeurs. Les Opteron 6200, également connus sous le nom de code Interlagos, sont de 25 à 30 % plus rapides que leurs prédécesseurs 12 coeurs, les Opteron 6100, a déclaré John Fruehe, directeur du marketing produit chez AMD.

Ces puces sont attendues dans les prochaines semaines au sein des serveurs de Hewlett-Packard, de Dell, de Cray et d'Acer a précisé M.Fruehe. Elles inaugurent une nouvelle architecture baptisée Bulldozer, qui apporte des améliorations au niveau de la bande passante et des performances tout en réduisant la consommation d'énergie.

Les expéditions de puces ont été retardées de quelques semaines, a indiqué Dean McCarron, analyste chez Mercury Research. Ce retard arrive alors qu'AMD tente de renverser sa mauvaise fortune sur le marché des serveurs. Le fondeur de Sunnyvale a en effet perdu du terrain l'année dernière au profit d'Intel. Les parts de marché serveur d'AMD au niveau mondial étaient seulement de 5,5% pour le deuxième trimestre de cette année, tandis qu'Intel en accaparait 94,5%, selon IDC. AMD a également été obligé de traiter les plaintes de clients qui estimaient que l'entreprise ne respectait pas sa roadmap produits.

Des processeurs avec des vitesses allant de 1,6 à 2,6 GHz

Les cinq puces 6200 - les 6262 HE, 6272, 6274, 6276 et 6282 SE - sont cadencées à des vitesses d'horloge comprises entre 1,6 et 2,6 GHz, et sont vendues de 523 à 1019 $. Ces composants consomment de 85 à 140 watts et peuvent remplacer les anciennes puces 12 coeurs dans les serveurs puisqu'elles utilisent les mêmes sockets (C34 et G31).

« Le 6200 est destiné aux applications vraiment évolutives, des charges de travail qui ont beaucoup de threads tels que les bases de données, le cloud et l'informatique haute performance », a déclaré M.Fruehe. Ces processeurs ont été conçus pour les des environnements serveurs très virtualisés ajoute-t-il encore. Les systèmes d'exploitation Linux et Microsoft Windows Server 2008 vont pouvoir profiter de ces 16 coeurs, et plusieurs instances de machines virtuelles peuvent être créées pour traiter les transactions, précise-t-il.

L'architecture Bulldozer présente comme particularité de mixer au sein du processeur des unités de calcul entier et une unité flottante de sorte que plusieurs opérations peuvent être exécutées par cycle d'horloge tout en réduisant la consommation électrique. Parmi les autres améliorations de ces puces, citons la technologie Turbo Core, qui, comme chez Intel, peut augmenter la vitesse d'horloge jusqu'à 500 MHz dans tous les coeurs et jusqu'à 1 GHz sur certains noyaux en fonction des performances requises. Les liens HyperTransport 3.0 sont toujours au nombre de 4 et le contrôleur mémoire sur quatre canaux.

Opteron 4200, un demi Opteron 6200

AMD a également annoncé la disponibilité de l'Opteron 4200, qui pourra être livrée avec 6 ou 8 coeurs. Ces puces fonctionnent à des vitesses d'horloge comprises entre 1,6 et 3,0 GHz, et sont vendues entre 125 et 377 $. Les processeurs 4200 ont été conçus pour les environnements serveurs denses nécessitant des puces basse consommation, a précisé le responsable d'AMD. Ces composants consomment de 35 à 95 watts, soit environ 4,3 watts par noyau, selon le fondeur.

Il y a un intérêt croissant pour les processeurs basse consommation sur le marché des serveurs et certains constructeurs comme HP récemment commencent à regarder ailleurs, du coté d'ARM par exemple, pour aider les entreprises à diminuer leur facture électrique. Mais toujours selon M.Fruehe, les processeurs Opteron 4200 possèdent encore une longueur d'avance sur les puces ARM, qui font l'impasse sur des fonctionnalités indispensable aux serveurs, comme l'adressage mémoire et les instructions 64-bit. « Quand vous regardez certaines des choses d'ARM, c'est une bonne technologie, mais quand vous regardez le marché des serveurs et les besoins ... ils ne vont vraiment adresser qu'une petite partie du marché, tout en bas, là où certaines de ces choses n'ont pas d'importance », a déclaré M.Fruehe. « Les processeurs pour serveurs haut de gamme seront toujours nécessaires pour les machines back-end exécutant intensivement des applications manipulant beaucoup de données ou réalisant des calculs d'images dans le cloud (...) Il n'y a aucun moyen qu'un processeur ARM à 1,4 GHz soit capable d'offrir le même niveau de performances qu'une puce x86 ». Un seul coeur peut être pas, mais quand on sait qu'ARM travaille sur une architecture multi coeurs avec instructions 64 bits (ARMv8), le retard pourrait être vite comblé.

[[page]]

Ces derniers mois, AMD a une fois de plus restructuré ses activités et la priorité du nouveau PDG, Rory Read (ex-Lenovo), est de stimuler l'activité à forte marge commerciale. Le dirigeant a d'ailleurs reconnu que les clients s'étaient plaints de l'incapacité d'AMD à fournir ses produits à temps, et qu'une de ses priorités était de régler les problèmes de fabrication et d'expédition des puces. L'Opteron 6200 est un processeur très important dans la stratégie serveur d'AMD car c'est un produit clef pour s'ancrer dans les datacenters, selon M.McCarron de Mercury Research. «Cela fait partie de leur programme de réimplantation. Ils ont connu une lente érosion ces dernières années ». Dell est le premier à annoncer que son serveur PowerEdge R815 (voir ci-dessous) pourra accueillir cette puce et passer ainsi de 48 à 64 coeurs max. La seul option supplémentaire pour ce serveur sera l'option mémoire à 1600 MHz.

AMD a connu quelques victoires importantes avec cette puce, a poursuivi l'analyste. L'une d'elles se situe au laboratoire national d'Oak Ridge du Département américain de l'Énergie, où un superordinateur appelé Titan est construit avec des processeur AMD 16 coeurs et les puces graphiques NVIDIA pour offrir un maximum de 20 Pétaflops en pointe. Ce supercalculateur dépassera le K japonais, qui, avec 8 Pétaflops, était jusqu'à présent l'ordinateur le plus rapide du monde dans la liste Top500.org publiée en juin dernier.

Le lancement de cet Opteron arrive enfin juste avant les processeurs Intel Xeon E5, qui sont déjà en fabrication et devraient arriver sur les serveurs dans la première moitié de l'année 2012. Intel a déjà 400 certifications environ pour son Xeon E5, a déclaré Kirk Skaugen, vice-président et directeur général de l'activité Intel Data Center Group, lors d'une conférence la semaine dernière.

| < Les 10 documents précédents | Les 10 documents suivants > |