Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 31 à 40.

| < Les 10 documents précédents | Les 10 documents suivants > |

(29/12/2011 10:34:10)

Avec Teradata, Hertz cherche à accroitre la performance de son entrepôt de données

Dans les trente prochains mois, le loueur de voitures va progressivement déployer les solutions proposées par Teradata autour de sa plate-forme Teradata Active Enterprise. En l'occurrence, Hertz installe le nouveau Teradata 6650 ainsi que Teradata Data Warehouse Appliance exploités pour un système de test d'analyse de données. Hertz met également en oeuvre des produits Teradata à des fins de sauvegarde et restauration, le modèle de données logique pour les entreprises de voyages, qui englobent cinq produits Teradata : Decision Experts, Profiler, Professional Services, Advanced Analytics Support et Managed Services.

L'objectif est de disposer d'un datawarehouse unique capable de traiter les volumes de requêtes complexes tout en permettant les accès aux informations en temps réel. Il remplace plusieurs datamarts distincts.

Big Data et BI : EMC pointe la carence des compétences

EMC s'est intéressé aux compétences en matière de Big Data et décisionnel auprès de 500 ingénieurs de la donnée (data scientist). Le constat montre une carence des compétences dans ce domaine. En effet, selon les chiffres fournis par cette enquête, seules un tiers des entreprises parviennent à s'appuyer sur des données qualifiées pour étayer leurs processus métier, accentuer leur avantage concurrentiel, améliorer leur productivité et innovation ou encore pour mieux cerner leur clientèle.

Pénurie de talents

L'étude révèle que l'explosion des données numériques, générées notamment par les capteurs mobiles, les médias sociaux, les systèmes de surveillance, les images médicales ou les réseaux électriques intelligents, provoque une croissance similaire en termes d'opportunités. La demande en «data scientists» a donc rapidement progressé ces dernières années, ce qui conduit 64% des personnes interrogées à estimer qu'au cours des cinq prochaines années, la demande de talents en sciences des données dépassera l'offre.

L'étude met par ailleurs en évidence plusieurs obstacles qui entravent le plus souvent une exploitation efficace des données, dont: des carences en compétences ou en formation (32%), le manque de budget ou de ressources (32%), une structure organisationnelle inadaptée (14%) ou encore une pénurie d'outils et de technologies (10%). En outre, seuls 22% des «data scientists» et 12% des experts de business intelligence déclarent avoir suffisamment accès aux données brutes disponibles au sein de leur entreprise pour leur permettre de les explorer à des fins de modélisation.

Data scientists et experts BI

L'étude se concentre également sur les principales différences entre le domaine de la business intelligence (BI) et la science des données (data science). Au vu du fait que la BI se concentre sur l'exploitation de données à des fins de monitoring et d'aide à la décision, alors que la science des données se concentre avant tout sur l'utilisation d'outils d'analyse et d'algorithmes afin de générer des données prospectives devant mener à l'innovation, les profils des experts de ces deux métiers sont également différents. Par exemple, note EMC, les «data scientists» sont trois fois plus nombreux à être titulaires d'une maîtrise universitaire ou d'un doctorat que les experts en BI.

ICTjournal.ch

[[page]]

Par ailleurs, alors que les experts en BI viennent en premier lieu du domaine commercial (37%), les «data scientits» proviennent plus facilement de l'informatique (24%), de l'ingénierie (17%) ou des sciences dures (11%). Ces derniers utilisent également une palette beaucoup plus diversifiée d'outils d'analyse. Ainsi, alors que de nombreux experts en BI utilisent avant tout Excel, les «data scientists » recourront beaucoup plus à SQL, aux bases de données NosQL, ainsi qu'à des outils d'analyse de big data comme Hadoop, des outils de visualisation comme Tableau, des instruments encore quasiment inconnus dans le monde de la BI. Des outils Open Source comme R statistics, Python et Perl sont également utilisés par 20% des data scientists, et seulement 5% des experts en BI.

Dans un dernier volet, EMC analyse les spécificités des spécialistes de l'analyse du big data, et note leur propension à utiliser des outils comme R Statistics (50% contre 13%), ou comme Hadoop, Greenplum ou Netezza. EMC relève par ailleurs que l'analyse du big data exige un degré élevé de collaboration avec d'autres experts, comme des statisticiens ou des programmeurs.

Au vu de la pénurie d'experts formés dans ces professions émergentes et exigeantes, EMC recommande de privilégier la formation interne de personnes dotées de rigueur et de la curiosité intellectuelle suffisante. Elle note aussi l'importance pour les entreprises de favoriser l'accès aux données afin de permettre à leurs experts de les explorer et de les exploiter à des fins d'expérimentation et de modélisation.

ICTjournal.ch

Crédit Agricole unifie son outil décisionnel avec MicroStrategy

Le Crédit Agricole repose, en France, sur plus de 2 500 caisses locales regroupées en 39 caisses régionales. Il sert ainsi 24 millions de clients en France. Depuis mars 2010, le Crédit Agricole a choisi d'unifier l'ensemble de ses structures informatiques dans le cadre du projet NICE (Nouvelle Informatique Convergente et Evolutive). Il dispose ainsi de deux GIE regroupant toutes les caisses régionales : Crédit Agricole Technologies et Crédit Agricole Services.

Crédit Agricole Technologies vient de choisir l'outil décisionnel unique du groupe et qui sera désormais utilisé par 71 000 salariés dans le groupe. Il s'agit de l'offre de MicroStrategy. L'intégration de la plate-forme technique, la facilité d'utilisation et l'accessibilité autant sur le web que sur les terminaux mobiles ont été les critères du choix.

Cet outil servira notamment au reporting, les analyses et les tableaux de bord dynamiques. L'objectif est de renforcer le pilotage de la performance du groupe.

Le coût du projet n'a pas été dévoilé.

IBM renforce son portefeuille dans le smarter commerce avec Emptoris

IBM a annoncé la signature d'un accord en vue d'acquérir Emptoris, un concepteur de logiciels de gestion des achats. Le montant financier de l'opération n'a pas été dévoilé, mais elle devrait être finalisée au premier trimestre 2012. Basée à Burlington dans le Massachussetts, elle comprend 725 employés et dispose de 350 clients dont ADP, Kraft et American Express. Récemment, la société a été condamnée à une amende de 7 millions de dollars contre elle pour une violation de brevets de son concurrent Ariba.

Cette opération fait suite la récente acquisition par IBM de DemandTec, pour 400 millions de dollars. Cette société a développé en mode SaaS (software as a service) des outils d'analyse des prix, du merchandising, des promotions et des actions de marketing. Les deux rachats s'inscrivent dans la stratégie d'IBM dans le smarter commerce, lancée au printemps 2011 pour aider les entreprises à optimiser leurs processus commerciaux, marketing et services aux clients.

Emptoris avait très récemment lancé la dernière version de sa suite de produits à destination des petites entreprises. Elle l'avait qualifiée de « plateforme stratégique du futur pour la gestion de la logistique ». Les apports de cette dernière version comprennent une expérience utilisateur rénovée, le support de plusieurs navigateurs, de l'iPad et l'intégration avec Microsoft Office, un module de gestion du programme, un référentiel global pour les données concernant les fournisseurs et des fonctionnalités de BI (Business Intelligence) basées sur SAP Business Object. Sur ce dernier point, on ne sait pas encore si IBM fera migrer les fonctionnalités de BI vers son offre Cognos.

(...)

Base de données : SAP vise désormais la place de numéro 2

Le projet HANA, dont la paternité revient au fondateur de SAP, Hasso Plattner, et au CTO, Vishal Sikka, a été initialement présenté au milieu de l'année 2010 comme une plateforme permettant d'exécuter des charges de travail analytique beaucoup plus rapidement qu'avec les bases de données traditionnelles. Selon SAP, ce mode de fonctionnement où le système inscrit les données qu'il doit traiter en RAM, au lieu de les lire sur les disques, permet des gains en performance significatifs, voire très impressionnants.

Mais, rapidement, SAP a commencé à évoquer la capacité de HANA à gérer des charges de travail transactionnelles dans le domaine de l'ERP (Enterprise Resource Planning) et dans d'autres types d'applications, le positionnant comme une alternative éventuelle à certains produits, notamment la base de données phare d'Oracle. « C'est une opportunité très stimulante, parce qu'elle ouvre sur la possibilité de développer des applications totalement nouvelles », a déclaré Vishal Sikka à la keynote qu'il a donné à l'Influencer Summit de Boston. Sur une diapositive, il a montré la future pile logicielle basée sur HANA. À la base de la pile se trouvent HANA et les services d'infrastructure et de gestion du cycle de vie associés. Viennent ensuite les services d'applications, puis ABAP et les services de la plateforme Java, surmontés par les environnements de développement, et enfin les applications construites par SAP et celles des vendeurs tiers.

SAP bientôt numéro 2 dans les SGBD ?

SAP trace aussi d'autres perspectives, annonçant une série d'initiatives en relation avec HANA de la part de vendeurs de middleware et d'analytiques comme Tibco, du fournisseur d'ERP UFIDA, du vendeur de visualisation de données BI (business intelligence) Tableau and Jive Software, connu pour ses solutions de réseau social pour l'entreprise. « Dorénavant, SAP entend disposer d'un « écosystème tout à fait ouvert » pour HANA, » a indiqué Vishal Sikka. Cela paraît logique, bien sûr, étant donné que HANA est un produit relativement nouveau qui a beaucoup de choses à rattraper pour se mettre au niveau d'Oracle et d'autres. Cela n'a pas empêché un autre responsable de SAP de faire une prédiction très optimiste, mardi, après la keynote de Vishal Sikka. « Retenez-ce que je vais vous dire : en 2015, nous serons le deuxième vendeur de bases de données sur le marché, » a déclaré Steve Lucas, Global General Manager Business analytics and technology. « Je sais qui nous devons dépasser. Ce ne sont pas de petits acteurs. Il va nous falloir quelques années et beaucoup d'ingénierie pour y arriver. Mais nous le ferons. »

« SAP va également chercher à conclure des partenariats avec des éditeurs de logiciels qui intégreront HANA dans leurs produits, » a ajouté Steve Lucas. Une autre bonne manière pour SAP d'avancer vers son objectif serait d'ajouter le support HANA pour son logiciel phare Business Suite, dont de nombreuses mises en oeuvre fonctionnent sur Oracle. « Ce travail est en cours, et comme aucune date d'achèvement n'a été fixée, on peut s'attendre à une mise à jour pour la conférence Sapphire de l'année prochaine, » a déclaré Sethu Meenakshisundaram, CTO adjoint de SAP. « C'est un projet de première importance et nous avançons. » SAP n'a pas encore décidé « si elle vendra aussi HANA comme base de données autonome, » a encore déclaré Vishal Sikka dans une interview.

Déjà 100 millions de dollars de vente pour HANA

« En attendant, SAP a récemment franchi une étape avec HANA, dépassant les 100 millions de dollars de ventes, » comme l'a révélé le directeur technique de SAP au cours de sa keynote. HANA est vendu sous forme d'appliance par un certain nombre de fabricants. « Les 100 millions de dollars ne prennent en compte que les revenus de licence du logiciel de SAP, » a aussi précisé Vishal Sikka dans son interview. « Autre signe du succès de HANA, dans toutes les régions du monde, les clients ont racheté d'autres produits intégrant le système, » a ajouté le dirigeant. « CSC, l'un des leaders mondiaux dans le conseil, l'intégration de solutions d'entreprise et l'externalisation devrait adopter HANA, » a déclaré David McCue, vice-président et CIO de CSC, dans une interview. « La première instance de production concernera environ 1 téraoctet de données, mais CSC réfléchit, encore à quel type d'usage elle sera affectée, » a-t-il ajouté.

« HANA est un produit jeune, mais c'est aussi une solution viable, » a encore déclaré le CIO de CSC. « Nous sommes suffisamment confiants pour l'acheter, et nous réaliserons plusieurs mises en oeuvre pour le compte de nos clients, » a-t-il ajouté. Ce dernier a aussi donné un point de vue mesuré sur le projet à long terme envisagé par SAP pour HANA. « S'il est matériellement réalisé, le produit aura un très bon retour, » a-t-il estimé. « Sans aucun doute, HANA a montré dans sa version actuelle qu'il avait assez de ressources pour qu'on s'y intéresse. Mais comme toute prospective à long terme, celle-ci pourrait être contredite par les événements. »

[[page]]

Hier à Boston, SAP a également abordé la question de sa stratégie logicielle dans le cloud computing, récemment agitée par le rachat de SuccessFactors pour 3,4 milliards de dollars. C'est le PDG du vendeur de logiciels de gestion des ressources humaines à la demande, Lars Dalgaard, qui sera placé à tête de l'activité cloud de SAP une fois la transaction achevée. Cette acquisition intervient après plusieurs années pendant lesquelles SAP s'est employé à peaufiner précisément son approche du logiciel dans le cloud. Cela n'a pas été une mince affaire pour un éditeur comme SAP, dépendant du modèle de logiciel sur site et du flux de revenus prévisibles et lucratifs rapportés par le renouvellement perpétuel des licences et les services de maintenance. Ce concept a du être bouleversé et remplacé par un système d'abonnement, devenu le standard du cloud.

« Mais SAP a encore le temps de voir venir, et l'expérience de SuccessFactors va être un atout majeur, » a déclaré Jim Hagemann Snabe, le co-CEO, lors d'un discours liminaire. « 80% des clients importants n'ont pas fait leur choix de stratégie pour le cloud, et pensent encore en terme de cloud privé. On voit aussi que les applications de pointe sont encore confiées à des services de cloud public. » « La combinaison de nos actifs et de SuccessFactors transforme une entreprise qui a essayé de bien faire les choses... en une entreprise qui va croitre rapidement dans le monde, » a-t-il ajouté. « Nous passons aussi d'un mode défensif, à un mode offensif. »

(...)(13/12/2011 17:14:54)SAP s'associe à NetBase pour analyser les médias sociaux

SAP va revendre le logiciel d'analyse des médias sociaux de l'éditeur NetBase. Ce dernier fait partie d'une catégorie d'acteurs qui se développe. Sa plateforme ingère les données issues de médias sociaux, tels que Facebook et Twitter. Elle analyse ensuite ces informations pour récupérer les commentaires émis sur les produits et les marques qu'elle communique aux entreprises concernées. L'offre de NetBase est concurrente de celle de l'éditeur Radian6 qui a été acheté au début de l'année par Salesforce.com. Des fonctions de surveillance des médias sociaux existent également dans la suite de RightNow, acquise de son côté par Oracle.

Selon Byron Banks, vice président marketing pour les solutions analytiques métiers, SAP aurait pu lui-même développer ce type de technologie (*), mais s'associer avec NetBase lui permet d'entrer dans le jeu plus rapidement. Il n'a pas précisé pourquoi SAP n'avait pas plutôt racheté l'éditeur. Le logiciel sera vendu à partir de janvier comme une extension, sous le nom de SAP Social Media Analytics (by NetBase). Son prix sera basé sur le nombre d'utilisateurs et le nombre de sujets qu'une entreprise voudra suivre sur les médias sociaux, a indiqué Lisa Joy Rosner, responsable marketing de NetBase.

30 téraoctets de données sur un an

L'application cloud de NetBase consiste en une base d'informations de 30 To, rafraîchie au fur et à mesure au rythme d'environ 90 millions de « posts » chaque jour, selon Byron Banks. Le système rassemble les « opinions » récupérées sur une année complète à travers les médias sociaux. Mais ce qui différencie vraiment NetBase des autres offres de ce type, ce sont ses capacités de traitement en langage naturel, souligne Lisa Joy Rosner. « Lorsque quelqu'un dit : « J'aime l'iPhone, il est cool », notre système comprend que « il » se rapporte à l'iPhone », donne-t-elle en exemple. NetBase peut aussi détecter différents niveaux dans l'expression, notamment la distinction qui s'exprime entre « I like iPhone » et « I adore the iPhone ».

SAP a déterminé environ une douzaine de point d'intégration possibles avec ses autres produits, en particulier avec ses modules CRM (gestion de la relation client) et son portefeuille de solutions décisionnelles BusinessObjects BI. Pour l'instant, aucune des ces intégrations n'est disponible, mais les clients pourront accéder à une API (sous la forme d'un service web) pour les projets qu'ils souhaiteront lancer rapidement.

L'éditeur allemand compte proposer le produit NetBase au-delà des départements marketing, selon Byron Banks. Selon lui, les équipes commerciales peuvent l'utiliser pour ajuster leur stratégie de tarification et mieux comprendre les clients. Les équipes de développement produit pourraient s'en servir pour améliorer leur processus de planification. « Quelles tendances dans la mode pour le printemps prochain ? Si vous produisez en offshore, vous devez le savoir », souligne le vice-président marketing.

Dépasser la surveillance des médias sociaux

Pour l'analyste Zach Hofer-Shall, de Forrester Research, les entreprises devraient dépasser la simple surveillance des médias sociaux. Il faudrait mettre ces données dans des tableaux de bord marketing, écrit-il en citant une banque de détail ayant créé un 'index de santé des marques' qui combine le volume et les sentiments exprimés dans les conversations en ligne, les scores de ses enquêtes en ligne et les réponses recueillies par téléphone.

[[page]]

Plus encore, les entreprises devraient relier les données des médias sociaux à celles de leurs clients, afin de cibler particulièrement les clients ayant des discussions sur les sites communautaires. « Cette approche soulève des questions relatives au respect de la vie privée et présente des limites lorsqu'il s'agit d'associer les informations entre elles, mais elle a montré son efficacité pour certaines marques grand public », selon lui. Des entreprises comme Fliptop proposent des services censés faciliter cette démarche, ajoute-t-il. Fliptop permet de constituer, à partir d'une adresse e-mail, des profils incluant des informations issues de Twitter, Facebook et LinkedIn.

SAP veut aller au-delà du département marketing

Il est important de reconnaître que l'analyse des médias sociaux n'en est qu'à ses débuts, souligne de son côté Susan Etlinger, analyste chez Altimeter Group, qui a conseillé NetBase et plusieurs de ses concurrents. « C'est tellement nouveau et cela vient de partout », a-t-elle confirmé à nos confrères d'IDG News Service. C'est constitué d'un ensemble d'acteurs de différents types qui sont liés les uns aux autres ». Elle ajoute que Radian6, avec ses tableaux de bord, représente un peu l'archétype général. Tandis que des sociétés telles que NetBase et Crimson Hexagon disposent de capacités d'analyse textuelle plus avancées.

NetBase a également constitué une base de données plus importante, ce qui lui donne un avantage sur ses rivaux, estime encore Susan Etlinger. Concernant le partenariat avec SAP, « il faudra faire des études de faisabilité », considère-t-elle. « Entre Radian6 et Salesforce.com, les structures ne sont pas si différentes, tandis que les outils de SAP et NetBase sont très différents. Il ne s'agit pas seulement de marketing, mais de développement de produits, de planification logistique, et par essence, tout endroit dans l'organisation d'une entreprise où les médias sociaux pourraient mettre les données en perspective ».

(*) Début 2010, SAP France avait présenté un prototype d'outil destiné à l'analyse des réseaux sociaux, SNA (Social network analyser), développé par le Centre d'innovation de SAP BusinessObjects.

Open Data : l'UE veut rendre les données publiques accessibles à tous

Les États membres de l'Union européenne vont avoir l'obligation de numériser toutes les données de leurs administrations publiques. En effet, selon la proposition de loi avancée par Neelie Kroes, la commissaire chargée de l'agenda numérique auprès de l'Union européenne, tous les pays membres de l'UE seront obligés de rendre leurs données publiques disponibles dans des formats numériques. Selon la Commission, « c'est une énorme opportunité pour les entreprises de haute technologie, puisque le marché a été estimé à 400 milliards d'euros par an pour l'économie européenne, dont 100 milliards d'euros reviendraient à la recherche sur les technologies de traitement des données. » De l'argent sera également alloué à la création de portails Internet via le Programme-cadre pour l'Innovation et la Compétitivité (PIC) de l'UE. La Commission va également soutenir la recherche dans le domaine des infrastructures de données.

L'objectif est de tirer le meilleur parti de la « mine d'or » d'informations cachées dont regorge l'Europe. Par données des administrations publiques, il faut comprendre toutes les informations produites, collectées ou achetées par les organismes publics de l'Union européenne. Cela pourrait inclure des données géographiques, météorologiques, statistiques, les données de projets de recherche financés par des fonds publics, ou encore les livres numérisés par les bibliothèques. « C'est un signal fort à l'attention des administrations. Elles doivent comprendre que leurs données ont plus de valeur si elles les diffusent. Elles doivent donc commencer à s'en séparer dès maintenant. Ce cadre va leur permettre de rejoindre d'autres dirigeants avisés qui tirent déjà profit des « données ouvertes ».

Des données pour favoriser la croissance

Les contribuables ont déjà payé pour cette information. Le moins que l'on puisse faire, c'est de la remettre entre les mains de ceux qui veulent l'utiliser autrement pour aider les personnes, créer des emplois et de la croissance, » a déclaré Neelie Kroes, lors du lancement de sa proposition. La Commission rendra ses propres données disponibles via un portail web Open Data actuellement en développement, et qui devrait être lancé au printemps prochain. Il servira de point d'accès unique pour les données réutilisables de toutes les institutions, organisations, agences, et autorités nationales de l'UE.

Il est probable que les premiers bénéficiaires de cette régulation seront les start-up technologiques, qui transformeront les données brutes en applications pour smartphone, comme des cartes, des informations sur le trafic en temps réel et la météo, des comparateurs de prix, etc. En plus de distribuer toutes les informations dans un format lisible à l'aide d'un terminal, les organismes publics devront aussi s'intéresser aux applications développées en vue de la réutilisation des données. Elles devront répondre aux demandes dans des délais fixes et ne seront pas autorisées à facturer plus que le coût lié à la demande individuelle pour accéder à ces données.

Pour plus de transparence du secteur public

En pratique, cela signifie que la plupart des données seront offertes gratuitement ou quasi gratuitement, sauf si la participation aux frais de traitement est dûment justifiée. Ces conditions conviennent particulièrement bien aux entreprises qui doivent démarrer rapidement, limitées en liquidité, et aux développeurs. La Commission affirme que ces dispositions permettront également d'accroître la transparence des administrations publiques: « L'Open Data est un instrument puissant pour accroître la transparence de l'administration publique, il améliore la visibilité d'informations, auparavant inaccessibles, informe les citoyens et les entreprises sur les politiques, les dépenses publiques et les résultats. » Enfin, cette proposition s'appliquera dans le plein respect des lois concernant le traitement des données personnelles.

Un certain nombre de pays, dont le Royaume-Uni et les Pays-Bas, ont déjà créé des portails Internet sur lesquels il est possible d'avoir accès à des données ouvertes. La semaine dernière, la France a lancé un portail qui répond exactement au cadre de la proposition de la Commission. Mais d'autres États membres traînent les pieds et continuent à publier leurs données exclusivement au format papier. Si la proposition de Neelie Kroes est adoptée par le Parlement européen et les États membres, elle pourrait entrer en vigueur en 2013. Les États membres disposeront alors de 18 mois pour la transposer dans leur législation nationale.

(...)(12/12/2011 12:37:34)Cartographie : Esri lance une offre découverte de son SIG

Esri élargit l'accès à son système d'information géographique ArcView en l'ouvrant à un usage privé. Avec le programme ArcGIS for Home Use, l'éditeur assortit le téléchargement et l'utilisation « non commerciale » de la version bureautique du logiciel à une redevance annuelle de 120 euros TTC, renouvelable. L'offre s'adresse à des utilisateurs âgés d'au moins 18 ans et inclut un support de 90 jours en français, ce dernier se limitant aux problèmes d'installation du logiciel. Les utilisateurs souhaitant faire un usage commercial de l'application devront se tourner vers ArcGIS Desktop Basis, dont le prix reste fixé à 2 500 euros.

ArcGIS for Home Use concerne la version de base du produit, néanmoins « très riche », précise Gaëtan Lavenu, responsable marketing produit chez Esri France. Le droit d'usage ouvert par le programme couvre en effet huit extensions du produit : 3D Analyst (outils de visualisation avancés, d'analyse et de génération de surfaces), Data Interoperability (import/export et transformation de données), Geostatistical Analyst (outils d'exploration de données spatiales et de création de surfaces basée sur des méthodes statistiques), Network Analyst (permet de créer des itinéraires), Publisher (partage de cartes), Schematics (création de diagrammes à partir de données contenues dans la base géographique), Spatial Analyst (modélisation spatiale) et Tracking Analyst (analyse et gestion des données temporelles).

Dans une perspective professionnelle

Le logiciel pourra, par exemple, être utilisé dans un cadre pédagogique, pour réaliser des cartes permettant à un auditoire de mieux comprendre un territoire, ou pour expliquer certains phénomènes, donne en exemple Gaëtan Lavenu. L'éditeur propose par ailleurs des licences de ses logiciels dans le domaine de l'éducation.

« Dans le cadre d'activités associatives ayant un lien avec le territoire, ArcGIS pourra aussi servir à planifier des itinéraires passant par des points d'intérêt, ou des réseaux pédestres, en évaluant les pentes moyennes sur des zones montagneuses », indique encore le responsable marketing. « On peut accéder à ArcGIS online, une base de contenus très riche comprenant des données géographiques et socio-démographiques, et conserver un historique des informations ».

Pour d'autres utilisateurs, l'accès à une version moins coûteuse peut être l'occasion de découvrir ce produit aux fonctions complexes, ou d'en approfondir la connaissance qu'ils en ont, dans une perspective professionnelle, pour éventuellement postuler à d'autres fonctions.

Greenplum d'EMC présente sa plateforme analytique unifiée

Greenplum, acquise par EMC l'année dernière, prévoit d'introduire UAP, plateforme analytique unifiée au 1er trimestre 2012. UAP combinera la base de données EMC Greenplum avec Greenplum HD, qui utilise le framework Hadoop, solution Open Source d'analyse pour les gros volumes de données non structurées. L'offre comprend aussi Chorus 2.0, une interface utilisateur capable de mettre en place les requêtes et la visualisation des résultats. Cette dernière version sera capable de gérer l'ensemble des données. UAP de Greenplum a été présentée hier lors d'un évènement en Californie. Les tarifs n'ont pas été dévoilés et seront divulgués l'année prochaine.

Julie Lockner, analyste chez Entreprise Strategy Groupe, estime que « Les entreprises dans de nombreux domaines produisent des montagnes de données qui deviennent trop importantes pour les analyser avec des outils traditionnels » et d'ajouter que « le volume de données, la complexité des requêtes et le besoin de réponses rapides s'apparentent à un vrai défi ». Les entreprises, surtout celles liées au commerce ou à la santé sont très intéressées par les technologies déployées par Greenplum pour apprendre des choses sur leurs clients à partir des données existantes. Ainsi, une boutique en ligne peut corréler le comportement des visiteurs avec leurs achats ou les laboratoires pharmaceutiques pourront traiter plus rapidement les résultats d'études cliniques. Les compagnies d'assurance adopte aussi ces nouveaux outils d'analyse pour faire des prédictions plus précises.

Un des objectifs de Greenplum a été de rendre les outils d'analyses de données accessibles aux dirigeants d'entreprise et pas uniquement à une équipe d'ingénieurs spécialisés. Chorus fournit une interface moins ésotérique pour traduire en langage naturel des requêtes sur l'ensemble des données. Ce programme inclut un environnement de réseau social où les salariés peuvent collaborer sur des projets avec les données.

Extension des données analysées et volonté de formation

Michael Maxey, directeur marketing produit chez Greenplum, explique « l'UAP apporte deux avantages principaux pour les entreprises, « le premier concerne l'étendu des données prises en compte, aussi bien celles existantes dans l'entreprise que d'autres types de données. La seconde est qu'en plus d'avoir accès aux données non structurées, les fonctionnalités de Greenplum HD et Chorus 2.0 permettent de créer rapidement une « sandbox » virtuelle pour développer de nouveaux processus d'analyse ». Il ajoute que ces ajouts tirent profit des technologies VMware. Le directeur marketing produit précise que les clients pourront déployer UAP sur leurs propres infrastructures informatiques ou depuis une configuration pré-packagée. Les entreprises disposant de la base de données Greenplum ou HD peuvent intégrer cette plateforme d'analyses unifiée.

Julie Lockner constate que, dans le domaine de la visualisation des données, des éditeurs comme Tableau et Alpine Miner offrent déjà une interface accessible des données comme ce qui est disponible avec Chorus 2.0, mais les capacités offertes sur l'UAP sont assez nouvelles ». Elle rappelle aussi que l'arrivée de telles solutions va changer la formation des spécialistes des données. A cette fin, Greenplum a annoncé un programme Big Data Training qui sera enseigné auprès de 700 universités. Récemment, une conférence montrait les difficultés de trouver des compétences sur les big data. (...)

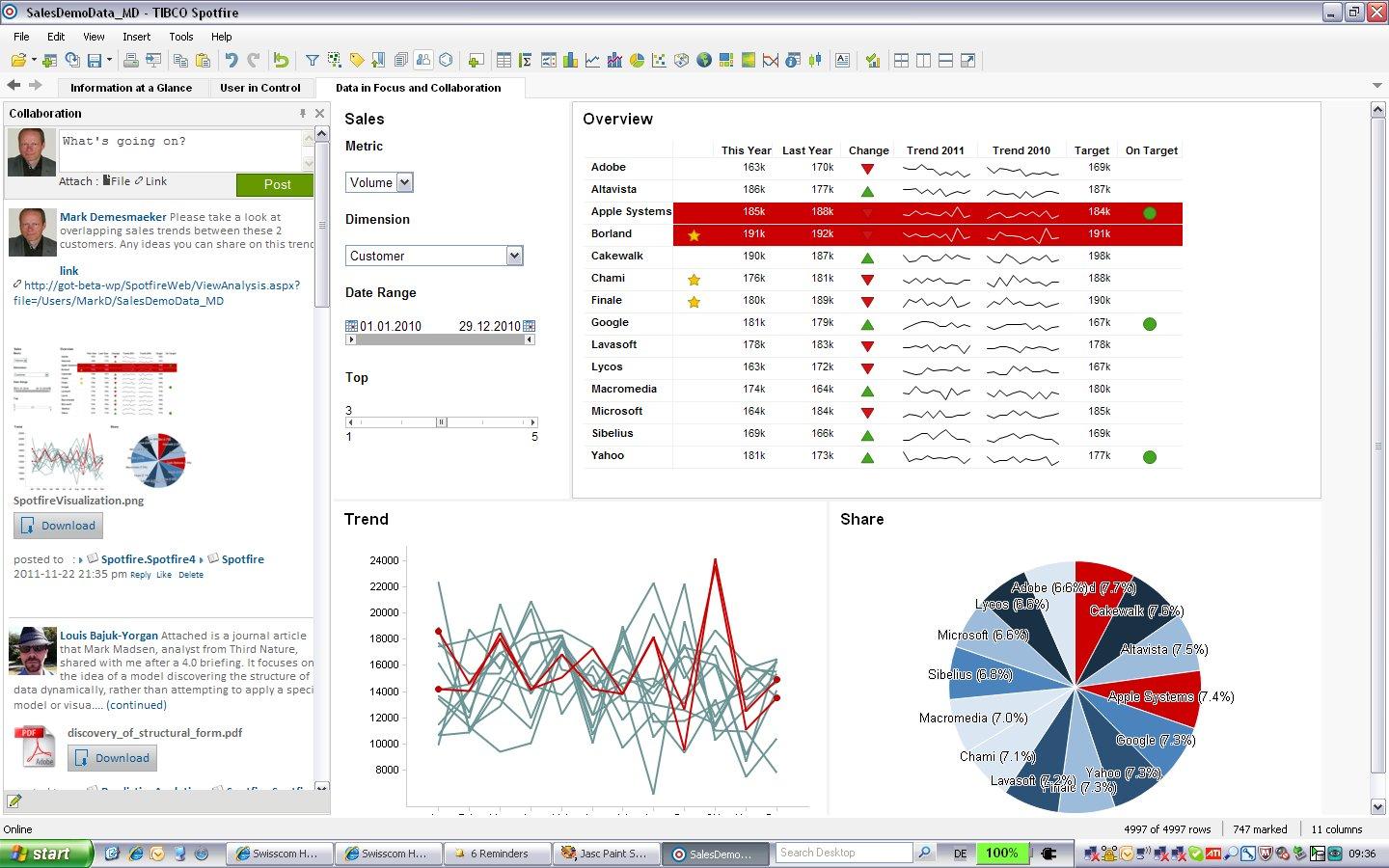

Tibco Spotfire 4.0 ajoute l'axe collaboratif à l'analyse interactive

« Notre plateforme donne davantage de pouvoirs à l'utilisateur final », considère Mark Demesmaeker, directeur de la stratégie produit EMEA chez l'édieur Tibco Spotfire. L'éditeur vient de lancer la version 4.0 de sa plateforme analytique, connue pour l'étendue de ses modèles de visualisation de données et pour son aptitude à traiter en mémoire des données provenant de multiples sources. Le logiciel est désormais complètement intégré avec « Tibbr », la plateforme de collaboration sociale d'entreprise que Tibco a lancée au tout début de cette année. « On peut porter une analyse interactive sur Tibbr et la partager », explique Mark Demesmaeker. Les analyses créées avec Spotfire peuvent aussi être facilement intégrées à des portails d'entreprise ou à des blogs. « Cela fonctionne aussi avec SharePoint, de Microsoft. Dans cet environnement, il était déjà possible de le faire en recourant à une API. Désormais, l'utilisateur métier peut le faire lui-même ». A l'inverse, on peut insérer des pages web dans une analyse Spotfire, de même que des fils de discussion provenant de Tibbr.

L'objectif est d'inscrire la réflexion dans un contexte métier, en concertation avec les équipes concernées. La collaboration sociale offerte par le réseau Tibbr, ce dernier ayant été destiné dès l'origine par l'éditeur à un environnement professionnel, va permettre de créer un espace de discussion pour inviter d'autres personnes à participer à une prise de décision, au besoin par vidéoconférence. Il est aussi possible de suivre dans le temps un sujet ou l'auteur d'une analyse. Tibco explique que les utilisateurs s'appuient sur des fonctionnalités comme les signets collaboratifs pour capturer un tableau de bord dans sa configuration complète et le partager via une connexion web avec d'autres utilisateurs qui y sont abonnés.

L'offre Tibco Spotfire est principalement utilisée par de grandes entreprises, notamment dans l'industrie pharmaceutique, les télécommunications, l'énergie (pétrole, gaz...) et d'autres secteurs industriels, ainsi que dans le monde de la banque et de la finance.

Des dashboards interactifs à explorer en profondeur

La deuxième amélioration importante de Tibco Spotfire 4.0 concerne les tableaux de bord analytiques. Ces derniers fournissent maintenant une vue globale sur les paramètres clés de l'activité d'une entreprise. « Des dashboards sur lesquels on peut effectuer des drill down pour entrer dans les détails », précise Mark Demesmaeker en expliquant : « Cela combine plusieurs visualisations classiques et peut être construit par l'utilisateur. » Tibco donne l'exemple d'un de ses clients, l'opérateur néerlandais KPN qui a mis en place un tableau de bord pour surveiller l'exécution des commandes de son département vente aux grossistes. Spotfire permet de mettre en relation d'importants volumes d'informations issus de sources différentes.

Pour un manager, un cas typique d'utilisation de ces tableaux de bord pourra être de suivre l'évolution du chiffre d'affaires, par produits, clients et pays, avec des icônes et des indicateurs de couleur indiquant si les objectifs ont été réalisés, si le chiffre d'affaires progresse ou recule, son évolution sur plusieurs années... Des données que l'on peut explorer en détail. « Un manager peut donc vraiment obtenir ses chiffres-clés de cette façon ». Tibco souligne que ces « dashboards » peuvent être créés sans faire appel aux équipes informatiques. L'éditeur a par ailleurs livré une application Spotfire native pour la tablette numérique d'Apple, l'iPad, qui donne accès à des tableaux de bord interactifs. Ceux-ci sont exportables sous forme d'images ou de fichiers PDF.

Enfin, le troisième axe d'amélioration de Tibco Spotfire 4.0 concerne l'interface utilisateur, plus intuitive et plus claire. « On peut facilement cacher les éléments qui ne sont pas nécessaires et définir une mise en page spécifique pour un terminal particulier », explique Mark Demesmaker. L'annotation des rapports PDF est facilitée. Des visualisations supplémentaires sont proposées parmi lesquelles une permettant de représenter les valeurs discrètes

Illustration : cliquer ici pour agrandir la capture d'écran

(...)| < Les 10 documents précédents | Les 10 documents suivants > |