Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 211 à 220.

| < Les 10 documents précédents | Les 10 documents suivants > |

(28/05/2010 09:54:17)

IBM prépare des offres analytiques basées sur Apache Hadoop

A l'instar de ses concurrents, IBM s'investit dans la mise au point de solutions capables d'analyser de très importants volumes de données. Séduit par les capacités apportées par le projet Apache Hadoop, consacré au traitement distribué intensif, il vient d'annoncer qu'il intégrait ce framework Open Source à son offre de services analytiques. Hadoop permet de répartir les traitements sur de multiples noeuds et d'en rassembler ensuite les résultats. Il combine plusieurs sous-projets : la base distribuée HBase supportant le stockage de données structurées sur un nombre élevé de tables, l'infrastructure de datawarehouse Hive, le framework MapReduce (mis au point par Google) pour le traitement distribué de grandes quantités de données sur des systèmes en clusters, ou encore Pig (langage de haut niveau pour les traitements parallèles), ZooKeeper (service de coordination d'applications distribuées), HDFS (système de fichiers distribué) et Chukwa (gestion de systèmes distribués de grande envergure).

Nom de code : BigInsights Core et BigSheets

Les offres élaborées par IBM autour d'Hadoop sont réunies sous l'appellation générique d'IBM InfoSphere BigInsights. Le suffixe Big fait ici référence à l'expression « Big data » qui caractérise ces volumes de données augmentant dans des proportions telles qu'ils exigent de nouveaux modes de récupération, de stockage, d'analyse et de visualisation pour parvenir à y repérer les informations importantes (dans les domaines de la finance, de la santé, de la lutte contre la criminalité, etc.). L'analyse et la gestion de l'information constituent pour IBM un secteur stratégique, le groupe prévoyant de générer 16 milliards de dollars d'ici 2015 sur ses activités « Business Analytics and Optimization », ainsi que l'a récemment indiqué le directeur financier Mark Loughridge.

InfoSphere BigInsights comprend d'abord un ensemble de logiciels et services d'Apache Hadoop qu'IBM désigne sous le nom de code BigInsights Core. Celui-ci permettra aux départements informatiques de construire et déployer des traitements analytiques sur mesure, à partir de volumes de données de l'ordre de ceux que peut générer Internet.

[[page]]

Par ailleurs, la technologie logicielle BigSheets est conçue pour extraire et découvrir des informations rapidement et de façon très visuelle, à partir d'une interface web. Il inclut une extension pour les moteurs d'analyse et les logiciels de visualisation tels que ManyEyes. Enfin, IBM prévoit des solutions d'analyse spécifiques pour permettre aux secteurs de la finance, de la gestion des risques, des médias et du loisir de mettre en place des application pour l'analyse d'énormes quantités de données.

[mise à jour : IBM n'a pas indiqué de date de sortie pour ces solutions en développement qu'il a dévoilées à l'occasion de sa conférence "Information On Demand EMEA 2010" qui s'est tenue à Rome, du 19 au 21 mai dernier).

Prédictif : Big Blue conjugue les logiciels d'Ilog et de SPSS

Par ailleurs, IBM développe ses offres conjuguées avec SPSS, le spécialiste du datamining racheté en juillet 2009. Dans ce domaine, il vient cette fois d'annoncer la disponibilité d'une solution qui tire également parti des technologies de l'éditeur français Ilog, acquis par Big Blue en juillet 2008 [ainsi que des logiciels de Cognos].

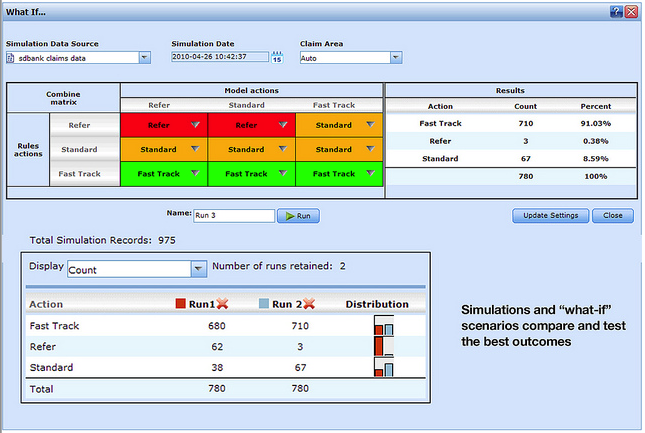

SPSS Decision Management associe ainsi des modèles prédictifs, des règles métiers et des fonctions d'optimisation. L'application aide l'entreprise à prendre des décisions en fonction des habitudes d'achat des consommateurs, et en prenant en compte les évolutions de sa stratégie et de la conjoncture économique. Deux offres verticales sont disponibles, respectivement destinée aux compagnies d'assurance (détection des demandes d'indemnisation frauduleuse) et aux sociétés de marketing (gestion multicanale des interactions entrantes avec les clients).

Capture d'écran de la solution IBM SPSS Data Management.

Cliquer ici pour agrandir l'image.

SapphireNow 2010 : SAP promet l'analyse en temps réel pour tous ses clients

Vishal Sikka, directeur technique de SAP, et assurément l'un des hommes forts de l'éditeur allemand d'ERP, a confirmé que la société préparait avec HP et IBM des « appliances » pour analyser en temps réel et en mémoire les données transactionnelles gérées dans ses différentes versions d'ERP. Ces équipements ne seront pas mis sur le marché avant la fin de l'année mais SAP va déjà proposer à certains de ses clients de les tester. L'annonce a été faite hier, à Francfort, dans le cadre de la conférence utilisateurs SapphireNow 2010, en duplex avec Orlando où se tenait le versant américain de l'événement.

L'émergence de ces technologies d'analyse en mémoire, capables d'opérer sur des volumes de données de l'ordre du téraoctet, en s'affranchissant donc des accès aux disques durs, résulte de la conjonction des avancées spectaculaires réalisées au cours des dernières années sur le matériel (processeurs, mémoires...). Le CTO (chief technology officer) de SAP énumère les processeurs multicoeurs qui permettent de disposer de 64 coeurs sur une seule lame (blade), en tournant à des fréquences de 2 à 3 GHz, et l'amélioration des performances sur les mémoires (capacité et rapidité -100 Go par seconde) conjuguée à la baisse radicale de leur coût. « Il est aujourd'hui possible de gérer jusqu'à 2 To sur une seule lame », souligne-t-il. A cela s'ajoute le stockage des données en colonnes qui, associée à des fonctions de compression des index, permet de réduire dans des proportions très importantes la taille nécessaire pour traiter en mémoire des milliards d'enregistrements. Vishal Sikka cite l'exemple d'un client gérant 4,7 milliards d'enregistrements, sur 74 000 tables. Le stockage en colonnes a permis de ramener ces données sur 250 Go de mémoire, ce qui correspond à des capacités couramment disponibles sur des serveurs lames actuellement.

« Pour tirer pleinement parti de ces avancées, nous avons réuni trois équipes de développement de SAP », a poursuivi le CTO. Outre celle qui travaille sur MaxDB (la base de données maison qui existe depuis maintenant 33 ans et tourne chez plusieurs milliers de clients de l'éditeur), il cite l'équipe qui a développé TRex, et élaboré il y a dix ans la première technologie de stockage en colonnes en mémoire de l'éditeur. « Le résultat combiné de leurs efforts a débouché sur une technologie capable de traiter en mémoire 2 Mo de données en une milliseconde par coeur en tirant avantage des processeurs multicoeurs. Vous imaginez la vitesse à laquelle le système peut parvenir en multipliant 2 Mo par 64 coeurs, sur des données stockées en colonnes et compressées, jusqu'à 10 à 50 fois ».

Des requêtes en temps réel sur des données transactionnelles

Le disque est ici utilisé comme un système de stockage secondaire, persistant, et le calcul sur les données se fait sans procéder à des agrégats. « Rien n'est matérialisé, ni stocké sur des couches intermédiaires, ce qui vous permet d'obtenir des réponses en temps réel sur les données. Vous pouvez ainsi procéder à des requêtes sur les données transactionnelles, des requêtes directes sur les données financières, par exemple. »

Les appliances, préparées avec HP et IBM, seront rattachées aux datawarehouses, mais aussi aux systèmes transactionnels qui exploitent SAP R/3. « Les données transactionnelles seront copiées dans une nouvelle base de données en mémoire et analysées en temps réel. Vous pourrez procéder à toutes les requêtes possibles et imaginer de nouveaux types d'applications dans les domaines de la planification, de l'optimisation, du prévisionnel ou encore de la simulation ». Des capacités que SAP souhaite apporter à l'ensemble de ses clients, quelle que soit la version de son ERP qu'ils utilisent.

SapphireNow 2010 : SAP garde le cap sur ByDesign 2.5 et l'analyse en mémoire

L'offre de rachat faite à Sybase braque opportunément les projecteurs sur SAP au moment où s'ouvre Sapphire, la conférence utilisateurs de l'éditeur d'ERP. Cent jours après avoir pris, au pied levé, la succession de Léo Apotheker remercié par le conseil d'administration, le tandem qui assure la direction du groupe se sait attendu sur plusieurs terrains. Les co-PDG Jim Hagemann Snabe et Bill McDermott se sont engagés à restaurer la confiance avec les clients, douchés par le vif contentieux ouvert sur le coût de la maintenance. Ils ont aussi promis de doper l'innovation et seront jugés sur pièces. Il convenait donc de donner à SapphireNow, l'édition 2010 de la conférence utilisateurs, une certaine solennité. L'événement se tient pour la première fois simultanément aux Etats-Unis en en Europe. Hier, les allocutions d'ouverture se sont faites en duplex entre Francfort et Orlando (Floride), avec un direct sur le Web. Au total, du 17 au 19 mai, SAP prévoit de réunir 50 000 participants, entre les rassemblements allemand et américain et le salon virtuel www.sapphirenow.com (où sont retransmis toutes les présentations et ateliers).

Business ByDesign 2.5 à la fin juillet

Il est coutume de convier à ces conférences des personnalités publiques qui viennent « faire le show ». Pour suivre le fil rouge du développement durable auquel il prétend, SAP a fait intervenir Richard Branson, fondateur de Virgin, et Al Gore, ancien vice-président des Etats-Unis, prix Nobel de la paix. Le premier parlait depuis Francfort, le deuxième depuis Orlando. Une heure plus tôt, un autre duplex avait été organisé pour une conférence de presse réunissant les co-PDG, ainsi que le directeur technique, Vishal Sikka. Ce dernier est, depuis les remaniements de février opérés à la direction de la société, le cinquième membre du conseil exécutif de SAP (executive board). Sans surprise, il fut question de mobilité, de bases de données d'un nouveau type et de traitements en mémoire (in-memory). C'est tout l'objet du rachat sur Sybase. Mais les dirigeants ont également insisté sur Business ByDesign, l'offre de gestion intégrée proposée en ligne aux PME et qui ne rassemble toujours qu'une centaine de clients (pour des questions de rentabilité, SAP limite pour l'instant le nombre d'utilisateurs sur sa plateforme).

[[page]]

La version 2.5 de Business ByDesign, en partie multitenant, sera disponible fin juillet. Elle disposera de fonctions analytiques contextuelles, exploitant la puissance du in-memory, et permettra une personnalisation plus poussée. Les partenaires pourront par ailleurs lui apporter des fonctions complémentaires [autour des outils de reporting]. Il faudra encore attendre plusieurs mois (2011 ?) pour une disponibilité générale de cette application (aujourd'hui disponible sur six pays seulement), mais Jim Hagemann Snabe a réitéré que, loin de se contenter d'être une solution de plus, concurrente des autres, elle va, ni plus ni moins, changer les règles sur le marché du « on demand ».

Sybase continuera à se développer

Revenant sur la transaction avec Sybase, le co-PDG insiste : « Nous n'avons pas acheté Sybase pour acquérir des parts de marché mais pour faire progresser la société. En matière de base de données, nous croyons fermement que l'on va faire évoluer la façon dont les données seront capturées, stockées et analysées, a-t-il indiqué faisant notamment référence au stockage en colonnes utilisé par Sybase pour sa base IQ. De son côté, Bill McDermott a assuré qu'il n'y aurait besoin de réaliser aucune synergie de coûts pour réaliser la fusion entre Sybase et SAP. « Il n'est ici question que de croissance, de satisfaction des clients et d'extension de notre champ d'action. Nous continuerons à fonctionner indépendamment afin que Sybase puisse continuer à se développer dans les solutions analytiques et la mobilité ». SAP, de son côté, restera totalement ouvert aux différentes bases de données, a-t-il réaffirmé. « Chaque société poursuivra sa croissance en tirant parti de ce rachat et on ne verra pas de gens démoralisés comme on a pu le voir dans d'autres cas », a-t-il ajouté en pointant en filigrane les licenciements et départs générés par le rachat de Sun par Oracle.

Le in-memory doit transformer l'usage des applications

Interrogé sur ce qui devrait résulter de concret de ce rachat, Jim Hagemann Snabe a rappelé que la technologie in-memory permettait d'accéder dix fois plus vite aux données placées en mémoire qu'à celles stockées sur disques durs. « Associée aux bases de données en colonnes, elle va permettre de créer des applications d'un nouveau type, apportant des capacités de simulation et capables d'explorer la totalité des données d'une entreprise sur plusieurs années », a-t-il évoqué. Il rappelle que SAP travaille depuis longtemps sur sa technologie in-memory d'abord appelée BI Accelerator (en 2008), puis BW Accelerator, mise l'an dernier au service de l'application décisionnelle Explorer (annoncée sur Sapphire 2009). « Nous l'utilisons en interne pour analyser notre pipeline [opportunités commerciales susceptibles de se réaliser] ».

[[page]]

Une réponse à Oracle Exadata en préparation ?

Interrogé sur le recours à ces technologies pour le datamining, Jim Hagemann Snabe souligne l'exigence de vitesse requise pour ces applications : « Imaginez ce que vous pourriez faire en accédant, sur un terminal mobile, à des fonctions d'analyse prédictive exploitant l'analyse de données en mémoire. C'est ce genre d'applications dont nous voulons tirer pleinement parti. » Des fonctions in-memory que l'on pourra donc exploiter sur les trois modes de déploiement que SAP promeut désormais avec ardeur : le classique « on-premise » (serveurs internes à l'entreprise), le « on-demand » et les terminaux mobiles.

Intervenant à plusieurs reprises aux côtés des co-PDG, en particulier pour réaffirmer la solidité des technologies Netweaver, le directeur technique Vishal Sikka a ajouté que des appliances (serveurs spécialisés) in-memory permettraient de réduire sensiblement le coût d'exploitation des technologies in-memory. Il indique que SAP travaille dans ce domaine avec HP, notamment, pour concurrencer des solutions comme celles que propose Oracle avec Exadata. Des précisions sur ces produits devraient être données ultérieurement, promet-il.

Pour ce SapphireNow, Jim Hagemann Snabe et Bill McDermott ont aussi prévu de faire des annonces : "raccorder les équipes de direction aux données du terrain", par les outils mobiles et les solutions analytiques, semble être l'un des mots d'ordre du moment.

SAP/Sybase : des points clés du rachat dans la mobilité, la BI et le cloud

Quels avantages SAP va-t-il tirer du rachat de Sybase et, à l'inverse, quelles difficultés risque-t-il de rencontrer ? L'acquisition de l'éditeur californien peut être appréhendée suivant différents axes. « Le volet mobilité de l'acquisition me semble être le plus important, car il n'y a pas encore d'acteurs vraiment installés sur ce terrain dans le secteur informatique, estime Jean-Michel Franco, directeur des offres chez Business & Decision. Il y a des places à prendre pour les acteurs du logiciel dans ce domaine. En atteste l'agitation actuelle autour des technologies Adobe sur le mobile. » Il constate que les trois grands acteurs face à SAP (Oracle, IBM, Microsoft) ne sont toujours pas parvenus à se positionner comme des acteurs incontournables sur les équipements mobiles. « Or, il va y avoir un besoin croissant dans ce domaine, que ce soit en termes d'applications (m-commerce, CRM...) que de business intelligence (moteurs de recommandation par exemple). »

Ce rachat peut, à terme, perturber le marché des bases de données

En revanche, Jean-Michel Franco considère que le volet bases de données de l'opération apparaît plus compliqué. « Le marché des SGBD est concentré sur Oracle, IBM et Microsoft et c'est un domaine assez conservateur. Sur la partie BI, il y a certes un besoin croissant de bases spécialisées, en particulier des bases axées sur le stockage en colonnes. Sybase IQ y a sa place, de même que la technologie in memory de SAP. Encore faudra-t-il faire converger ces deux technologies pour vraiment faire la différence. »

Jean-Michel Franco, directeur des offres de Business & Decision

[[page]]

On constate d'ailleurs un certain scepticisme parmi les réactions suscitées par le rachat de Sybase. Jean-Michel Franco relève que certains acteurs plus récents sur le marché, comme Workday (créé fin 2006 par Dave Duffield, fondateur de PeopleSoft), considèrent par exemple que la technologie SGBD de Sybase est relativement ancienne, et que le cloud computing nécessite des changements plus radicaux. « Ce qui peut être intéressant, c'est que ce rachat va mettre un peu de pression sur les trois acteurs principaux des bases de données. Sur la Business Intelligence, ceux-ci sont concurrencés par Teradata, Sybase et quelques nouveaux venus. Jusqu'à présent leur réponse passait par le hardware -Exadata pour Oracle, Smart Analytics pour IBM ou le rachat de Datallegro par Microsoft. Cette acquisition peut les amener à s'interroger sur leur stratégie... »

De fait, attaquer la question de l'optimisation des traitements par la base de données n'est pas une mauvaise idée. Le directeur des offres chez Business & Décision rappelle que les bases de données relationnelles reposent sur des technologies qui ont 25 ans et que, par ailleurs, les budgets de maintenance ne sont pas négligeables. « On peut penser, effectivement, qu'il existe là des éléments qui peuvent remettre en cause le marché des bases de données dans les prochaines années », considère-t-il. [[page]]

Pour SAP, sur les applications décisionnelles, Sybase IQ pourrait constituer une des options pour son application de datawarehouse BW. C'est, d'après Jean-Michel Franco, ancien collaborateur de SAP, quelque chose qui pourrait se faire assez vite. La base de données colonnes viendrait au-dessus de la base de données principale. « C'est ce qui semble le plus évident dans la probable feuille de route de SAP. Ensuite, il pourrait y avoir une solution hybride entre BW Accelerator et Sybase IQ. Toutefois, faire converger les deux technologies pourrait s'avérer plus compliqué. Il y a un intérêt à le faire, mais cela représente beaucoup de travail. »

Enfin, un autre aspect intéressant de l'acquisition de Sybase par SAP réside dans les développements réalisés par Sybase pour supporter les technologies de cloud. C'est un point que souligne notamment l'analyste Ray Wang, d'Altimeter, en rappelant que l'éditeur californien a noué un partenariat autour d'Amazon EC2. « Or, la possibilité d'avoir une application SAP qui fonctionne en mode IaaS (infrastructure as a server) pourrait faire basculer les clients SAP vers des bases de données différentes de celles qu'ils utilisent historiquement, fait remarquer Jean-Michel. Dans les quatre à cinq ans, cela peut perturber le marché. On voit bien actuellement que tous les fournisseurs de cloud ne sont pas sur des bases relationnelles parce qu'elles manquent de puissance dans les montées en charge. » Les acteurs de l'Internet, comme Twitter ou Digg, misent aussi sur des bases NoSQL.

« Je ne sais pas si Sybase dispose d'une véritable avance dans ce domaine, mais, si c'est le cas, cela pourrait aussi expliquer le rachat par SAP. Jim Hagemann Snabe a encore rappelé, il y a peu que SAP comptait être un leader dans le SaaS dans les cinq ans. Sybase constitue-t-il un pas en avant dans ce sens ? ».

Core Security trouve les patchs «cachés» de Microsoft

Deux des trois vulnérabilités, dont la plus sérieuse, ont été intégrées à la mise à jour MS10-024 que Microsoft a livré le 13 avril dernier pour corriger des bugs dans Exchange et Windows SMTP Service. L'éditeur avait même qualifié ces correctifs d'«importants», le second rang dans son classement des menaces. Selon Ivan Arce, chef de la technologie chez Core Security Technologies, Microsoft a corrigé ces bugs en omettant de le faire savoir. Selon lui, «ces correctifs étaient plus importants que les deux [vulnérabilités] dont Microsoft a fait état. Cela signifie que les administrateurs système n'ont pas disposé de cette information pour évaluer le risque, ce qui les a peut-être amenés à prendre de mauvaises décisions quant à l'application de cette mise à jour. »

Nicolas Economou, chercheur chez Core Labs, a découvert les deux bugs « anonymes » en fouillant dans la mise à jour. Cette activité fait partie de son job chez Core, où il réalise des tests de pénétration, les Core Impact, réputés pour mettre à jour les vulnérabilités potentielles des ordinateurs et des réseaux en les plaçant en situation d'attaques réelles. « Un attaquant peut facilement exploiter les deux vulnérabilités non divulguées antérieurement et réparées par le patch MS10-024 pour tromper les réponses à toute requête DNS envoyées par le service SMTP de Windows, » a déclaré Core, suite à la découverte de son chercheur. «L'usurpation de la réponse DNS et les attaques par contamination du cache sont aussi connues pour provoquer une variété de problèmes de sécurité ayant un impact qui dépasse le déni de service et la divulgation d'informations, comme l'indiquait à l'origine le document accompagnant le patch. » La contamination du cache DNS est une tactique d'attaque qui ne date pas d'hier - elle remonte à près de deux décennies - mais elle est probablement mieux connue pour les vulnérabilités critiques qu'elle produit sur le DNS Internet, comme l'a découvert Dan Kaminsky en 2008.

[[page]]

Les correctifs appliqués en secret ne sont ni nouveaux, ni rares. « C'est ce qui s'est passé pendant de nombreuses années et cette modalité en soi n'a rien du complot, » a déclaré Andrew Storms, directeur des opérations de sécurité chez nCircle Security. Ce qui est plus inhabituel, c'est que Core ait rendu la mise à jour « cachée » de Microsoft publique. En déclarant que Microsoft a « caché» et « sous-estimé» le degré de menace corrigé par le MS10-024, Core exhorte les administrateurs à «envisager de réévaluer les priorités pour le déploiement de ce patch. » Dans l'autre mise à jour MS10-028 publiée le 13 avril, Core a également débusqué un correctif non déclaré qui répare deux bugs identifiés dans Microsoft Visio, le logiciel de création de diagrammes de Microsoft.

Microsoft a reconnu avoir corrigé ces défauts à l'insu de ses clients, et s'est défendu en déclarant : «Quand une faille est découverte, Microsoft mène une enquête approfondie sur cette vulnérabilité. A la suite de quoi elle peut être amenée à modifier d'autres éléments du code et soumet alors les mises à jour de sécurité à de nombreux tests pour s'assurer de leur qualité, » a déclaré Jerry Bryant, en charge de la sécurité des programmes, dans un mail. « Cela permet de limiter le nombre de mises à jour que les clients auront à déployer, dans la mesure où elle peut perturber l'environnement dans lequel le client exerce son activité » Si la faille interne découverte nécessite une action distincte ou une orientation particulière qui ne sont pas déjà couvertes par les autres vulnérabilités, «nous documentons et réglons cette vulnérabilité séparément, » a déclaré Jerry Bryant.

[[page]]

« La vérité est que, comme d'habitude, les affaires sont les affaires, et pas seulement pour Microsoft, mais pour la plupart des éditeurs de logiciels, » a déclaré Andrew Storm. « Les vendeurs trouvent souvent eux-mêmes les bogues dans leur code et distribuent ensuite les correctifs dans une mise à jour d'ensemble, » fait-il remarquer. « La plupart du temps, il n'y a tout simplement aucun avantage à divulguer la nature du bug. » En fait, « la politique de Microsoft est de ne pas attribuer d'identifiant destiné à figurer dans la base de données «Common Vulnerabilities and Exposures » (CVE) pour des failles constatées par ses chercheurs, » a déclaré Andrew Storms. « Un vendeur n'a pas l'obligation de demander un CVE pour les bugs identifiés en interne, » a t-il ajouté.

Faisant écho aux préoccupations de Ivan Arce au sujet d'un éventuel détournement de cette pratique, laquelle pourrait se traduire par un faux sentiment de sécurité chez les utilisateurs, il répond que « la question est de savoir si le vendeur qui cache le risque, retarde la nécessité d'appliquer la mise à jour. Par exemple, si un patch d'IE8 qualifié de « modéré »par Microsoft contient également le correctif d'une faille critique, cette évaluation sous cotée peut-elle exposer les utilisateurs à un risque, dans la mesure où ils pensent pouvoir retarder l'application du patch, puisqu'ils n'ont aucune idée de la faille critique réparée en même temps ? » Ivan Arce soutient que c'est exactement ce que Microsoft fait avec la MS10-024. « Il y a deux ans, en 2008, Microsoft a corrigé une vulnérabilité très similaire avec le patch MS08-037, » dit-il, celui-là même qui réparait la faille dans le DNS découverte par Kaminsky. « Si ce n'était pas une faille, alors, pourquoi ont-ils émis un bulletin de vulnérabilité ? » a t-il demandé. « En aucune manière, ils ne peuvent dire que ce n'est pas un problème de sécurité. »

« Que ce soit côté éditeur ou côté client, il n'y a pas de réponse facile,» a ajouté Andrew Storm. « Si le vendeur livre un patch critique en donnant peu d'informations, comme ça a été le cas d'Adobe par exemple, nous harcelons le vendeur pour savoir ce qu'il contient. D'autre part, compte tenu de la charge de travail des équipes de sécurité au sein des entreprises, nous devons pouvoir faire confiance à l'estimation du vendeur pour déterminer la priorité à donner à sa mise à jour. »

Les points de vue de Core sur les patch MS10-024, MS10 -028 sont disponibles sur son site web.

(...)(06/05/2010 09:15:46)Semestriels Sage : Tassement au niveau des abonnements aux services

Pour le compte du premier semestre de son exercice 2010 (clos le 31 mars), l'éditeur de logiciels de gestion a réalisé un chiffre d'affaires de 719 M£ en baisse de 2% sur un an. C'est au niveau des abonnements aux différents services proposés par l'éditeur (par exemple les contrats d'assistance et de maintenance) que la baisses des revenus est la plus sensible. Elle atteint - 8,6% à 247,8 M£. Également en recul léger de 1,2%, les ventes de licences et les services associés ont dégagé un chiffre d'affaires semestrielles de 471 M£. Pour Sage, ce résultat est à considérer comme une bonne performance, notamment si l'on considère que son chiffre d'affaires avait chuté de 6% lors du premier semestre de son exercice 2009.

Durant les six premiers mois de l'exercice en cours, la marge brute a atteint 666 M£, soit 25 M£ de moins qu'il y a un an. En revanche, le résultat opérationnel est en hausse de 10,5% à 164 M£. L'EBITA progresse également, de 8%, à 181,9 M£.

En France, le chiffre d'affaires semestriel de Sage s'est élevé à 161,1 M€, affichant ainsi une progression de 1%. L'EBITA a progressé de 6% pour s'établir à 37 M€. Ce résultat place l'hexagone au dessus de la progression moyenne enregistrée par l'activité de l'éditeur sur l'ensemble de l'Europe (hors Royaume-Uni et Irlande) où le chiffre d'affaire a reculé de 0,45% (268.8 M£).

(...)

Observatoire du cloud : CA et IDC scannent la maturité des entreprises

« Après l'évangélisation vient le temps de la mesure régulière de la maturité des entreprises » prévient François Trouillet, directeur marketing Europe du Sud de l'éditeur CA. Dans cette optique, la « cloud academy » organisée deux fois par an par CA et divers partenaires (comme le cabinet Revevol) se dote d'un nouvel outil : un « observatoire du Cloud » réalisé par le cabinet d'études IDC. Publié le même jour que l'étude de Markess, cette synthèse qui arrive après celle réalisée par PAC pour le compte de VMware, Intel et EMC et juste avant le livre blanc du Syntec sur la question (à l'occasion du salon Datacenter Cloud Computing au Cnit les 5 et 6 mai 210). Les nuages sont vraiment dans l'air du temps.

L'adoption du modèle du cloud rentre ainsi dans la norme des autres modèles. La réduction des coûts était la justification quasi-unique du passage au cloud mais retrouve désormais une place plus ordinaire parmi les motivations diverses, derrière, par exemple, l'efficacité du SI, même si les DG sont encore axés sur les coûts avant tout. Amélioration de la réactivité, optimisation de l'infrastructure et du portefeuille applicatif, bref l'agilité, sont des priorités de la DSI quand elle choisit le cloud. Innovation et Green-IT sont, par contre, jugés très secondaires.

[[page]]

L'infrastructure, de plus en plus complexe, est également de plus en plus externalisée, d'abord pour déléguer cette complexité et l'hétérogénéité induite. L'absence de recours à des prestataires ne concerne désormais plus que 30% des entreprises et continue de chuter même si la délégation totale à des prestataires est encore très marginale (7% seulement).

Le cloud est jugé connu dans ses principes généraux mais les entreprises s'intéressent et connaissent prioritairement le SaaS (27% ont mis en oeuvre et seul un tiers ne s'y intéresse pas encore). PaaS et IaaS n'intéressent pas encore les deux tiers des entreprises et quasiment aucune n'en ont mis en oeuvre. La problématique de la sécurité au sens strict et technique est en régression au profit de la gestion de la confidentialité et des droits d'accès. Même si 55% des entreprises ne peuvent pas envisager autre chose qu'un cloud privé, le principe de « mettre dans les nuages » des éléments du SI n'est plus une hérésie.

Illustration : crédits D.R. (...)

Le cloud et le SaaS étendent leur périmètre applicatif

Le cabinet Markess dévoile - le même jour que CA et IDC - une étude sur le SaaS (software as a service), une notion désormais englobée, avec ses consoeurs IaaS (infrastructure) et PaaS (platform), dans celle du cloud computing. L'étude est basée sur 330 interviews menées en ligne au cours des deux derniers mois et complétée par les études menées par le cabinet en parallèle (stockage, sauvegarde, archivage ...). Rappelons également que PAC avait présenté une synthèse fort intéressante sur le sujet le 8 avril dernier et que le Syntec dévoilera son livre blanc sur la question à l'occasion du salon Datacenter Cloud Computing (au Cnit les 5 et 6 ami 2010)

Le premier enseignement est d'ordre quantitatif. Le marché des services concernés par le cloud computing se montait à 1,200 milliard d'euros en 2008 en France, il va atteindre 1,860 milliard d'euros en 2010 et passer à 2,730 en 2012. A l'intérieur de ce marché, c'est le SaaS qui progresse le plus. Et à l'intérieur du SaaS, on retrouve d'année en année (de 2008 à 2010) le même groupe de tête, celui du collaboratif : messagerie, agenda partagé, gestion de projet, web conference.

Derrière, figurait jusqu'alors les applications liées aux ressources humaines : gestion des recrutements des talents et de la paie. Entre 2010 et 2012, les applications liées à l'informatique de base : sécurité, sauvegarde, pilotage, supervision, tests, vont arriver au deuxième rang. C'est la grande nouveauté qualitative issue de l'étude. Deuxième donnée, la demande devrait se porter sur des applications transverses, mais utilisées en mode SaaS. Markess cite : la collaboration d'entreprise, les applications sociales, la communication vocale, les applications bureautiques, la gestion de contenu d'entreprise, l'analytique et le décisionnel.

Illustration : crédits D.R.

(...)(04/05/2010 18:07:05)SAP France entame l'année avec confiance

Au premier trimestre 2010, le chiffre d'affaires de SAP France s'établit à 107 millions d'euros en croissance de 7% - par rapport à la même période l'année dernière - quand l'Allemagne ne dépasse pas 3% et les USA seulement 2%. Pour le monde, la croissance s'affiche à 5% (+ 3% à chiffres constants). Interrogé sur les raisons de cette progression en France, Nicolas Sekkaki a simplement souligné que « les clients ont modernisé leurs infrastructures après de nombreux mois d'attente. En proie à des difficultés financières, certaines entreprises ont même décidé de passer à l'acte pour accélérer leur réorganisation et faire face aux enjeux ».

Le secteur que SAP qualifie de stratégique (services publics, banque/assurance et distribution) a apporté une croissance de 82% (50% en BI et 50% en ERP). Dans le monde bancaire, la BI est très présente mais pas encore les ERP, SAP France va donc s'atteler à développer le marché. Toujours dans la banque, les performances ont par contre été à 3 chiffres dans le secteur du cost management avec des affaires à la MAIF et chez Groupama pour mieux piloter les structures de coûts (PCM). Pour le second semestre, SAP France affiche également de grandes ambitions sur le secteur de la distribution. Toujours en PCM, le secteur public a connu de très belles références au 1er trimestre avec notamment la signature d'un contrat au Ministère de la Défense. L'Éducation Nationale, de son coté, a confirmé son engagement pour des solutions de BI et de gestion des RH.

[[page]]Le mois de mars a connu une forte accélération avec + 30% de hausse sur la vente de licences et + 12% pour la partie software et support. « Les pays émergeants et la Grande Bretagne connaissent aujourd'hui également une forte croissance. (...) En France, il n'y a pas d'affaires qui dépassent les 5 millions d'euros à la différence de l'Angleterre ou de la Russie qui affiche même des déploiements à 10 millions d'euros. En Allemagne, le marché de l'ERP est arrivé à maturité et ce sont les solutions de BI qui assurent notre croissance. Dans l'hexagone, le chemin de la croissance passe encore par les ERP, notamment sur le marché des PME-PMI, et la BI. Si le Syntec annonce une croissance de de 2% sur le software dont 1% sur l'applicatif, nous attendons de 2% à 4% de hausse dans le monde et la France se situe dans la fourchette haute. Nous sommes bien positionnés par rapport à notre marché et sur la vente de licences pure, nous attendons de bonnes affaires. En France, deux dynamiques sont à l'oeuvre. Sur la partie volume nous attendons plus de contrats de moins de 500 K€, notamment en BI. Avec les grands groupes, on constate une segmentation d'affaires avec un panier moyen en baisse, de 500 K€ à 2 millions. Les contrats de plus de 5 millions deviennent difficiles à trouver. » Au niveau monde avec l'accélération des fusions/acquisition, SAP attend encore des affaires à plus de 100 millions d'euros avec un très grand nombre d'utilisateurs.

Sur le marché des PME-PMI, le dirigeant français avoue que la croissance n'a pas été celle attendue. « On n'a pas encore déployé tous les bons leviers. 62% de nos revenus dans ce secteur proviennent de nos partenaires (contre 50% en 2009). L'objectif est de passer à 75%, notamment avec le recrutement de master vars qui regrouperont des revendeurs géographiques.. Un message pas vraiment nouveau puisque l'éditeur nous avait déjà confié en octobre dernier qu'il comptait développer son réseau pour pousser son offre Business ByDesign. Conçu pour les PME-PMI et les filiales de grands groupes, cet ERP en mode hébergé a séduit trois clients depuis le début de l'année sur un objectif annuel de dix ! Quinze affaires ont d'ailleurs été conclues en 2009, le plan de développement semble particulièrement conservateur.

SAP attend aujourd'hui l'arrivée de la version 2.5 pour pousser cette offre. « Si ces solutions mobilisent trop de ressources, on perd de l'argent et ce n'est pas vraiment l'objectif » explique le dirigeant français. « Nous allons redéfinir le socle technologique pour réduire les coûts de ByDesign. Notre rôle est avant tout d'aider nos clients à atteindre leurs objectifs de manière efficace en leur proposant des solutions aux meilleurs coûts, et non pas de vendre à perte. »

[[page]]

Revenant sur la révolte des clients obligés de passer à l'Enterprise Support, « une offre qui aurait été mal expliquée aux destinataires », Nicolas Sekkaki précise que 91% des clients ont adopté ce contrat en France. Après une première grogne, l'objectif initial de 75% a donc été dépassé. L'arrivée du transfuge de Big Blue est l'occasion de remettre à plat les relations avec les clients, notamment avec l'USF. L'arrivée d'un nouveau président - Claude Molly-Mitton a remplacé Jean Leroux - permettra peut-être d'apaiser les choses. Nicolas Sekkaki a d'ailleurs réservé sa première sortie - en tant que PDG de SAP France - à l'USF. « Nos clients doivent se reconnaitre dans SAP même s'ils n'ont pas d'ERP. Nous avons une vision à partager avec nos utilisateurs, notamment la synergie entre la gestion de la donnée et l'ERP. » Reste à savoir si les clubs utilisateurs sont prêts à écouter le message.

Un autre pas a été franchi avec l'amélioration de la communication sur les produits à venir. « Nous allons partager avec nos gros clients l'évolution et les développements des produits à venir dans les deux à trois ans. Les clubs utilisateurs désirent influencer l'éditeur et nous sommes aujourd'hui à l'écoute de leurs demandes. L'idée n'est pas de réaliser des développements spécifiques, mais d'ouvrir les portes pour donner plus de visibilité. Nous offrons aujourd'hui des solutions adaptées aux différents métiers de nos clients avec des fonctionnalités spécifiques. » Les clubs utilisateurs britanniques et irlandais ont déjà indiqué qu'ils allaient travailler avec le réseau Sugen pour davantage peser sur la feuille de route de l'éditeur allemand. Nous attendons encore la réaction de l'USF sur ce dernier point.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |