Flux RSS

108538 documents trouvés, affichage des résultats 351 à 360.

| < Les 10 documents précédents | Les 10 documents suivants > |

(30/03/2012 10:21:20)

Infogérance d'infrastructure : SCC va renforcer son Service Desk

Composé 80 techniciens aujourd'hui, l'effectif du centre de support technique (service desk) mutualisé que SCC héberge dans ses locaux de Lieusaint (77) devrait passer à 150 personnes d'ici la fin 2013. Le revendeur grands comptes à déjà bien balisé son plan d'embauche de techniciens et d'ingénieurs en programmant trois sessions de recrutement. La première s'achèvera fin avril et vise l'entrée de 35 nouveaux collaborateurs dans la société. La seconde se terminera fin 2012 avec en ligne de mire le ralliement de 15 personnes. Enfin, une vingtaine d'autres personnes devraient être recrutées d'ici la fin 2013.

En embauchant de la sorte, SCC anticipe sur la forte croissance d'activité qu'il attend de son service Desk dans l'année et demie qui vient. A l'issue cette période, le chiffre d'affaires de cette structure qui compte actuellement une centaine de client devrait avoir été multiplié par deux. Elle le devra notamment à la récente signature d'un contrat d'importance avec un client industriel qui va monopoliser à lui seul 40 collaborateurs du support technique de Lieusaint. (...)

Annuels SQLI : La SSII améliore sa rentabilité malgré un CA en baisse

SQLI confirme les résultats préliminaires envisagés il y a un mois. La SSII annonce une baisse de 5,4% de son chiffre d'affaires (CA) annuel à 164,7 millions d'euros. A périmètre comparable, les facturations sont en léger repli de 0,2%. La société explique s'être recentrée sur des activités stratégiques et l'amélioration de sa gestion (hausse du taux d'activité et baisse des frais de structure).

Les chiffres de la rentabilité sont positifs. Le résultat opérationnel courant grimpe de 5,7%, à 8,3 millions d'euros. Le résultat opérationnel progresse de 7,9% à 8,2 M€. Le résultat net part du groupe est en hausse de 5,9% à 4,1 M€. Le groupe tire un trait sur deux exercices annuels déficitaires.

SQLI aborde 2012 dans de meilleures conditions. La société a engagé un plan stratégique, le plan Boost qui en est à sa deuxième phase. Après celle de la rationalisation, elle entame celle de l'efficacité opérationnelle, marquée par de meilleures synergies entre les différentes entités. Elle n'exclut pas des opérations de croissance externe.

(...)(29/03/2012 10:50:43)Silicon Valley 2012 : NAS optimisé pour le cloud chez Avere Systems

Fondée en janvier 2008 par Ronald P.Bianchini - actuel CEO et ancien co-fondateur de Spinnaker Networks, une société acquise par NetApp - la start-up Avere Systems annonce la version 3.0 de son architecture de stockage NAS multi-tiers. Pour améliorer les performances et mieux gérer l'espace disponible, cette solution déplace automatiquement les données entre les quatre différents types de stockage (SAS, RAM, SSD et SATA). L'appliance maison baptisée FXT assure le travail d'optimisation de manière automatique. « Vous n'avez pas à définir des politiques. Nous examinons les blocs comme ils se déplacent entre l'application et le serveur de stockage et nous déterminons où ils vont sur la base de la fréquence d'accès et les caractéristiques des données », nous a indiqué le dirigeant.

Un défi auquel sont aujourd'hui confrontés les clients est que la croissance de la capacité des disques a plus rapide que des performances ce qui les obliger à acheter plus de stockage que nécessaire pour atteindre les performances requises, indique Ronald Bianchini. Les taux d'utilisation peuvent être améliorés en déplaçant intelligemment les données à travers différents niveaux en fonction des besoins changeants, assure-t-il.

Combiner RAM, SAS, SSD et SATA

La série FXT utilise la mémoire vive pour la lecture et l'écriture des petits fichiers; les SSD et les SAS pour la lecture et l'écriture aléatoires des gros fichiers, et des disques SAS pour la lecture et l'écriture séquentielles des gros fichiers. Les besoins en archivage sont assurés par les disques SATA. Le système FXT lui-même comprend la RAM, les SSD et les SAS. Les clients achètent les disques SATA séparément, et le tout est géré par le logiciel Avere. Les sauvegardes habituelles des clients et les processus de mise en miroir restent les mêmes.

Avec la version 3.0 de sa solution, Avere transforme son appliance - rebaptisée FXT Edge Filer - pour mieux gérer les avantages issus de la consolidation offerte par la virtualisation et du cloud. Les nouvelles fonctionnalités de gestion de données disponibles avec l'AOS 3.0 permettent aux clients de facilement déplacer, synchroniser et répliquer les données entre les baies de stockage, les centres de calcul au centre de données proche ou à distant et le cloud. Avere surmonte l'approche traditionnelle et coûteuse qui consiste à ajouter toujours plus de contrôleurs et de stockage pour améliorer les performances. Cela renforce la complexité des datacenters et ne résout en rien les problèmes de latence entre les sites distants, notamment avec les clouds de stockage utilisés pour la sauvegarde et l'archivage. AOS 3.0 propose également une fonction Flashmirror, l'écriture simultanée sur plusieurs supports - local et distant - pour éviter la moindre perte de données.

Avere propose donc une évolution de son architecture NAS qui ambitionne d'éliminer les compromis entre performance et coût et s'assure que le stockage primaire est bien situé là où il a le plus de sens - au niveau économique - pour les entreprises. M. Bianchini revendique une centaine de déploiements aujourd'hui. La start-up est soutenue par Menlo Ventures et Norwest Venture Partners.

(...)(29/03/2012 10:44:10)

Silicon Valley 2012 : Nicira, un joyau parmi les start-ups de la virtualisation réseau

Le lancement de la start-up Nicira Networks (vigilance en sanscrit) en 2008 était un des plus attendus dans la Silicon Valley. Elle a été fondée par les chercheurs Martin Casado et Nick McKeown, de l'Université Stanford, et Scott Shenker, de l'Université de Californie à Berkeley. La société a levé près de 50 millions de dollars auprès d'investisseurs comme Andreessen Horowitz, Lightspeed Venture Partners, ou encore AEN, et attiré des sommités de l'industrie numérique, Diane Greene (co-fondatrice de VMware) et Andy Rachleff. Greene (fondateur de Benchmark Capital).

Pourquoi cet enthousiasme : la start-up s'est attaquée à un verrou qui ralentit aujourd'hui les performances et donc le développement du cloud ; la virtualisation du réseau. Nicira ambitionne tout simplement d'assurer la virtualisation du réseau d'un datacenter, de sorte que le réseau peut devenir plus agile et facilement portable pour supporter la mobilité des machines virtuelles et la variation de la charge de travail au sein et entre les centres de calcul.

Un modèle VMware

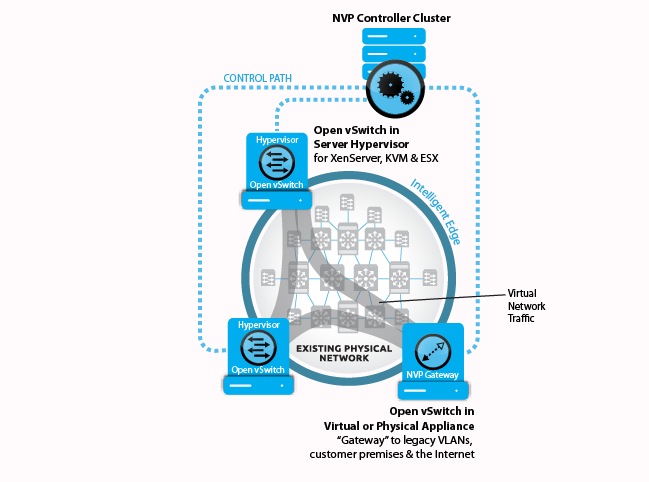

La start-up est par exemple à l'origine des initiatives OpenFlow et OpenSwitch. En substance donc, Nicira veut faire pour le réseau ce que VMware a fait pour les serveurs : employer le même modèle opérationnel de VM afin de segmenter le réseau pour déplacer des switchs sans interruption de service. Nicira explique que cela va enlever le goulot d'étranglement qui pénalise le dynamique cloud computing à la demande, c'est-à-dire les architectures réseau complexes, intégrées verticalement, fragiles et coûteuses. « Le réseau est la barrière vers le cloud », nous a expliqué Alan Cohen, vice-président marketing chez Nicira. « La configuration du réseau est difficile » quand les machines virtuelles sont mobiles ou lors de la fourniture de services à un nouvel utilisateur. «Il faut en moyenne sept jours pour mettre en place un réseau pour une nouvelle application ». Avec la virtualisation, cela ne devrait prendre que 30 secondes pour préparer le réseau pour une nouvelle application, souligne le dirigeant. C'est l'objectif de NVP la plate-forme de virtualisation de réseaux de Nicira , un logiciel installé sur des serveurs dédiés pour gérer les commutateurs virtuels des serveurs du centre de calcul.

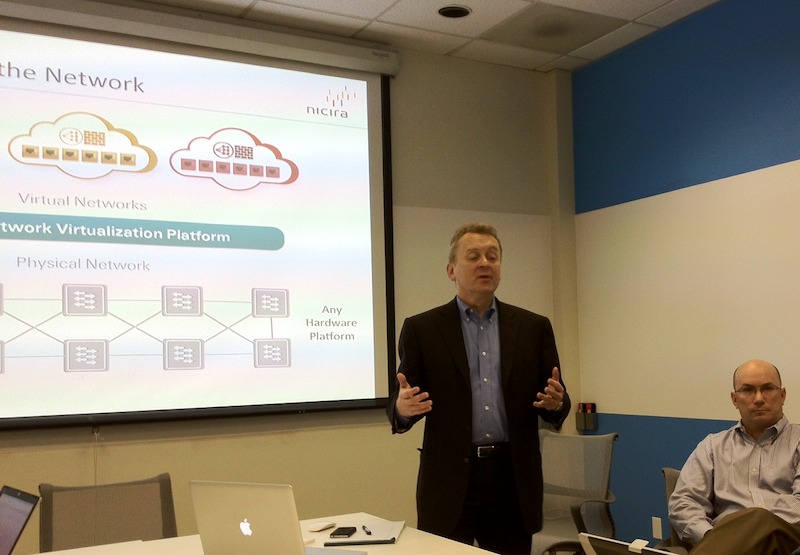

Alan Cohen, vice-président marketing chez Nicira

Piloter les switchs depuis un serveur dédié

NVP reproduit toutes les caractéristiques du réseau d'un datacenter physique - telles que les politiques de sécurité, la qualité de service (QoS), la couche 2 pour l'accessibilité et des capacités de services de niveau supérieur telles qu'un pare-feu complet - et inclut des API pour les hyperviseurs et les outils d'orchestration pour coordonner le fonctionnement avec le monde virtuel. Nicira pousse également son API OpenFlow dans les datacenters pour être en mesure d'accéder, de manipuler et de tester les routeurs et les commutateurs pour diriger le trafic sur les réseaux. Pour les outils d'orchestration, Nicira avance son l'API de son projet Quantum qui entre dans le cahier des charges OpenStack pour définir un cloud Open Source. Une initiative auquel Nicira participe activement.

Le travail de Martin Casado à Stanford, aujourd'hui CTO de Nicira, a conduit à la création d'OpenFlow, un catalyseur de réseau comme le définit le concept SDN (Software-Defined Networking). Ce protocole a été initié en 2007 par l'université de Stanford pour gérer les réseaux entre les campus universitaires. Depuis 2011, une fondation baptisée ONF (Open Networking Foundation) regroupe plusieurs acteurs de l'IT, Facebook, Google, Microsoft, Deutsche Telekom, Yahoo, Broadcom, Brocade, Ciena, Extreme Networks, Citrix, Dell, Ericsson, Force10, HP, IBM, Juniper, Marvell, NEC, Netgear, Verizon et VMware, travaillent sur autre approche du réseau, autour du concept de SDN (Software Defined Networking). Le Software-Defined Networking permet à un contrôleur externe de diriger toute l'infrastructure de commutation et/ou de routage. Il permet de programmer et de configurer le logiciel au niveau de chaque élément du réseau sans intervention manuelle.

[[page]]

Cisco qui voit remise en cause sa mainmise sur les switchs pour Datacenter est bien sûr absent de ce projet et travaille avec une start-up interne sur une solution concurrente. Mais l'impact du SDN sur l'industrie de réseau, dont Cisco est le fournisseur dominant, ne se fera sentir que dans plusieurs années. Au final, l'intelligence du réseau sera aspirée hors de la configuration matérielle et logée dans les contrôleurs à la périphérie du réseau, agissant comme un cerveau de niveau 3 meilleur marché que les matrices de commutation IP. Cisco se prépare donc activement à l'émergence d'OpenFlow et du SDN. Comme nous l'avons déjà précisé, l'équipementier a déclaré son intention d'ajouter le support du protocole OpenFlow dans ses commutateurs Nexus, mais au-delà, ses plans pour contrer la menace du SDN ne sont pas très clairs.

NVP et SDN permettent de traiter le réseau physique comme un fond de panier IP. Cela permet la création dynamique de réseaux virtuels qui soutiennent la mobilité des VM au sein ou entre les centres de calcul sans interruption de service ou de changement d'adresse, souligne Nicira. Les approches traditionnelles - le domaine de Cisco - peuvent laisser sous-utilisées de 20% à 30% des capacités serveurs dans les datacenters ce qui contribue à faire grimper les coûts du réseau, selon Nicira. La société affirme qu'avec sa solution NVP, il est possible de récupérer jusqu'à 20 millions de dollars en coûts d'immobilisation et d'exploitation dans une datacenter avec 40 000 services et un million de machines virtuelles.

NVP est compatible avec n'importe quel équipement réseau pour datacenter, avance la start-up, et peut être déployé sans interruption sur n'importe quel réseau existant. Il permet également aux futurs changements au matériel de réseau sans perturber les opérations du réseau virtuel, avance encore Nicira. Disponible depuis juillet dernier, NVP est en cours d'utilisation chez AT&T, eBay, Fidelity Investments, NTT et Rackspace. (...)

Silicon Valley 2012 : Ring 4 chez Scality, Big data chez RainStor et stockage flash chez Nimbus Data

Première étape dans le quartier d'affaire de San Francisco pour rencontrer une nouvelle fois Jérôme Lecat, le CEO de Scality. L'occasion de parler de Ring 4.0, la dernière version de la solution de stockage scale-out poussée par la start-up franco-californienne. Cette société spécialisée dans le stockage cloud présente comme particularité de faire travailler des ingénieurs français qui sont moins chers et beaucoup plus productifs que leurs homologues américains selon Jérôme Lecat. Un écho que nous avions déjà eu l'année dernière auprès de jeunes entrepreneurs rencontrés dans un incubateur de start-ups à Sunnyvale. Une quarantaine de personnes travaillent déjà pour Scality des deux côtés de l'Atlantique et cette équipe sera bientôt renforcée par l'arrivée d'un nom bien connu dans le milieu du stockage en tant que directeur de la stratégie produit.

Alternative meilleur marché au SAN, le RING de Scality se présente toujours comme une plate-forme de stockage distribué à travers des noeuds de serveurs Linux x86 standards. Pour la version 4.0 plusieurs points ont été revus. " Le travail a commencé, il y a un an pour certains composants comme le système de fichiers. Pour ce dernier, nous ne sommes pas repartis de zéro, c'était trop de travail de tout reconstruire. Nous nous sommes concentrés sur certains points comme le déplacement des gros fichiers. Nous développons également une solution NFS qui n'est pas encore prête, mais qui sera très utile pour nos clients ".

Evolution de l'anneau de Scality

Ring 4.0 propose une architecture qui diffère des précédentes versions avec un anneau supplémentaire dédié à la gestion des métadonnées (le ring app server), mais toujours en liaison avec les noeuds de stockage de l'anneau principal (le data ring). Et pour réduire le temps de latence, ce second ring, celui des métadonnées, utilise des disques flash pour accélérer l'accès aux données. S'appuyant sur une étude préliminaire réalisée par le cabinet d'étude ESG Lab, Jérôme Lecat annonce un temps de réponse de 7,05 ms. La version finale de ce rapport sera publiée à l'occasion du prochain Storage Networking World (du 2 au 5 avril à Dallas). Cette étude souligne également que cette architecture de stockage distribuée assure des performances élevées en terme d'IOPS pour l'accès à de petits fichiers et fournit une bande passante élevée pour l'accès à de gros fichiers.

Depuis son lancement, Scality gère un pétaoctet de données chez les clients : chez France Télévision par exemple avec des noeuds répartis dans des centres en France métropolitaine et dans les territoires d'outre-mer. Pour assurer son avenir, la société a toutefois besoin de passer à la vitesse supérieure avec des ventes de plusieurs pétaoctets. Le dirigeant se montre confiant sur le sujet avec des projections optimistes et un coût aux 100 To très compétitif face à une solution NAS (950 000 dollars contre 180 000 dollars pour Scality selon une étude Forrester). Face à un Amazon S3 les tarifs sont plus proches (180 000 dollars également), mais Scality permet ici de créer son cloud de stockage privé.

[[page]]

Une base de donnée Hadoop ready chez RainStor

Nous avons poursuivi la journée avec une visite chez RainStor, toujours à San Francisco. Fondée par des Britanniques, cette start-up propose une base de données SQL spécialement taillée pour le big data et le traitement décisionnel.

Multistructure, la solution de RainStor supporte nativement le système de fichiers HDFS, celui d'Hadoop. Rappelons qu'Hadoop est un agrégateur Open Source de données structurées et non structurées qui permettent d'analyser d'énormes volumes d'informations. En exécutant sa base de données nativement sur Hadoop, RainStor indique qu'il est possible d'interroger et d'analyser plus rapidement ces informations multi-structurées.

Mark Cusack, chief architect, et John Bantleman, CEO de RainStor

John Bandleman, le CEO de la compagnie, nous a expliqué qu'un des points forts de sa base est la compression drastique des données (dans un ratio de 40:1) et ce afin de réduire les coûts de possession du stockage. Second étage de la solution l'analytique avec une passerelle SQL et Oracle vers MapReduce. Cela concerne l'ensemble des données compressées, à la fois structurées et non structurées, en cours d'exécution les clusters HDFS.

Deux baies de stockage 100% flash

Nous avons terminé notre journée avec une dernière rencontre avec Nimbus Data dans un hôtel de la Silicon Valley en état de siège. Mitt Romney organisait en effet un diner à 25 000 dollars le couvert pour lever des fonds pour sa campagne à l'investiture républicaine pour la prochaine élection présidentielle américaine. Cernés par les manifestants, les membres des services secrets et la police du comté de Redwood City, nous avons pu discuter avec Thomas Isakovitch, le CEO de Nimbus Data, de ses baies de stockage flash.

[[page]]

Avec les E-Class (classe entreprise), la start-up propose un système de stockage entièrement redondant d'une capacité de 10 à 500 To reposant sur des modules flash EMLC (400 ou 800 Go) dotés d'une interface SAS. Ce système utilise un système d'exploitation basé sur Linux avec des fonctions de déduplicaton, de snapshot, de réplication et de chiffrement. Si le coût au gigaoctet est d'environ 10 dollars, le système se rattrape avec une consommation électrique de 5 watts par téraoctet, ce qui revient à économiser près de 80% sur les coûts habituels de refroidissement avec des disques durs SAS 15K nous a indiqué le dirigeant.

Thomas Isakovitch, CEO de Nimbus Data

À coté du E-class, Nimbus propose le S-class. Si le premier est constitué d'une paire de contrôleurs redondants et accueille jusqu'à 24 modules flash par rack 2U (avec un maximum de 10 To par rack), le second se contente de 5 To par unité. Avec ses deux plates-formes, la start-up fondée en 2006 vise le marché de la consolidation du stockage dans les environnements de serveurs virtualisés, les infrastructures web, des clusters de bases de données, les solutions VDI (Virtual Desktop Infrastructure) et enfin le HPC.

Le système S-Class a un prix de départ de 25 000 $ pour une configuration 2,5 To. La baie Classe E commence à 149 995 $ pour une configuration 10 To, ce qui fait un tarif de 10 $ par gigaoctet, plus 25 000 $ pour chaque contrôleur.

Nous poursuivrons notre programme très dense demain avec Engine Yard, une plateforme SaaS pour le développement d'applications, NextGen Storage et son appliance d'optimisation de la performance des systèmes de stockage et enfin la très intéressante solution de virtualisation de bases de données de Delphix.

Des critiques infondées sur la batterie de l'iPad HD ?

Tout va bien avec la batterie de la troisième génération d'iPad, en dépit de ce qui a pu être écrit sur le sujet. Elle fonctionne comme prévu et les utilisateurs de la tablette numérique n'ont pas à craindre de l'endommager en la surchargeant, selon les recherches menées par nos confrères de Macworld. Petit rappel des faits. Raymond Soneira, de DisplayMate Technologies, signale une anomalie. Il pense que la batterie de l'iPad HD indique probablement à tort qu'elle est chargée à 100% alors qu'elle serait plus proche de 90%. Selon lui, si l'on arrête le chargement de la tablette au moment où la jauge de la batterie arrive à 100%, on dispose d'une autonomie réduite.

Il ajoute par ailleurs qu'Apple aurait indiqué que laisser son iPad HD branché trop longtemps (pour être sûr de l'avoir bien chargé par exemple) pouvait endommager la longévité de la batterie. Macworld, pour sa part, n'a pas trouvé écho de cette déclaration du constructeur et ce dernier n'a pas souhaité commenté cette question. Toutes les références à cette assertion semblent remonter à l'information communiquée par Mr Soneira ou à ce qu'en a dit CNBC. Et les instructions d'Apple sur le chargement de la batterie de l'iPad ne mentionnent aucun risque de surcharge.

Pas de risque de surcharge

Carl Howe, du cabinet The Yankee Group, vice-président pour les recherches sur le marché mobile, a indiqué à Macworld que cela ne causait pas de dommages [à la batterie de l'iPad] de la laisser branchée. « Il y a un circuit de charge qui permet de s'assurer que cela n'arrive pas », a-t-il précisé. Pour décrire son fonctionnement, Carl Howe le compare à la façon dont on se servirait d'une carafe pour remplir un verre. « Vous ne versez pas l'eau d'un seul coup jusqu'à faire déborder le verre, fait-il remarquer. Au contraire, vous remplissez le verre jusqu'à 5 ou 10% du bord puis vous versez plus doucement pour faire en sorte que cela ne déborde pas. C'est ainsi que fonctionne le circuit de charge ». On parle de « charge de maintien » (trickle-charge) pour désigner ce mode de chargement qui s'effectue comme si on versait au « goutte-à-goutte » pour être sûr de ne pas dépasser « le bord de la batterie », explique Carl Howe. En fait, ce mode fournit aussi une explication à propos de la deuxième remarque de Raymond Soneira. Ce dernier se demandait à quel niveau de chargement se trouvait la batterie au moment où l'iPad affichait 100%. Sur ce point, Carl Howe est d'accord pour dire que la batterie peut effectivement être plus remplie, mais ajoute que ce n'est pas un problème. « La capacité sur laquelle [Apple] communique correspond au moment où l'iPad indique 100% ». Tout ce qui se situe au-delà est une sorte de bonus.

Une batterie plus puissante et donc plus longue à charger

Effectivement, Apple suggère qu'en cas d'utilisation non régulière de l'iPad, son possesseur doit s'assurer de le charger complètement puis de le déchargement entièrement, au moins une fois par mois, pour la santé optimale de la batterie. Et même en cas d'utilisation régulière, un cycle de chargement complet permettra de garantir que l'état de charge de la batterie est correctement indiqué. Étalonner ainsi celle-ci, une fois par mois, sert avant tout à fournir au logiciel des données précises sur l'utilisation pour ajuster ses calculs. Cela signifie qu'on peut sans danger brancher son iPad le soir. Même si l'indicateur de la batterie arrive à 100% à minuit, la tablette pourra rester en charge sans risque jusqu'au matin. L'iPad HD affiche la même autonomie que ses prédécesseurs, soit 10 heures, même s'il a besoin d'une batterie de plus grande capacité pour y arriver : 42,5 watt/h comparé aux 25 watt/h des autres modèles, pour alimenter l'écran Retina à haute résolution. Sans surprise, cette batterie a besoin de davantage de temps pour se charger complètement. Macworld procède actuellement à différents tests sur le dernier iPad dont il communiquera prochainement les résultats. (...)

Performances : la bêta de Windows 8 fait déjà mieux que Windows 7

Si parmi les utilisateurs qui ont essayé la version bêta de Windows 8, certains critiquent l'interface Metro du prochain système d'exploitation de Microsoft, il semble que peu auront à se plaindre des performances affichées par l'OS. Dans les séries de tests réalisés par le laboratoire de PCWorld aux États-Unis, la Consummer Preview de Windows 8 s'est en effet montrée en général plus rapide - et parfois nettement plus rapide - que Windows 7.

Déjà, à travers le WorldBench 7 de PCWorld, la machine tournant avec la Preview de Windows 8 a démarré plus vite qu'une machine équivalente tournant sous Windows 7. Ensuite, celle-ci a fait preuve de performances supérieures à Seven lors de la navigation sur le Web. Dans un seul test important, celui de la mesure des outils de productivité, Eight s'est montré à la traîne face à Windows 7.

Une bonne base pour évaluer Windows 8

De toute évidence, ces résultats sont loin d'être définitifs, car ils concernent la version Preview, et non la version finale du système d'exploitation. Il est possible que, au moment de sa sortie, Windows 8 affiche de meilleures performances, ne serait-ce que parce que l'équipe a dû utiliser des pilotes qui n'étaient pas encore été optimisés pour la nouvelle version de l'OS de Microsoft.

Les résultats prennent aussi en compte les impressions des lecteurs de PCWorld qui ont installé la version Preview et ont fait part de leurs remarques dans un récent sondage. Environ 40% des utilisateurs qui ont répondu à l'enquête du journal ont déclaré que leurs machines semblaient plus rapides avec Windows 8, et 9,4% seulement ont déclaré qu'elles semblaient plus lentes. Enfin, près de 45 % d'entre eux n'ont pas observé de changement significatif sur leur machine.

Méthodologie des tests de PCWorld

L'équipe a utilisé son banc de tests WorldBench 7 sur une machine dédiée du Lab Test construite autour d'un processeur Intel Core i5-2500K tournant à 3.3GHz. Ce processeur est couplé avec 8 Go de mémoire vive DDR3 cadencée à 1333 MHz, un disque dur de 1 To tournant à 7200 tours, et une carte graphique Nvidia GeForce GTX 560 Ti. Selon l'équipe, ce banc de test reproduit le niveau d'un PC de milieu de gamme. Les testeurs ont installé la version Consulmer Preview de Windows 8 sur leur système et ont comparé leurs résultats avec ceux obtenus sur le même banc d'essai avec Windows 7.

Après un moulinage par le WorldBench 7, Eight a affiché un rendement global supérieur de 14 % à Seven. En règle générale, le WorldBench de PCWorld permet d'apprécier des écarts de l'ordre de 5 % ou plus. Cette différence peut être perçue par l'utilisateur quand il fait tourner une machine sous Windows 8.

Temps de démarrage

Ceux qui n'aiment pas attendre la mise en route de leur PC vont sûrement aimer Windows 8. Le benchmark de PCWorld indique que Windows 8 est 35 % plus rapide au démarrage que Windows 7. L'équipe précise que sous Windows 7, le temps moyen de démarrage était de 56,2 secondes. Sous Windows 8, ce temps est passé à 36,8 secondes.

Ce chiffre est encore plus impressionnant, si l'on considère que Windows 8 a un handicap. En effet, pour mesurer le temps de démarrage, l'équipe demande à Windows d'ouvrir un fichier texte situé dans le dossier « startup » du PC, et chronomètre le temps entre le moment où il appuie sur le bouton d'alimentation et celui où ce fichier texte s'ouvre. Parce que Windows 8 démarre dans l'interface Metro, et non sur le bureau traditionnel, il fallait, pour les besoins du banc d'essai, charger l'interface Metro, puis charger le bureau pour accéder à ce fichier texte. Le délai moyen pour voir s'afficher l'écran de démarrage de Windows 8 (sans aller sur le bureau) est encore plus rapide - seulement 23,91 secondes. A noter que le matériel du Lab est équipé d'un disque dur à plateau tournant. Si bien que, avec un disque SSD, le temps de démarrage serait encore plus rapide.

Comment fait Windows 8 pour démarrer aussi vite ?

Depuis la dernière version de Windows, Microsoft a introduit un « boot hybride », qui combine la vitesse et la fonctionnalité du mode « veille prolongée » de Windows, avec les avantages d'une nouvelle session de démarrage.

Pour rappel, lorsque l'on choisit d'éteindre son PC, Windows ferme toutes les applications et services, puis éteint l'ordinateur. Lorsque l'on choisit l'option « Mise en veille prolongée », Windows écrit dans un fichier conservé en RAM tout ce qui est en cours d'utilisation, puis suspend l'activité. Le processus d'arrêt est un peu plus long, mais le PC démarrera plus vite et reprendra son activité là où il en était avant la mise en veille. Dans Windows 8, quand on demande à éteindre l'ordinateur, le système ferme toutes les applications en cours d'exécution, mais il met en veille le système d'exploitation sous-jacent. Lorsque l'on rallume la machine, Windows 8 charge cet état sauvegardé beaucoup plus rapidement. Au bout du compte, c'est comme un « clean boot », qui prend une fraction de seconde. Le blog Building Windows 8 donne davantage de détails sur les modifications d'architecture.

Tests individuels

Le WorldBench 7 de PCWorld s'est aussi intéressé à des tests individuels de performance pour la navigation web, la productivité des outils de bureautique, et la création de médias. Celui-ci a mesuré la performance de la navigation Internet à l'aide du benchmark WebVizBench. Ce test évalue la façon dont le système restitue le contenu Web dynamique, y compris le JavaScript et le HTML 5. Pour ces tests, l'équipe de PCWorld a utilisé les navigateurs par défaut de chaque système d'exploitation, soit Internet Explorer 10 pour Windows 8 et IE 9 pour Windows 7.

Les progrès réalisés par Microsoft dans l'accélération matérielle et l'optimisation de la navigation sont ici évidents. Windows 8 affiche un score (mesuré en images par seconde) deux fois plus élevé que Windows 7.

Ces différences ne sont pas aussi importantes dans les tests de création de contenu, qui mesurent la capacité de la machine à effectuer du codage audio et vidéo, et de l'éditing. Selon l'équipe de testeurs, le système fonctionnant sous Windows 7 était un peu plus rapide que le même système fonctionnant sous Windows 8. Cependant, ces différences sont rarement au-dessus de quelques secondes, et ces résultats pourraient changer de façon spectaculaire lorsque les pilotes vidéo définitifs seront disponibles pour Windows 8.

Windows 7 marque un écart décisif dans un seul domaine : celui de la productivité des outils bureautiques. PCWorld a basé ses résultats sur le test productivité du benchmark Futuremark de PCMark, qui évalue des tâches de bureau classiques comme l'édition de texte, l'ouverture d'application et la recherche de virus. Dans ce test, Windows 8 s'est montré environ 8% plus lent que Windows 7. Mais, il faut remarquer que Futuremark va mettre à jour ses séries de benchmarks pour Windows 8, et ceux-ci pourraient donner d'autres résultats.

Conclusion

Ces indicateurs de performance vont probablement changer au cours des prochains mois, puisque Microsoft va fournir des mises à jour pour son système d'exploitation. Le cycle de développement de Windows va s'étendre sur plusieurs mois. Il comprendra des mises à jour de pilotes, des réglages de performance et diverses optimisations destinées à améliorer les choses. Ces premiers résultats sont toutefois déjà très prometteurs, les ingénieurs de Microsoft ont bien avancé ce point très important pour les utilisateurs finaux.

Certes, la majorité des lecteurs de PCWorld n'a pas vraiment plébiscité l'interface radicalement nouvelle de Windows 8. Mais les chiffres ne mentent pas : même dans sa forme initiale, Eight promet, et pourrait s'avérer être la mouture la plus performante de Windows à ce jour.

(...)(26/03/2012 14:37:38)Les archives de l'INA arrivent sur YouTube

L'Institut national de l'audiovisuel (INA) a annoncé un partenariat avec YouTube afin de diffuser prochainement sur la première plateforme de partage de vidéos au monde près de 57 000 vidéos issues de ses archives. Ces vidéos représentent près de soixante ans de programmes télévisés, relatifs à l'actualité, au sport, aux arts ou aux phénomènes de société. Ce fond sera accessible sur YouTube depuis plusieurs grandes chaînes thématiques dédiées (politique, sport, divertissement, culture, histoire...).

Pour Mathieu Gallet, PDG de l'INA, cette association offre de nouvelles perspectives : "Cet accord avec YouTube s'inscrit pleinement dans notre stratégie de conquête de nouveaux publics - notamment à l'international - tout en gardant la pleine maîtrise de notre politique éditoriale."

Ce n'est toutefois pas une première puisque les archives de l'INA sont déjà disponibles depuis 2010 sur la plateforme française Dailymotion, en plus de son propre site INA.fr.

La puce Nvidia GeForce GT 640M transforme les ultrabooks en consoles de jeux

Avec la dernière unité de traitement graphique (GPU) Geforce GT 640M annoncée en fin de semaine, Nvidia compte faire accéder les ultrabooks au statut de console de jeu. Jusqu'à présent, les processeurs graphiques de cette famille d'ordinateurs portables fins et légers, créés sur le modèle du MacBook Air d'Apple, permettaient seulement de faire tourner des jeux ordinaires. « Grâce à son design, le GPU Geforce GT 640M pourra être intégré dans les ultrabooks et faire tourner les jeux les plus exigeants en traitement graphique, » a déclaré Chris Daniel, chef de produit chez Nvidia.

Ce processeur graphique est deux fois plus rapide que son prédécesseur, le Geforce GT 540M, que l'on trouve dans des modèles de portables plus lourds. Par exemple, l'Acer Timeline Ultra M3, un PC nomade qui intègre la dernière GPU, mesure 20 millimètres d'épaisseur et pèse 2,27 kilogrammes. Comparativement, il est plus léger qu'un ordinateur portable de catégorie équivalente, comme le MSI GE620, équipé d'un processeur graphique GT 540M, lequel mesure 37 mm d'épaisseur et pèse 5,7 kilos. Cependant, le Timeline Ultra M3 à l'air un peu plus épais et plus lourd que d'autres ultrabooks comme le Folio de Hewlett-Packard et le XPS 13 de Dell, qui ne sont pas équipés de GPU distincts. Mais l'ordinateur portable d'Acer entre dans les critères définis par Intel : pour prétendre à la qualification d'ultrabook, le portable ne doit pas mesurer plus de 21 millimètres d'épaisseur.

Les premiers PC disponibles en avril

Selon Chris Daniel, ce processeur graphique est capable de gérer tous les jeux disponibles sur le marché. Nvidia a des projets avec de gros fabricants de PC pour son GPU, dont HP, Lenovo, Dell, Sony et Toshiba. « Les ordinateurs portables intégrant le nouveau GPU pourraient être disponibles dès le mois d'avril, » a déclaré le chef de produit de Nvidia. « Le GPU ultramobile est une aubaine pour les utilisateurs qui font du montage vidéo ou ceux qui jouent à des jeux sophistiqués, » a déclaré Dean McCarron, analyste principal chez Mercury Research. « Ils auront le choix de migrer vers les ultrabooks ou de conserver leurs ordinateurs portables classiques, plus lourds, plus épais et plus gros, » a commenté l'analyste, qui a précisé que le GPU pourrait être intégré dans des ultrabooks encore plus minces que l'Acer Timeline Ultra M3. « La puce graphique est basée sur la nouvelle architecture Kepler de Nvidia, » a encore déclaré Dean McCarron.

Avec Kepler, Nvidia a voulu améliorer la performance-par-watt. L'architecture Fermi précédente, critiquée pour être trop gourmande en énergie, ne lui permettait pas les mêmes performances. « En plus d'une réduction remarquable de leur taille, les puces graphiques vont permettre de préserver la vie de la batterie. En effet , elles vont partager la charge du traitement vidéo avec les dernières puces d'Intel, » a expliqué Chris Daniel. Le GPU distinct, plus performant que le traitement graphique intégré, ne sera sollicité qu'en cas de besoin, ce qui va contribuer à préserver la vie de la batterie.

Une carte Geforce 680 pour les hardcores gamers

Nvidia a également lancé la carte graphique PCIe haut de gamme GTX 680 pour les ordinateurs de bureau. Celui-ci dispose de 1536 coeurs de traitement et consomme 195 watts. En fonction du jeu, le GPU est 20 à 40 % plus rapide que le modèle GTX 580 précédent. La carte coûte 500 dollars et il est disponible dans le monde entier dès maintenant chez les principaus constructeurs.

Enfin , Nvidia a également prévu de lancer plus tard cette année de puces graphiques Tesla basées sur l'architecture Kepler, destinées aux ordinateurs desktop, aux serveurs et aux supercalculateurs. Par exemple, le Oak Ridge National Laboratory est en train de mettre au point un supercalculateur du nom de Titan qui combinera des processeurs pour serveurs Opteron 6200 d'Advanced Micro Devices avec les cartes graphiques Tesla basés sur Kepler. Celui-ci devrait délivrer une puissance de 10 petaflops, ce qui le classerait parmi les supercalculateurs les plus rapides du monde.

(...)(26/03/2012 14:19:01)OMGPOP, le créateur de Draw Something, racheté par Zynga

Au début de la semaine les blogueurs suspectaient Zynga d'être en négociations pour racheter OMGPOP, créateur du jeu à succès Draw Something. Quelques jours plus tard, Zynga a levé les doutes, confirmant que l'équipe OMGPOP rejoindrait bientôt sa propre équipe. Zynga a déboursé $210 millions pour racheter cette compagnie. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |