Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 11 à 20.

| < Les 10 documents précédents | Les 10 documents suivants > |

(28/02/2012 16:50:01)

Oracle livre Exalytics et se prépare à affronter HANA de SAP

Moins de cinq mois après l'annonce d'Exalytics, Oracle livre son serveur dédié aux applications analytiques. C'est le dernier produit en date dans sa famille d'appliances spécialisées (qui comporte déjà Exadata et Exalogic). Sur le marché, Exalytics va entrer en concurrence avec la solution HANA de SAP. L'une comme l'autre ont recours à une technologie « in-memory » qui porte les données à analyser en mémoire afin d'augmenter les performances de traitement.

C'est seulement en octobre que l'offre Exalytics a été dévoilée par Larry Ellison, sur sa conférence OpenWorld 2011. Le délai avec lequel elle a été mise sur le marché a donc été relativement court. Oracle a également annoncé une mise à jour de sa suite décisionnelle OBIEE (Business Intelligence Foundation Suite), optimisée pour l'appliance Exalytics. Cette dernière utilise OBIEE avec une version de la base de données in-memory TimesTen ajustée pour les traitements analytiques. L'ensemble fonctionne sur une plateforme matérielle spécialisée incluant un serveur Sun Fire équipé de 1 To de mémoire vive et exploitant des processeurs Xeon E7-4800 d'Intel rassemblant 40 coeurs. La connectivité entre les éléments combine des liaisons Infiniband à 40 Gb/s et Ethernet à 10 Gb/s. Les machines peuvent être chaînées ensemble pour en augmenter la puissance.

A partir de 164 700 dollars sans le logiciel

Exalytics dispose aussi de fonctions de cache in-memory qui permet au fil de l'eau de déterminer quelles informations doivent être gardées en mémoire pour optimiser la performance. Selon Oracle, les tests réalisés (notamment chez les clients) ont montré des applications de reporting et de tableaux de bord fonctionnaient jusqu'à 100 fois plus vite sur Exalytics.

La tarification de l'offre a été communiquée le mois dernier assez discrètement. Dans un document mis à jour le 10 janvier, on pouvait découvrir que le modèle Exalytics In-Memory Machine X2-4 était listé à 135 000 dollars, dans la configuration décrite plus haut, auxquels s'ajoutent 29 700 dollars pour le support annuel et autres coûts. Toutefois, les différents logiciels nécessaires à son fonctionnement augmentent sensiblement son prix. Un expert a confié le mois dernier à nos confrères d'IDG News Service que le prix d'une machine Exalytics complètement équipée devrait sans doute atteindre les 3 millions de dollars, après prise en compte des remises accordées sur le logiciel.

SAP ne communique pas publiquement de prix pour HANA. Les systèmes sont vendus par différents partenaires assurant la partie matérielle, dans une gamme de configurations incluant l'édition Edge pour les PME annoncé au début de ce mois.

Guerre des mots entre Oracle et SAP

Alors qu'Exalytics se focalise sur les applications d'analyse, HANA est également destiné à des traitements transactionnels, en conjonction avec le produit phare de SAP, la Business Suite (ERP et applications périphériques). Malgré tout, la concurrence entre les deux produits risque d'être acharnée, si l'on se réfère à la guerre des mots à laquelle les deux éditeurs se sont déjà livrés.

En octobre déjà, Sanjay Poonen, l'un des responsables de SAP, avait publié une tribune critique sur Exalytics après sa présentation par Larry Ellison. Il y affirmait que l'offre d'Oracle reposait sur une architecture dépassée, trop coûteuse pour ce qu'elle cherchait à réaliser.

La semaine dernière, c'est un responsable d'Oracle qui a posté à son tour un billet de blog vengeur sur HANA. Aussitôt taclé par un tweet de Vishal Sikka, directeur technique de SAP, dénonçant les mensonges et les informations dénaturées qu'il contenait. Le billet de blog d'Oracle a depuis été supprimé.

Microstrategy renforce l'utilisation de sa BI sur mobile

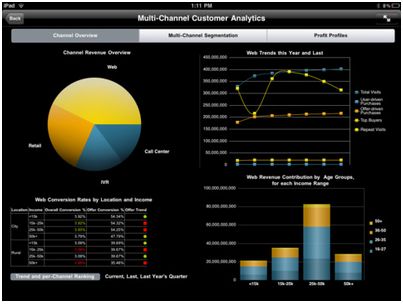

Pour enrichir l'exploitation mobile de ses outils de Business Intelligence, Microstrategy a livré avec la dernière version de son offre une série de fonctionnalités permettant d'exploiter plus confortablement et plus efficacement ses outils sur les tablettes et smartphones. Son application Microstrategy Mobile, déjà disponible pour l'iPad sur iTunes, l'est désormais aussi sur l'Android Market (pour Android 2.1 à 3.2). Elle permet de visualiser les données de l'entreprise via des tableaux de bord et des graphiques dynamiques.

Parmi les améliorations apportées par la version 9.2.1m de l'offre de Microstrategy en utilisation mobile, l'affichage se modifie et redimensionne ses contenus en fonction de la rotation du terminal. Des contenus supplémentaires peuvent être ajoutés par widgets. On dispose de la fonction « pincer pour zoomer » pour agrandir le rapport ou le document. S'ajoutent à cela la prise en charge des transactions mobiles hors ligne, ainsi qu'un suivi de la qualité du réseau qui informe les utilisateurs de la bande passante réseau disponible. Le logiciel supporte les fonctions d'authentification SSO de Siteminder (de CA). Pour naviguer dans un document de plusieurs pages, il suffit de taper au bord de l'écran pour feuilleter rapidement le rapport. Un widget affiche des événements et différents détails dans une frise chronologique (timeline) à laquelle les utilisateurs pourront se référer pour effectuer des comparaisons dans le temps. Par ailleurs, sur les terminaux sous iOS, il est possible de mettre en oeuvre les fonctionnalités d'accessibilité telles que VoiceOver.

En mode déconnecté, les utilisateurs pourront préparer des transactions qui seront mises en attente pour la prochaine connexion. Enfin, avec le widget Multimedia, on peut se connecter à des systèmes de gestion de fichiers comme WebDAV et SharePoint pour récupérer des données multimédias dans l'application mobile.

Microstrategy Mobile sur iPad

Une solution décisionnelle sur base AS/400 chez Rautureau Apple-Shoes

Créé en 1870 en Vendée, Rautureau Apple-Shoes fabrique et distribue des chaussures haut de gamme sous plusieurs marques (Free Lance, Jean-Baptiste Rautureau, Pom d'Api...) dont, pour la moitié de son chiffre d'affaires, pour l'export. Les 240 collaborateurs de l'entreprise génèrent un chiffre d'affaires de 40 millions d'euros par an auprès de 1500 clients de 40 pays en s'appuyant sur un réseau de 37 boutiques (dont 3 en Suisse et Belgique, 3 magasins en ligne et un magasin d'usine).

Le système d'information de l'entreprise repose sur un AS/400. Mais la création du compte d'exploitation analytique nécessitait la ressaisie d'information sous tableur Microsoft Excel pour un travail mensuel de 3 à 4 jours. Cette modalité n'étant pas satisfaisante, Rautureau Apple-Shoes a cherché une solution alternative évitant toute ressaisie mais permettant de croiser des informations de plusieurs sources, le tout sans investissement en infrastructure.

Une solution sur AS/400

Après appel au marché, la société a choisi la solution MyReport de Report One, intégrée par Ouest Décision. La solution choisie est installée sur AS/400 et utilise la base de données DB2/400. Elle permet d'exporter des données vers des tableurs comme Excel ou OpenOffice. La distribution des rapports peut également être automatisée.

Mise ne place en moins de deux mois, tout compris, la solution est destinée à voir son périmètre s'étendre au delà du seul contrôle de gestion, notamment vers la gestion commerciale et la prévision de production. Elle a d'ores et déjà permis d'économiser les 3 à 4 jours mensuels de ressaisies et de retraitements comme c'était l'objectif. Les rapports sont désormais suivis au quotidien. Le coût du projet n'a pas été communiqué. (...)

Les éditeurs du Syntec Numérique publient le Livre noir et blanc du logiciel

« Il y a dix ans en arrière, la R&D dans une automobile était liée à sa fabrication, maintenant, 25% de cette R&D vient des logiciels informatiques » a expliqué Bruno Vanryb, président du collège éditeurs du Syntec Numérique et PDG d'Avanquest, lors de la présentation du livre noir et blanc du logiciel. Il replace ainsi le secteur de l'édition de logiciels dans son nouveau contexte. Un secteur qui touche désormais toutes les activités de la société, et doit être mieux reconnu.

Toutefois, ce secteur souffre de blocages. Avant tout sa dispersion entre de multiples entreprises trop faibles en taille. La France compte 3 200 éditeurs, mais 63% d'entre eux réalisent moins de 10 millions d'euros de chiffre d'affaires. 30% se situent entre 10 et 50 ME, 4% entre 50 et 100, 3% seulement au-delà de 100 ME de CA annuel. Dès qu'ils grandissent, ils se font racheter. Passer de PME à ETI (entreprise de taille intermédiaire) est donc problématique.

L'équipe de Bruno Vanryb propose d'abord la création d'un statut de « société créatrice de logiciels ». Les éditeurs informatiques relèvent en effet, du point de vue juridique et fiscal, de différents statuts : entreprise de croissance, société industrielle, activité de R&D. Ce nouveau statut serait une transformation de celui actuel de JEI. Le Syntec Numérique travaille depuis des mois sur ce projet. Il faudrait avoir 500 salariés et 20 ans d'existence pour y accéder. Le segment visé est bien celui des PME voulant devenir ETI, donc grandir en taille.

Les entrepreneurs forment les entrepreneurs

Le Livre noir et blanc insiste ensuite sur la formation marketing des chefs d'entreprise. Un vieux problème très français, nous sommes plus techniciens que vendeurs. La solution ? Des formations packagées dispensées (il reste juste à trouver un accord avec l'Education Nationale) aux futurs chefs d'entreprise. Elles seraient livrées par les actuels patrons des entreprises d'édition informatique.

Et comme un dialogue avec l'Education Nationale ne lui suffit pas, le Syntec Numérique en ajoute un second, pour définir une filière de formation dédiée aux métiers du logiciel. Ils sont en effet mal reconnus dans leurs nouveaux développements (le web en particulier) et peut adaptés aux applications concrètes. Des cursus ciblés, une gouvernance partagée avec l'Education nationale (mais si, mais si, le Syntec Numérique en rêve), une meilleure visibilité des éditeurs auprès des étudiants sont envisagés.

[[page]]

Le Syntec Numérique veut également simplifier l'accès aux multiples aides dispensées par les différents services de l'Etat. Oseo, Régions, Caisse des dépôts « baladent » les entreprises d'un guichet à l'autre, d'un formulaire au suivant, et d'un interlocuteur à son homologue. Le Syntec Numérique propose un guichet unique de toutes les aides et surtout, associée à ce guichet, une équipe formée pour ce type de mission.

Des pôles de compétitivité incomplets

Enfin, le syndicat aimerait développer des écosystèmes du logiciel. Les pôles de compétitivité existent bien, mais le Syntec Numérique les trouve incomplets. Il manque les organismes de financement, les universités et grandes écoles, et ils fonctionnent indépendamment les uns des autres, trop localement. Contrairement aux organismes américains, Silicon Valley, par exemple, les grands acteurs ne passent pas commande aux petits acteurs. Ils s'ignorent. Le Syntec Numérique propose donc de revoir la conception des écosystèmes pour regrouper tous les acteurs du logiciel, leur donnant une plus grande dynamique et une meilleure visibilité en France comme à l'international.

Bref, le Syntec Numérique veut expliquer aux candidats aux présidentielles : « tenez compte de nos propositions, c'est bon pour la croissance ». Après sa présentation, Bruno Vanryb dialoguait d'ailleurs avec les représentantes des deux principaux candidats (***). Et il est allé beaucoup plus loin que ses propositions, expliquant que l'expansion de l'industrie du logiciel permettrait de mieux accueillir, dans la vie active et dans la société en général, les nouvelles générations, particulièrement la génération « Y ». A condition de dépasser ses blocages et que le futur Président l'y aide. C'est la raison d'être de ces cinq propositions (****).

(***) Laure de la Raudière pour l'équipe Sarkozy et Fleur Pellerin pour celle de Hollande.

(****) Le Syntec Numérique a par ailleurs avancé dix propositions, mais son collège éditeurs voulait souligner l'importance de son secteur (et ne pas laisser l'Afdel, qui le lui rend bien, seule en piste) avec ses propres propositions au nombre de cinq.

Cinq étapes pour se préparer au traitement des big data

Manipuler de larges volumes de données n'est pas une nouveauté pour les départements informatiques, mais derrière le battage fait sur la question, les big data diffèrent vraiment du datawarehouse, du datamining et de l'analyse décisionnelle qui les ont précédées, souligne Beth Stackpole, de Computerworld, dans un article publié cette semaine.

Les données sont générées de plus en plus vite, la plupart étant désormais récupérées sous leur forme brute. Les blogs, les réseaux sociaux, les outils de localisation, de même que les informations remontées des capteurs et sondes diverses, créent un nouvel univers de données non structurées. Si celles-ci sont rapidement capturées, gérées et analysées, elles peuvent aider les entreprises à découvrir des faits et des modèles qu'elles n'avaient pas été capables de reconnaître jusque-là. « Nous avons recueilli beaucoup de données pendant longtemps », relate ainsi Paul Gustafson, directeur des programmes technologiques du Leading Edge Forum de CSC. Archivées, elles étaient modélisées autour des processus métiers, mais elles ne l'étaient pas comme un ensemble de connaissances plus large pour l'entreprise, pouvant être reliées entre elles. L'informatique se trouve à l'avant-garde de cette révolution. Les responsables IT devraient commencer à préparer leur entreprise pour cette transformation, estiment des analystes tels que Mark Beyer, de Gartner. Voici cinq actions à entreprendre pour en poser les fondations.

1 - Faire l'inventaire de ses données.

Toutes les entreprises, ou à peu près, ont accès à un flux régulier de données non structurées, que celles-ci proviennent des médias sociaux, ou de capteurs surveillant une usine, par exemple. Cela ne signifie pas qu'elles doivent toutes les sauvegarder et les exploiter. Cet afflux soudain a suscité un besoin artificiel d'essayer de comprendre toutes ces données, remarque Neil Raden, un analyste de Constellation Research. Ce souci a pu être provoqué par des consultants ou fournisseurs soucieux de promouvoir leurs solutions. « Il y a une certaine pression de la part de ceux qui commercialisent la technologie », observe Neil Raden. Sans urgence, une première étape pourrait consister à inventorier quelles données sont créées en interne et déterminer quelles sont les sources externes, s'il y en a, qui pourraient apporter des informations complémentaires sur l'activité de l'entreprise, explique l'analyste de Constellation Research.

Une fois cet état des lieux engagé, les équipes informatiques devraient entreprendre des projets très ciblés qui pourraient être utilisés pour montrer quels résultats on peut obtenir, plutôt que d'opter pour des projets en mode big-bang. Mieux vaut éviter de dépenser plusieurs millions de dollars pour déterminer si un projet vaut la peine d'être mené, souligne Neil Raden.

2 - Donner la priorité aux métiers

Aligner l'IT avec les métiers est indispensable dans le cas d'un chantier aussi important que peut l'être le traitement des big data. Les premières occasions de traiter ces volumes se sont trouvées hors du périmètre de la IT. Par exemple dans des départements marketing qui ont décidé de récolter les flux des médias sociaux pour gagner en visibilité sur les besoins des clients et les tendances en matière d'achats. Si c'est effectivement du côté business que l'on devrait identifier l'intérêt de ces analyses, c'est à la IT que revient de prendre en charge la fédération et le partage des données et de mettre en oeuvre la stratégie big data. Pour Dave Patton, analyste chez PricewaterhouseCoopers, ce n'est pas une démarche que la IT peut faire seule de son côté. « Il sera difficile d'en faire une success story si le projet n'est pas aligné sur les objectifs business ».

3 - Réévaluer l'infrastructure[[page]]

3 - Réévaluer l'infrastructure

Dans la plupart des entreprises, les projets big data vont demander des changements importants. D'une part sur les infrastructures serveurs et de stockage, d'autre part sur la gestion des données, si l'on en croit Mark Beyer, du cabinet Gartner, ainsi que d'autres experts. Les responsables informatiques doivent se préparer à étendre leurs systèmes pour qu'ils supportent des bases en perpétuelle expansion, recevant données structurées et non structurées. Cela signifie qu'il faut trouver la meilleure approche pour rendre les systèmes à la fois extensibles et évolutifs et qu'il faut élaborer une feuille de route pour intégrer tous les systèmes disparates qui vont alimenter l'effort d'analyse des big data.

« Actuellement, les entreprises ont souvent des systèmes disparates et séparés pour gérer la paie, les relations clients, le marketing », indique Anjul Bhambhri, vice-président, responsable des produits big data chez IBM. Les CIO ont besoin de mettre en place une stratégie pour les faire converger. « Il faut pouvoir poser des questions qui traversent tous ces systèmes pour obtenir des réponses », précise le VP d'IBM.

4 - Etudier les technologies associées

Evidemment, le monde des big data apporte sa liste d'acronymes et de technologies. Les outils en Open Source sont ceux qui retiennent le plus l'attention. On met au crédit des Hadoop, MapReduce et NoSQL d'avoir aidé les géants du web que sont Google et Facebook à naviguer à travers leurs réservoirs de big data. La plupart de ces technologies, même si elles sont désormais disponibles sous une forme commerciale, sont encore assez immatures et requièrent pour s'en servir des compétences très spécifiques. Parmi les autres technologies importantes dans le monde des big data figurent l'analytique in-database pour être au plus près des données, les bases exploitant le stockage en colonnes et les appliances de datawarehouse. Les équipes IT vont devoir comprendre ces nouveaux outils pour pouvoir faire des choix avertis en matière de big data.

5 - Préparer ses équipes

Qu'elles aient besoin d'experts Hadoop ou de spécialistes des données (data scientists), les départements IT manquent sévèrement des talents nécessaires pour aller plus loin avec les big data. Les compétences en matière d'analytique sont peut-être les plus cruciales et c'est là que se trouvent les manques les plus importants.

McKinsey prévoit que, pour les seuls Etats-Unis, on aura besoin d'ici 2018 de 140 000 à 190 000 experts supplémentaires spécialisés dans les méthodes statistiques et l'analyse de données. Parmi les postes les plus demandés se trouvera la fonction de plus en plus médiatisée de « data scientist ». En outre, McKinsey s'attend à des demandes à la fois du côté métier et technique pour quelque 1,5 million de managers à l'aise avec les données, disposant d'une formation reconnue dans l'analyse prédictive et les statistiques.

Pour quelques entreprises, particulièrement celles qui se trouvent dans les zones les moins peuplées, trouver des compétences sera l'un des aspects les plus délicats des projets de big data. Pour une structure de taille moyenne, ce sera un défi de constituer une équipe et de faire en sorte qu'elle suive le rythme en constante évolution de cet environnement, estime Rick Cowan, CIO de True Textiles, un fabricant américain de tissu situé dans le Maine. Pour y faire face, il a commencé à reconvertir des développeurs et des spécialistes des bases de données pour les faire progresser sur les analyses avancées.

Les directions des départements IT vont devoir elles-mêmes se transformer pour exceller dans ce nouveau monde. Les managers IT du futur combineront des compétences sur l'analyse de données et les processus métiers, estime Mark Beyer, de Gartner. « Les CIO ont eu l'habitude de gérer des infrastructures à partir des prescriptions des métiers, par opposition à un CIO qui serait capable d'identifier une opportunité et par conséquent de pousser vers une utilisation innovante de l'information », explique-t-il. C'est la transformation qui devra se produire.

Sopra Group veut renforcer ses activités au Royaume-Uni

Trois jours avant de présenter ses résultats financiers pour l'année 2011, la SSII française Sopra Group annonce son intention de renforcer ses activités outre-Manche par deux acquisitions. L'une porte sur la filiale britannique de Business & Decision qui intervient dans les domaines du décisionnel, du CRM (gestion de la relation client) et du e-business sur plusieurs secteurs (services financiers, distribution, secteur public, transports). L'autre projet de rachat concerne l'activité de Tieto consacrée aux services financiers sur le marché britannique. Ces deux entités ont respectivement réalisé un chiffre d'affaires de 26 M€ et 22 M€ en 2011, précise Sopra dans un communiqué.

Sur les neuf premiers mois de l'année dernière, la France pesait toujours plus de 80% du chiffre d'affaires de la SSII française, soit 632,4 millions d'euros sur un total de 769,8 M€. Les deux projets d'acquisition pourraient être finalisés au cours de ce trimestre, sous réserve des autorisations réglementaires requises. Les activités rachetées seront intégrées à la filiale britannique de Sopra Group. Cette dernière a réalisé un chiffre d'affaires de 58 millions d'euros environ pour l'année 2011.

TF1 révise son décisionnel RH avec Microstrategy

Le groupe TF1 a déployé en janvier 2010 le projet Sigma sous SAP pour unifier sa gestion au niveau groupe, toutes activités confondues. Il manquait cependant un outil complet de pilotage des ressources humaines disponible sous divers environnements, notamment les tablettes voire les smartphones pour la direction du groupe.

Au départ, la DRH groupe disposait de rapports sous SAP BW (Business Warehouse) créés dans le cadre de Sigma mais ceux-ci n'étaient ni souples ni ergonomiques. Par ailleurs, il existait une application de tableau de bord, faite maison et avec des données devant être intégrées ponctuellement. L'ensemble n'était disponible que pour les personnels de la DRH sur les PC. L'objectif poursuivi était d'obtenir, sur tous les terminaux, un rafraîchissement au minimum quotidien des données et une ergonomie avancée avec un usage aisé sans besoin de formation particulière.

Par ailleurs, TF1 a signé la Charte de la Diversité. L'outil décisionnel devait permettre de contrôler que ses dispositions étaient respectées tant sur le recrutement que sur la politique de rémunération.

Une cinquantaine d'utilisateurs étaient concernés. Les opérationnels de la DRH devaient accéder à l'outil via le portail applicatif sur PC, le comité exécutif RH autant par le portail applicatif que sur tablettes et le comité directeur essentiellement sur tablettes.

Un projet baptisé REVE

Le projet, nommé REVE (Reporting EVErywhere), se devait d'être global au niveau groupe, fiable, pérenne et surtout sécurisé. « Les données intègrent des informations extrêmement sensibles, notamment les salaires des vedettes de la chaîne » souligne Dan Malka, chef de projet informatique détaché à la DRH groupe. Environ 90% des données pouvaient être récupérés via SAP BW car elles étaient disponibles dans Sigma. Le solde était constitué de données intégrables (fichiers Excel...).

Deux produits ont été examinés pour compléter SAP BW et atteindre tous les objectifs. Le premier, logiquement, était SAP BO (Business Object), le second, Microstrategy.

Le groupe TF1 dispose en interne d'une expertise sur BO XI 3 mais la version 4 avait été recommandée, bien que manquant de maturité, pour correspondre aux attentes en termes de multi-terminal. BO bénéficiait d'une intégration évidente dans SAP et la version 3 aurait coûté moins cher que toute autre solution, car déjà présente sur le système d'information du groupe. La version 4 supposait en effet de racheter des serveurs et des licences.

Cette nécessité de rachat de serveurs et de licences constituait le handicap majeur pour Microstrategy. Mais, à l'inverse de BO, l'accès multi-terminal y était déjà mature et l'intégration de l'ensemble des outils de l'écosystème ne posait aucun souci. Enfin, les fonctionnalités avancées et métier plaidaient aussi en faveur de cet outil qui a été finalement choisi.

Deux étages : SAP BW et Microstrategy

SAP BW et SAP HR (human Ressource) ont été maintenus, avec une intégration confiée au prestataire habituel du groupe TF1, Northgate Arinso. La couche Microstrategy (version 9.2.1), elle, a été intégrée par Censio. Les métadatas propres à Microstrategy ont été mises en place dans un serveur MS SQL 2008. La connexion Microstrategy/SAP repose quant à elle sur Microstrategy Intelligence Server.

[[page]]

SAP BW a été conservé pour sa partie intégration des données, le stockage/archivage, le datawarehousing et les cubes associés aux quelques requêtes de base. Microstrategy se base sur les requêtes BW (et pas sur les cubes pour améliorer les performances) pour construire les rapports, disponibles sans redéveloppement quel que soit le terminal. « On peut cependant prévoir d'ajouter la prise en charge de certains apports des tablettes ou des smartphones (géolocalisation GPS, accéléromètre, commande tactile...) dans les rapports affichés sur ces outils » relève Dan Malka.

Le socle de REVE a été construit de janvier à septembre 2011. Des tableaux de suivi des rémunérations ont été ajoutés dans un deuxième lot, de juillet à novembre 2011. Un troisième lot a permis de piloter la campagne annuelle de réévaluation des salaires, avec intégration des propositions des managers opérationnels saisies via l'intranet. Enfin, un projet d'industrialisation a été mené de décembre 2011 à janvier 2012.

Des bonnes pratiques à respecter

Plusieurs règles ont été adoptées pour s'assurer de la performance de l'ensemble. La première a été de gérer trois niveaux dans la mise en place d'une évolution de l'outil : développement, pré-production et production. Le passage d'une évolution d'un niveau au suivant se fait par simple glisser-déposer dans Object Manager de Microstrategy. Dan Malka préconise : « une bonne pratique est de bien sauvegarder ses métadatas Microstrategy avant toute manipulation de ce genre ».

Par ailleurs, la connexion des tablettes s'effectue en respectant strictement les règles de la DSI groupe (VPN/HTTPS sur les connexions WiFi ou 3G...). Cela implique un paramétrage fin qui est malheureusement perdu en cas de mise à jour du coeur applicatif.

Le bilan est cependant largement positif pour les utilisateurs métier. Ceux-ci se sont largement impliqués dans le développement de l'outil, via des allers-retours entre métiers et informaticiens. Malgré tout, le raccordement de la BI RH et de la BI finances (sous SAP BW) n'a pas été de tout repos.

Le budget du projet n'a pas été communiqué.

SAP adapte HANA, la base de données en mémoire, aux PME

Les PME vont disposer de la solution analytique haute performance de SAP. L'offre comprend une nouvelle édition Edge du logiciel ainsi que des outils analytiques sous HANA pour sa suite ERP (Enterprise Resource Planning) Business One. « Ces produits seront vendus par nos partenaires sur un marché où SAP compte plus de 96 000 clients, ce qui représente 79% de sa base client totale, » a déclaré Eric Duffaut, patron de la distribution mondiale de SAP, au cours d'une conférence téléphonique avec la presse et les analystes.

La technologie HANA consiste à traiter les données depuis la RAM au lieu de les écrire et de les lire sur des disques durs traditionnels, ce qui permet de meilleures performances. La base de données, qui sait gérer aussi bien les charges de travail décisionnelles que transactionnelles, est vendue sous forme d'appliance par un certain nombre de fournisseurs. « L'édition Edge de HANA est disponible. Elle est identique à la version Entreprise, » a déclaré Bobby Vetter, vice-président senior, SAP, Ecosystem & Channels Readiness. « L'édition Edge aura aussi le même calendrier de sortie que l'édition Entreprise, » a t-il ajouté. Cependant, la quantité de RAM des appliances HANA Edge sera plafonnée et moins élevée. Celles-ci pourront également être vendues en bundle avec la suite logicielle BusinessObjects Edge BI (business intelligence) de SAP.

Comme le précise SAP dans un communiqué, l'offre d'analytiques pour Business One, son application de gestion intégrée, est susceptible de répondre à tous les besoins « à petite échelle. » Celle-ci s'appuie sur une application SAP basée sur HANA facile à utiliser et intégrant des processus essentiels, notamment pour le reporting « avec Crystal Reports, lequel génère en temps réel des rapports complets à partir de données actualisées. »

Pas de prix dévoilé et une montée en charge progressive

Le produit doit entrer dans sa phase de montée en charge ou « ramp-up» (un terme utilisé par SAP pour désigner le lancement de programmes destinés aux « early adopters) d'ici la fin du mois de février. La diffusion générale est prévue plus tard cette année. Bobby Vetter et Eric Duffaut n'ont pas voulu donner de détails sur le prix des produits, mais tous deux ont souligné que leur coût sera adapté. « Nous savons que ce marché est sensible à la question du prix, » a déclaré Eric Duffaut en ajoutant que « le prix sera juste. »

HANA est disponible pour tous depuis juin dernier. Depuis cette date, SAP est resté très discret sur sa technologie et sur sa feuille de route technique. Le mois dernier, Vishal Sikka, CTO et membre exécutif du Conseil d'administration de SAP, a révélé que l'entreprise avait l'intention d'utiliser le support HANA pour faire tourner certains modules de sa Business Suite phare d'ici à la fin de cette année. Dans le futur, HANA devrait aussi servir de base à une prochaine génération d'architecture logicielle pour les produits de l'éditeur allemand.

L'an dernier, les ventes de HANA ont atteint plus de 160 millions d'euros. « Dans l'histoire de SAP, c'est le produit qui affiche la plus forte croissance, » a déclaré l'entreprise.

Attention au prix des outils BI en mode SaaS

Le développement des demandes de cloud ou de SaaS n'est pas une surprise. De plus en plus de responsables financiers ou informatiques sont tentés de faire appel à ce type d'offres pour répondre à une augmentation des besoins en Business Intelligence. Deux raisons à cela, les faibles couts de démarrage ou de déploiement et l'absence de compétences nécessaires en interne pour construire leurs propres solutions analytiques.

La migration des entreprises vers le cloud pour le décisionnel se fait très vite. Selon une étude Gartner, un tiers des personnes interrogées (1 364 responsables IT) prévoient d'utiliser des offres SaaS en matière de BI dans les 12 prochains mois pour certaines divisions métiers. Cependant, les directeurs financiers ont un peu de mal à savoir combien leur coutera au final l'utilisation de ces offres. Les logiciels achetés comme un service peuvent généralement être passés comme un investissement, plutôt qu'un achat d'actif dans les bilans financiers. Les acheteurs pensent souvent que le SaaS est cher, mais la réalité est plus compliquée. Le modèle de coûts de Gartner montre que le SaaS peut être moins cher au cours des cinq premières années, mais pas par la suite. Les avantages à long terme se trouvent ailleurs - notamment dans le flux de trésorerie et la réduction des coûts de support, indique l'étude.

« Les professionnels sont souvent frustrés par la longueur des cycles de déploiement, les coûts, la complexité des processus de mise à niveau des infrastructures informatiques demandés par les solutions de BI sur site » a déclaré James Richardson, directeur de recherche chez Gartner. « La BI dans le cloud est perçue comme offrant une vitesse de déploiement à faible cout, même si cela reste à prouver ». précise l'analyste. Il constate également que « si l'intérêt est croissant, le marché reste confus sur ce que sont les solutions SaaS et cloud dans le BI et ce qu'elles apportent ».

Décisionnel : Salesforce.com ne facturera pas de suppléments

Suite au fort mécontentement manifesté par ses clients, Salesforce.com a finalement décidé d'inclure, dans les versions Enterprise et Unlimited de son logiciel CRM (Customer Relationship Management), et ce sans coûts supplémentaires, certaines des nouvelles fonctionnalités de l'Analytics Edition annoncées par le vendeur. Les clients avaient fait valoir que ces outils décisionnels (voir article précédemment publié par lemondeinformatique.fr) venaient combler des lacunes constatées de longue date sur le produit, et qu'elles ne justifiaient pas une augmentation de tarif.

C'est George Hu, directeur opérationnel (CTO) de Salesforce.com, qui a annoncé cette décision dans un blog mardi soir. « Nous avons eu tort, et nous présentons nos sincères excuses à nos clients, » a-t-il écrit dans son billet. Salesforce.com a estimé initialement que les capacités d'analyse décisionnelle apportées par Analytics Edition en faisaient un produit entièrement nouveau. « Or, les commentaires de nos clients montrent clairement qu'ils considèrent ces nouveautés comme des améliorations à notre produit actuel. » Si bien que « ces fonctionnalités rassemblées dans un premier temps dans une édition distincte ne seront pas vendues séparément, » a indiqué le CTO de Salesforce.com dans une interview. Salesforce.com avait prévu de faire payer 40 dollars de plus par utilisateur et par mois pour accéder à ces fonctionnalités. Le vendeur fait payer 125 dollars par utilisateur et par mois pour l'édition Enterprise, et 250 dollars pour l'édition Unlimited de sa suite CRM.

La force des réseaux sociaux mise en avant

Un utilisateur qui avait exprimé son mécontentement s'est dit satisfait de la décision de Salesforce.com. « Voilà une entreprise qui est à l'écoute de ses clients et qui leur apporte une répondre rapide, » a déclaré Jeremy Farber, le client de Salesforce.com à l'origine de la campagne de communication. Ce dernier avait alerté la semaine dernière sur les réseaux sociaux cette hausse de tarif envisagée par le vendeur. Il faut dire que la promotion des médias sociaux dans les entreprises est un axe central de la stratégie marketing et produit du vendeur. Selon Jeremy Farber, la volte-face de Salesforce montre clairement le « pouvoir des médias sociaux. » Celui-ci estime que Salesforce « aurait certainement pu ignorer le mécontentement exprimé par ses clients. » Ajoutant que «s'il avait été confronté à la même situation il y a dix ans, il n'aurait eu comme seul recours que de râler tout seul dans son bureau. »

La fronde des clients a permis à Salesforce.com de montrer qu'il était capable d'être à l'écoute de ses clients, et peut-être aussi de profiter d'un bon coup de publicité. « Voilà un certain temps déjà que nous prêchons en faveur du pouvoir de l'entreprise sociale, » a déclaré George Hu. « Nous voulons mettre en pratique ce que nous prêchons. Cela ne signifie pas que Salesforce.com se laissera convaincre dans tous les cas. Mais le mécontentement exprimé ici n'est pas habituel, » a ajouté le CTO de Salesforce.com. « Ces dernières années, nous avons sorti plusieurs produits avec des prix différents sans susciter beaucoup de réactions. C'est la première fois que nous assistons à cela et nous nous devions de prendre en compte ce message envoyé par nos clients. »

Une brique nécessaire pour les clients

Ray Wang, analyste de l'industrie et PDG de Constellation Research, a un point de vue plus mesuré pour expliquer ce retournement. « Analytics est la dernière frontière pour Salesforce.com. Ils ont le social, ils ont la mobilité. Leur maillon faible, ce sont les fonctions analytiques, » a-t-il déclaré. « La bonne nouvelle, c'est que ces fonctionnalités sont désormais comprises dans le tarif. La mauvaise, c'est qu'il y a probablement des outils tiers plus performants. » Cela dit, « ce que demandent les utilisateurs, à part exporter vers Excel, c'est de pouvoir utiliser les outils décisionnels dans l'environnement dans lequel ils travaillent. »

(...)| < Les 10 documents précédents | Les 10 documents suivants > |