Flux RSS

Décisionnel

626 documents trouvés, affichage des résultats 171 à 180.

| < Les 10 documents précédents | Les 10 documents suivants > |

(07/10/2010 11:14:00)

Sans bonne intégration pas de cloud fonctionnel

Le cloud computing franchit une nouvelle étape en étant abordé maintenant sous l'angle de l'intégration. C'est Alain Attias, directeur associé du cabinet Kerensen Consulting qui fixe le nouvel axiome : « Si vous ne savez pas intégrer, vous n'avez aucune chance dans le cloud ». En clair, de plus en plus d'applications en cloud s'installent dans le SI, donc se confrontent à des applications pré-existantes. Par exemple, le CRM en cloud avec le système d'information d'une banque. L'intégration est alors essentielle. Editeurs, intégrateurs et SSII se disputent ce marché.

Certains acteurs ont même acheté des compétences. Comme IBM avec le rachat de la société californienne Cast Iron au mois de mai dernier. Elle lui apport des outils d'intégration spécialisés sur les applications cloud. « L'intégration est bien devenue la clé du développement pour le cloud computing » souligne Alain Attias, « on ne va pas pour autant passer au tout-cloud, mais cloudiser progressivement le système d'information ».

Le "Saas canada dry"

Cette progressivité s'observe très bien sur les ERP. « Beaucoup d'applications basculent en Saas, note Loïc Simon, comme la trésorerie ou les RH, les ERP métiers sont plus rétifs. » En fait, lui-même et d'autres acteurs du cloud pointent les « faux amis » ou le « Saas canada dry », bref les applications en Saas qui n'en sont pas vraiment. Ce serait l'écrasante majorité des éditeurs français qui proposeraient ainsi, sous couvert de Saas, de l'hébergement pur et simple. Avec un serveur par client. Alors que le Saas véritable consiste à pourvoir accueillir plusieurs clients sur un même serveur. C'est ce que proposent des sociétés comme salesforce. Capables d'accueillir toutes tailles d'entreprises et toutes les applications.

Derrière ses airs consensuels, le cloud computing laisse se déchirer les éditeurs à belles dents.

Teradata et Cloudera s'associent pour révolutionner le traitement analytique des données

Les nouveaux partenaires envisagent de mettre en route un pipeline destiné aux clients de Teradata qui utilisent la distribution Hadoop de Cloudera (CDH). Ceux-ci précisent que le pipeline sera utilisé pour acheminer des données non structurées provenant de diverses sources en ligne directement vers une installation Teradata où les masses de données brutes pourront être analysées en détail. L'objectif est de permettre aux utilisateurs de rassembler et de consulter de grands pools de données, et de profiter d'une quantité d'informations utiles émanant de sources de données structurées et non structurées comme jamais ils n'ont pu le faire auparavant.

Hadoop, le framework de traitement qui travaille en parallèle pour exécuter des programmes écrits en Python, Java et autres langages, a été principalement utilisé jusqu'ici à des fins de data reporting, par exemple pour l'extraction de données des fichiers log sur les serveurs web. Mais celui-ci peut être mis utilement à contribution dans des domaines qui couvrent la reconnaissance et l'analyse d'images jusqu'à la collecte et le déplacement de données à grande échelle.

Améliorer le traitement d'énormes quantité de données

Comme l'a déclaré Mike Olson de Cloudera, grâce à cette solution additionnelle, les clients de son entreprise peuvent maintenant relier leurs résultats de recherche à des indicateurs financiers, des profils clients, et autres. Mais selon Richard Winter, président de Winter Corporation, une entreprise spécialisée dans les solutions impliquant des gros volumes de données, ce puissant outil intégré, dédié à l'analyse complexe des données, pourra aider de nombreux utilisateurs à renforcer leurs atouts sur le plan concurrentiel.

Ce développement révolutionnaire est possible grâce à la compatibilité des réseaux de traitement parallèles (comme Hadoop) avec l'entreposage de données en parallèle (géré par le moteur analytique de la base de données de Teradata). Chaque système peut avoir été mis en place pour différents types d'analyse, mais lorsqu'ils sont combinés - comme le font Teradata et Cloudera - ils peuvent aider les utilisateurs à réunir des quantités énormes de données en provenance de toutes sortes de sources. Mais ce n'est pas tout. Selon un expert, le déploiement des deux technologies en parallèle peut aider à explorer de nouvelles opportunités, à inventer de nouvelles applications et à disposer de meilleurs avantages concurrentiels.

Les deux partenaires ont prévu de travailler très étroitement pour mettre sur pied ensemble cette solution de pointe. Le Hadoop Connector de Teradata sera livré gratuitement avec Cloudera Enterprise, à charge pour Cloudera d'apporter le support technique du Connector. La commercialisation de la solution sera menée de manière conjointe, à l'occasion de forums, d'évènements et de salons spécialisés.

(...)(23/09/2010 09:04:27)OpenWorld 2010 : Oracle se convertit à la religion du Cloud

Davantage de contrôle utilisateur dans le cloud

L'intervention de Thomas Kurian concernait également la méthode utilisée par l'éditeur en matière de sécurité au sein du cloud, ce qui lui a permis, au passage, de faire la promotion de l'offre d'Oracle en matière de contrôle des identités et des niveaux de sécurité au sein de la base de données. Celui-ci a montré notamment comment les utilisateurs pourraient facilement configurer et modifier les processus de gestion dans les futures applications Fusion d'Oracle qui seront proposées sur site et à la demande. "Dans le passé, il était nécessaire de faire appel à un développeur pour apporter cette souplesse. Nous avons revu l'architecture de notre middleware pour modifier fondamentalement l'ancienne modalité", a-t-il expliqué. "Si Thomas Kurian a insisté sur les capacités d'Oracle en matière de sécurité et de gestion d'identité, c'est parce que ces fonctionnalités sont, pour le moment, généralement rarement offertes par la plupart des vendeurs de services SaaS (Software-as-a-Service) pure-play", a relevé China Martens l'analyste du Group 451. La stratégie d'Oracle en matière de cloud computing ne semble pas inclure une offre d'IaaS (infrastructure-as-a-Service) public comme c'est le cas d'Amazon Elastic Compute Cloud (EC2). Thomas Kurian n'a pas non plus abordé des concepts tels que l'architecture SaaS multi-tenant qui permet à de nombreux clients de partager une application ou une fonction précise, sans mélanger leurs données.

Pas encore de SaaS multi-tenant

On ne comprend pas encore clairement si les Applications Fusion seront disponibles sous forme multi-tenant, une approche préférée par les fournisseurs de SaaS, car elle permet de réduire les frais généraux du système et facilite le déploiement des mises à jour pour de nombreux utilisateurs à la fois. Les applications SaaS sont généralement vendues par abonnement sur la base d'une par utilisateur. Mais Oracle semble croire qu'il sera plus rentable de s'en tenir à un modèle single-tenant pour Fusion et de maintenir le système traditionnel des licences séparément des bases de données et des autres technologies supportées. Selon Paul Hamerman, analyste chez Forrester Research, la stratégie Cloud d'Oracle apparaît comme une évolution de son service d'hébergement actuel Oracle On Demand, qui a fonctionné pendant des années. "Quand Oracle dit "Cloud", cela signifie hébergement", a t-il commenté. "Je pense qu'il y a une technologie nouvelle en jeu ici, mais la dernière du genre pour faire de l'hébergement."

OpenWorld 2010 : Mark Hurd dévoile un Exadata plus puissant

Dès la nomination de Mark Hurd comme président d'Oracle, il y a quinze jours, il apparut évident que parmi les attributions de l'ex-PDG de HP figurerait la promotion des solutions matérielles. On s'attendait notamment à le voir soutenir Exadata, le système de stockage de base de données, optimisé pour le datawarehouse et les processus intensifs de requêtes. L'homme connaît déjà le produit puisque sa version initiale, lancée en septembre 2008, a été co-développée avec HP.

Pour son premier OpenWorld en tant que dirigeant d'Oracle, Mark Hurd s'est ainsi vu confier l'annonce d'Exadata X2-8, version 3 du système, qui repose sur deux serveurs Sun 8-socket totalisant 128 coeurs Intel et 2 To de mémoire. Comme la V2 lancée en 2009, l'offre complète réunit 14 serveurs de stockage. Elle offre jusqu'à 336 To de capacités de stockage brutes. En interne, les serveurs communiquent entre eux par des liaisons Infiniband à 40 Gb/s et avec l'extérieur via une connexion Ethernet 10 Gb/s. L'armoire comprend jusqu'à 5 To de mémoire Flash cache pour accéder aux données les plus importantes lors des transactions réclamant des temps de réponse extrêmement rapides.

Solaris 11 Express ou Unbreakable Enterprise Kernel

Les clients ont le choix d'utiliser ces machines sous Solaris 11 Express ou avec l'OS Unbreakable Enterprise Kernel qu'Oracle vient d'annoncer. Ce dernier s'appuie sur la version 2.6.32 du kernel Linux et bénéficie d'optimisations mises au point en collaboration avec les équipes de développement d'Oracle (sur la base de données, les offres middleware et le matériel). Cet OS inclut aussi un kernel compatible Red Hat, compilé directement à partir de Red Hat Enterprise Linux.

Avec l'arrivée de cette troisième version d'Exadata, la V2, qui repose sur huit serveurs 2-socket, change de nom pour s'appeler Exadata X2-2. Elle se présente maintenant comme le modèle ouvrant la gamme, existant en quart de rack, en demi-rack, en full et multi-racks. Tandis que le modèle X2-8 est d'emblée proposé dans sa version complète (full rack), présentée comme une plateforme adaptée aux traitements nécessitant des processus de requêtes très intensifs et pour les applications de datawarehouse. Dans ce dernier domaine, la concurrence promet d'être rude avec IBM qui vient d'ajouter Netezza à son catalogue, et avec Teradata.

Oracle voit pour Exadata un avenir tout tracé dans la consolidation d'applications et de bases de données multiples en cloud privé (une grande base de données couvrant plusieurs noeuds avec RAC -Real application Cluster- ou plusieurs bases de données avec le cluster RAC One Node, option disponible depuis la version 2 d'Oracle Database 11g).

Illustration : Mark Hurd, président d'Oracle (crédit photo : Maryse Gros)

Observatoire des projets : Le taux d'échec reste élevé faute de méthode

Les premiers résultats de sont guère encourageants et les nombreux échecs semblent bien liés à une méthodologie défaillante dans les organisations. 16% des organisations ayant répondu au questionnaire admettent que la majorité des projets sont des échecs et seulement 30% que la majorité arrivent à l'heure. Les dépassements de délais sont importants mais, par contre, les dépassements de coûts sont déclarés comme rares.

Une première étude française

Cette étude est une première en France. Elle porte sur des entreprises de plus de 250 personnes issues d'un échantillon de 5000 firmes réparties de façon représentative en terme de taille et de secteur. Pour la réaliser, Daylight s'est associé à deux établissements d'enseignement supérieur et de recherche : l'ENSIIE (Ecole Nationale Supérieure d'Informatique pour l'Industrie et l'Entreprise) et l'IAE Lille (Institut d'Administration des Entreprises, université Lille I). Le Monde Informatique et CIO étaient également partenaires. Auparavant, il n'existait que des études d'origine américaine et dont le principal enseignement était qu'un tiers des projets étaient des échecs complets et la moitié dérivaient fortement en terme de délais, de budget ou des deux.

La première édition du baromètre annuel de l'« observatoire des projets en France à dominante SI » est bien sûr perfectible et, faute d'un recul suffisant, ses conclusions sont à prendre avec prudence, plus comme des tendances qualitatives. Les éditions successives, dans les années à venir, permettront d'affiner le propos.

Mais où sont les bonnes pratiques ?

La première tendance qui se dégage est catastrophique : si les référentiels de bonnes pratiques se multiplient, force est de constater que les entreprises n'appliquent que rarement leurs principes, même ceux de bon sens. Il en résulte un taux d'échec élevé. Pire, les entreprises sont incapables de tirer partie des échecs passés : non seulement il y a un très faible partage des connaissances en cours de projet mais, en plus, en fin de projet, il n'y a quasiment jamais de capitalisation de l'expérience acquise. De plus, le rôle du chef de projet n'est pas vu comme celui d'un véritable métier. Le chef de projet est tantôt vu comme un simple manager généraliste, tantôt comme un poste temporaire au sein d'une carrière. Il est vrai que l'autonomie de ceux-ci est souvent des plus limitées. Ils dirigent certes au quotidien des équipes mais ne maîtrise pas la composition de celles-ci, pas plus qu'il n'a de choix quant aux autres ressources dont il pourrait avoir besoin, notamment financières.

Moins de 10% des organisations disposent d'un SI collaboratif pour gérer un projet. Les projets sont déclenchés sur une vague étude d'opportunité. L'alignement stratégique -quand il existe- est mené quasiment exclusivement en mode top-down, sans aucune possibilité de retour formel de la base vers le sommet. Les référentiels de bonnes pratiques sont rarement utilisés. Il n'existe d'ailleurs pas de méthodologie de référence réelle (autrement qu'un document bureautique stocké dans un coin de l'intranet) dans plus des deux tiers des cas.

Des méthodologies à renforcer

Les développements sont souvent réalisés au fil de l'eau, avec des référentiels (cahier des charges...) peu ou pas formalisés. La contractualisation MOA/MOE est peu fréquente. « Sans vraie contractualisation, on ne peut pas réussir un projet » martèle pourtant Fadi Gémayel.

De même, la gestion de porte-feuilles de projets est très perfectible : les dépendances entre projets sont peu ou pas traités : les conflits de ressources vont être affrontés devant la hiérarchie qui va arbitrer en mode binaire, sans anticipation.

Quand une équipe de support aux projets existe, la structure est rarement permanente et son rôle consiste souvent à installer des outils de gestion de projets. Gestion des risques et gestion de la qualité sont soit absents soit très ponctuels. Leur intégration au processus du projet est exceptionnelle (moins de 10% des cas). Plaquées comme un projet parasite à côté du projet principal, leur utilité est des plus douteuses. La remontée des incidents est généralement déficiente et elle se limite à signaler que le client se plaint du produit livré.

Des projets vraiment stratégiques ?

Alors que la « gouvernance » est dans toutes les bouches depuis une dizaine d'années, que ce concept repose sur l'alignement stratégique du SI sur le business, on aurait pu croire que la qualification de « projet stratégique », donc prioritaire et intimement lié à l'avenir de l'organisation, serait un peu sérieuse.

Or, pour les répondants à l'enquête, un projet est stratégique soit parce que son budget dépasse un certain seuil (une évolution isofonctionnelle d'un parc machine peut donc être « stratégique ») soit parce que la direction générale l'a décidé sans aucunement justifier le qualificatif. Le prochain baromètre sera réalisé au printemps 2011. On peut rêver à une amélioration de la gestion des projets d'ici là.

OpenWorld 2010 : Les Fusion Apps d'Oracle attendues au 1er trimestre 2011

La première version tant attendue de la prochaine génération des applications Fusion d'Oracle sera disponible au premier trimestre de 2011. C'est ce qu'a déclaré hier son PDG, Larry Ellison, lors d'une allocution faite à la conférence OpenWorld 2010 à San Francisco. "Nous savions que nous devions réaliser une nouvelle génération de produits qui réunisse les meilleures fonctionnalités de PeopleSoft, de la suite E-Business et de Siebel," a-t-il dit. "Il nous a fallu cinq années et un énorme travail pour y parvenir. Cela continue à représenter un immense challenge en matière d'ingénierie." Oracle a du en effet ré-implémenter toutes les fonctionnalités "au sommet d'une infrastructure middleware moderne, et précisément au sein de notre propre middleware Fusion," a déclaré le PDG d'Oracle. "La Suite contient 10 000 processus intégrés uniques et la version finale comprendra 100 produits différents, tous disponibles simultanément," a-t-il ajouté. "Nous n'avions jamais fait cela auparavant, et j'espère que nous n'aurons pas à le refaire."

Selon Larry Ellison, Oracle "ne s'est pas réfugiée dans une grotte" pour développer son logiciel. L'entreprise a ainsi réalisé des tests à grande échelle avec certains clients tout au long du processus de développement de manière à offrir une interface utilisateur satisfaisante," a-t-il précisé. Le logiciel "ne ressemble pas beaucoup à la suite E-Business, il ressemble peu à SAP. Il apporte une interface moderne."

"Les applications sont disponibles auprès d'Oracle sur site ou à la demande," a-t-il indiqué. "Ce sera aux clients de décider. Ils peuvent aussi commencer à utiliser le logiciel à la demande et le déplacer ensuite facilement en interne s'ils le désirent." Le PDG d'Oracle a précisé que l'entreprise n'avait pas l'intention de pousser les clients qui utilisent des produits logiciels plus anciens à passer à Fusion. "Nous pensons que, pour la plupart des clients, la bonne chose à faire est de voir comment se passent les premiers déploiements... Ils pourront s'orienter vers Fusion quand ils le souhaitent. Ils sont les mieux placés pour savoir comment effectuer le déploiement de leurs ressources informatiques."

D'autres sessions de présentation des Fusion Apps sont prévues jusqu'à jeudi, date de la clôture de l'OpenWorld 2010.

Illustration : Larry Ellison, fondateur et PDG d'Oracle, crédit photo IDG NS

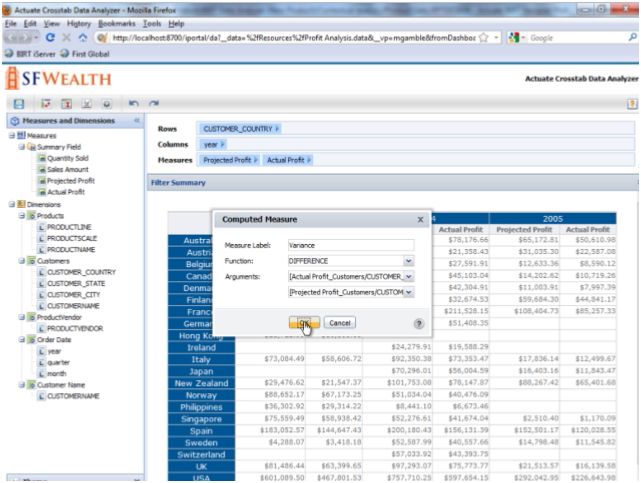

La suite BI d'Actuate en route vers le cloud

Voilà déjà six ans que l'éditeur de solutions décisionnelles Actuate a créé son projet Open Source basé sur Eclipse. Celui-ci rassemble des outils de reporting et de visualisation de données pour bâtir des applications web en Java et J2EE. Selon Actuate, le nombre de développeurs travaillant avec ces technologies, en particulier avec le logiciel BIRT design, aurait maintenant dépassé les 750 000.

La suite intégrée ActuateOne que l'éditeur s'apprête à livrer s'appuie sur cet environnement de conception qui peut récupérer des données provenant de sources disparates (bases relationnelles, XML, web services, applications, fichiers plats, documents, flux d'impression, cubes multidimensionnels, datawarehouses...). Elle inclut les versions 11 des produits qu'Actuate a développés au-dessus de BIRT (Business Intelligence Reporting Tools), ainsi que la dernière mise à jour du serveur de rapports, iServer, qui supporte des déploiements en volume et qui peut s'installer en interne ou dans le cloud.

Analyse en mémoire pour l'utilisateur métier

La suite ActuateOne servira à générer du reporting ad-hoc, créer des tableaux de bord interactifs et effectuer des analyses en mémoire. Elle inclut les logiciels BIRT 360 et BIRT Data Analyzer, le premier mettant entre les mains des utilisateurs les outils pour constituer des tableaux de bord sans recourir aux équipes informatiques. Le logiciel utilise notamment Google Gadget, ce qui permet aussi aux éditeurs indépendants de créer des applications mashup.

L'outil OLAP Data Analyzer apporte de son côté la puissance de l'analyse croisée à travers une interface intuitive conçue pour faciliter l'exploration et la découverte d'informations.

Cliquer sur l'image pour l'agrandir

Les utilisateurs peuvent aussi créer de petites applications (widgets) AIR en Flash pour visualiser des données, et exporter sous forme de fonctions Excel des champs calculés et des données agrégées. Ils produiront également des documents Word, PowerPoint, PDF et XML.

Optimiser le traitement en réaffectant les instances

La suite ActuateOne s'appuie sur le serveur de rapports BIRT iServer pour gérer les déploiements, en interne et sur des clouds, privés ou publics, ou encore dans des environnements de cloud hybrides. La version 11 du serveur intègre des capacités d'évolutivité (baptisées Elastic Clustering) permettant de réassigner, ajouter ou supprimer une image 'stateless' de BIRT iServer, de façon dynamique et automatique au sein d'un cluster sans interrompre les traitements. Tous les paramètres de l'image sont configurés de façon externe, afin que l'instance mise en place prenne en charge un rôle prédéfini dans le cluster. La consommation des ressources s'en trouvera optimisée. Actuate cite en exemple un cluster optimisé pour un traitement en volume pendant la nuit tandis qu'il se concentrera, pendant la journée, à l'analyse des données en temps réel en mémoire pour l'alimentation des tableaux de bord.

L'éditeur souligne que l'architecture de BIRT iServer 11 supporte les déploiements multitenants et que des outils permettent aux clients de reconfigurer leurs environnements à tout moment au fur et à mesure de l'évolution de leurs besoins pour supporter tout type d'environnement virtualisé. Les capacités d'administration couvrent les déploiements en mode SaaS, PaaS, interne multi-tenant ou sur des systèmes départementaux multiples.

Plusieurs modes de tarification sont associés à la suite ActuateOne, facturée à l'utilisateur nommé ou sur la base d'un nombre illimité d'utilisateurs par CPU. D'autres modèles de licences, par 'unité de travail', sont également prévus pour les environnements de cloud.

SAP livre dix solutions analytiques conçues avec ses clients

L'éditeur allemand SAP se fait fort de co-innover main dans la main avec ses clients et ses partenaires. C'est un sujet sur lequel le spécialiste des applications d'entreprise insiste beaucoup depuis quelques années. Et plus encore ces derniers mois. Touché l'an dernier par la crise économique, il lui faut mettre les bouchées doubles pour prouver sa capacité d'innovation. Bill McDermott, co-PDG du groupe, a rappelé cette volonté hier, lors d'une présentation retransmise en direct depuis la conférence DEMO Fall 2010 (Santa Clara, 13-15 septembre). L'éditeur y annonçait dix applications analytiques spécifiquement adaptées à six secteurs d'activité : la santé, la distribution de détail, les télécommunications, la banque, les produits de grande consommation et le secteur public. Chacune de ces solutions apporte quelques centaines d'indicateurs clés de performance (KPI), élaborés en collaboration avec les clients de SAP sur chaque secteur. Destiné aux chaînes de boutiques spécialisées, le produit porte par exemple sur l'analyse les ventes ; celui s'adressant aux banques couvre le suivi du risque client en entreprise.

Mesurer la qualité du service apporté aux patients

Lors de la présentation, l'éditeur a choisi de détailler les capacités de l'offre SAP BusinessObjects Quality Management for Healthcare (illustration ci-dessus). Destinée aux hôpitaux, celle-ci permet d'agréger et d'afficher les mesures recueillies sur les soins et services apportés aux patients. Les indicateurs proposés ont été mis au point avec l'aide de centaines d'établissements de santé, a expliqué Keith Costello, directeur général de l'activité Solutions analytiques chez SAP. Selon lui, les dix solutions métiers lancées hier par SAP ont été conçues pour se déployer en quelques semaines (à partir de huit semaines, avance l'éditeur) ou quelques mois (et pas en plusieurs années, a-t-il promis - sic). L'ensemble des éléments techniques nécessaires à leur mise en oeuvre sont inclus. « Tout ce dont le client a besoin est dans la boîte ! », selon Keith Costello. Il considère aussi que ces solutions s'abordent avec une formation réduite et s'exploitent facilement. Elles s'appuient par ailleurs sur une architecture qui permettra aux entreprises d'en étendre ultérieurement les fonctionnalités, avec l'aide des partenaires.

Enfin, ces solutions ne s'adressent pas uniquement à la base installée de SAP, a ajouté le responsable des offres analytiques. « Les entreprises entendent tirer le maximum de leurs investissements informatiques ; nos applications fonctionnent indépendamment des systèmes utilisés. »

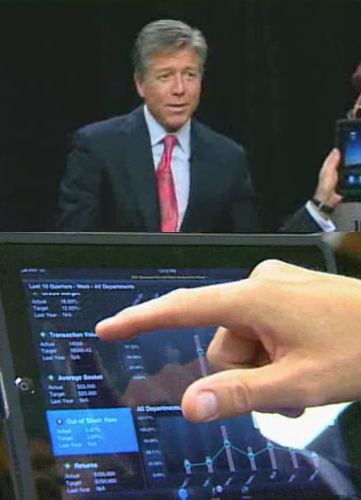

L'iPad, nouveau sésame vers la mobilité

En préambule, armé de la tablette numérique d'Apple, Bill McDermott avait montré comment un dirigeant pouvait lui-même, en temps réel, explorer ses données gérées sur le terrain et, le cas échéant, transmettre des instructions à ses équipes dans la foulée. Et ce, sans se préoccuper du volume de données auquel il accède ainsi depuis son iPad. « 100 millions d'enregistrements traités en quelques dixièmes de seconde, a souligné le co-PDG à Santa Clara.

Cliquer sur l'image pour l'agrandir

Bill McDermott a rappelé qu'avec son co-PDG Jim Hagemann Snabe, ils étaient déterminés à doubler le marché ciblé par SAP en s'imposant sur l'un des segments qui se développe le plus vite : celui de l'analyse en mémoire en temps réel déclinée dans des offres décisionnelles « On Demand », accessibles depuis tout poste de travail, smartphone ou tablette. Rappelons que SAP prépare avec Sybase, racheté au printemps, une plateforme mobile ouverte qui doit permettre d'accéder à n'importe quelle application de gestion depuis la plupart des terminaux mobiles. Sa livraison est prévue pour 2011.

Illustration : SAP BusinessObjects Quality Management for Healthcare (...)

Informatica : bientôt racheté par Oracle ?

Lors d'un sondage réalisé au cours des deux derniers mois par le cabinet Software Advice, l'entreprise Informatica arrive en tête dans les réponses à la question "Quelle pourrait être le prochain achat d'Oracle ?" avec 178 citations, suivie de près par Teradata qui récolte 175 voix, et VMware qui totalise 143 votes. Un sondage similaire réalisé par Dennis Moore sur un blog réputé pour ses articles abordant les questions de logiciels d'entreprise, donne une "majorité écrasante" à Informatica. Le sondage, toujours ouvert, a récolté 250 réponses.

Avec ses 500,7 millions de dollars US de bénéfices déclarés en 2009 et une capitalisation boursière qui atteignait 3,2 milliards en fin de semaine dernière, l'un des plus importants et derniers vendeurs indépendants en intégration de données de l'industrie ne serait pas une acquisition de second plan pour Oracle. Pour l'instant, ni l'éditeur de Redwood Shores, ni Informatica n'ont commenté ces spéculations qui ont régulièrement alimenté les rumeurs ces dernières années. D'ailleurs, d'autres observateurs de l'industrie ont minimisé les résultats de ces sondages. Pour Rob Karel, analyste chez Forrester Research, il existe trop de chevauchements entre les portefeuilles produits de ces vendeurs. En outre, "l'acquisition d'Informatica serait", selon lui, "un aveu d'échec de la part d'Oracle, signant l'abandon de la voie de l'intégration de données prise en 2006 après le rachat de Sunopsis, et la perte sèche des investissements consacrés à l'intégration d'Oracle Data Integrator dans leur portefeuille middleware", a-t-il estimé.

Qui d'autre peut acquérir Informatica ?

"Mais il serait imprudent de nier le fait qu'Oracle pourrait acheter Informatica", a-t-il ajouté. "D'une part, Oracle est l'une des rares entreprises capables de payer plusieurs milliards de dollars pour acquérir Informatica, et d'autre part, beaucoup de leurs bases de données existantes et d'applications clients sont standardisées sur Informatica", a-t-il commenté. "Même si cet achat suppose de nombreux équilibrages de portefeuilles et implique des choix difficiles pour résoudre le chevauchement des produits, la question n'est pas hors sujet", a-t-il précisé. "Oracle pourrait très bien acquérir Informatica, autant pour sa base installée que pour la mettre hors de portée d'autres prétendants", a ajouté Rob Karel.

L'achat d'un intégrateur aurait plus de sens

Un autre observateur, Adrian Merv de IT Market Strategy, est du même avis. "Informatica est une cible idéale pour de nombreuses entreprises, mais le niveau de chevauchement avec l'activité d'Oracle laisse à penser que cette acquisition viserait plus à éliminer un concurrent sur le terrain qu'a prendre une position stratégique," a-t-il souligné. "Je pense que le prochain mouvement d'Oracle se situera dans le domaine du hardware, et non du software", a-t-il ajouté. En effet, "cela ferait plus de sens pour Oracle d'aller chercher un fournisseur réseaux comme Juniper Networks ou un intégrateur systèmes, depuis que l'acquisition de Sun Microsystems l'a poussé sur le marché du hardware", a déclaré Ray Wang, analyste chez Altimeter Group.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |