Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 681 à 690.

| < Les 10 documents précédents | Les 10 documents suivants > |

(10/01/2011 10:59:48)

Dassault Systèmes pointe à la 22e place des acteurs mondiaux du logiciel

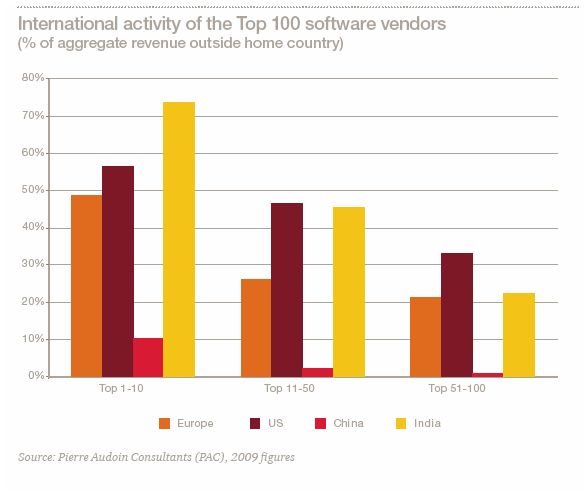

L'industrie du logiciel représente un marché mondial de 250 milliards de dollars, dans lequel le continent américain représente 44%, l'Europe 36% et l'Asie, 20%. Sur l'échiquier des acteurs qui l'alimentent, la prépondérance des Etats-Unis est toujours écrasante. C'est ce que montre le Global Software Leaders, établi par PricewaterhouseCoopers, avec PAC et le soutien d'associations d'éditeurs comme l'Afdel et l'ESA. Outre un classement global, PwC liste les cent premiers éditeurs mondiaux aux Etats-Unis, en Allemagne, au Royaume-Uni et en France, mais aussi en Chine et en Inde, soulignant ainsi l'ascension des fournisseurs asiatiques sur ce secteur.

Il apparaît vite que les cent premiers éditeurs originaires des Etats-Unis pèsent près de 60% des éditeurs mondiaux, bien loin devant tous les autres. Pour calculer ces estimations, PAC a pris en compte les revenus 2009 issus des ventes de licences logicielles et de contrats de maintenance et de support associés (exprimés en euros). Derrière les Américains, seul le Top100 allemand parvient à réunir 6% du total grâce au poids de SAP et de Software AG. Le Top100 anglais atteint 3%, avec Sage en tête, et le Top100 français arrache 2%, tiré par Dassault Systèmes. Quant aux Top100 chinois et indien, ils représentent chacun 1%.

Un logiciel chinois local, contrairement à l'Inde

Sur le podium des éditeurs chinois figurent les sociétés Neusoft Corporation, Ufida Software et Shanghai Baosight, avec des chiffres d'affaires sur le logiciel allant de 222 millions d'euros à 102 millions d'euros (M€), mais pour des ventes essentiellement locales. En Inde, à l'inverse, l'activité internationale des acteurs est importante. Sans surprise, on retrouve des noms déjà bien connus au niveau global : Tata Consultancy Services, Infosys et 3i Infotech, avec des revenus logiciels respectifs autour de 140, 137 et 117 millions d'euros. Les revenus logiciels des autres pays rassemblés représentent 28% du tout, parmi lesquels figurent des acteurs japonais comme les géants Fujitsu, Nec et Hitachi (12e, 17e et 18e du classement mondial des fournisseurs de logiciels).

agrandir l'image

Au classement général, les Etats-Unis, champions toutes catégories, réunissent dix sociétés parmi les onze premiers générateurs de chiffre d'affaires sur le marché du logiciel. En 2009, Microsoft, IBM et Oracle ont réuni à eux seuls 61 milliards d'euros (Md€) sur leurs revenus de licences, de maintenance et de support, à comparer aux 89 milliards d'euros réalisés par le Top11 mondial. Selon les critères retenus par PAC, les revenus logiciels de Microsoft se sont élevés à 32,7 Md€, soit 77% de son chiffre d'affaires (CA), ceux d'IBM à 14,4 Md€ (21% de son CA) et ceux d'Oracle à 13,8 Md€ (83% de son CA).

Le revenu logiciel d'Apple le hisse à la 11e place

Après l'éditeur allemand de solutions de gestion SAP, à la quatrième place, EMC est le cinquième générateur de revenus logiciels au niveau mondial, avec 4,24 Md€ en 2009, soit 42% de son chiffre d'affaires total, selon les estimations de PAC. N'oublions pas que le spécialiste du stockage a successivement absorbé les éditeurs Documentum (solutions de gestion de contenus et de documents), VMware (virtualisation), Data Domain (déduplication de données) et RSA (sécurité). Il a récidivé cette année avec Greenplum (datawarehouse). L'éditeur d'antivirus Symantec arrive juste derrière lui, avec près de 4 Md€ de revenus logiciels (94% de son CA total). On trouve ensuite le numéro 1 mondial de l'informatique, le constructeur et fournisseur de services HP. Situé en septième position, il ne génère que 4% de son chiffre d'affaires avec le logiciel, soit 3 Md€, mais il compte bien augmenter cette proportion, ainsi que l'a annoncé son nouveau PDG, Léo Apotheker, l'ancien dirigeant de SAP.

Dassault Systèmes : 90% du revenu à l'international [[page]]

En huitième position figure Computer Associates (2,8 Md€, 92% de son revenu total), puis Intuit (logiciels de gestion pour TPE et particuliers) et Adobe (logiciels multimédias et de création numérique). A la 11e place, on trouve encore un constructeur, Apple. Le fabricant du Mac, de l'iPhone et de l'iPad n'a pourtant généré que 6% de son chiffre d'affaires en logiciels, mais cette part atteint 1,5 Md€. Le Japonais Fujitsu est 12e. Son revenu logiciel ne représente, là aussi, que 4% des 35,6 Md€ qu'il a engrangé en 2009.

Viennent ensuite le Britannique Sage (logiciels de gestion, 13e), puis les Américains SAS (décisionnel), BMC Software (administration de systèmes) et Cisco Systems (réseaux et visioconférence). Suivent deux autres Japonais, les constructeurs NEC et Hitachi, tandis que la 19e et la 20e place sont occupées par Autodesk et McAfee. Ce dernier fait actuellement l'objet d'une procédure de rachat de la part du fabricant de processeurs Intel, ce qui prouve, s'il en était encore besoin, l'importance prise par le logiciel dans l'industrie IT.

Dassault Systèmes : 90% du revenu à l'international

Dans ce classement mondial, le premier éditeur français, Dassault Systèmes, arrive à la 22e place, derrière l'éditeur d'ERP Infor Global Solutions présidé depuis novembre par Charles Phillips, ex-président d'Oracle. Dassault Systèmes, spécialisé sur les solutions de conception et de gestion du cycle de vie des produits (CAO, PLM, usine numérique) présente une particularité, saluée de longue date : il réalise près de 90% de son chiffre d'affaires logiciel 1,1 Md€ (sur 1,25 Md€) à l'international. Ses ventes de logiciels en France ont avoisiné les 110 M€ en 2009. La semaine dernière, à Paris, Bernard Charlès, PDG du groupe français et membre de l'Afdel, réaffirmait avec force, lors d'une conférence de l'association française des éditeurs de logiciels, que « le logiciel est un élément majeur de transformation de l'économie et des processus d'innovation ».

Entre la 23e et la 25e place, signalons encore des éditeurs comme Citrix (virtualisation), Salesforce.com (plateforme cloud de CRM), mais aussi Synopsys qui développe des logiciels pour l'industrie des semiconducteurs et qui génère 780 M€ de revenus logiciels (78% de son CA). Sur la base des chiffres 2009, Sun Microsystems (acquis depuis par Oracle) figure encore à la 26e position dans le classement. Les places suivantes sont occupées par des acteurs des solutions de sécurité : TrendMicro (dont le siège social est installé au Japon depuis 1992), SunGuard et Check Point Software (31e). NetApp est 32e et le quatrième éditeur européen de ce classement mondial n'arrive qu'à la 33e place. Il s'agit de l'Allemand Software AG qui a racheté l'Américain webMethods en 2007.

PwC souligne trois tendances sur ce marché, qui vont amener les éditeurs à repenser leur modèle économique et à collaborer plus étroitement encore qu'ils ne le faisaient, entre eux et avec les fournisseurs de matériel, de services et de télécommunications. Ces trois tendances sont déjà bien identifiées puisqu'il s'agit du cloud computing, des terminaux mobiles et de la généralisation des technologies IT dans le grand public. Les utilisateurs réclament une synergie entre les outils qu'ils exploitent chez eux et ceux dont ils disposent au bureau. Cette évolution contraint les éditeurs à en tenir compte dans leurs produits, rappelle PwC en soulignant combien la R&D, l'innovation, le développement durable et la protection de la propriété intellectuelle vont devenir plus que jamais des domaines cruciaux.

Un classement séparé pour les acteurs des jeux

Dans son classement, PricewaterhouseCoopers réserve une place à part aux jeux vidéos, une industrie qui repose aussi sur le logiciel. « En fait, si le Global Software 100 incluait les fournisseurs de jeux, trois d'entre eux figureraient dans le Top10 mondial et 21 entreraient dans le Top100 », fait remarquer PwC. Ainsi le Japonais Nintendo a réalisé en 2009 un chiffre d'affaires de 4,35 Md€, le Français Activision Blizzard a engrangé 3,06 Md€ et l'Américain Electronics Arts, 3,02 Md€. A noter qu'un deuxième français, Ubisoft, se trouve parmi les dix premiers acteurs du jeu dans le monde.

Conférence LMI/CIO : Le cloud, passage obligé des systèmes d'information

Pour tirer le meilleur parti de ces services de nouvelle génération, l'entreprise doit disposer des réponses ad hoc qu'il s'agisse de sécurité, de qualité de service, de reprise de l'existant ou du respect des réglementations. Les décideurs IT devront être très attentifs aux aspects contractuels, voire opter pour un cloud privé afin de répondre à certaines contraintes.

Dans le même temps, la palette des applications d'entreprise basculées dans un cloud s'élargit. Elle englobe désormais des services stratégiques. On trouve aussi des usages du cloud computing pour de l'hébergement souple d'applications de gestion, pour la mise en ligne de sites Web ou de stockage, du test et du développement de logiciels, des outils collaboratifs, des applications décisionnelles, du BPM (Business Process Management), et du déploiement d'applications métiers destinées à un large usage via internet.

Clarifier les différentes offres

L'offre de cloud mérite cependant encore des clarifications afin de réaliser les bons arbitrages. Quel cloud choisir : privé, public ou hybride ? Quels types de services retenir : Paas (Platform as a Service), Iaas (Infrastructure as a Service) ou Saas (Software as a Service) ? Quelles applications basculer dans le cloud ? Comment marier son système d'information à un cloud ? Comment contractualiser le recours au cloud ? Quelle sécurité (confidentialité, récupération, traçabilité, sauvegarde) pour ses données ? Comment respecter les contraintes réglementaires ? Comment changer de fournisseur ?Outre l'hébergement d'applications virtualisées, le cloud se décline également en offres verticales via des services dédiés : Testing as a service, Desktop as a service, Database as a service, Data Recovery as a service, Storage as a service, Business Process as a service, Integration as a service, MDM as a Service ou Labs as a service.

Pour vous aider à bien comprendre ces enjeux, vous pourrez bénéficier de l'expertise de :

- Patrick Joubert, directeur transformation architecture et technologie, infrastructure du groupe à la Société Générale, co-pilote du groupe de Travail "Cloud Computing" au CRIP

- Pascal Pignon, responsable partenariats chez Google Enterprise Europe du Sud

- Pascal Thomas, directeur marketing audiences chez Pages Jaunes

- Jean-Pierre Dumoulin, responsable exploitation et infrastructure des SI pour le groupe PSA Peugeot Citroën

- Et enfin une table ronde sur les gains et les limites du Cloud Computing, privé ou public avec la participation de Hubert Tournier (DSI adjoint au groupement des Mousquetaires), Pascal Thomas (directeur marketing audiences de Pages Jaunes), Frédéric Charles, direction des systèmes d'information, stratégie et gouvernance - SI collaboratif à la Lyonnaise des Eaux et enfin de Benoit Tiers, CTO de Sanofi Aventis.

Pour vous inscrire à cette conférence du mardi 25 janvier 2010 à l'Automobile Club de France à Paris 8e rendez-vous à cette adresse : Le cloud, passage obligé des systèmes d'information

Enfin pour découvrir le planning des prochaines conférence LMI/CIO, une seule adresse : http://conferences.lemondeinformatique.fr/

Amazon Web Services enrichit ses offres de support et baisse ses prix

Cette stratégie accroît la concurrence avec des rivaux comme Rackspace et marque un positionnement clair pour les entreprises qui souhaite transférer certaines de leurs opérations dans le Cloud. AWS propose également une nouvelle offre de support Bronze, spécialement destinée aux développeurs de logiciels, qui ont constitué le coeur de cible de AWS au cours des dernières années : pour 49 dollars par mois, le support Bronze offre un soutien quotidien - calé sur les heures d'ouvertures et les jours ouvrables habituels - avec un temps de réponse garanti allant de 12 heures à un jour ouvrable.

Comparativement, la nouvelle offre Platinium cible plutôt les grandes entreprises, offrant pour sa part un temps de réponse garanti de 15 minutes dans les cas critiques. Ce niveau de support est également assorti d'un gestionnaire de compte attitré « aux compétences élargies, qui connaîtra le domaine d'activité et les besoins du client, saura l'accompagner dans toutes les phases d'utilisation de AWS et servira de contact principal, » comme l'indique Amazon dans son communiqué. Le tarif du support Platinium a été fixé au plus à 15 000 dollars par mois ou 10 % des frais d'utilisation mensuelle d'AWS par le client.

Silver et Gold moins cher

L'option Silver, qui couvre un support technique les jours ouvrables, avec des temps de réponse de quatre heures pour les questions «plus sérieuses», coûtera désormais au plus 100 dollars par mois ou 5 % des frais d'utilisation mensuelle d'AWS. Un plan Gold ajoute une assistance téléphonique 24h/24 et 7j/7 avec des de temps de réponse d'une heure pour les questions urgentes pour un prix fixé à 400 dollars par mois ou 5 à 10 % de l'abonnement mensuel. Ce pourcentage peut baisser en fonction du volume. Enfin, Amazon conserve son offre de base, laquelle donne accès à un centre de ressources, des FAQ, des forums et un « tableau de bord d'états » sans frais.

Cette modification de l'offre de support d'AWS intervient alors que certains fournisseurs de logiciels d'entreprise comme Oracle ont commencé à proposer un support total de leurs produits et à certifier certaines applications tournant sur Amazon. L'offre Platine d'AWS semble destinée en particulier à des clients qui pourraient être intéressés par un déploiement Cloud pour réduire leurs coûts et profiter de plus de souplesse, tout en ayant l'assurance de bénéficier d'un support haut de gamme pour l'infrastructure sous-jacente.

BP choisit HP pour consolider ses datacenters et les ouvrir au cloud

BP a annoncé avoir confié à HP le remplacement de ses datacenters à travers le monde. Le contrat, d'une durée de cinq ans, est annoncé pour un montant de 400 millions de dollars. « Selon les termes du contrat, HP fournira des services de centres de calcul à BP, à l'échelle mondiale, pour lui permettre de standardiser et de consolider ses services d'hébergement et de profiter d'innovations telles que le cloud computing » indiquent les deux firmes dans leur communiqué.

Ce contrat constitue en fait une extension au monde entier et une renégociation d'un contrat pré-existant qui ne concernait que le Royaume-Uni, pays du siège de la compagnie pétrolière. L'infogérance des centres de calcul inclut bien sûr l'administration des infrastructures matérielles, y compris les sauvegardes et la supervision, mais aussi celle des middlewares et des bases de données.

HP proposera des services, notamment de support, localisés dans différents pays, y compris en off-shore en Inde. Le prestataire s'est aussi engagé à permettre l'intégration de services de clouds externes en complément d'une offre de cloud disponible en option dans le contrat.

Ce contrat complète ceux signés il y a un an et demi qui réorganisaient la sous-traitance du pétrolier.

Le prix des puces DRAM chute en décembre

Le prix des puces équipant les barrettes de mémoire DRAM DDR3 a chuté à un prix moyen de 0,84 dollars par unité. C'est un effondrement par rapport à avril et mai 2010 où les puces DRAM se négociaient à 2,80 $, a déclaré Ivan Lin, rédacteur en chef du site DRAMeXchange. Cette baisse a quasiment atteint le prix plancher de 0,81 $ par puce en mars 2009.

La perte de valeur est consécutive à la période des fêtes en occident qui se termine, précise Ivan Lin. Les principaux fabricants tels que Elpida Memory, Powerchip Semiconductor et Samsung Electronics ont continué à produire les puces pour rester compétitif, a-t-il dit. L'augmentation des capacités des usines a également eu un impact sur les prix malgré les avertissements sur une potentielle pénurie de DRAM.

Un marché saisonnier

Les fabricants de PC dépensent environ 10%, soit 20 à 36 dollars, pour la DRAM dans le coût total d'un ordinateur souligne Iavn Lin. La baisse des prix de la mémoire devrait leur permettre soit de réduire les prix ou d'offrir de meilleures performances en ajoutant plus de mémoire. Depuis décembre, les fabricants de PC ont choisi d'écouler une partie de leur stock, a déclaré Helen Chiang, directeur de recherche chez IDC à Taipei. «Ils disposent d'un peu d'espace pour faire des promotions » dit-elle.

Cette tendance basse devrait se maintenir durant le premier trimestre 2011 prévient Ivan Lin. Les prix devraient alors remonter au deuxième trimestre, si la demande se redresse. «C'est saisonnier », a déclaré Eric Tang, vice-président de Powerchip basé à Taiwan. Le plus grand fabricant de l'île avec une capacité annuelle de 130 000 plaques a ajusté sa production en fonction de la baisse des prix. « Habituellement, nous ne voyons pas beaucoup de ventes au premier trimestre, mais dans le second, elles devraient augmenter. »

Crédit photo : D.R.

Les pertes de données de Hotmail entament la confiance dans le cloud

Cette erreur est certainement liée à un bug dû au changement de date. Après leur authentification, les utilisateurs de Hotmail, outre l'écran de bienvenue semblable à celui qui apparaît normalement après une période d'inactivité de service de 270 jours (délai d'inutilisation à partir duquel toutes les données sont automatiquement supprimées), ont eu la mauvaise surprise de trouver leur boîte de réception complètement vide. Microsoft affirme avoir résolu le problème et dit avoir pu restaurer les e-mails, rassurant des utilisateurs laissés dans l'inquiétude pendant plusieurs jours.

Avec ses 364 millions d'utilisateurs, Hotmail est le service de webmail le plus populaire au monde. Même si Microsoft n'a communiqué aucun chiffre sur le nombre d'utilisateurs affectés par le problème, environ 500 personnes ont posté des plaintes auprès du Windows Live Solution Center. 500 utilisateurs qui ont pris la peine de manifester leur mécontentement, sachant peut-être aussi sur quel forum le faire. En considérant que de nombreux internautes ont une connaissance limitée en matière technologique, on peut imaginer que le nombre total de personnes touchées est sans doute très important. Seulement 1% d'utilisateurs de Hotmail touchés, et ce sont potentiellement 3,6 millions de personnes concernées par la perte de données... Dans ce contexte, Microsoft a répondu à la manière d'un pompier qui annonce avoir maitrisé un feu, soutenant que les dégâts étaient « limités », et adressant ses excuses pour la gêne occasionnée. Une formule assez légère qui a du laisser les utilisateurs dans un certain désespoir face à la perte de ce qu'il considère comme une partie de leur vie.

Craintes sur le cloud ?

Surtout, cet accident arrive à un moment particulièrement mal venu pour Microsoft, puisque l'éditeur doit bientôt lancer Office 365, son premier essai d'envergure pour introduire une suite bureautique cloud. Car si la firme de Redmond ne peut pas assurer un service de mails fiable dans un cloud qu'elle gère depuis le siècle dernier, peut-on lui faire confiance en lui demandant d'héberger des données d'entreprise ? Et si Google ou d'autres fournisseurs de messagerie web envisageaient de profiter de ce faux-pas, mieux vaut le leur déconseiller. En effet, de temps à autre, un nombre important d'utilisateurs de Gmail a déjà vu disparaître l'ensemble des messages contenus dans leur boîte de réception. Cela a été le cas l'année dernière où des boites mails de certains utilisateurs ne contenaient plus aucun message, heureusement réapparus après 30 interminables minutes. Pour l'utilisateur de longue date, c'est un choc, car comment souvent, Gmail devient le miroir de sa propre vie. Le webmail sert de coffre-fort pour conserver des photos de famille envoyées à des proches en pièces jointes, il conserve la trace de numéros de téléphone ou d'adresses inscrits dans le corps des emails échangés, sans compter les divers mémos que l'on s'envoie à soi-même pour se rappeler certaines choses. En un mot, on compte un peu sur des services de type Gmail. Certains ont bien essayé de tout sauvegarder sur Google Gears, mais ont fini par abandonner, faute de savoir ou de pouvoir faire correctement les paramètrages. Il faut donc espérer que Microsoft et tous les fournisseurs de cloud tirent les leçons de ce nouvel incident. Ils doivent comprendre que chaque utilisateur est précieux. Chacun leur concède une confiance disproportionnée. Pour eux, un taux de fiabilité de 99,99 % n'est pas suffisant : ils attendent du 100 %.

Cette exigence ne s'applique pas nécessairement aux autres services en ligne. Par exemple, si Facebook s'effondrait, cela pourrait être irritant mais pas catastrophique (sauf pour un adolescent, peut-être). Au contraire, les services comme les suites bureautiques ou les plates-formes de messagerie sont différents. Parce qu'ils font parti d'un mode de vie très réel, et que nous les utilisons en permanence pour gérer notre quotidien. Nous leur accordons une confiance qui va bien au-delà de celle que nous concédions aux ordinateurs jusque-là. Et cela ne va pas aller en s'arrangeant, puisque le cloud fonctionne aussi sur nos téléphones portables et tablettes. Autant dire que les différents acteurs ont l'obligation de ne pas trahir la confiance que nous avons mis en eux.

Bilan virtualisation 2010 : Après les serveurs les postes de travail

Après le stockage et les serveurs en 2010, la virtualisation est appelée à se renforcer sur les postes de travail en 2011. Hyperviseurs de type 1 ou 2, VDI... les éditeurs et les constructeurs développent des solutions pour toutes les plates-formes : PC de bureau, portables, smartphones ou tablettes tactiles. Si les technologies de virtualisation des postes de travail sont aujourd'hui bien maitrisées, les utilisateurs se plaignent toujours de certains désagréments qui sont principalement liés aux capacités réseau, énormément sollicitées dans le cadre d'une infrastructure de bureau virtualisés. Reste la question du coût qui est généralement de 9 à 11% plus élevé que l'environnement PC classique selon une responsable de Microsoft, Gabriella Schuster. D'autres estiment au contraire que la VDI entrainerait une baisse des coûts de 20%, principalement en maintenance. Quoi qu'il en soit, avec la montée en puissance du cloud qui concentre son lot d'applications virtualisées, les départements informatiques sont naturellement amenés à reconsidérer la place des postes de travail dans l'entreprise. Mais ici encore les questions liées à la reprise en cas d'incidents et à la sécurité des données interpellent les responsables informatiques.

Nous vous proposerons le 6 janvier prochain un dossier complet sur la supervision des machines virtuelles qui se sont multipliées sur les serveurs avec la consolidation.

Les articles publiés en 2010 sur le sujet :

Le 28 mars 2010 : Pour la NSA, la virtualisation crée de nouvelles menaces

Le 8 avril 2010 : La virtualisation des postes de travail dans les starting-block

Le 4 mai 2010 : Bureaux virtuels, abondance et différences laissent perplexes

Le 11 mai 2010 : Microsoft minimise les avantages du VDI

Le 18 mai 2010 : Michael Dell, apôtre du VDI et du multi-équipement

Le 23 juillet 2010 : La virtualisation plus concrète et plus attractive que le cloud

Le 2 aout 2010 : VDI, Citrix reprend l'avantage sur VMware estime le Burton Group

Le 27 aout 2010 : Avant VMworld, Microsoft vante Hyper-V avec son client CH2M

Le 6 septembre 2010 : Les clients de VMware restent méfiants vis à vis de Hyper-V

Le 8 septembre 2010 : VMware travaille sur un VDI pour iPad

Le 30 septembre 2010 : La virtualisation s'invite sur les tablettes et les smartphones

Le 30 septembre 2010 : Fedora 14 teste la virtualisation de bureau

Le 12 octobre 2010 : VMworld 2010 : La virtualisation en route pour les clouds

Le 27 octobre 2010 : Avec le SP1, Microsoft dope la virtualisation sur Windows Server

Le 10 novembre : Microsoft pousse Hyper-V pour combler son retard dans le cloud

Le 8 décembre 2010 : VMware et LG dévoilent un smartphone virtualisé sous Android

Le 17 décembre 2010 : Plus de RAM pour améliorer la virtualisation sur serveurs

Bilan Processeurs 2010 : Puces multicoeurs pour serveurs et portables

(Mise à jour) C'est en mars qu'Intel lance ses processeurs Xeon 5600 Westmere gravés en 32 nm, un an après les Xeon 550 Gainestown (45 nm). Ces puces destinées au marché des serveurs (lames et rack) réunissent quatre ou six coeurs par socket, et promettent de meilleures performances pour une consommation d'énergie réduite. Très vite, Dell, Fujitsu, HP et IBM les intègrent dans leurs machines. Quelques semaines plus tard, Intel livre les Xeon Nehalem-EX. Ce sont les processeurs pour serveurs les plus rapides du moment. « Jamais le gap d'amélioration n'avait été aussi fort entre deux générations, affirmait alors Pascal Lassaigne, directeur du marché entreprises chez Intel France. Entre le Xeon 7400, classe Dunnington, et le 7500, sur base Nehalem-EX, les performances sont multipliées par trois en moyenne. » Cent serveurs monocoeurs pourraient être remplacés par 5 machines animées par des Xeon 7500 huit coeurs. « Et dans le cas où ces solutions monocores seraient remplacées par 100 unités Nehalem-EX, les performances seraient multipliées par 20. »

La réponse d'AMD ne se fait attendre. Le concurrent d'Intel, installé à quelques kilomètres de là dans la Silicon Valley, compte se battre sur le front des prix face au Xeon 5600 Westmere 32 nm. Il prévoit de proposer sa plateforme Maranello, qui peut recevoir quatre sockets Opteron « Magny-Cours » (8 à 12 coeurs), dans la même fourchette de prix que les deux sockets d'Intel. Présentée sous le manteau depuis plusieurs semaines, sa plateforme Opteron 6000 est officiellement dévoilée le 29 mars. Le gain de performance attendu est environ le double des précédentes puces six coeurs. AMD reprend une astuce, déjà utilisée par Intel, qui consiste à assembler des coeurs par couple pour fournir une puce Opteron 6100. Cette dernière, toujours gravée en 45 nm (contre 32 nm pour les Westmere et 45 nm également pour les Nehalem-EX), possède 1,8 milliard de transistors quand le Westmere en revendique 1,2 milliard et le Nehalem-EX 2,3. AMD espère aussi convaincre les entreprises de remplacer leurs serveurs bi-sockets par sa solution en leur faisant valoir la réduction des coûts sur les logiciels (la tarification des licences se fait généralement par processeur, sans tenir compte du nombre de coeur par puce).

Systèmes Unix : Itanium Tukwila, Power7 et Sparc T3

En février, Intel a également lancé, après de nombreux retards, son processeur Itanium connu sous le nom de code Tukwila. Cette puce 64 bits gravée en 65 nm a été conçue pour fonctionner sur des serveurs à faible tolérance de pannes. « Tukwila fait plus que doubler les performances de l'Itanium précédent », souligne alors Intel. Ce processeur à quatre coeurs est en concurrence directe avec les Sparc d'Oracle/Sun et les Power7 d'IBM. Justement, Big Blue annonce le sien quelques jours plus tard. Gravé en 45 nm, cadencé de 3 à 4,14 GHz, le Power7 sera livré avec 4, 6 ou 8 coeurs, chacun d'eux étant en mesure d'exécuter quatre threads. Une puce Power7 huit coeurs peut donc mener 32 tâches simultanément, soit quatre fois plus que les Power6. Comme chez Intel, la puce d'IBM possède une technologie baptisée TurbcoCore qui permet d'augmenter temporairement la fréquence des coeurs actifs (quatre sur huit). Ces pouces doivent fournir deux fois plus de performances que les Power6 en consommant quatre fois moins d'énergie, indique IBM.

En septembre, c'est au tour d'Oracle d'annoncer des serveurs animés par le processeur Sparc T3, une puce qui a commencé sa vie chez Sun Microsystems et que certains pensaient bien ne plus revoir depuis le rachat de la compagnie de Santa Clara. Connu sous le nom de code Rainbow Falls, ce Sparc T3 intègre jusqu'à 16 coeurs, soit deux fois plus que la précédente puce haut de gamme de Sun, l'UltraSparc T2 Plus, qui a été dévoilée il ya deux ans. Pour l'occasion, Oracle a procédé à un petit changement dans l'appellation de la marque en raccourcissant UltraSparc en simplement Sparc. Ces processeurs sont destinés aux serveurs de la série T d'Oracle sous Solaris.

L'option Atom ou ARM pour les serveurs

En marge des serveurs à base de Westmere, de Nehalem ou d'Opteron, d'autres options apparaissent sur le marché. Ainsi, le Californien SeaMicro annonce-t-il en juin qu'il a développé le SM 1000, un serveur composé de 512 Atom, processeurs à faible puissance d'Intel, montés sur de petites cartes mères. Des puces que l'on trouve habituellement dans les netbooks bon marché. Andrew Feldman, PDG de SeaMicro et personnage controversé dans la Silicon Valley, justifie son choix en expliquant que les Atom peuvent être plus efficaces sur le plan énergétique que des processeurs x86 traditionnels. En particulier pour le cloud et pour certains types d'opérations sur Internet, où les charges de travail sont souvent plus petites en taille, mais plus importantes en volumes. Mais Intel, de son côté, ne souhaite pas positionner les processeurs Atom sur le marché des serveurs, considérant notamment que ce type d'offres ne peut se limiter qu'à des marchés de niche.

[[page]]

En revanche, c'est un terrain sur lequel ARM pourrait s'aventurer. En septembre, le spécialiste des puces à basse consommation lève le voile sur sa prochaine génération de processeurs. Le fabricant promet des performances cinq fois supérieures qui lui permettraient de se positionner au-delà des smartphones et tablettes tactiles, sur des routeurs coeurs de réseaux et sur des serveurs, justement. ARM pré-annonce ainsi sa plate-forme Cortex-A15 MPCore, qui illustre le saut de génération avec ses modèles Cortex-A8 et Cortex-A9. Or, l'architecture du A9 vient à peine d'être licenciée auprès des constructeurs et le A15, lui, ne sera disponible que fin 2012.

Chez AMD, une puce hybride pour PC portable

Du côté des processeurs pour postes de travail, le nombre de coeurs disponibles continue à progresser. En janvier 2010, sur le salon CES de Las Vegas, Intel annonce la commercialisation des Core i7, i5 et i3. Ils sont gravés en 32 nanomètres, ce qui permet notamment d'intégrer le circuit graphique 2D/3D à l'intérieur du proceseur. La famille Arrandale se destine aux PC portables tandis que la gamme Clarkdale vise les postes fixes. Quelques mois plus tard, les Core i3, i5 et i7 sont intégrés par Apple à ses ordinateurs iMac et MacPro.

En juillet, on apprend que les premières puces Fusion d'AMD devraient très prochainement apparaître sur les netbooks et les notebooks d'entrée de gamme, mais que rien n'est encore prévu pour les tablettes. Quelques semaines auparavant, le fondeur avait dévoilé les premières puces se basant sur l'architecture de type Fusion. Celle-ci combine des coeurs CPU et GPU au sein de la même entité. La puce Fusion Ontario, par exemple, possède deux coeurs x86 et un circuit graphique DirectX 11. Ce dispositif devrait rendre AMD plus compétitif dans les marchés de netbooks, entre autres, dominés à l'heure actuelle par Intel.

Dans la famille Fuxion, AMD fournit aussi un aperçu de Llano, son prochain processeur hybride pour ordinateurs de bureau et PC portables, qui combine CPU et GPU DirectX 11 sur une seule puce. Il l'a dévoilée lors d'un forum technique d'AMD et d'un salon à Taipei. Elle devrait servir à construire des PC plus légers et plus économes en énergie. Le circuit graphique devrait être capable de décoder des disques Blu-ray, et le processeur d'exécuter simultanément plusieurs grosses applications en tâche de fond. Mais le CPU et le GPU seront aussi capables de travailler ensemble pour accélérer certains logiciels non graphiques et très gourmands en données, affirme le fabricant. Cette puce devrait disposer de quatre coeurs fonctionnant à des vitesses supérieures à 3.0 GHz. Elle est attendue en 2011, mais AMD n'a pas encore fourni de date précise quant à son intégration dans des PC.

Premiers portables Sandy Bridge en janvier

Quant à Sandy Bridge, la prochaine génération de processeurs Intel pour PC et portables, elle a été présentée fin août quelques jours avant la conférence développeurs IDF du constructeur. Ces puces comportent une douzaine de fonctionnalités pour améliorer les performances graphiques et, notamment, le décodage matériel des films Blu-ray 3D. Les portables qui exploiteront cette architecture seront capables de lire des films en 3D en préservant l'autonomie de la batterie, annonce Intel. Les puces Core ix 2000 Sandy Bridge doivent arriver chez les constructeurs pour la fin de l'année. De fait, en décembre, un peu avant le lancement officiel des puces (au CES 2011 de Las Vegas), HP et Lenovo pré-annoncent les premiers PC portables qui les intègrent. Parmi eux figure un HP Pavilion à écran 17,3 pouces doté du Core i7 2630QM équipé de quatre coeurs à 2 GHz et de 6 Go de RAM DDR3. Le tout pour 1 150 dollars environ. Chez Lenovo, les modèles, plus petits, démarrent à 850 dollars avec des Core i7.

Illustration : A sa sortie, le Nehalem-EX d'Intel représente le processeur le plus puissant jamais livré jusqu'alors (crédit photo : D.R.).

Les articles publiés en 2010 sur le sujet :

- Le 11 janvier 2010 : CES 2010 - Les processeurs 32 nm d'Intel enfin disponibles

- Le 3 février 2010 : Tukwila, la dernière puce Itanium d'Intel, arrive enfin

- Le 9 février 2010 : Avec le Power7, IBM relance la bataille des puces pour systèmes Unix

- Le 12 février 2010 : Jasper Forest, un processeur Intel Xeon Nehalem spécial stockage

- Le 17 mars 2010 : Dell, Fujitsy, HP, IBM et SGI annoncent leurs serveurs sur base Intel Xeon 5600

- Le 19 mars 2010 : Plateforme serveur quatre sockets au prix de deux chez AMD

- Le 23 mars 2010 : Opteron 6100, un gros 12 coeurs AMD pour contrer les 6 coeurs d'Intel

- Le 31 mars 2010 : Intel Nehalem-EX, cap sur les performances et la haute disponibilité

- Le 7 avril 2010 : Cisco adopte les Xeon 7500 d'Intel

- Le 14 avril 2010 : IDF Pékin - Android sur Atom et processeurs Sandy Bridge en vue

- Le 7 mai 2010 : Jusqu'à 12 coeurs pour le prochain Westmere-EX d'Intel

- Le 15 juin 2010 : SM1000, un serveur animé par 512 puces Atom

- Le 23 juin 2010 : AMD Opteron 4000, une vraie puce serveur à partir de 99 dollars

- Le 16 juillet 2010 : AMD en avance sur le développement de Fusion

- Le 27 juillet 2010 : Processeurs pour les iMac et MacPro

- Le 5 août 2010 : Accusé de pratiques anticoncurrentielles, Intel accepte la proposition de la FTC

- Le 18 août 2010 : Des processeurs double coeur pour les smartphones

- Le 19 août 2010 : Intel s'approprie des parts de marché AMD sur les serveurs

- Le 23 août 2010 : Intel lance enfin son Atom bi-coeur pour netbook

- Le 31 août 2010 : AMD envisage des serveurs équipés de puces de faible puissance

- Le 10 septembre 2010 : Des puces ARM pour serveurs avec 4 coeurs à 2,5 GHz

- Le 14 septembre 2010 : IDF 2010 - Sandy Bridge adopte le Turbo Boost pour le CPU et le GPU

- Le 21 septembre 2010 : Oracle défie les sceptiques avec ses serveurs à base de Sparc T3

- Le 6 décembre 2010 : DOSSIER - Les dix tendances IT pour 2011

- Le 29 décembre 2010 : HP et Lenovo dévoilent leurs 1er PC portables Sandy Bridge

| < Les 10 documents précédents | Les 10 documents suivants > |