Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 101 à 110.

| < Les 10 documents précédents | Les 10 documents suivants > |

(05/01/2012 10:06:47)

Neo Telecom acquiert MIT pour étendre son réseau de datacenters régionaux

Créé en 2003, Neo Telecoms a développé son propre réseau international de transit pour les entreprises, un réseau en fibre optique en Ile-de-France, des salles machines, une offre cloud en infrastructure depuis quatre ans (à l'époque on ne parlait pas encore de Iaas). Comme 50% du marché se trouve en région, l'opérateur a décidé de développer un projet régional d'implantation de datacenters afin de mieux servir ses clients PME. Il compte déjà des points de présence dans les grandes métropoles.

Neo vient d'annoncer le rachat de la société MIT, implantée à Montpellier. Elle a créé un datacenter de 400 mètres carrés et cherchait à se développer plus fortement. Neo Télécoms la rachète et garde l'équipe dirigeante. Au total, Neo aimerait une dizaine de datacenters en région. Il offrira alors un hébergement régional avec des services clouds et des liaisons à l'international. Neo Telecoms se veut être déjà le 2ème opérateur en France, derrière Orange, en termes de transit IP.

Nancy, Metz, Toulouse et Besançon

Plusieurs autres datacenters en région sont déjà développés. L'un par une filiale implantée dans l'Est, Arcan Networks, qui compte un datacenter à Metz, un autre à Nancy. A Toulouse, Neo Telecoms a racheté un bâtiment et implanté son datacenter, ouvert au mois de septembre dernier. Autre formule donc, à Montpellier avec une croissance externe. A Besançon enfin, la société construit un datacenter dans le cadre d'une joint-venture avec la société Euclyde et l'appui des collectivités locales. Ces dernières ont réaménagé un site industriel qui va accueillir le datacenter et vont le connecter avec leur réseau, Lumiere. La ville et le Grand Besançon ayant une longue pratique des technologies, le réseau Lumiere est opérationnel depuis 2000, il a été initié dès 1994 !

En 2012, la demande en serveurs économes en énergie va profiter aux puces ARM

Les processeurs de type basse consommation proposés par des compagnies comme ARM pourraient être massivement utilisés dans les centres de calcul en 2013, et leur association avec des puces graphiques pourrait apporter des améliorations de performances et entrainer d'importantes économies d'énergie, selon les analystes. Les premières expériences autour des processeurs ARM dans des serveurs sont déjà en cours -chez HP notamment- , et les puces graphiques sont déjà utilisées dans certains des supercalculateurs les plus rapides du monde.

L'efficacité énergétique a été un des éléments déterminants pour l'achat de serveurs chez les clients désirant maintenir leurs coûts d'exploitation tout en déployant des applications , selon les analystes. Cette année, on a assisté à un pic dans l'accumulation de clouds et de serveurs haute performance autour du modèle « hyperscale », dans lequel la densité des machines est très élevée pour réduire la consommation d'énergie tout en augmentant la performance globale.

Passer de x86 à ARM pour certains usages

Pour réaliser des économies électriques supplémentaires, les entreprises pourraient envisager d'utiliser à l'avenir des serveurs avec processeurs ARM basse consommation, qui sont aujourd'hui à l'oeuvre dans la plupart des tablettes et smartphones. «Les clients font des tests avec beaucoup de technologies différentes. Ils essaient de gagner en efficacité», a déclaré Jed Scaramella, directeur de recherche chez IDC. Les entreprises mesurent désormais leur consommation en kilowatt et en mètre carré/euros, et la mesure des performances par watt des serveurs est devenue beaucoup plus précise. La croissance des plates-formes de type cloud computing contribue à l'augmentation des ventes de serveurs, avec de nombreuses entreprises qui construisent des clouds publics et privés. Beaucoup de serveurs x86 bi-socket ont été achetés pour créer des infrastructures de ce type autour du modèle hyperscale, qui permet à de nouvelles machines d'être raccordées très facilement pour augmenter les performances globales. Les serveurs utilisant cette architecture hyperscale sont généralement utilisés pour des applications analytiques et décisionnelles. «Elles ne sont pas jetables, mais elles sont clairement conçues pour travailler avec des coûts réduits. C'est vraiment une question d'efficience énergétique ... et de souplesse à l'usage », a déclaré M.Scaramella.

Des serveurs denses avec des processeurs ARM pourraient être une alternative à la technologie x86 dans les prochaines années quand les DSI exigeront encore plus de densité et d'économies d'énergie. Les analystes soulignent que l'agrégation de puces ARM basse consommation pourrait fournir une capacité de traitement plus efficace sur des plates-formes de type cloud computing de nuages que les traditionnelles puces serveurs x86 (Intel Xeon ou AMD Opteron), qui sont plus gourmandes en énergie. Les processeurs ARM sont cependant moins intéressants que les puces x86 pour traiter des tâches gourmandes en ressources comme les ERP (Enterprise Resource Planning).

Des serveurs ARM en cours de tests chez les clients de HP

En 2011, certaines entreprises ont introduit des serveurs expérimentaux reposant sur des processeurs ARM. Hewlett-Packard a ainsi annoncé en novembre dernier une machine utilisant des puces quad-core Calxeda, sur un design ARM, qui consomment 1,5 watt de puissance par puce. De son coté, Nvidia a indiqué le mois dernier qu'un supercalculateur a été construit à Barcelone autour de sa puce Tegra 3, qui repose sur une architecture ARM quad-core. Et pour accélérer les calculs scientifiques et mathématiques, un bloc de trois puces Tegra - soit douze coeurs - est jumelé avec des processeurs graphiques. « Ce qui s'est passé en 2011, c'est que l'on a commencé à voir des feuilles de route et des produits. Les solutions sont devenues « réelles », mais cela ne signifie pas qu'elles vont gagner des parts de marché l'année prochaine [en 2012, NDLR], a déclaré M. Scaramella.

[[page]]

Une rupture dans l'architecture serveur traditionnelle x86 au profit de celle d'ARM sera étroitement surveillée, mais l'impact ne se fera vraiment sentir qu'en 2013 au plus tôt, a déclaré Dan Olds, analyste principal chez Gabriel Consulting Group. Presque tous les fabricants majeurs de serveurs vont expérimenter des machines avec des processeurs ARM, a poursuivi M. Olds. « Si c'est suffisamment réel pour que HP lui donne le feu vert, cela signifie que le marché existe », a déclaré l'analyste. « Cela va dépendre de la feuille de route 64 bits d'ARM. »

Il manque encore les instructions 64 bits

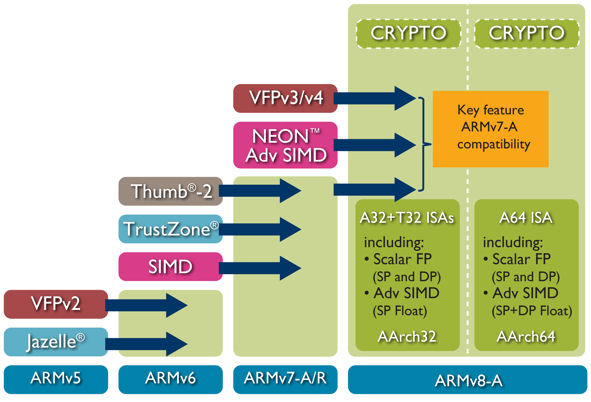

Les processeurs ARM actuels ne supportent que l'adressage 32 bits et ne possèdent que des fonctionnalités très limitées pour la correction d'erreurs. Avec les instructions 64 bits, les ordinateurs peuvent utiliser une plus grande quantité de stockage et de mémoire, ce qui est bénéfique pour les applications intensives. Fin octobre 2011, ARM avait présenté sa première architecture microprocesseur 64 bits, l'ARMv8, destinée aux marchés des systèmes embarqués et des serveurs.

L'idée du couplage CPU ARM et GPU est également fascinante, selon M. Olds. Les circuits graphiques sont utilisés sur certains des supercalculateurs les plus rapides au monde, et sont capables d'offrir des performances bien supérieures à celles des processeurs traditionnels pour exécuter certaines applications. « Une telle combinaison serait un moyen d'offrir une densité beaucoup plus élevée, avec un coût au watt moindre », a poursuivi l'analyste.

La transition x86 vers ARM risque de prendre du longtemps

Les processeurs graphiques s'infiltrent progressivement dans les supercalculateurs et sont de plus en plus utilisés pour le calcul haute performance dans l'énergie, les produits pharmaceutiques, les services financiers, les médias et d'autres industries, selon M. Olds.

Mais les analystes conviennent que le passage de l'architecture x86 à celle d'ARM reste encore un défi en raison des problèmes matériels et logiciels. Les clients sont déjà en train de réfléchir aux différentes options d'achat avec les matériels disponibles, pour optimiser la charge de travail de leurs systèmes en regroupant serveurs, stockage, réseaux et logiciels. Si la plate-forme ARM offre certains avantages, elle reste un élément perturbateur et son adoption prendra du temps. « C'est un long voyage, il ne se déroulera pas une seule nuit », a ajouté M. Scaramella d'IDC.

Gerry McCartney, DSI de l'Université de Purdue dans l'Indiana, se fait l'écho de cette assertion, en indiquant que son université a beaucoup investi dans son infrastructure informatique actuelle. Elle s'appuie largement sur des serveurs x86, et une grande partie du code utilisé par les chercheurs est écrit pour le jeu d'instructions x86. «Les chercheurs ne veulent pas changer de logiciels », a déclaré M. McCartney. Il faudra plusieurs années d'efforts pour passer de l'architecture x86 à une autre et beaucoup ne voudraient pas aller vers cette nouvelle architecture. Notre université ne va probablement pas s'éloigner des puces x86, car les serveurs d'Intel sont de plus en plus économes en énergie, a déclaré M. McCartney.

À titre d'exemple, le supercalculateur Purdue Carter, qui se classe 54e au monde Top 500, offre plus de performances par watt que les quatre autres supercalculateurs, également sur base Intel, achetés au cours des quatre dernières années. «Je ne pouvais pas me débarrasser des quatre machines précédentes, et j'utilise aujourd'hui un quart de l'énergie qu'elles consommaient auparavant », a déclaré M. McCartney. Le ratio de performance/consommation des puces Intel s'améliore avec chaque nouveau composant, selon lui. "Il y a eu quelques améliorations modestes dans l'encombrement, et nous sommes satisfaits en termes de consommation électrique », a déclaré McCartney.

Le marché du datacenter explose en Chine

La Chine construit beaucoup de datacenter, certains parlent de centaines, pour répondre à la croissance de la population connectée, estimé aujourd'hui à près de 500 millions de personnes. Les centres de calcul serviront aussi aux fournisseurs de services et opérateurs de télécommunications, pour faire du e-commerce, de la banque en ligne ou proposer des offres d'e-administration. La construction des datacenters est fortement soutenue par le gouvernement chinois, qui en a fait une priorité dans son dernier plan quinquennal. Les autorités régionales prévoient aussi le financement pour développer de grandes « citées clouds » - des zones industrielles qui seront capables d'accueillir à terme plus de 20 datacenters.

Ce déploiement donne de grandes opportunités pour des entreprises comme Hewlett-Packard et IBM. « Nous avons plus de personnes en Chine sur le développement des datacenters, que dans aucun pays dans le monde », a déclaré Rick Einhorn, directeur mondial de l'activité Critical Facilities Services de HP. La Chine est pour l'instant fortement tributaire d'aujourd'hui des expertises sur la conception, explique le dirigeant. Mais cela pourrait changer car les sociétés étrangères forment des ingénieurs chinois. D'autant que certains constructeurs chinois comme Huawei et ZTE développent leurs offres serveurs et stockage pour le cloud.

L'approche de l'Etat chinois sur les datacenters est de construire davantage et grand, a déclaré Glen Yuan, directeur des services datacenter au sein du groupe Greater China d'IBM. Les installations qui seront construites pour les banques et les opérateurs de télécommunications peuvent aller jusqu'à 50 000 mètres carrés. Le pays avait déjà une politique de développement de salles informatiques par le passé mais sans réels moyens. Aujourd'hui, la Chine veut aller vite et être à la pointe de la technologie. Ainsi, le datacenter du parc scientifique international de Suzhou (SISDC), en Chine du sud, par exemple, se targue d'être le premier datacenter du pays à être qualifié Tier 4, soit le plus haut niveau de performance. Construit avec l'aide d'IBM, cette infrastructure a ouvert une première tranche en octobre 2010 et prévoit un espace de 42 000 m² pour la deuxième tranche qui sera bouclée en 2013-2014. Le gouvernement de Suzhou a participé au financement avec l'espoir de devenir un centre majeur pour les services IT.

[[page]]

Il peut se rassurer, 80% de l'espace existant est déjà en usage ou réservé par des clients, notamment des établissements financiers étrangers qui sont obligés par la réglementation à stocker les données des clients chinois dans le pays. Le volet green IT n'est pas écarté, souligne Rick Einhorn, des directives gouvernementales sur les émissions de carbone relatives aux datacenters reposent sur les derniers standards en la matière.

Des écueils pour un développement dans le business international

Si les usages des particuliers dynamisent la construction des datacenters, les analystes restent sceptiques sur le fait que la Chine devienne une base des services IT internationaux. « Il reste des questions relatives autour des droits de propriété des données et d'autres actifs », a déclaré Michelle Bailey, analyste chez IDC et d'ajouter « il sera intéressant de voir si la Chine peut faire évoluer sa politique pour rester en phase avec le marché. »

Par ailleurs, certains problèmes de sécurité ou de sécurisation des datacenters restent en suspens. Un ancien consultant en sécurité qui a travaillé sur des projets de datacenter en Chine explique que les sociétés étrangères ont plusieurs raisons d'être inquiètes. Il cite 3 risques potentiels : le vol de données par les employés locaux, la surveillance du trafic et la perte d'équipements lors « d'inspections inopinées » par la police chinoise. Certains estiment que ces craintes sont infondées et ont été alimentées par la médiatisation de l'affaire Google.

Il existe d'autres défis pour la Chine comme assurer une bande passante performante pour les infrastructures. Cela est important car les utilisateurs se dotent de plus en plus rapidement de PC, de tablettes et de smartphones, a déclaré Sheldon Lui, un directeur du marketing produit chez Intel. Le ratio client-serveur en Chine est actuellement de plus de 60 pour 1, précise-t-il, alors qu'aux Etats-Unis, le rapport est de 20 pour 1. La Chine a presque cinq fois la population des États-Unis, donc nos problèmes sont cinq fois plus grande, a-t-il dit. « Si nous arrivons à les résoudre, nous deviendrions les leader en matière d'innovation » conclut-il.

Bilan processeurs 2011 : ARM se pose comme le futur concurrent d'Intel

D'ici à 2015, ARM pourrait capter 15% du marché du processeur pour PC selon IDC. La société britannique, qui vend sous licence ses designs d'architecture à des fabricants de puces, est actuellement quasiment absente du marché des processeurs pour PC, dominé par Intel et AMD mais les choses pourraient évoluer très vite avec l'arrivée de Windows 8 pour ARM. « ARM pourrait récupérer des parts de marché au moment où les consommateurs considèreront les options offertes par Windows 8, puisque le futur OS de Microsoft tournera sur les processeurs basse énergie de ARM, » a déclaré Shane Rau, directeur de recherche dans le domaine des semi-conducteurs pour le cabinet d'études IDC. Mais pas de version de Windows 8 Server pour ARM, Microsoft ne pousse pas ce marché qui risque de rester la chasse gardée de Linux. Pour s'imposer, les puces ARM pour serveur doivent se doter de fonctions indispensables sur ce marché comme l'adressage sur 64 bits pour étendre les capacités en mémoire et la correction d'erreurs. HP exploite déjà cette piste avec des serveurs reposant sur des puces ARM Calxeda en cours de tests chez certains clients. Reste que l'écosystème logiciel est encore à bâtir.

ARM toujours avec l'annonce des premières puces quatre coeurs pour smartphones et tablettes chez Nvidia et Qualcomm même si certains analystes restent circonspects quant à la réelle utilité de ces processeurs sur les terminaux mobiles. Les processeurs quad-core x86 sont par exemple utilisés dans moins de 10% des PC commercialisés, et le marché des tablettes pourrait connaître le même taux d'adoption, indique Dean McCarron, analyste chez Mercury Research. Terminons avec un segment où on n'attendait pas vraiment les puces ARM : les supercalculateurs. Le Centro nacional de Supercomputación (CNS) espagnol, également connu sous le nom de Barcelona Supercomputing Center (BSC), a construit un prototype de supercalculateur reposant sur des processeurs ARM quad-core. Il s'agit de vérifier l'efficacité énergétique d'un tel système haute performance.

Oracle perturbe la plate-forme Itanium

Sur le marché x86, Intel et AMD ont lancé des processeurs combinant CPU et GPU. Cette union dans une seule pièce de silicium permet de simplifier la conception des micro-ordinateurs compacts et d'optimiser la consommation d'énergie. Plus étonnant, pour contrer ARM, Intel prépare son retour sur le marché des smartphones avec une puce x86 taillée pour ces produits : l'Atom Medfield.

Sur le segment des serveurs x86, les processeurs Intel Xeon E5 se font toujours attendre, alors qu'AMD a commercialisé son Opteron 6200 16 coeurs reposant sur l'architecture Bulldozer. Le marché Unix a été secoué par la décision d'Oracle d'arrêter ses développements sur la plate-forme Intel Itanium, principalement utilisée par HP sur ses machines Integrity. Depuis cette décision, HP et Intel tentent de convaincre leurs clients que l'apport d'Oracle n'est pas si indispensable et que d'autres solutions se profilent. Enfin, le marché Unix a été marqué par le renouveau des puces Sparc, désormais dans le giron d'Oracle, pour équiper les appliances de l'éditeur. Un superserveur a même été annoncé sur base Sparc T4.

(...)(26/12/2011 17:30:39)

Le Cedars Sinai Hospital à Los Angeles intègre l'IBM Watson à son équipe de médecins

IBM et WellPoint, le plus grand programme de santé du Blue Cross Blue Shield, ont mis au point des applications qui vont transformer le supercalculateur Watson en conseiller spécialisé, au service des oncologues du département Samuel Oschin Comprehensive Cancer Institute de l'hôpital Cedars-Sinai de Los Angeles, comme l'a indiqué Steve Gold, directeur du marketing mondial d'IBM Watson Solutions.

La base de données que possède déjà le Cedars-Sinai sur le cancer, mais aussi les dossiers cliniques de patients en cours de traitement, vont être versés dans la mémoire d'une déclinaison du supercalculateur Watson d'IBM, qui sera installée au siège de WellPoint. L'ordinateur va servir de référentiel en matière de données médicales sur de multiples types de cancer. WellPoint travaillera ensuite avec les médecins du Cedars-Sinai Hospital pour concevoir et développer des applications, et valider leurs capacités. Le Dr M. William Audeh, directeur médical de l'institut de recherche pour le cancer, travaillera en étroite collaboration avec des experts cliniciens de WellPoint pour fournir des conseils sur la meilleure façon dont Watson peut être utilisé dans la pratique médicale et apporter une meilleure compréhension des connaissances acquises sur le cancer, y compris sur des thérapies alternatives moins bien connues des médecins. IBM avait fait savoir plus tôt cette année que la santé serait la première application commerciale de l'ordinateur qui avait réussi à battre les deux champions « humains » du jeu Jeopardy au mois de février.

Cet automne, WellPoint s'est associé avec IBM pour développer des applications pour le supercalculateur Watson, destinées à améliorer les soins aux patients en mettant à profit des pratiques médicales qui ont pu faire leur preuve. L'idée est aussi de normaliser les traitements aux patients après avoir identifié les meilleures pratiques. Un exemple de cette médecine fondée sur la pratique, c'est quand un professionnel de santé met systématiquement un patient qui a subi une crise cardiaque sous aspirine au moment de sa sortie de l'hôpital. Cedars-Sinai est la première émanation de ce partenariat. « Là où Watson se montre vraiment utile dans ce contexte, c'est sur la richesse des informations qu'il est capable de traiter, informations en constante évolution, qui lui parviennent sous différentes formes, structurées et non structurées, depuis des systèmes eux-mêmes disparates », a expliqué Steve Gold. « Le secteur de la santé est particulièrement bien adapté pour tirer profit de cette compétence. »

[[page]]

Le supercalculateur Watson, vainqueur des champions du Jeopardy, était constitué de 90 serveurs Power Express 750 IBM intégrant des processeurs 8 coeurs - quatre dans chaque machine - avec un total de 32 processeurs par machine. Les serveurs ont été virtualisés en utilisant une machine virtuelle libre sur noyau Linux (KVM), de manière à créer un cluster de serveurs ayant une capacité de calcul de 80 téraflops (un téraflop = 10 puissance 12 opérations en virgule flottante par seconde). La déclinaison de Watson qui sera utilisée par le Cedars-Sinai Hospital est beaucoup plus petite, a confirmé le directeur du marketing mondial d'IBM Watson Solutions (le supercalculateur sera hébergé par WellPoint et accessible à distance via un réseau étendu). « Le Watson qui a concouru pour le Jeopardy avait une configuration bien précise. Il disposait notamment d'une application en mémoire lui permettant de répondre à une question en trois secondes », a déclaré Steve Gold. « Il abritait 2 880 coeurs et 15 téraoctets de mémoire. La plupart des situations ne nécessitent pas un tel temps de réponse. Si la réponse parvient au médecin en 6 à 10 secondes, c'est suffisant... D'autant que la qualité de la réponse et ses implications sont plus importantes que le délai nécessaire pour l'obtenir. »

Le modèle Watson qui sera utilisé par le Cedars-Sinaï Hospital sera donc beaucoup plus petit, mais il aura la même capacité d'analyse de données provenant de systèmes disparates, données à la fois structurées et non structurées. IBM a notamment travaillé avec l'éditeur Nuances Communications, dont le logiciel effectue de la reconnaissance vocale et de l'imagerie. Avec ce logiciel, le supercalculateur peut aider les professionnels de santé à déterminer le meilleur traitement possible en fonction d'une maladie spécifique, après avoir examiné des gigaoctets ou des téraoctets d'informations médicales sur les patients. Ainsi, la technologie d'analyse de Watson, associée au système de reconnaissance vocale et de compréhension du langage médical de Nuance, pourrait aider un médecin à prendre en compte l'ensemble des textes relatifs à la maladie de tel patient, les matériaux de référence, les cas cliniques connus, les dernières connaissances médicales publiées sur le sujet dans des revues et dans la littérature médicale. L'analyse pourrait aider les médecins à effectuer rapidement un diagnostic et à déterminer le traitement le plus approprié.

« Watson sera probablement un bon assistant pour aider les médecins à prescrire les traitements qui auront les meilleurs résultats », a fait valoir Steve Gold d'IBM. « Par exemple, pour un patient atteint d'un cancer, son traitement doit être en général modifié dans un cas sur deux entre la première et la seconde prescription, selon la manière dont il réagit au premier traitement », explique Steve Gold. Watson pourrait permettre de mieux prescrire le traitement initial en comparant les données du patient à toutes les informations se rapportant à la maladie. « L'objectif est d'aider les médecins à choisir le traitement le mieux adapté, en s'appuyant sur une pratique médicale actualisée, dont il peut avoir connaissance en quelques secondes », a t-il déclaré.

La Russie construit un supercalculateur de 10 pétaflops

T-Platforms, une entreprise technologique moscovite, qui a déjà construit certains des plus grands systèmes informatiques en usage dans le pays, a annoncé qu'elle développait un supercalculateur 10 pétaflops pour le compte de l'Université d'État MV Lomonosov de Moscou. Ce projet vient rejoindre la liste des supercalculateurs les plus importants en cours de développement dans les pays les plus impliqués dans ces technologies. Il marque aussi l'intention de la Russie de devenir un acteur majeur dans la course à l'Exascale. Le pays doit rattraper son retard pour se placer dans un peloton de plus en plus rapide dans lequel on trouve actuellement la Chine, le Japon, les États-Unis et l'Europe. L'enjeu : être, dans la décennie, le premier pays à réaliser un supercalculateur Exascale, c'est à dire un système ayant une puissance de calcul de mille pétaflops (un petaflop correspond à 10 puissance 15 opérations en virgule flottante par seconde).

La mise au point d'un système Exascale nécessite de nouvelles approches en matière de microprocesseurs, d'interconnexions, de mémoire et de stockage. Si des avancées se produisent en dehors des États-Unis, on pourrait voir apparaitre des entreprises technologiques capables de rivaliser avec les entreprises américaines, aujourd'hui dominantes dans ce secteur. La Russie « s'est engagée à disposer de capacités de calcul Exascale d'ici 2018-2020, et le pays est prêt à y consacrer les investissements nécessaires pour y parvenir », a déclaré Mike Bernhardt, auteur de l'Exascale Report, qui a répondu à un questionnaire de Computerworld. « Nous aurons plus de détails sur les dispositions que prendra la Russie pour mener son projet Exascale dans le courant de l'année prochaine », a t-il ajouté.

Un système de 1,3 pétaflop pour l'Université Lomonossov

L'entreprise T-Platforms, qui se positionne comme le leader du HPC en Russie, s'est également constituée un portefeuille de clients à l'étranger, en Europe notamment. Elle a déjà construit un système de 1,3 pétaflop pour l'Université Lomonossov. Le futur système que l'entreprise doit livrer à l'université moscovite sera refroidi à l'eau et devrait être opérationnel d'ici la fin de 2013. « Il intègrera des puces Intel et Nvidia, et peut-être même des puces MIC d'Intel, si elles sont disponibles en 2012 au moment de la phase de conception », a indiqué T-Platforms.

La position de la Russie en matière de supercomputing est assez proche de celle de l'Europe. Russes et Européens aimeraient être moins dépendants des technologies américaines pour construire des systèmes haute performance. « A ce stade, tout le monde s'accorde pour dire qu'il n'y pas une entreprise dans le monde qui pourrait prétendre maîtriser cette technologie et affirmer qu'elle sait comment ou avec quels composants construire une machine Exascale », a déclaré Mike Bernhardt. « Ces systèmes seront hybrides, hétérogènes et uniques. Il reste encore trop d'inconnues, de même qu'il y a beaucoup de recherches en cours explorant différentes pistes, pour prédire quelle solution sera la bonne. La Russie pourrait très bien mettre au point sa propre technologie qui dépendra peu, voire pas du tout, des technologies extérieures », a déclaré l'auteur du rapport.

[[page]]

A l'heure actuelle, le monde dépend de l'américain IBM, dont la technologie équipe près de 45% des plus grands systèmes mondiaux figurant sur la liste du Top 500 des supercalculateurs. Hewlett-Packard compte pour 28% et Cray pour 5,4%. L'Europe explore déjà des technologies alternatives. Elle étudie notamment la possibilité d'utiliser des processeurs ARM construits par l'entreprise anglo-saxonne ARM Holdings. « Le calcul Exascale est un défi scientifique, mais c'est aussi une opportunité pour l'Europe de devenir leader dans le calcul haute performance », a déclaré Leonardo Flores Añover, membre de la Commission européenne en charge de l'initiative européenne Exascale, par courriel à Computerworld.

« Cet objectif ne peut être atteint que s'il y a une vraie politique européenne impliquant les États membres de l'UE. La volonté de l'UE est de soutenir l'excellence de l'offre européenne et de promouvoir l'utilisation du HPC dans tous les domaines qui sont stratégiques pour l'Europe (dans l'industrie, le secteur scientifique et la société en général) », a déclaré Leonardo Flores Añover. « En particulier du côté de l'offre, l'objectif est de favoriser le développement d'une capacité industrielle européenne », a t-il ajouté. A l'image de la Chine, qui a développé ses propres processeurs et ses propres systèmes d'interconnexions, qu'elle utilise désormais dans certains de ses systèmes HPC.

Les États-Unis déploient de multiples efforts pour développer une architecture et des technologies pour les plateformes Exascale. Mais le financement d'un projet étalé sur plusieurs années, qui coûtera vraisemblablement plusieurs milliards de dollars, est pour l'instant en attente de la décision du Congrès - annoncée pour le 10 février prochain. Celui-ci doit statuer sur le rapport soumis par le Département américain à l'Énergie (DOE) dans lequel il expose l'importance d'une initiative Exascale aux États-Unis, les avancées internationales dans ce domaine, et le coût pour y parvenir.

Dossier : les 10 tendances et innovations technologiques 2012

Notre rédaction a dressé une liste des 10 tendances et innovations technologiques qui devraient s'affirmer ou se confirmer l'année prochaine. Sans surprise, la mobilité, le cloud et les réseaux sociaux seront encore les trois axes à profiter le plus des innovations technologiques. Dans la mobilité, une bataille sur les architectures va s'engager pour contrer ARM, on peut dire la même chose pour les systèmes d'exploitation avec l'arrivée de Windows 8 sur les tablettes ou encore la virtualisation qui s'embarque dans les terminaux. Concernant le cloud, il y a toujours des défis à relever en terme d'outils d'administration, d'interopérabilité et des datacenters vieillissants à rénover...

Quant aux réseaux sociaux publics, ils s'ouvrent aux entreprises via des API, un bon moyen pour monétiser la mine d'informations qu'ils renferment. Enfin, 2012 sera aussi l'année où l'on assistera à une montée en charge des outils analytiques et décisionnels en temps réel, à une sécurité accrue pour combattre les menaces persistances, à une multiplication des outils à commande vocale et...peut-être à la commercialisation des nouvelles mémoires intelligentes.

Medi-Partenaires héberge les données santé de ses clients dans un double cloud

Medi-Partenaires est un groupe de 31 établissements de santé réunissant 3 600 lits et places. Il réalise un chiffre d'affaires annuel de 500 millions d'euros grâce à ses 5000 collaborateurs dont 2100 praticiens. Il comporte 24 cliniques exerçant une activité de médecine/chirurgie/obstétrique, 2 centres de dialyse et 5 centres d'imagerie. Dans le cadre de la mise en place d'une informatique liée à la production de soins, le groupe a externalisé l'hébergement de celle-ci à Cheops Technology en utilisant son offre de cloud privé iCod.

« Les évolutions réglementaires et nos engagements dans le cadre du programme Hôpital 2012 nous imposait de mettre en route notre projet comme fixé avec nos tutelles » indique Sylvie Coiffard, DOSI du GIE regroupant les fonctions support (Ressources Humaines, Finance, Informatique, Juridique) de l'ensemble des établissements. Or plusieurs contraintes étaient à prendre en compte.

Fortes obligations de fiabilité et de sécurité

Le principe du projet était de disposer d'un hébergement fiabilisé et sécurisé pour un dossier patient employant les mêmes technologies pour toutes les cliniques. Le groupe passait en effet d'une informatique administrative à une véritable informatique liée à la production de soins. Or si la première peut supporter quelques heures de coupure, la deuxième doit fonctionner en permanence, 24 heures sur 24, 7 jours sur 7.

« Le groupe n'a pas vocation à réaliser des salles informatiques sécurisées avec un PCA et un PRA exigeant, que ce soit dans chaque clinique ou en centralisé » observe Sylvie Coiffard. La DSI du groupe ne comporte en effet qu'un informaticien par établissement et trois au niveau du GIE.

La grande difficulté liée à une centralisation était d'obtenir un statut d'hébergeur de données de santé. Sylvie Coiffard explique : « lorsqu'une clinique héberge ses propres données, elle n'a pas besoin d'agrément mais dès lors qu'un établissement héberge des données de plusieurs structures de soins, la demande d'agrément est obligatoire. Le simple remplissage du dossier nous aurait demandé un mois de travail. » Dès lors, l'externalisation et la centralisation s'imposait.

Un double cloud privé

Après un appel d'offres, Cheops Technology a été choisi avec son offre iCod. « Dans un poste précédent, j'en avais eu une très bonne expérience, j'avais apprécié leur sérieux, et puis, en l'occurrence, ils étaient moins chers » confie Sylvie Coiffard. Elle ajoute : « l'aspect Green-IT de l'offre iCod a été également appréciée par notre direction de la qualité car il est conforme à l'éthique du groupe. » Le contrat a été conclu pour une période de trois ans. Son coût n'a pas été communiqué, en dehors du modèle de location classique du cloud « pay as you go ».

L'architecture choisie est celle d'un double cloud privé avec réplication et répartition de charge, les points du réseau étant reliés par MPLS avec HSRP pour accroître sa disponibilité.

[[page]]

Le dossier patient mis en oeuvre utilise l'application eMed de CS3i (sauf pour encore trois cliniques en cours de migration). Chaque clinique possède sa propre instance du produit avec une base de données dédiée. Cette architecture, qui a été définie avec l'éditeur du logiciel pour éviter tout incident, a été mise en oeuvre par Cheops Technology. Elle permet une adaptation facile à la croissance attendue du groupe qui a vocation à acquérir ou ouvrir d'autres établissements : il suffit de rajouter des instances.

Un périmètre qui devrait s'accroître

Le projet devrait également s'étendre avec une augmentation de son périmètre fonctionnel. En effet, le groupe utilise un produit vieillissant pour son informatique administrative, Santé 400, qui était commercialisé par Siemens Healthcare Solutions mais a été repris par WebSanté durant l'été 2011. Une réflexion est en cours pour son remplacement avec une échéance dans les cinq ans.

La plupart des produits du marché, dont celui proposé aujourd'hui par WebSanté, dispose d'un coeur accueil-facturation-PMSI-planification d'activité qui se connecte à une comptabilité et une paie tierces. Il est probable que ce nouveau système d'information administratif sera lui aussi hébergé à l'extérieur.

(...)

Dassault Systèmes quitte le projet de cloud français Andromède

La création d'un cloud souverain français, baptisé Andromède, subit quelques turbulences. Le quotidien économique, La Tribune, a indiqué que Dassault Systèmes a décidé de se retirer du consortium en charge de la construction de ce cloud made in France. Un protocole d'accord entre la Caisse des Dépôts, et des partenaires privés FranceTelecom/Orange, Thalès et Dassault Systèmes avait été signé en août dernier. A l'époque, Cap Gemini s'était retiré du projet. Les causes du retrait de Dassault Systèmes porteraient selon le journal économique sur la durée d'une clause de non-concurrence que Dassault Systèmes souhaitait la plus longue possible. Orange préférait raccourcir au maximum cette durée pour promouvoir ses propres offres clouds. Le nom des futurs dirigeants et les tarifs proposés par Orange sur les contrats d'hébergement des salles blanches » ont été d'autres sujets d'achoppements.

A la recherche d'un autre partenaire

Avec le retrait de Dassault Systèmes, l'Etat et les autres partenaires privés Orange et Thalès vont être obligés de chercher un nouveau partenaire pour le projet Andromède. Sur le plan budgétaire, l'Etat via la Caisse des Dépôts apporte 135 millions d'euros au titre du Grand Emprunt, Thalès contribue à hauteur de 30 millions d'euros, Orange et Dassault Systèmes devaient y consacrer 60 millions d'euros chacun. L'Etat va tenter de jouer les médiateurs pour faire changer d'avis le fournisseur de services et chercher d'autres acteurs intéressés par le projet. La Tribune parle d'Atos ou de Cap Gemini. A suivre...

| < Les 10 documents précédents | Les 10 documents suivants > |