C’est une fin plutôt rapide pour Classifier, l’outil d’IA pour détecter les travaux écrits par l’IA et développé par OpenAI. Il faut dire que la solution n’a pas franchement eu l’effet escompté lors de son lancement. Lorsqu’OpenAI a lancé Classifier en janvier, il était censé être suffisamment performant pour détecter si un utilisateur (par exemple, un étudiant) avait utilisé ChatGPT ou un autre programme d'IA pour rédiger un article. OpenAI a présenté Classifier comme un moyen pour un enseignant d'identifier si une dissertation, par exemple, avait été rédigée par l’IA au lieu d'être un travail original. Mais l’outil a connu des difficultés lorsque nous l’avons testé, notamment en identifiant des œuvres célèbres comme étant générées par une IA.

Au lieu de résoudre les problèmes, OpenAI a donc fait le choix de le fermer. La page dirigeant vers Classifier est vide, et OpenAI a ajouté ceci à l'annonce originale de l'outil Classifier : « À partir du 20 juillet 2023, le classificateur d'IA n'est plus disponible en raison de son faible taux de précision. Nous nous efforçons d'intégrer les commentaires et recherchons actuellement des techniques de provenance plus efficaces pour le texte, et nous nous sommes engagés à développer et à déployer des mécanismes permettant aux utilisateurs de comprendre si le contenu audio ou visuel est généré par l'IA ».

Un taux d’erreur trop élevé

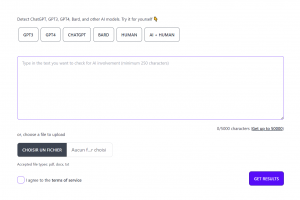

Au moment du lancement de Classifier, OpenAI a déclaré que le service avait identifié 26 % des textes rédigés par l'IA comme étant authentiquement humains, et qu'il avait considéré 9 % des textes rédigés par un humain comme étant rédigés par l'IA. A contrario, un service concurrent, Hive Moderation, semblait mieux fonctionner. Il s'agit d'un outil gratuit de détection de l'IA qui remplit la même fonction, mais qui renvoie un pourcentage de confiance, c'est-à-dire la probabilité que l'échantillon de texte contienne du texte d'IA.

Les étudiants se sont plaints bruyamment en ligne du fait que même lorsqu'ils rédigent des essais originaux, des applications défectueuses de détection de l'IA peuvent les faire échouer. Les chartes informatiques des universités et des lycées n'autorisant qu'une faible marge de manœuvre en matière de plagiat, un seul faux positif peut compromettre la carrière universitaire d'un étudiant. Il est possible que la disparition de Classifier serve de prétexte pour reconsidérer la manière dont les établissements d'enseignement traitent ce problème.