Intel a présenté une version de son logiciel d'accélération du cache SSD (Cache Acceleration Software - CAS) pour les serveurs Linux, qui, selon l'entreprise permet d'améliorer jusqu'à 18 fois les performances des applications qui sollicitent les disques de manière intensive, telles que les systèmes transactionnels. De plus, cette solution prend désormais en charge la mise en cache de mémoire flash NAND (SSD et cartes PCIe) dans les baies de stockage. Elle supporte également vMotion de VMware, ce qui permet aux machines virtuelles de migrer entre les systèmes tout en conservant les données les plus utilisées sur du cache, quelle que soit la machine hôte.

« L'avantage ne consiste pas qu'à fournir une meilleure performance, mais à s'assurer que, quoiqu'il arrive, celle-ci restera cohérente », a déclaré Andrew Flint, responsable des produits CAS chez Intel. La firme de Santa Clara a acquis la technologie logicielle d'accélération du cache SSD en septembre, suite au rachat de la start-up canadienne Nevex. Celle-ci a cédé son logiciel sous la marque CacheWorks, mais Intel l'a rapidement rebaptisé CAS

L'utilisation d'un logiciel d'accélération et de gestion du cache pour la mémoire flash NAND est un marché très prometteur. Plus d'une douzaine de fournisseurs commercialisent ce type de produits et les acquisitions sont légion. Début 2012, SanDisk a acquis FlashSoft pour son logiciel dédié à cette technologie. Puis ce fut au tour de Samsung de racheter Nvelo pour son logiciel de mise en cache SSD, Dataplex. La solution identifie les données qui subissent des niveaux élevés de lecture et les déplace dans la mémoire flash NAND sous forme de SSD pour accroître la performance.

Redistribuer les données à forte intensité

Intel a annoncé le support de son logiciel d'accélération du cache pour les systèmes Windows en décembre. Le support le plus récent, pour Linux, donne également aux administrateurs la possibilité de sélectionner des applications qui bénéficieront des SSD les plus performants ou permettront au logiciel d'accélération du cache de redistribuer automatiquement les données à forte intensité en entrée/sortie vers la mémoire flash. Intel a indiqué que son outil était en mesure de cibler les données les plus utilisées sur des baies de stockage, comme un SAN, pour les systèmes sous Windows et Linux, et autoriser la migration d'une machine virtuelle tout en maintenant une haute performance en I/O, avec du cache flash.

« Nous avons abordé le problème du goulot d'étranglement en entrée/sortie en nous plaçant du côté de l'accélération des applications », a précisé Andrew Flint. « Nous possédons la technologie pour adresser de la performance aux applications », a-t-il ajouté. « C'est parce que nous procédons ainsi, que la plupart de nos ventes visent les administrateurs de bases de données et d'applications dans les entreprises. »

[[page]]

Le responsable a également indiqué qu'il n'était pas nécessaire de rearchitecturer ou de configurer les applications. « Vous n'avez pas besoin de faire quoi que ce soit sur l'infrastructure de stockage », a-t-il insisté. « Le cache se trouve au milieu, identifie automatiquement les données les plus actives, place une copie sur un lien haut débit et les applications par extension vont plus vite. »

Triplement des performances

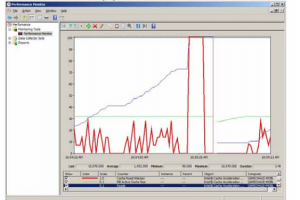

Andrew Flint a également indiqué que, sur des bases de données standard, le logiciel de mise en cache pouvait tripler les performances. « Sur des applications OLTP, qui sont lues plus intensivement, la performance peut être multipliée par 18 » a-t-il assuré.

Alors que les serveurs d'applications exécutent déjà une certaine quantité de données stockées dans la mémoire DRAM volatile, le niveau de la mise en cache est limitée entre 4 à 8 Go. Le logiciel d'accélération du cache d'Intel tire profit de la haute capacité des SSD, qui peut atteindre plus d'un To. Ces bénéfices varient sensiblement selon les systèmes et dépend du ratio des données situées en back-end par rapport aux données actives sur le serveur et si celles-ci sont en lecture ou en écriture intensive. La solution d'Intel accélère le cache en lecture. « Si votre application ne fait rien de plus que de la relecture, vous aurez les mêmes performances sur nos caches à deux niveaux que sur un cache SSD à un seul niveau, » a exposé Andrew Flint.

« D'autre part, dans les scénarios où l'on fait fonctionner des bases de données, des choses comme des index ou des tables temporaires deviennent extrêmement sollicitées pendant une période de temps, nous pouvons assurer que ces indices et tables temporaires sont dans la mémoire, et, ce faisant, nous pouvons stimuler la performance du système qui va bien au-delà de ce que l'on pourrait obtenir en transférant l'ensemble des données sur un SSD. »

Pour s'assurer qu'il ne duplique pas des tâches déjà en cours d'exécution dans la DRAM, le logiciel prend le contrôle de tous les accès aux données. Les plus utilisées sont placées sur la DRAM, tandis que les moins utilisées, mais qui produisent beaucoup d'I/O, sont sur le SSD. La solution fournit une intégration coopérative entre le cache DRAM du serveur standard et celui du SSD d'Intel, créant un cache multi-niveau qui optimise l'utilisation de la mémoire système et détermine automatiquement le meilleur niveau de cache pour les données actives.

Le fondeur a présélectionné sa solution pour une utilisation avec ses SSD SATA 3700 ou ses cartes flash 910 series PCIe.