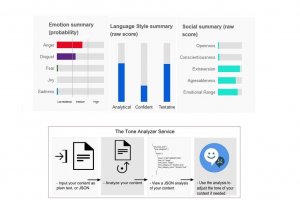

Une autre salve d’améliorations autour des API pour Watson dans le cloud a été annoncée par IBM sur sa conférence Interconnect (Las Vegas, 21-25 février). Après les quatre familles de services pour l’IoT livrés en décembre, les nouveautés sont centrées cette fois sur les capacités d’identification des émotions et de reconnaissance d’images de la plateforme cognitive développée par Big blue. Trois des API concernées sont disponibles en version bêta sur le PaaS Bluemix. La première d’entre elles, Tone Analyzer, permet d’appréhender la tonalité d’un texte et, le cas échéant, d’en corriger les défauts. « Le service utilise l’analyse linguistique pour détecter et interpréter les signaux émotionnels dans un texte », explique IBM sur son site en proposant une rapide démonstration de ce qu'il peut effectuer. Il est possible d'identifier un excès d’agressivité dans un mail ou une trop grande familiarité dans un billet de blog, donne en exemple le fournisseur.

Tone Analyzer pouvait déjà reconnaître 9 tonalités sur 3 axes : les émotions exprimées (les sentiments négatifs, l’enthousiasme, la colère), l’inclination sociale (interlocuteur ouvert, agréable, consciencieux) et le style d’écriture (analytique, confiant, hésitant). Désormais, l’API peut aussi identifier la joie, le dégoût, la peur, la tristesse, ainsi que l’extraversion. Jusqu’à présent, elle n’analysait que des mots isolés, maintenant, elle travaille sur des phrases entières. La deuxième API, Emotion Analysis, ajoute une fonction à AlchemyLanguage. Elle servira à analyser du contenu extérieur à l’entreprise pour mieux comprendre les émotions exprimées, par exemple lors d’une session de chat avec un client, ou encore pour surveiller les réactions des internautes sur les médias sociaux après la diffusion d’une information. Là aussi, les développeurs pourront maintenant aller au-delà de l’identification des simples sentiments négatifs ou positifs en décelant une gamme d’émotions allant de la joie au dégoût en passant par la peur, ce qui permettra de mieux comprendre le ressenti des clients.

80 000 personnes dans la communauté Watson Developer Cloud

IBM a également fait évoluer son API Text to Speech (TTS) destinée aux interactions vocales. En disponibilité générale sous le nom d’Expressive TTS, l’outil a gagné en expressivité avec l’intégration d’une forme d’intelligence émotionnelle. C’est le résultat de 12 années de R&D, souligne Big blue qui explique que l’ordinateur peut non seulement comprendre le langage naturel, le ton et le contexte, mais également répondre avec l’inflexion appropriée.

Enfin, une quatrième API, Visual Recognition, permet d'aller au-delà de la reconnaissance d’images habituelle. Fournie en mode bêta, elle peut être personnalisée en fonction des besoins des utilisateurs. En exemple, IBM cite une chaîne de boutiques de mode qui pourrait créer un tag spécifique pour un nouveau vêtement, par exemple la ligne de pantalons d’une collection. Watson serait alors entraîné à identifier sur les médias sociaux des photos où l’on verrait apparaître l’un de ces pantalons portés par les personnes photographiées. Ces API font partie des 30 services qui sont actuellement proposés sur l’espace Watson Developer Cloud de la plateforme Bluemix. Selon IBM, 80 000 développeurs, étudiants et entreprises utilisent ces technologies cognitives pour élaborer des prototypes et des applications cloud.