Pour offrir aux entreprises un moyen de développer et de fournir en toute sécurité des modèles d'inférence et des charges de travail basés sur l'IA, F5 a déclaré cette semaine qu'il allait travailler avec Intel. Plus précisément, les entreprises combineront les capacités de sécurité et de gestion du trafic de la suite Nginx Plus de F5 avec la boîte à outils OpenVino et les unités de traitement d'infrastructure (IPU) d'Intel. L'ensemble offrira aux clients la protection, l'évolutivité et la performance pour le développement d'inférences IA avancées, ont déclaré les fournisseurs. Nginx Plus est la suite de sécurité des applications de F5 qui comprend un équilibreur de charge logiciel, un cache de contenu, un serveur web, une passerelle API et un proxy microservices conçus pour protéger les applications web et mobiles distribuées. OpenVino est une boîte à outils open source qui accélère l'inférence de l'IA et permet aux développeurs d'utiliser des modèles d'IA formés à l'aide de cadres populaires tels que TensorFlow, PyTorch, ONNX, et d'autres. Le serveur de modèles d'apprentissage en profondeur OpenVino utilise la technologie des conteneurs Docker et peut être déployé dans un environnement en cluster pour gérer des charges d'inférence élevées et évoluer en fonction des besoins.

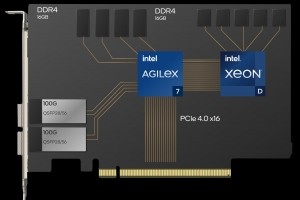

« Le serveur de modèles OpenVino prend en charge l'inférence à distance, ce qui permet aux clients d'effectuer l'inférence sur des modèles déployés sur des serveurs distants », selon Intel. « Cette fonctionnalité est utile pour les applications distribuées ou les scénarios dans lesquels l'inférence de l'IA doit être effectuée sur des serveurs puissants alors que l'appareil client a des ressources limitées. » Les IPU d'Intel sont des accélérateurs matériels qui déchargent un certain nombre de tâches telles que le traitement des paquets, la mise en forme du trafic et la commutation virtuelle de l'unité centrale du serveur. L'offre intégrée F5/Intel, qui est disponible, sera particulièrement bénéfique pour les applications de périphérie (edge), telles que l'analyse vidéo et l'IoT, où une faible latence et des performances élevées sont cruciales, a écrit Kunal Anand, directeur de la technologie chez F5, dans un blog sur la technologie.

Décharger le processeur principal avec l'IPU

« F5 Nginx Plus fonctionne comme un proxy inverse, offrant une gestion du trafic et une protection pour les serveurs de modèles d'IA », écrit M. Anand. « Avec des configurations de haute disponibilité et des contrôles de santé actifs, Nginx Plus peut s'assurer que les demandes des applications, des flux de travail ou des utilisateurs atteignent un serveur de modèle OpenVino opérationnel. » Il propose également l'utilisation de certificats HTTPS et mTLS pour crypter les communications entre l'application utilisateur et le serveur de modèle sans ralentir les performances, a ajouté M. Anand. Avec OpenVino, les développeurs convertissent d'abord les modèles et peuvent ensuite les optimiser et les compresser pour obtenir des réponses plus rapides, selon M. Anand. « Le modèle d'IA est prêt à être déployé en intégrant le moteur d'exécution OpenVino dans leur application pour la rendre compatible avec l'IA. Les développeurs peuvent déployer leur application infusée d'IA via un conteneur léger dans un centre de données, dans le nuage ou à la périphérie sur une variété d'architectures matérielles », a-t-il écrit.

Selon Intel, l'intégration d'une Intel IPU à Nginx Plus crée un vide de sécurité entre Nginx Plus et les serveurs OpenVino. Cette couche de sécurité supplémentaire protège contre les vulnérabilités potentielles partagées pour aider à protéger les données sensibles dans le modèle d'IA, ont déclaré les fournisseurs. Les IPU d'Intel sont compatibles avec le serveur Dell PowerEdge R760 équipé de processeurs Xeon. Cette association peut augmenter les performances des serveurs OpenVino et de F5 Nginx Plus, selon M. Anand. « L'exécution de Nginx Plus sur l'Intel IPU offre des performances et une évolutivité grâce aux accélérateurs matériels de l'Intel IPU », a écrit M. Anand. « Cette combinaison laisse également des ressources CPU disponibles pour les serveurs de modèles d'IA.