Malgré les difficultés rencontrées autour de son chimérique projet de métavers, la société mère de Facebook, Meta, a révélé des plans pour le développement de sa propre puce personnalisée (ASIC) pour exécuter des modèles d'intelligence artificielle et une architecture de centre de données pour les charges de travail d'IA. "Nous exécutons un plan ambitieux pour construire la prochaine génération d'infrastructure d'IA de Meta et aujourd'hui, nous partageons quelques détails sur nos progrès. Cela comprend notre première puce personnalisée pour exécuter des modèles d'IA, une nouvelle conception de centre de données optimisée pour l'IA et la deuxième phase de notre supercalculateur de 16 000 GPU pour la recherche sur l'IA », a écrit Santosh Janardhan, responsable de l'infrastructure chez Meta, dans un article de blog. Chez Meta, les charges de travail d'IA sont partout, servant de base à de nombreuses applications telles que la compréhension de contenu, les flux, l'IA générative et le classement des publicités. Grâce à son intégration Python transparente, sa son execution immédiate et ses API simples, PyTorch peut exécuter ces charges de travail. En particulier, les DLRM sont essentiels pour améliorer l'expérience utilisateur sur tous les produits et offres de Meta. Les systèmes matériels doivent fournir de plus en plus de mémoire et de calcul à mesure que la taille et la complexité de ces modèles augmentent, le tout sans consommer trop de puissance électrique.

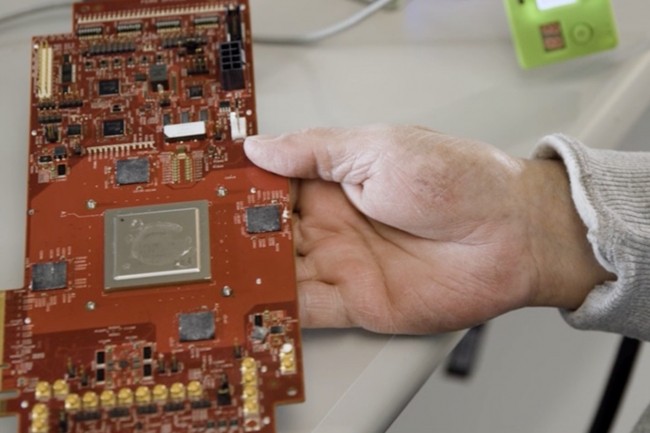

L'ASIC taillé pour l'IA de Meta est fabriqué en 7bnm dans les fonderies de TSMC. (Crédit S.L.)

Gravée en 7 nm chez TSMC, la puce ASIC de Meta pour l'exécution de modèles d'IA, appelée Meta Training and Inference Accelerator (MTIA), est conçue pour fournir une puissance de calcul et une efficacité supérieure à celles des processeurs actuellement sur le marché, selon M. Janardhan. MTIA est personnalisé pour les charges de travail internes (voir plus haut), ajoutant que la première version de la puce avait été conçue en 2020.L'annonce par Meta des progrès qu'elle fait pour produire ses propres puces ASIC pour dédiées à l'IA intervient à un moment où d'autres grandes entreprises technologiques - motivées par la prolifération de grands modèles de langage et d'IA générative - travaillent ou ont déjà lancé leusr propre puces pour ces charges de travail. Plus tôt ce mois-ci, des articles ont rapporté que Microsoft travaillait avec AMD pour développer sa propre puce pour AWS a également publié sa propre puce pour exécuter des charges de travail IA.

Des datacenters taillés pour l'IA

De son côté, Meta a également déclaré jeudi que le développement d’un datacenter optimisé pour l’entraînement des modèles d'IA, afin d'améliorer les performances à mesure que la quantité de données traitées augement. "Ce centre de données sera une conception optimisée pour l'IA, prenant en charge le matériel d'IA refroidi par liquide et un réseau d'IA haute performance connectant des milliers de puces IA ensemble dans des clusters dédiés à l’entraînement IA à l'échelle du centre de données", a écrit M. Janardhan, ajoutant que les datacenters seront plus rapides à construire et plus rentables que les installations antérieures.

En plus de la conception de centre de données dédiés à l’IA, la société a rapporté qu'elle travaillait au développement de supercalculateurs IA qui prendront en charge la production de modèles d'IA de nouvelle génération, les outils de réalité augmentée et la traduction en temps réel.

Commentaire