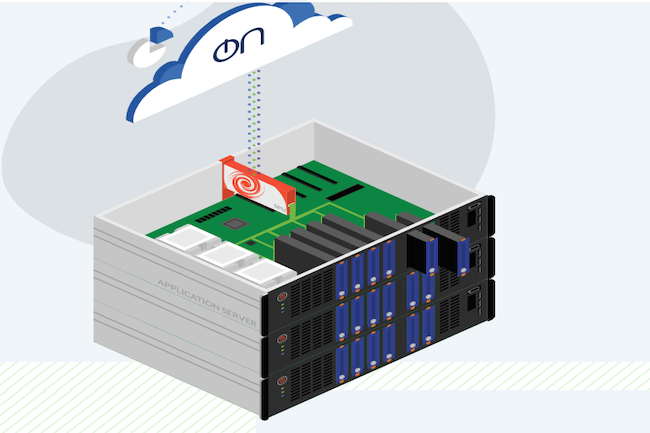

Fondée en 2018 à San Francisco à par des vétérans du stockage et notamment des anciens de 3Par (David Scott, Siamak Nazari, Craig Nunes et Sean Etaati), Nebulon mise sur le Software Defined Storage mais en mode cloud hybride. La start-up parle donc de Cloud Defined Storage, qui combine une couche de management dans le cloud (controle plane) et des cartes PCIe installées dans les serveurs de stockage des clients. Chaque serveur est donc équipé d'une carte Nebulon qui décharge le traitement du stockage et qui se connecte à d'autres cartes Nebulon dans le datacenter. Jusqu'à 32 cartes peuvent se connecter via un lien Ethernet 10 / 25 Gbps pour former un pool de stockage (un Npod) qui peut être découpé en volumes provisionnés, via le plan de contrôle cloud Nebulon ON. Ces cartes dotées d’une puce ARM 8 cœurs (3 GHz) épaulée par 32 Go de NVRAM se comportent comme des cartes RAID et hébergent leur propre OS - avec des fonctionnalités de compression et chiffrement - afin de rester indépendantes des serveurs, et travailler avec les applications critiques habituées au mode SAN ou HCI.

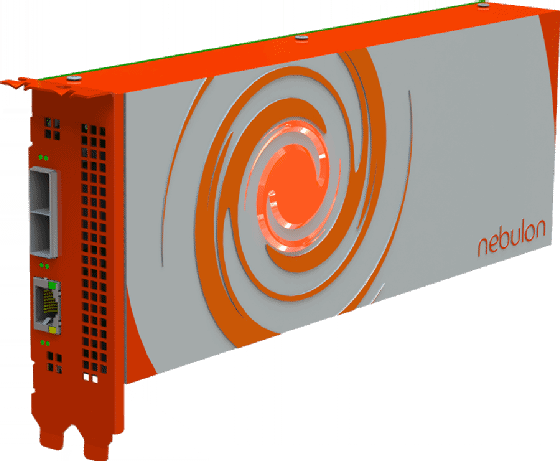

La carte PCIe assure donc les fonctionnalités d'une mini-baie de stockage dans chaque serveur ou nœud. Le stockage au sein de chaque nœud est connecté via l'AIC ou le Snippet Processing Unit (SPU), la SPU, à son tour, émulant un contrôleur de stockage local vers l'hôte. Les SPU apparaissent comme des périphériques SAS standard pour le système d'exploitation installé. Cela signifie qu'un seul cluster peut prendre en charge les installations bare-metal ou avec un hyperviseur, y compris les clusters mixtes si nécessaire. Les serveurs d'un cluster ou «NPod» sont connectés via Ethernet 10 / 25 Gbps entre les SPU, ce qui permet la mise en miroir pour la protection des données. En cas de défaillance d'un SPU, le remplaçant est simplement doté de la configuration de la carte précédente et les données sont à nouveau immédiatement accessibles. Un emplacement GPU est requis, car le SPU consomme 85 watts, légèrement plus que les 75 W standard autorisés pour un emplacement PCIe (les GPU ont des connecteurs d'alimentation supplémentaires séparés).

Analytique à venir

La solution de Nebulon est intéressante, car elle déporte le travail des contrôleurs de stockage d’une baie vers les cartes SPU, limitant ainsi les besoins en mémoire et CPU. Et comme les fonctionnalités de surveillance et de provisionnement qui sont normalement du ressort du contrôleur sont déchargées vers Nebulon ON sur le cloud, les besoins en CPU sont moins importants. Nebulon ON est l'endroit où la topologie est définie, le stockage provisionné, la télémétrie collectée et les fonctions de gestion telles que les mises à jour effectuées. Le portail cloud gère toutes les métadonnées et transmet les informations de configuration aux SPU. En utilisant les données recueillies par le SPU, la société prévoit d'activer des outils d'analyse basés sur l'IA via son panneau de contrôle Nebulon ON. En cas de perte de la connectivité au cloud, le stockage continue de fonctionner comme configuré, les SPU locaux jouant le rôle de cache du contrôleur vers lequel les paramètres de configuration auront été envoyés. Pour l'instant, Nebulon ON fonctionne dans les clouds d’AWS et GCP.

Pleine longueur, pleine hauteur et double largeur, les cartes SPU de Nebulon se connectent à l'emplacement GPU d'un serveur standard et sont conformes à la norme PCIe 3.0.

Installée dans la Silicon Valley, mais aussi à Seattle, Belfast et Londres, Nebulon emploie une cinquantaine de personnes dans le monde et compte s’appuyer sur des partenaires comme HPE ou SuperMiccro pour vendre des serveurs équipés de ses SPU.

Commentaire