Pour l'aider à créer et optimiser ses modèles IA, IBM a construit un supercalculateur baptisé Vela. Conçu par sa division AI Research et opérationnel depuis mai 2022, ce dernier est déjà utilisé en production par des dizaines de chercheurs d'IBM pour entrainer des modèles IA avec plusieurs dizaines de millions de paramètres. Tout dernièrement, le fournisseur a fourni des détails sur son fonctionnement et ses ambitions dans le domaine. Avec lui, Big Blue veut faciliter le travail de ses équipes de recherche (ingénieurs, datascientsts...) pour mieux appréhender les performances et le comportement de ses modèles fondamentaux et changer la façon dont l'IA et l'apprentissage automatique peuvent être utilisés. « Nous pensons vraiment que ce concept technologique autour des modèles de base a un énorme potentiel de différenciation », a expliqué à notre confrère de Venture Beat Talia Gershon, directrice de la recherche sur l'infrastructure cloud hybride chez IBM.

Les modèles dits « de fondation » sont des modèles IA qui ont été formés sur un large ensemble de données non étiquetées. Leur nature générique signifie qu'ils peuvent être utilisés pour une gamme de tâches différentes avec un minimum de réglages, mais ils sont volumineux et nécessitent une puissance de calcul importante et coûteuse. « Nous nous sommes demandé : comment pouvons-nous fournir des performances bare-metal à l'intérieur d'une machine virtuelle ? Après une quantité importante de recherches et de découvertes, nous avons conçu un moyen d'exposer toutes les capacités d'un noeud (GPU, CPU, réseau et stockage) dans une machine virtuelle afin que la surcharge de virtualisation soit inférieure à 5 %, ce qui est le niveau le plus bas atteint dans l'industrie que nous connaissons », a par ailleurs expliqué IBM.

Un système de planification de workloads maison

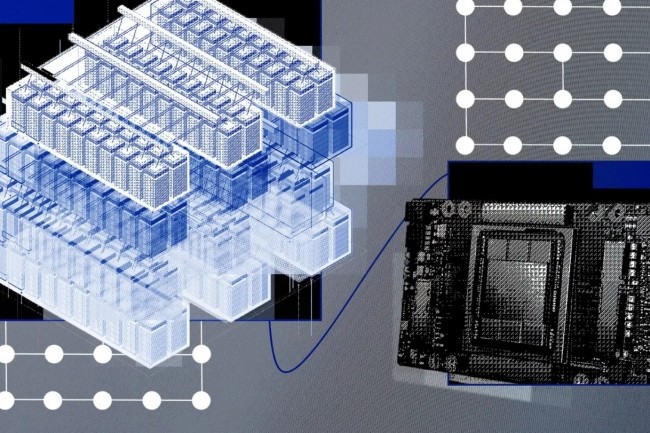

Le supercalculateur d'IBM se différencie d'autres systèmes HPC plus traditionnels. A commencer par son célèbre cousin Summit conçu pour le Laboratoire national d'Oak Ridge dans le Tennessee. Chaque nœud Vela dispose ainsi de deux processeurs Intel Xeon Cascade Lake, de 1,5 To de DRAM et de quatre lecteurs NVMe de 3,2 To. Chaque noeud de ce datacenter - composé de 60 racks - s'appuie sur 8 accélérateurs GPU Nvidia A100 embarquant chacun 80 Go de mémoire large bande (HMB). Les noeuds sont connectés entre eux via la technologie GPU NVLink, ainsi que NVSwitch pour connecter plusieurs liaisons NVLink.

La pile logicielle, qui sous-tend la formation du modèle de fondation, utilise quant à elle une kyrielle de technologies open source incluant aussi bien Kubernetes, PyTorch (formation ML) que Ray (évolution des workloads). IBM a par ailleurs aussi mis au point un système de planification de la charge de travail spécifique, MCAD (distributeur d'applications multicluster), pour gérer l'ordonnance des tâches cloud natives pour la formation à l'IA du modèle de base. Vela bénéficie d'une intégration native à l'environnement VPC d'IBM Cloud dont les workloads IA s'appuieront sur une batterie de 200 services associés.

« Disposer des outils et de l'infrastructure appropriés est un ingrédient essentiel pour la productivité de la R&D », ont expliqué les ingénieurs d'IBM. « De nombreuses équipes choisissent de suivre la voie éprouvée de la construction de supercalculateurs traditionnels pour l'IA [...] nous avons travaillé sur une meilleure solution qui offre le double avantage d'un calcul haute performance et d'une productivité utilisateur haut de gamme ».

Commentaire