IBM propose un accès élargi aux GPU Nvidia sur son Cloud pour aider les entreprises à avancer dans leurs implémentations d'IA, y compris la formation de grands modèles de langage (LLM). Les utilisateurs d'IBM Cloud peuvent dorénavant accéder aux instances GPU Nvidia H100 Tensor Core dans des environnements de cloud privé virtuel et Red Hat OpenShift gérés. L'ajout des instances GPU H100 Tensor Core vient compléter une famille de GPU et de logiciels Nvidia déjà pris en charge par big blue. « Le GPU Nvidia H100 Tensor Core peut délivrer des performances d'inférence jusqu'à 30 fois plus rapides que l'actuel A100 Tensor Core et fournira aux clients d'IBM Cloud des capacités de traitement en offrant plus de contrôle sur le coût du réglage et de l'inférence de l'IA à l'échelle de l'entreprise », a écrit Rohit Badlaney, directeur général d'IBM Cloud Product and Industry Platforms dans un billet de blog consacré à l’annonce. https://newsroom.ibm.com/blog-ibm-brings-enhanced-performance-and-efficiency-for-ai-and-hpc-with-nvidia-accelerated-computing

« Les entreprises peuvent commencer par former des modèles à petite échelle, en affinant les modèles ou en déployant des applications comme des chatbots, la recherche en langage naturel et en utilisant des outils de prévision à l'aide des GPU Nvidia L40S et L4 Tensor Core », a poursuivi M. Badlaney. « À mesure que leurs besoins augmentent, les clients d'IBM Cloud pourront ajuster leurs dépenses en conséquence, pour finalement exploiter le H100 pour les cas d’usage les plus exigeants en matière d'IA et de calcul haute performance. »

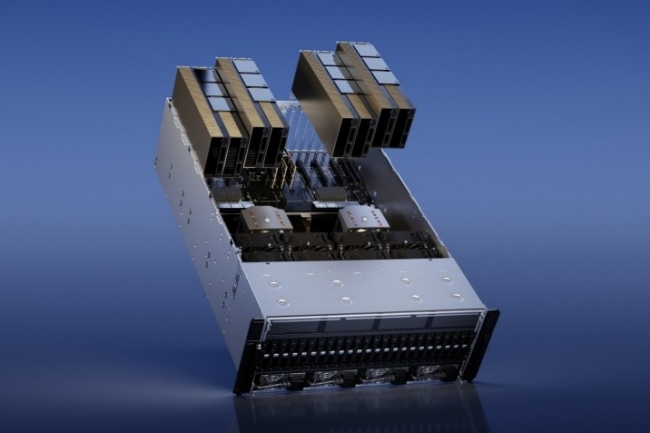

NVLink et NVSwitch supportés par IBM Cloud

IBM Cloud dispose d'un réseau solide, entièrement basé sur Ethernet, pour gérer le surcroît de charges de travail. « Pour le déploiement de plusieurs systèmes H100 dans un cluster, nous construisons des hubs de traitement avancé à Washington et à Francfort, pour que les clients puissent connecter de nombreux systèmes par le biais d'une configuration RoCE/RDMA qui autorise jusqu'à 3,2 Tbps pour la communication GPU-GPU », a précisé le fournisseur. « Pour le déploiement d'un seul serveur, les GPU sont connectés à l'aide de NVLink de Nvidia qui fournit une connexion point à point directe et à grande vitesse entre les GPU et NVSwitch, la structure de commutation à grande vitesse de Nvidia qui connecte plusieurs GPU. L'ensemble de ces technologies constitue une configuration Nvidia DGX clé en main de GPU Nvidia A100 ou H100 Tensor Core. »

Selon Rohit Badlaney, les services IBM Cloud incluent divers protocoles de sécurité à plusieurs niveaux pour protéger les processus d'IA et HPC et prévenir contre les fuites de données et les problèmes de confidentialité des données. « Ces services comprennent également des contrôles intégrés qui servent de garde-fous à l'infrastructure et aux données pour les charges de travail d'IA », a-t-il expliqué. IBM Cloud comprend par ailleurs des capacités d'automatisation du déploiement. « IBM Cloud automatise le déploiement des applications alimentées par l'IA pour réduire le temps et les erreurs qui pourraient survenir lors d'une configuration manuelle », a fait valoir M. Badlaney. « Il fournit également des services essentiels, notamment des solutions de gestion du cycle de vie de l'IA, une plateforme sans serveur, du stockage, de la sécurité et des solutions pour aider les clients à surveiller leur conformité. » Les clients peuvent aussi utiliser le studio d'IA Watsonx d'IBM, le data lakehouse et la boîte à outils de gouvernance pour un développement plus intensif de l'IA », a indiqué M. Badlaney.

IBM Cloud et Nvidia

Le déploiement du H100 n'est que le dernier des nombreux partenariats technologiques conclus entre IBM Cloud et Nvidia, qui a des accords partenariats avec un certain nombre de fournisseurs de cloud. Par exemple, au début de l'année, big blue a déclaré qu’il était parmi les premiers à accéder aux microservices d'IA générative de Nvidia que les clients et les développeurs peuvent utiliser pour créer et déployer des applications personnalisées optimisées pour ses accélérateurs. De plus, IBM propose les puces Nvidia L40S et Nvidia L4 Tensor Core, ainsi que la prise en charge de Red Hat Enterprise Linux AI et OpenShift AI pour aider les entreprises à développer et à exécuter les charges d'IA. IBM a aussi intégré les accélérateurs Nvidia dans sa plateforme Watson AI pour accélérer diverses charges de travail d'IA, notamment l'apprentissage profond, le traitement du langage naturel et la vision par ordinateur.

Commentaire