Pas un jour ne passe sans que l'actualité ne soit parsemée d'annonces autour des LLM. Mais aussi des SLM, des modèles de langage qui se différencient des premiers par leurs tailles plus modestes. Juste après Microsoft qui a levé le voile sur Phi-3 Mini capable de tourner sur des smartphones (et Orca-Math en mars) c'est au tour d'Apple de sortir du bois sur ce créneau en lançant OpenELM. Ce n'est pas la première fois que la firme à la pomme s'intéresse au sujet des modèles de langage : en décembre dernier il avait poussé, en partenariat avec l'université de Cornell, un LLM également open source baptisé Ferret mais disponible seulement dans un cadre de recherche. Alors que ce dernier pouvait grimper jusqu'à 13 milliards de paramètres, OpenELM ne joue cependant pas dans la même cour avec 4 versions plus petites : 270 M, 450 M, 1,08 B et 3,04 B.

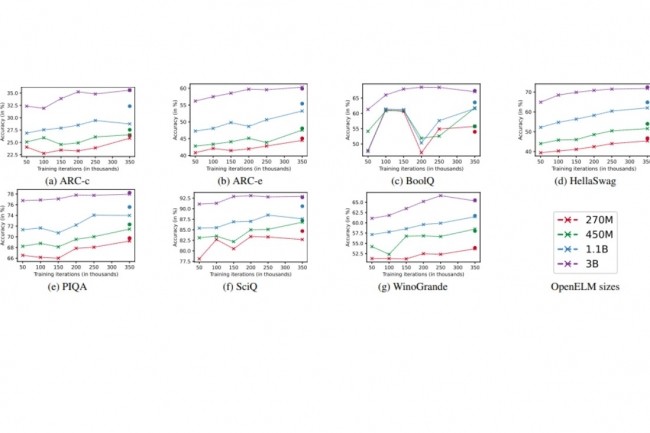

"OpenELM utilise une stratégie de mise à l'échelle par couche (layer-wise scaling) pour allouer efficacement les paramètres au sein de chaque couche du modèle de transformeur ce qui permet d'améliorer la précision", explique Apple dans un papier de recherche. Pour illustrer son propos, le groupe avance par exemple qu'OpenELM 1.1 B présente une amélioration de 2,36 % de la précision par rapport à OLMo, tout en nécessitant deux fois moins de paramètres par rapport à ce dernier tout en requérant 2× moins de tokens de pré-entraînement. OLMo a été mis au point par l'Ai2, organisme à but non lucratif créé en 2014 par un certain Paul Allen, co-fondateur de Microsoft avec Bill Gates. Ce n'est pas le seul modèle avec lequel Apple compare OpenELM, puisque l'on trouve également dans son benchmark OPT (Meta AI), MobiLlama et TinyLlama (dérivés open source de Llama de Meta), Pythia (EleutherAI), OpenLM (Apache LangChain) et Cerebras-GPT (Cerebras).

Du travail pour améliorer la rapidité d'exécution

La performance de ce modèle par rapport à son concurrent semble toutefois avoir pour l'heure un revers : "Malgré une plus grande précision d'OpenELM pour un nombre de paramètres similaires, nous observons qu'il est plus lent qu'OLMo", fait savoir Apple. Bien que l'objectif principal de l'étude de la firme américaine s'intéresse davantage à la reproductibilité plutôt qu'à la performance de l'inférence, une analyse a été faite pour comprendre cette contre-performance.

Dans ses prochains travaux, Apple prévoit ainsi "d'explorer des stratégies d'optimisation pour améliorer l'efficacité de l'inférence d'OpenELM qui passera par une meilleure implémentation de RMS Norm (Root Mean Square Layer Normalization)". Ce dernier régularise la somme des entrées d'un neurone dans une couche en fonction de la moyenne quadratique (RMS).

Commentaire