Au sein du calendrier de l’avent (du 5 au 20 décembre) OpenAI a présenté en début de semaine des éléments pour les développeurs. Ainsi, il a lancé une API pour son modèle GPT o1 doté de capacité de raisonnement. Une décision saluée par les analystes. « C’est intelligent de rester en phase avec d’autres fournisseurs, car de nombreux clients se tournent vers des applications basées sur des agents plutôt que vers des applications plus simples basées sur le chat », a estimé Jason Andersen, vice-président et analyste principal chez Moor Insights & Strategies. L’analyste a également qualifié cette décision « de défensive », AWS, Google et Microsoft ayant déjà lancé des frameworks de développement multimodèles basés sur des API, comme Bedrock et AI Foundry. « Certains de ces frameworks ont OpenAI comme cible de modèle potentielle, mais ils offrent également des fonctionnalités supplémentaires comme le routage de modèle, si bien que rien ne garantit que le fournisseur du framework utilisera toujours OpenAPI », a-t-il ajouté.

GPT o1 in API est prêt pour la production. « Le modèle contient des capacités de vision pour raisonner sur des images, ce qui permet d’envisager beaucoup plus d'applications dans les domaines de la science, de la fabrication ou du codage, où les entrées visuelles sont importantes », a fait valoir OpenAI. D'autres améliorations incluent l'appel de fonctions pour connecter o1 à des données et des API externes, ainsi qu'un paramètre API qui offre au développeur un « contrôle sur le temps de réflexion du modèle avant de répondre. » Ce paramètre est disponible au niveau Tier 5 de l'API. Parmi les autres ajouts à l'ensemble d'outils, OpenAI mentionne encore des améliorations de l'API Realtime « utilisée par les développeurs pour créer des expériences conversationnelles multimodales à faible latence. » Actuellement, l’API prend en charge le texte et l'audio en entrée et en sortie, ainsi que les capacités d'appel de fonctions.

Le support de WebRTC apprécié

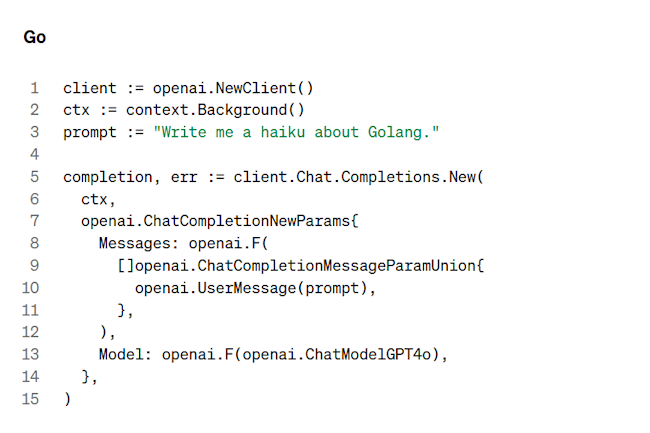

Mais l'intégration avec WebRTC, une norme ouverte de communication, est, à n’en pas douter, l'un des principaux ajouts. « L’intégration à WebRTC apporte des interactions fluides et réactives dans des conditions réelles, même avec une qualité de réseau variable », a précisé l'entreprise qui a également annoncé le lancement de Preference Fine Tuning. Présentée comme une autre technique de personnalisation des modèles, il facilite l'adaptation des modèles en fonction des préférences des utilisateurs et des développeurs, ainsi que de SDK pour Go et Java, tous deux disponibles en version bêta. M. Andersen de Moor Insights & Strategies a qualifié ces SDK de « très intéressants », car ils concernent deux langages très répandus chez les développeurs qui utilisent le cloud public. « Ceux-ci et les API offrent une alternative significative aux développeurs qui n’utilisent que les modèles proposés sur étagère par le fournisseur de cloud. »

De son côté, Andrew Cornwall, analyste principal chez Forrester, fait remarquer que quand OpenAI parle d’« outils supplémentaires pour les développeurs », il désigne surtout les développeurs d'IA. « Tous les autres ne commenceront à les utiliser qu'une fois que les développeurs d'IA auront mis la main sur ces outils. » Ce qui devrait prendre un certain temps, puisque les API o1-2024-12-17 ont été déployées hier au niveau Tier 5, c'est-à-dire pour les utilisateurs les plus exigeants. Par ailleurs, au regard de ce qui a été annoncé, M. Cornwall estime que « le plus intéressant est probablement la prise en charge de la vision, capacité qui ne figurait pas dans l’aperçu o1-preview. » Il pense aussi que « le dernier modèle o1 devrait renvoyer des réponses plus précises et signaler moins de refus que l'aperçu. » L’analyste fait encore remarquer que les capacités mathématiques et de codage « ont été améliorées par rapport à l'aperçu, parfois de manière significative, même si le score rapporté par o1 ne détrônera pas Amazon Q en tête du classement SWE-bench Verified. »

Des SDK pour Java et Go en guise d’ouverture

OpenAI a également amélioré l'appel de fonction et la sortie structurée, « c’est-à-dire les capacités d'appeler un programme à partir d'une requête d'IA et de renvoyer la sortie en JSON, apprécié par les développeurs, plutôt qu'en langage naturel. » En outre, « les développeurs disposent d’un nouveau paramètre, le raisonnement basé sur les modèles, avec lequel ils pourront ajuster la précision et la vitesse », a-t-il indiqué. « Cela s'intégrera parfaitement au support WebRTC pour la voix, une pause de quelques secondes est parfois acceptable au clavier, mais pas pendant une conversation. » Par ailleurs, selon M. Cornwall, « avec le passage des SDK pour Java et Go en version bêta, davantage de développeurs pourront expérimenter avec le modèle le plus puissant d'OpenAI, car, même si les entreprises sont impatientes d'utiliser l'IA, nombre d'entre elles attendent la stabilité que pourrait offrir cette version. »

En bref, il pense que ces ajouts ne sont pas une révolution. La plupart des capacités étaient déjà disponibles dans différents modèles. Mais avec cette version, le modèle unique s'améliore dans de nombreux modes et pour plusieurs catégories de problèmes. Selon Thomas Randall, directeur de la recherche sur le marché de l'IA chez Info-Tech Research Group « cette ouverture et cette flexibilité accrues ont pour objectif de maintenir la part de marché d’OpenAI en tant que fournisseur de modèles de référence pour les développeurs. Des dépendances plus profondes pourraient se créer entre le provisionnement de modèles la société et les éditeurs qui utilisent déjà OpenAI pour leur propre offre améliorée par l'IA. »

Commentaire