Facebook vient de livrer des statistiques stupéfiantes sur son réseau social. Chaque jour, les utilisateurs regardent 100 millions d’heures de vidéo, 400 millions de personnes utilisent Messenger et plus de 95 millions de photos et vidéos sont postées sur Instagram. Comme on pouvait s’en douter, cette activité de ruche bourdonnante représente une sacrée charge pour les serveurs dans les datacenters du fournisseur. Pour améliorer les services, des technologies d’apprentissage machine sont à l’œuvre dont la reconnaissance d’images. La problématique est la même chez Microsoft qui s’emploie en permanence à équilibrer la charge sur ses serveurs. Là aussi, le machine learning est mis en œuvre pour des services en langage naturel comme Cortana.

Les deux fournisseurs ont donc mis en place de nouveaux designs de matériel en open source pour obtenir des réponses accélérées sur ces services faisant appel aux technologies d’intelligence artificielle. Ces designs de serveurs vont permettre aux entreprises de proposer davantage de services à travers leurs plateformes et logiciels. Ils ont été présentés hier sur l’Open Compute Project U.S. Summit qui se tient en ce moment (8-9 mars) à Santa Clara en Californie. D’autres entreprises pourront les prendre comme référence pour concevoir leurs propres serveurs qu’ils pourront ensuite faire fabriquer en série en Asie, ainsi que Facebook et Google procèdent depuis des années. Les institutions financières ont également testé les designs OCP pour mettre au point des serveurs destinés à leurs datacenters. Big Basin, de Facebook, est un boîtier serveur peu orthodoxe que la société de Mark Zuckerberg surnomme JBOG, « just a bunch of GPU » que l’on pourrait traduire par « juste une flopée de GPU » et qui apporte une puissance sans précédent pour l’apprentissage machine. Le système n’a pas de CPU et se présente sous la forme d’un boîtier indépendant qui doit être connecté à des serveurs et systèmes de stockage distincts.

Découpler les ressources pour étendre plus vite les capacités

Le rôle de Big Basin est de découpler les unités de traitement, de stockage et de réseau dans les datacenters. Regroupées de façon indépendante, les ressources de stockage et de calcul peuvent être étendues plus rapidement, alors qu’elles se retrouvent limitées quand elles sont confinées dans un boîtier serveur comme aujourd’hui. Les capacités de calcul sont également beaucoup plus rapides lorsque les ressources de traitement et de stockage sont physiquement reliées à proximité les unes des autres. Ces unités découplées partagent également l’alimentation électrique et les dispositifs de refroidissement, ce qui réduit la facture d’électricité dans les datacenters. Le système Big Basin peut être connecté à Tioga Pass, nouveau design de serveur dual-CPU open source de Facebook.

Le Tioga Pass de Facebook est un autre design de serveur reposant sur les spécifications de l'Open Compute Project.

Cette notion de découplage est importante pour les datacenters de fournisseurs comme Facebook et Google qui achètent des milliers de serveurs pour faire face à leurs besoins croissants de traitement. Ces grands acteurs du web peuvent ainsi ajouter beaucoup plus vite des capacités supplémentaires pour leurs services web et leurs tâches de machine learning. Intel s’est aussi lancé dans cette course avec son architecture Rack Scale et des entreprises comme Dell et Hewlett Packard Enterprise fournissent également des présentations détaillées de telles mises en œuvre. Big Basic intègre huit accélérateurs GPU Nvidia Tesla P100, connecté au travers de liens rapides NVLink à une architecture mesh semblable à celle du serveur DGX-1 Nvidia utilisé dans un superordinateur IA de Fujitsu au Japon.

Bascule automatique entre architectures x86 et ARM

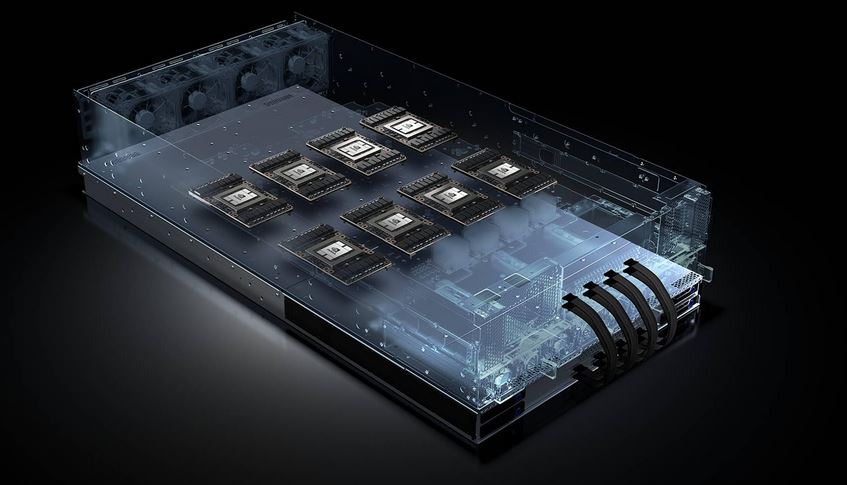

L’autre design de serveur conçu pour les applications d’intelligence artificielle vient de Microsoft qui a annoncé son projet Olympus comportant davantage de place pour des co-processeurs IA. La firme de Redmond a également annoncé l’accélérateur GPU HGX-1 avec Nvidia et Ingrasys. Celui-ci est similaire au Big Sur de Facebook mais il peut être étendu jusqu’à 32 CPU. Le projet Olympus propose un design de serveur plus conventionnel qui ne requiert pas de modifications massives dans les installations de serveurs. Il arrive dans un serveur rack au format 1U avec des CPU, des GPU, de la mémoire, le stockage et le réseau dans le même boîtier. Il présente un connecteur universel pour la carte mère qui supporte les dernières puces serveurs, incluant le Skylake d’Intel et le Naples d’AMD.

L'architecture hyperscale HGX-1 a été conçue par Microsoft et Nvidia pour faire « décoller les calculs IA dans le cloud ».

Ce projet va apporter quelque choses rarement vu dans les serveurs : un mélange entre x86 et ARM avec le support des processeurs Thunder X2 de Cavium et Centriq 2400 de Qualcomm. Ce dernier présente une carte mère et un serveur basés sur le design de Project Olympus sur l’OCP Summit. Le serveur fonctionnera sous Windows Server et c’est la première fois que ce système d’exploitation tournera sur des puces ARM. Le support de la carte mère universelle x86 et ARM permettra aux clients de switcher entre les architectures de processeurs sans avoir à acquérir de nouveaux matériels. Avoir apporté le support de ARM au Project Olympus est l’une des grandes réalisations de ce nouveau design, indique dans un billet Kushagra Vaid, general manager responsable de l’infrastructure hardware Azure chez Microsoft.

Les FPGA d'Intel pour livrer plus vite les résultats de Bing

Il y a aussi de la place pour les FPGA d’Intel qui vont accélérer les applications de recherche et de deep learning. Microsoft les utilise pour livrer plus vite les résultats de son moteur Bing. Le serveur présente également des connecteurs pour rajouter jusqu’à 3 cartes PCI-Express comme des GPU, jusqu’à 8 SSD NVM, Ethernet et de la mémoire DDR4. Il comporte aussi de multiples ventilateurs, dissipateurs de chaleur et batteries pour que le serveur continue à fonctionner en cas de coupure d’électricité. Project Olympus HGX-1 supporte 8 GPU Pascal Nvidia à travers la technologie d’interconnexion NVLink. Quatre accélérateurs HGX-1 AI peuvent être reliés pour créer un cluster massif d’apprentissage machine de 32 GPU.

Les datacenters d’aujourd’hui opèrent une transformation massive pour supporter l’adoption rapide des traitements liés à l’intelligence artificielle, a indiqué Ian Buck, vice-président responsable du calcul accéléré chez Nvidia. « Les nouveaux designs OCP de Microsoft et Facebook montrent que les centres de données hyperscales ont besoin de GPU haute performance pour faire face aux énormes demandes de ces traitements IA », pointe-t-il.

Commentaire