Décidément Nvidia est au centre de toutes les attentions cette semaine en France. Ainsi Iliad a annoncé un investissement de 200 millions d’euros dans l’IA comprenant notamment l'acquisition d'un système DGX SuperPod composé de noeuds de calcul DGX H100 (et d'un stockage fourni par DDN). Puis, c’est l’Autorité de la concurrence qui a visité les locaux de Nvidia France à la Défense près de Paris dans le cadre de soupçon sur des pratiques anti-concurrentielles sur le marché des cartes graphiques. Aujourd’hui, c’est au tour d’OVHcloud de dévoiler sa stratégie IA en misant fortement sur les solutions développées par Nvidia.

Les L4 et L40S pour l’inférence

Au menu plusieurs instances à base d’accélérateur GPU de la firme de Santa Clara pour l’entraînement des modèles notamment LLM et l’inférence (l’exécution d’un modèle une fois qu’il a déjà été entraîné). Sur ce dernier point, le fournisseur roubaisien disposait déjà de VM sur les cartes A100 (dont les premières version datent de 2020) et vient de les booster avec plus de mémoire en passant à 80 Go HBM2 ECC 5120 bits pour une bande passante de près de 2 To/s. Plusieurs configurations sont disponibles allant de une carte A100, 15 vCore et 180 Go de RAM (pour un prix de 2,75 euros de l’heure) à 4 cartes A100, 60 vCore et 720 Go de RAM (11 euros de l’heure).

Toujours dans l’inférence, OVHcloud compte sur les récentes cartes Nvidia L4 et L40S pour cette tâche. La L4 a été annoncée en mars dernier et succède à la T4. Elle est basée sur l’architecture GPU Ada Lovelace et comprend 24 Go de mémoire. La firme la définissait alors comme un accélérateur universel pour la vidéo, l'intelligence artificielle et le graphisme. De son côté les L40S garde la même architecture avec 48 Go de mémoire. Yaniv Fdida, CPO (chief product officer) d’OVHcloud a précisé, « les L40S sont idéales pour l’inférence avec des petits modèles d’IA, les L4 s’orientent aussi vers l’inférence mais aussi le VDI ». Ces deux offres seront disponibles au travers d’instances sur son cloud public (dans le courant du mois d’octobre), mais également sur des serveurs bare metal (au cours de l’automne). La firme précise que la L4 rejoindra la gamme Scale-GPU et la L40S la gamme HGR-AI. Si elle est très orientée Nvidia, le fournisseur de Roubaix n'exclut pas la concurrence : « Nous regardons les avancées d’AMD avec les cartes Instinct Mi 250 et Mi 300 combinant CPU et GPU qui sont très prometteuses et Intel Flex qui doivent gagner en maturité », répond le responsable.

H100 pour l’entraînement

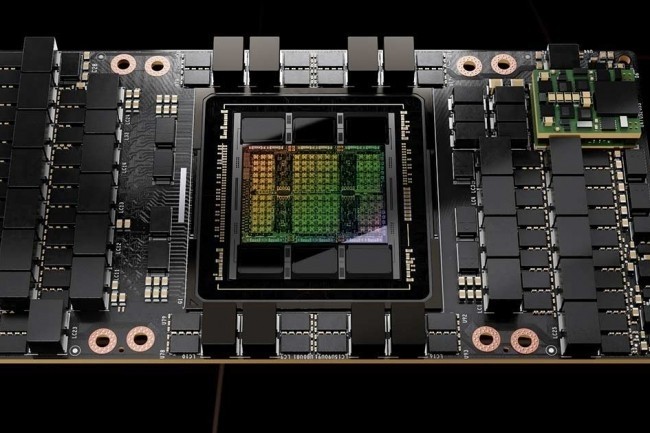

Côté entraînement des modèles d’IA, OVHcloud suit la concurrence en misant sur les cartes H100 (architecture Hooper). Les instances sont disponibles en pré-réservation et devraient être livrées en novembre prochain. Deux types d’accélérateurs seront mises à disposition, les H100 classiques et la variante SXM. Les premières sont dotées de 14 592 unités CUDA et associé à 80 Go de mémoire vidéo HBM3. Elles affichent une bande passante de 2 To/s et supporte le PCIe Gen 5.

Le modèle SXM (doté de 16 896 unités CUDA) affiche une puissance de calcul plus importante (67 Tflops) et une bande passante GPU beaucoup plus importante (3,35 To/s). Cette offre sera accessible « à discrétion » rapporte Yaniv Fdida et indique avoir Lighton, société française qui développe des LLM, comme premier client.

Commentaire