Le consortium MLCommons, que nous avons rencontré en janvier dernier, a publié de nouvelles versions de ses benchmarks MLPerf Inference, offrant un aperçu plus précis des performances des centres de données et du matériel sous des charges de travail d'IA de plus en plus exigeantes. La version 5.0 mise à jour de MLPerf Inference arrive alors que les équipes d'infrastructure sont confrontées à une demande croissante d'applications d'IA génératives telles que les chatbots et les assistants de code, qui nécessitent un traitement rapide de requêtes volumineuses et complexes. Les tests de performance fournissent des moyens standardisés de comparer la vitesse et la réactivité des plateformes matérielles (serveurs avec CPU et accélérateurs) qui alimentent ces outils. L'un des nouveaux tests s'articule autour du modèle Llama 3.1 de Meta, qui compte 405 milliards de paramètres et qui permet d'évaluer la capacité d'un système à exécuter des tâches intensives telles que les calculs mathématiques, la réponse à des questions et la génération de code. Un autre test se concentre sur l'inférence à faible latence, en simulant des scénarios d'interaction en temps réel à l'aide du modèle Llama 2 70B de Meta.

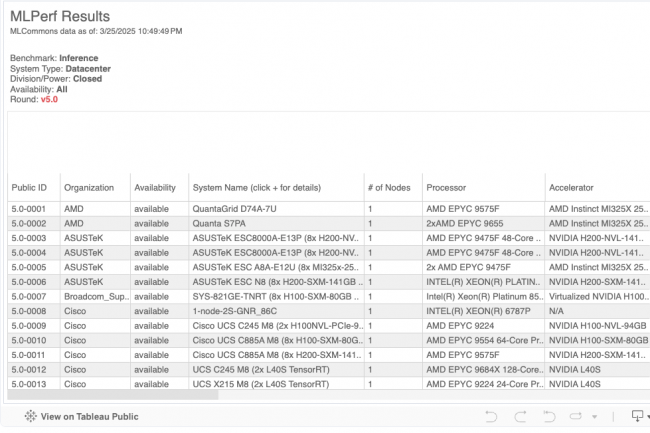

MLCommons a publié les résultats de benchmarking MLPerf Inference v5.0 soumis par 23 fournisseurs, dont AMD, Broadcom, Cisco, CoreWeave, Dell, Fujitsu, Google, Hewlett-Packard Enterprise, Intel, Nvidia, Oracle et Supermicro. Nvidia avait déjà partagé ses résultats pour les benchmarks mis à jour, soulignant que son GPU Blackwell constituait une avancée majeure par rapport à l'architecture Hopper précédente.nLa dernière version élargit également son champ d'application au-delà des benchmarks de chatbot. Un nouveau test de réseau neuronal graphique (RNG) cible le matériel pour centres de données et est conçu pour des charges de travail telles que la détection de fraude, les moteurs de recommandation et les graphes de connaissances. Il utilise le modèle RGAT basé sur un ensemble de données graphiques contenant plus de 547 millions de nœuds et 5,8 milliards d'aspects.

Évaluer les performances

Les analystes suggèrent que ces tests de performance permettront de juger plus facilement la performance de diverses puces et grappes de matériel informatique sur la base de modèles documentés. « Alors que chaque fournisseur de puces cherche à prouver que son matériel est suffisamment performant pour prendre en charge l'IA, nous disposons désormais d'un test de performance standard qui montre la qualité de la prise en charge des questions, des mathématiques et des compétences de codage associées au matériel », a déclaré Hyoun Park, CEO et analyste en chef chez Amalgam Insights. Les fournisseurs de puces peuvent désormais rivaliser non seulement sur les vitesses et les débits traditionnels, mais aussi sur les compétences mathématiques et la précision des informations. Ce benchmark offre une rare opportunité d'ajouter de nouvelles normes de performance sur le matériel de différents fournisseurs, a ajouté M. Park.

« La latence, c'est-à-dire la vitesse à laquelle les tokens sont délivrés et le temps nécessaire à l'utilisateur pour voir la réponse, est le facteur décisif », a déclaré Neil Shah, associé et cofondateur de Counterpoint Research. « C'est là que des acteurs tels que Nvidia, AMD et Intel doivent mettre au point le logiciel adéquat pour aider les développeurs à optimiser les modèles et à obtenir les meilleures performances de calcul. »

Benchmarking et décisions d'achat

Les benchmarks indépendants tels que ceux de MLCommons jouent un rôle clé en aidant les acheteurs à évaluer les performances des systèmes, mais s'y fier uniquement peut ne pas fournir une image complète. « Ces benchmarks ne permettent pas encore d'évaluer en détail le travail dans le monde réel », a souligné M. Park. « Par exemple, le benchmark de réponse aux questions peut aider à évaluer un aspect spécifique du service client, mais ne remplace pas une analyse des performances du service client. »

Cela signifie que si les nouveaux benchmarks constituent une avancée significative, ils ne sont probablement qu'un des nombreux facteurs guidant les décisions d'achat de matériel informatique des entreprises. « Lorsqu'il s'agit de décisions d'achat de matériel informatique d'entreprise, elles sont influencées par une multitude de facteurs, dont la puissance de calcul », a déclaré Abhishek Sengupta, directeur de la pratique chez Everest Group. « Les fabricants de matériel informatique qui ne sont pas les meilleurs sur certains critères de performance peuvent offrir de meilleures conditions commerciales pour compenser cela, offrant un meilleur rapport qualité-prix. » Les performances d'un cas d'utilisation de l'IA dépendent d'une série de facteurs liés à l'ensemble des technologies, ainsi que de l'apport humain. Les critères de référence étroits ciblant des composants isolés peuvent ne pas permettre de saisir l'impact global sur les résultats concrets, a ajouté M. Sengupta.

Commentaire