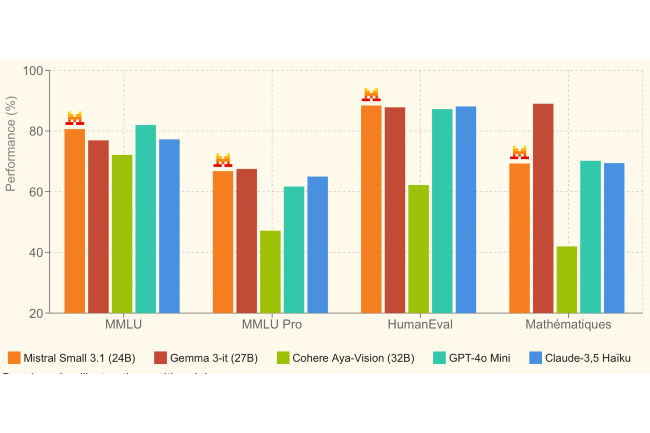

Les petits modèles ont la côte et Mistral AI entend bien conquérir ce marché avec son dernier SLM Small 3.1. Développée à partir du modèle Small 3, lancé en janvier dernier, cette version à 24 milliards de paramètres offre des performances textuelles renforcées, une meilleure compréhension multimodale et une fenêtre contextuelle élargie, capable de contenir jusqu'à 128 000 tokens. Dans son communiqué, la start-up explique que Small 3.1 rivalise en termes de performance avec d’autres modèles concurrents.

Un modèle efficace pour différents domaines

Dans ce domaine, il se mesure à Gemma 3 récemment dévoilé par Google et GPT-4o mini d'OpenAI. Le SLM de Mistral se distingue par sa rapidité, générant jusqu’à 150 tokens par seconde, une réactivité similaire à la concurrence. Fonctionnant sur une carte graphique RTX 4090 ou un Mac avec 32 Go de RAM, Small 3.1 est parfaitement adapté aux environnements mobiles. Il est également très efficace pour les assistants virtuels, où la réactivité et la précision sont essentielles.

Mistral a déclaré dans un article de blog que Small 3.1 est polyvalent et personnalisable. Il peut servir à « la vérification de documents, les diagnostics, le traitement d'images, l'inspection visuelle pour les contrôles de qualité, la détection d'objets dans les systèmes de sécurité, le support client basé sur l'image et l'assistance à usage général.»

Un accès immédiat pour les développeurs

Distribué sous licence Apache 2.0, Small 3.1 est librement exploitable par les entreprises et la communauté open source. Il est déjà disponible sur Hugging Face en deux déclinaisons : Mistral Small 3.1 Base et Mistral Small 3.1 Instruct. Le modèle est également accessible via l’API de Mistral AI ainsi que sur Google Cloud Vertex AI. Dans les prochaines semaines, il sera intégré aux services NIM de NVIDIA et Azure AI Foundry de Microsoft.

Commentaire