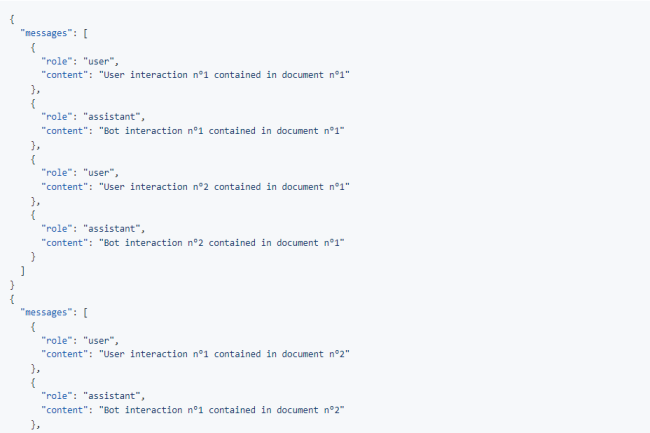

Pour répondre aux besoins des entreprises d'assurer une optimisation des modèles d'IA qu'elles utilisent (aussi bien LLM que SLM), les fournisseurs proposent de plus en plus des options de personnalisation (aka fine tuning). Et ce afin d'assurer de meilleures performances aussi bien en matière de capacités de traitements, de rapidité d'exécution que de contrôle et de gestion des risques associés. C'est le cas de Mistral AI qui a fait des annonces spécifiques pour monter en puissance sur ce sujet pour les développeurs qui souhaitent affiner les modèles open source de Mistral sur leur infrastructure, en publiant un sdk mistral-finetune. "Notre code de base est construit sur le paradigme de formation LoRA (Low-Rank Adaptation), qui propose un réglage fin performant et efficace de la mémoire", explique la start-up.

Aux côtés de ce code base, Mistral AI annonce aussi des services de réglage fin pour ses modèles Mistral 7B and Small accessibles pour l'heure à certains clients. "Nos services de formation sur mesure consistent à affiner les modèles d'IA de Mistral sur les applications spécifiques d'un client en utilisant ses propres données. Cette approche permet de créer des modèles hautement spécialisés et optimisés pour leur domaine particulier. Nous proposons des techniques avancées telles que le pré-entraînement continu afin d'inclure des connaissances exclusives dans les poids des modèles eux-mêmes", indique la jeune pousse.

Commentaire