Mistral AI a lancé un grand modèle linguistique de 123 milliards de paramètres appelé Mistral Large 2 (ML2), renforçant ainsi sa position de concurrent important d'OpenAI, d'Anthropic et de Meta. Dans un communiqué, l'entreprise indique que ML2 dispose d'une fenêtre contextuelle de 128k et prend en charge des dizaines de langues, dont le français, l'allemand, l'espagnol, l'arabe, le chinois, le japonais et le coréen. Il supporte aussi plus de 80 langages dont Python, Java, C, C++, JavaScript et Bash. Cette annonce fait suite à la présentation par Meta de la famille de LLM Llama 3.1, qui comprend le modèle le plus avancé, le 405B. Meta affirme que ses modèles disposent également d'une longueur de contexte de 128K et supportent huit langues. Le lancement de Large 2 a été fuité par Google Cloud mercredi qui en avait fait mention dans son dernier partenariat avec la start-up française.

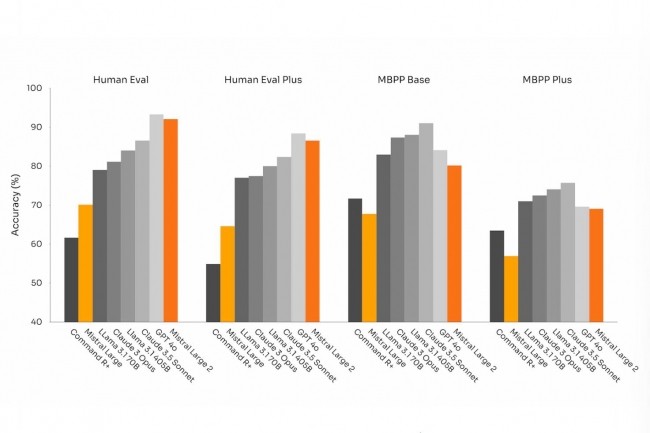

La semaine dernière, OpenAI a lancé GPT-4o mini, son petit modèle d'IA le plus abordable. Mistral AI a déclaré que les analyses comparatives montrent que ML2 a des performances comparables à celles des principaux modèles tels que GPT-4o, Claude 3 Opus et Llama 3 405B dans des domaines tels que le codage et le raisonnement. Sur le test d'étalonnage populaire MMLU, ML2 a obtenu un score de 84 %, tandis que Llama 3.1 405B a obtenu un score de 88,6 % et GPT-4o un score de 88,7 %. GPT-4o mini a obtenu un score de 82 %. Les modèles d'IA de Mistral sont disponibles sur Vertex AI, Azure AI Studio, Amazon Bedrock et IBM watsonx.ai, a indiqué l'entreprise.

Principaux attraits pour les entreprises

Les analystes soulignent que la bataille de l'IA s'est déplacée vers des modèles conversationnels et multimodaux, chacun s'efforçant d'exceller dans les mathématiques complexes, le raisonnement avancé et la génération efficace de codes. Selon Neil Shah, partenaire et cofondateur de Counterpoint Research, les principaux acteurs de l'IA, comme Mistral AI, se concentrent sur la réduction des hallucinations, l'amélioration des capacités de raisonnement et l'optimisation du rapport performance/taille de leurs modèles. « C'est là que Mistral Large 2 excelle en termes de performances par rapport à la taille, puisqu'il ne nécessite que 246 Go de mémoire avec une précision totale de 16 bits pendant l'entraînement », a déclaré M. Shah. « L'empreinte réduite de Mistral Large 2 par rapport à la concurrence, tout en maintenant une précision plus élevée, est avantageuse pour les entreprises. Il leur permet de produire des réponses contextuelles plus précises et plus concises plus rapidement que les autres modèles plus grands, qui nécessitent plus de mémoire et de calcul. »

En outre, les entreprises fortement dépendantes de Java, TypeScript ou C++ bénéficieront des performances et de la précision supérieures en matière de génération de code que les benchmarks de Mistral revendiquent, a ajouté M. Shah. Les modèles open source comme celui de Mistral peuvent également permettre aux utilisateurs de créer des LLM spécialisés adaptés à des industries ou des lieux spécifiques, selon Faisal Kawoosa, analyste en chef chez Techarc. « Ces types de LLM spécialisés finiront par émerger au fil du temps », a déclaré M. Kawoosa. « Bien que l'IA générative soit utile, dans de nombreux cas, une compréhension spécialisée du domaine est nécessaire, ce qui ne peut être obtenu qu'en créant de tels LLM. Il est donc crucial de disposer d'une plateforme open source qui non seulement fournit des LLM pour utiliser des modèles d'IA, mais qui permet également de les modifier et de les développer pour créer ces plateformes très spécifiques. » Charlie Dai, vice-président et analyste principal chez Forrester, a également noté que les fonctionnalités avancées de Mistral LLM-2 en matière de génération de code, de mathématiques, de raisonnement, de performance et de rentabilité - conçues pour fonctionner efficacement sur un seul nœud H100 - ainsi que son support multilingue et sa disponibilité sur les principales plateformes cloud, renforceront considérablement sa compétitivité pour les entreprises clientes dans le cadre de leurs initiatives en matière d'IA.

Des limites transformées en freins ?

Un problème potentiel pour les utilisateurs est que Mistral distribue ML2 sous la licence Mistral Research License (MRL), autorisant l'utilisation et la modification uniquement à des fins de recherche et à des fins non commerciales. Pour une utilisation commerciale nécessitant un auto-déploiement, les utilisateurs doivent obtenir une licence commerciale Mistral distincte auprès de la société. « Étant donné que Mistral AI a dû engager d'importants coûts de données et de formation pour Large 2, l'entreprise a réduit à juste titre le champ d'application de l'utilisation commerciale sans licence, en exigeant une licence commerciale stricte, ce qui fait grimper le prix et pourrait constituer un obstacle », a déclaré M. Shah. « Cela peut être un obstacle dans certains domaines comme les marchés émergents.

Prabhu Ram, vice-président du groupe de recherche sur l'industrie chez Cybermedia Research, a ajouté que si l'IA de Mistral s'est révélée prometteuse, certaines préoccupations persistent cependant. Notamment en matière de transparence des données, d'interprétabilité des modèles et du risque de biais, qui restent des domaines critiques à améliorer.

Commentaire