Après l'euphorie, la réalité commence à s'imposer sur les capacités de l'IA générative : sans protections appropriées, les grands modèles de langage (LLM) peuvent se montrer terriblement naïfs et partager beaucoup trop facilement ce qu'ils savent. Or de tels comportements exposent les applications construites à partir de ces modèles, et les entreprises qui les utilisent, à des risques de piratage et à des poursuites pour violation des droits d'auteur. Pour atténuer certains de ces risques, Microsoft a ajouté des outils de sécurité à sa plateforme de création d'applications, Azure AI Studio. L’idée est d’aider les entreprises à savoir comment leurs grands modèles de langage (LLM) réagissent aux attaques indirectes par injection d’invites et à vérifier s'ils incluent des informations protégées dans leurs réponses.

Détecter les attaques par injection d’invites

Les attaques par injection indirecte d’invites, également connues sous le nom de XPIA (Indirect Prompt Injection Attacks), ciblent la source de données d'ancrage du LLM. Ces attaques sont de plus en plus populaires auprès des pirates qui cherchent à corrompre la source de données pour transmettre des instructions malveillantes cachées au modèle afin de contourner ses garde-fous de sécurité. L'outil de Microsoft, Azure AI Evaluate, est accessible via l'interface Azure AI Studio ou via le SDK Azure AI Evaluation. Il « sert à simuler des attaques par injection indirecte sur leur modèle ou application d'IA générative et à mesurer la fréquence à laquelle ils ne parviennent pas à détecter et à détourner certaines attaques, par exemple l'intrusion de contenu manipulé ou la collecte d'informations », a écrit Minsoo Thigpen, cheffe de produit senior à la division Azure AI de Microsoft, dans un article de blog.

« Si les développeurs estiment que leurs modèles ne parviennent pas à stopper les attaques indirectes par injection d'invites, ils peuvent soit ajuster les sources de données d’ancrage, soit appliquer d'autres mesures d'atténuation avant de recommencer l'évaluation pour vérifier si leur modèle ou leur application peuvent être déployés en production en toute sécurité », a expliqué Minsoo Thigpen. Une autre fonctionnalité appelée Prompt Shields aide les développeurs à détecter et à bloquer ou atténuer toute attaque provenant d'invites d'utilisateurs. « Elle peut être activée via le service Azure Content Safety AI Service de Microsoft », a-t-elle ajouté. Prompt Shields cherche à bloquer les invites qui peuvent conduire à des résultats d'IA dangereux. Il peut également identifier les attaques de documents lorsque du contenu nuisible est intégré dans des documents fournis par l'utilisateur. L'outil Azure AI Evaluate et le SDK correspondant sont actuellement disponibles en aperçu.

La gestion du contenu protégé

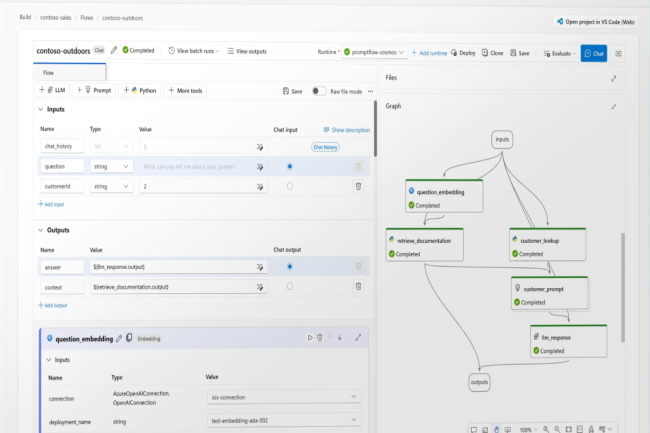

Mais le SDK d'évaluation Azure AI a aussi une autre fonction : il peut tester la fréquence à laquelle les LLM qui sous-tendent les applications génèrent des réponses contenant ce que le fournisseur appelle du « matériel protégé », ou plus exactement du matériel interdit, car la catégorie comprend des textes protégés par le droit d'auteur dont l'entreprise ne détient probablement pas les droits, comme des paroles de chansons, des recettes et des articles. « Pour le vérifier, les résultats du LLM sont comparés à un index de contenus textuels de tiers maintenu sur GitHub », a indiqué la responsable. « Les utilisateurs peuvent regarder l’évaluation en détails afin de mieux comprendre comment leur application répond à ces invites d'utilisateur et les risques associés », ajoute-t-elle. Deux API sont fournies : l'une pour signaler la sortie de textes protégés par le droit d'auteur, et l'autre pour signaler la sortie de code protégé, y compris les bibliothèques logicielles, le code source, les algorithmes et d'autres éléments liés à la programmation. Un aperçu de la fonctionnalité de test est également accessible via l'interface d'Azure AI Studio.

D'autres fonctionnalités mises à jour du SDK Azure AI Evaluation, également en avant-première, comprennent de nouvelles évaluations de la qualité, ainsi qu'un générateur de données synthétiques et un simulateur pour les tâches non contradictoires. Ces évaluations de la qualité, qui seront aussi incluses dans l'interface Azure AI Studio en octobre, sont basées sur des mesures mathématiques populaires qui devraient aider les développeurs à vérifier si un LLM génère des résultats textuels qui respectent la qualité. « Ces mesures, à savoir ROUGE (Recall-Oriented Understudy for Gisting Evaluation), BLEU (Bilingual Evaluation Understudy), GLEU (Google-BLEU) et METEOR (Metric for Evaluation of Translation with Explicit Ordering) vérifient la précision, le rappel et l'exactitude grammaticale », a rappelé Minsoo Thigpen. Le générateur de données synthétiques et le simulateur de tâches non contradictoires devraient aider les développeurs à vérifier si leur LLM répond aux normes souhaitées quand l’utilisateur envoie une invite spécifique.

Commentaire