L’évaluation est un aspect essentiel de l’entraînement d’un modèle IA en expertisant leur performance, la qualité des réponses, la fiabilité, l’éthique, etc. Habituellement, l’évaluation humaine est requise dans le développement de LLM. Pour autant, des chercheurs de l’équipe de Meta sur l’IA (baptisée FAIR) développent des évaluateurs autoapprenants pour les LLM. Ils ont publié un article de leurs travaux et expliquer leur démarche.

Comme indiqué le recours aux données annotées par des humais est très présente dans le domaine de l’évaluation. Elle peut être directe avec un humain qui analyse les sorties des LLM ou via la technique dite LLM as a judge, qui se sert d’un modèle pour jauger les réponses du modèle d’IA (à partir d’une donnée x il propose une préférence pour la réponse qui est la meilleure A ou B). Mais là encore, ce procédé est formé avec de grandes quantités de données annotées par des humains ce qui le rend coûteux et les données deviennent obsolètes au fur et à mesure que le modèle s’améliore, soulignent les chercheurs.

L’approche LLM as a judge optimisée

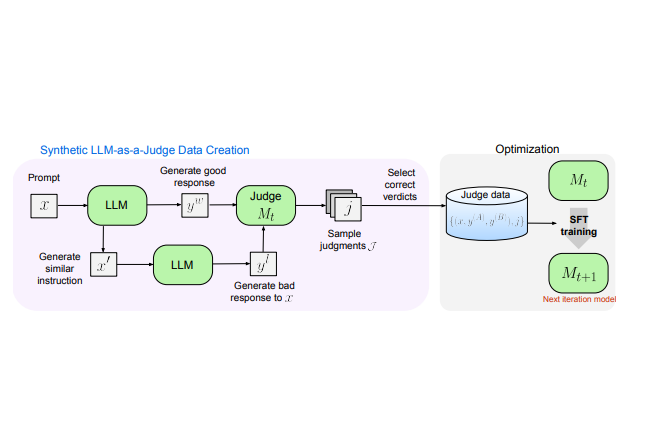

Ils se sont donc servis du LLM as a judge, mais en ne lui fournissant que des données synthétiques, et « aucune donnée annotée par des humains ». Les chercheurs ont démarré avec un modèle de départ et ont utilisé le prompt engineering pour générer des paires de préférences (A ou B) synthétiques à partir d’une entrée donnée. Le modèle a été entraîné de manière itérative sans avoir besoin d’instructions de label. Ce dernier ou étiquette est la réponse attendue du LLM. Cela peut être un mot dans un texte que l’on retire pendant la phase d’entraînement. « À partir d'instructions non étiquetées, notre schéma itératif d'auto-amélioration a généré des sorties de modèle contrastées et a entraîné un LLM as a judge pour produire des débuts de raisonnement et des jugements finaux. Cet entraînement a été répété en utilisant les prédictions améliorées lors de chaque itération », précise l’équipe FAIR de Meta. Au final, les chercheurs ont obtenu « une LLM as a judge supérieur , à partir duquel nous pouvons ensuite itérer l'ensemble du processus afin qu'il s'améliore de lui-même ».

Dans le cadre de leurs expériences, ils ont affirmé dans l'article que sans aucune donnée de préférence étiquetée, l'évaluateur autoapprenant a amélioré le score de Llama3-70B-Instruct de 75,4 à 88,3 points sur l'outil d'analyse comparative RewardBench. Selon eux, ce changement de score surpasse les LLM as a judge couramment utilisés, tels que GPT-4, et correspond aux performances des modèles de récompense (utilisés dans le cadre du renforcement supervisé) les plus performants. Toutefois, les chercheurs ont également souligné que cette approche présentait certaines limites. Ils ne l'ont pas testée sur des modèles plus petits (leurs modèles d'essai avaient 70 milliards de paramètres) et n'ont pas tenu compte des exigences de calcul, mais seulement de la précision. Autre limite, le modèle de départ utilisé était « déjà raisonnablement aligné sur les préférences humaines (ou juridiques/politiques) ».

Commentaire