En avril, Meta a publié un article sur une nouvelle approche de formation pour des LLM meilleurs et plus rapides utilisant la prédiction multi-tokens. Cette dernière approche rompt avec la méthode traditionnelle d'entraînement des LLM pour prédire uniquement le mot suivant d'une séquence. Au lieu de cela, l'approche de la maison-mère de Facebook demande aux modèles de prévoir plusieurs mots futurs simultanément, ce qui promet des performances accrues et des temps de formation considérablement réduits. En prédisant plusieurs mots à la fois, ces modèles peuvent développer une compréhension plus nuancée de la structure et du contexte de la langue. Cela pourrait conduire à des améliorations dans des tâches allant de la génération de code à la rédaction de contenu, en comblant potentiellement le fossé entre l'IA et la compréhension du langage au niveau humain.

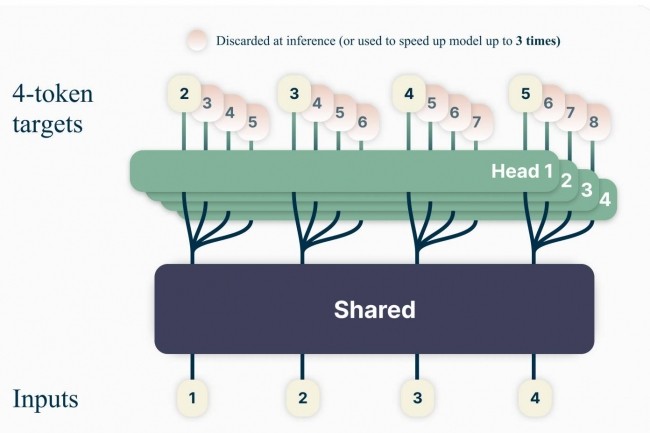

"Les grands modèles de langage tels que GPT et Llama sont entraînés avec une perte de prédiction du token suivant", explique Meta. "L'entraînement des modèles de langage pour prédire plusieurs futurs tokens simultanément permet d'obtenir une plus grande efficacité d'échantillonnage. Plus précisément, à chaque position dans le corpus d'apprentissage, nous demandons au modèle de prédire les n tokens suivants à l'aide de n séquence de sortie indépendantes, opérant au-dessus d'un tronc de modèle partagé. En considérant la prédiction multi-tokens comme une tâche d'entraînement auxiliaire, nous mesurons l'amélioration des capacités en aval sans surcharge de temps de formation pour les modèles de code et de langage naturel."

Des résolutions de problèmes sensiblement améliorées

Selon le fournisseur, les gains sont particulièrement prononcés sur les benchmarks génératifs tels que le codage, où ses modèles surpassent systématiquement de plusieurs points les modèles de base les plus performants. Les modèles de Meta 13B paramètres résoudraient ainsi 12 % de problèmes en plus sur HumanEval et 17 % de plus sur MBPP que les modèles comparables de type next-token. "Des expériences sur de petites tâches algorithmiques démontrent que la prédiction multi-token est plus performante", précise aussi Meta. "En outre, les modèles formés avec la prédiction à 4 traits sont jusqu'à 3 fois plus rapides pour l'inférence, même avec des lots de grande taille."

Pour permettre aux chercheurs de poursuivre leur exploration, le groupe a publié sur HuggingFace des modèles pré-entraînés pour la complétion de code en utilisant cette approche. Ces modèles à 7 milliards de paramètres sont les suivants : modèle de base (n=1) entraîné sur 200B tokens de code (7B_200B_1/), modèle de prédiction multi-tokens (n=4) entraîné sur 200B tokens de code (7B_200B_4/), modèle de base (n=1) entraîné sur 1T tokens de code (7B_1T_1/), et modèle de prédiction multi-tokens (n=4) entraîné sur 1T tokens de code (7B_1T_4/).

Commentaire