Il vous reste 94% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

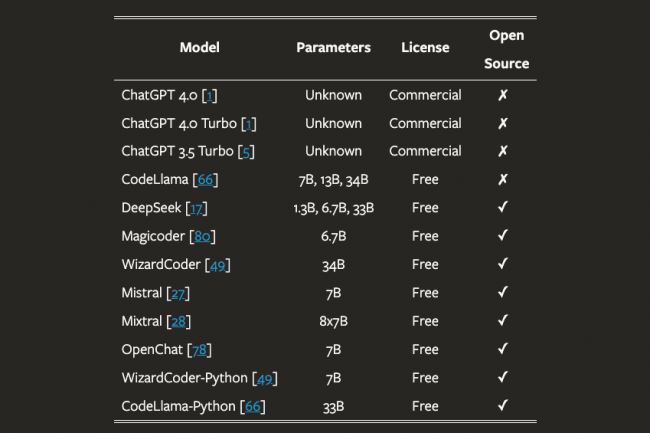

D'après la première étude importante sur l'hallucination de paquets, les LLM pourraient être exploités pour lancer des vagues d'attaques par « confusion de paquets ».

Il vous reste 94% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire