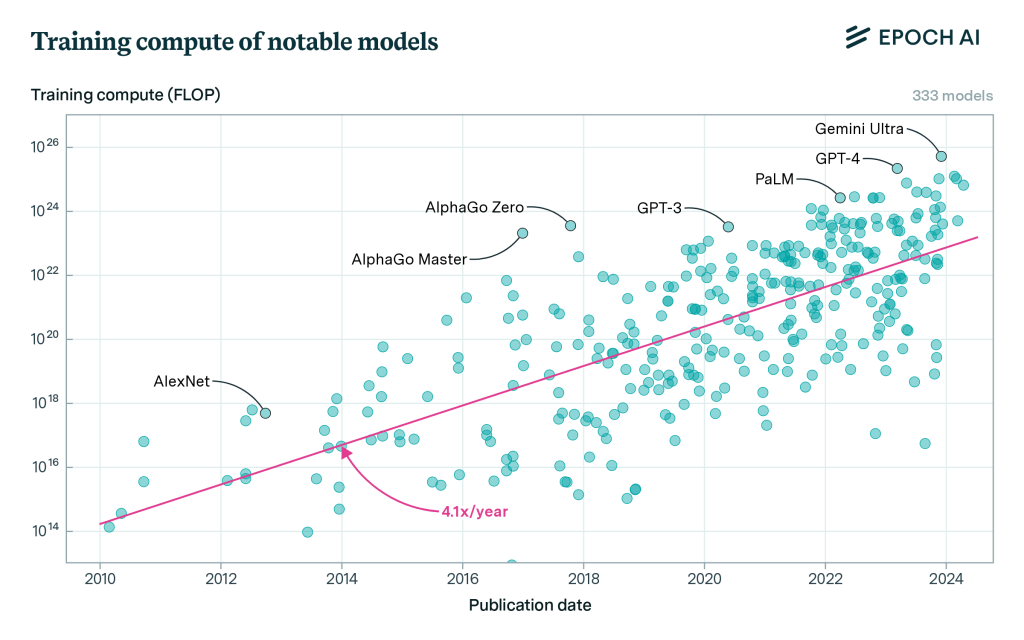

Le constat est sans appel, l’IA est devenu un gouffre énergétique. Une étude menée par l’AIE (agence internationale de l’énergie) montre ce dérapage en constatant que le besoin en électricité des datacenters équivaudrait à celui de l’ensemble du Japon, soit plus de 1 000 TWh d’ici 2026. Une analyse faite par Epoch AI observe par ailleurs que la capacité de calcul nécessaire pour alimenter les LLM a été augmenté par 4 à 5 par an depuis 2010. Ainsi pour entraîner Gemini Ultra de Google, le besoin en calcul frôle les 10 puissance 28 Flops.

Le besoin en capacité de calcul selon les LLM au fil du temps. (Crédit Photo: Epoch)

Selon le Forum économique mondial, la puissance de calcul nécessaire pour soutenir l'essor de l'IA double environ tous les 100 jours. À ce rythme, il est urgent de trouver un équilibre entre la progression de l'IA et les impératifs de durabilité. « L'empreinte environnementale de ces progrès est souvent négligée », a déclaré le think tank. Par exemple, pour décupler l'efficacité des modèles d'IA, la demande en puissance de calcul pourrait être multipliée par 10 000. L'énergie nécessaire à l'exécution des tâches d'IA s'accélère déjà, avec un taux de croissance annuel compris entre 26 % et 36 %. « Cela signifie que d'ici 2028, l'IA pourrait consommer plus d'énergie que l'Islande tout entière en 2021 », a déclaré le forum. Une course frénétique mêlant performance et besoin énergétique s’est donc engagée où les acteurs de l’IA comme AWS, Microsoft et Google cherchent des fournisseurs d’électricité pour répondre à leurs besoins. Ils s’intéressent de très près aux centrales nucléaires et ont accueilli favorablement l’annonce de la Maison Blanche de soutenir le développement de nouvelles centrales nucléaires.

Un intérêt croissant pour le nucléaire

Selon des sources citées par le Wall Street Journal, un tiers des producteurs d'électricité américains exploitant des centrales nucléaires sont en pourparlers avec des entreprises IT pour fournir de l'électricité aux récents datacenter dédiés à l’IA. Par exemple, Amazon Web Services devrait conclure un accord avec Constellation Energy pour fournir directement au fournisseur de cloud de l'électricité provenant de centrales nucléaires. Une filiale d'Amazon a également dépensé 650 millions de dollars pour acheter un datacenter alimenté par l'énergie nucléaire à Talen Energy en Pennsylvanie, et prévoit de construire 15 centres de données sur son campus qui seront alimentés par cette énergie, selon The Citizen's Voice. Des négociations nécessaires, car la construction de centrales nucléaires demande plusieurs années.

Pour Jack Gold, analyste chez J. Gold Associates, la pression sur la demande en électricité va augmenter les tarifs, mais ce sont les utilisateurs qui vont payer cette hausse. « Oui, AWS paie un milliard de dollars par an en factures d'électricité, mais ses clients lui paient 2 milliards de dollars par an. C'est ainsi que fonctionne le commerce », observe l’analyste. Il souligne aussi l’importance des projets de SMR (petit réacteur nucléaire) et notamment celui de Bill Gates et la start-up TerraPower. David Crane, sous-secrétaire à l'infrastructure de l'Office of Clean Energy du ministère américain de l'Energie, s'est dit « très optimiste » quant aux conceptions émergentes des petits réacteurs modulaires, selon Bloomberg.

Une énergie bonne pour les objectifs de bilan carbone

Cette orientation vers le nucléaire répond aussi à un autre objectif pour les acteurs de l’IA, réduire leur empreinte carbone et atteindre leurs objectifs environnementales. Amazon a déclaré avoir résolument misé sur les énergies renouvelables pour son avenir et s'est fixé pour objectif d'atteindre des émissions nettes de carbone nulles d'ici 2040, soit dix ans avant l'Accord de Paris. L'entreprise, qui est le plus grand acheteur d'énergie renouvelable au monde, espère que toute l'électricité consommée dans le cadre de ses activités proviendra à 100 % d'énergies renouvelables d'ici à 2025. Elle a déjà atteint 90 %, selon un porte-parole. Ce dernier a indiqué à nos confrères de Computerworld, « il n'y a pas de solution unique lorsqu'il s'agit de passer à une énergie décarbonée, et nous pensons que toutes les options viables et évolutives doivent être envisagées, y compris le nucléaire ».

De son côté Microsoft et Google ont la même réflexion après la publication de leur récent rapport sur leur bilan carbone. La firme de Redmond a vu ses émissions de CO² déraper de près de 30% en 2023 par rapport à 2022. Elles proviennent en grande partie de la construction et de l'approvisionnement de datacenters pour répondre à la demande des clients en matière de services cloud, mais aussi anticiper les besoins en IA. Constat similaire chez Google où en 2023, les émissions carbone ont progressé de 13% par rapport à 2022, à 14,3 millions de tonnes d'équivalent CO². Depuis 2019, elles ont bondi de 48%. Cette tendance s'explique d'abord « par la croissance de la consommation d'énergie dans les datacenters et par les émissions de la chaîne d'approvisionnement », selon la firme de Mountain View.

L’avenir des IA passe par des SLM pas des LLM

Pour contenir la demande en électricité, les fournisseurs IT devront se tourner vers des modèles plus petits et plus orientés vers les secteurs d’activité. Les entreprises prévoient d'investir 10 à 15 % de plus dans les initiatives d'IA au cours des 18 prochains mois par rapport à l'année civile 2022, selon une enquête IDC menée auprès de plus de 2 000 décideurs informatiques et commerciaux. Toujours dans l’enquête, 66% des entreprises du monde entier ont déclaré qu'elles investiraient dans la GenAI au cours des 18 prochains mois. Parmi les organisations indiquant que la GenAI entraînera une augmentation des dépenses informatiques en 2024, l'infrastructure interne représentera 46 % des dépenses totales. Le problème : un élément clef du matériel nécessaire pour construire cette infrastructure d'IA – les GPU- est en pénurie.

Les LLM comportant des centaines de milliards, voire des milliers de milliards de paramètres, dévorent les cycles de calcul plus rapidement que les accélérateurs qu'ils requièrent ne peuvent être fabriquées ou mises à l'échelle ; cela peut peser sur la capacité des serveurs et entraîner un délai irréaliste pour former les modèles à une utilisation commerciale particulière. « Tôt ou tard, la mise à l'échelle des accélérateurs GPU ne parviendra pas à suivre l'augmentation de la taille des modèles » a déclaré Avivah Litan, vice-présidente et analyste chez Gartner Research. « Continuer à fabriquer des modèles de plus en plus grands n'est donc pas une option viable », selon lui. La solution consistera probablement à réduire la taille des LLM et à utiliser les informations exclusives des entreprises qui souhaitent tirer parti de la capacité de l'IA à automatiser des tâches et à analyser des ensembles de données volumineux afin de produire des informations utiles.

Commentaire