Selon une étude de Sysdig, le marché noir de l'accès aux grands modèles de langage (LLM) se développe. Dans ce que l’on appelle désormais le LLMjacking, les attaquants abusent d’identifiants volés pour interroger des services de requête d'IA tels qu'Amazon Bedrock. D’après les requêtes API observées par Sysdig, il semble que les acteurs de la menace interrogent non seulement les LLM que les propriétaires de comptes ont déjà déployés sur ces plateformes, mais qu’ils tentent également d'en activer de nouveaux, ce qui pourrait rapidement faire grimper les coûts pour les victimes. « Le LLMjacking lui-même est en hausse : au cours du mois de juillet, les requêtes LLM ont été multipliées par 10 et au cours du premier semestre 2024, le nombre d'adresses IP uniques engagées dans ces attaques a été multiplié par 2 », ont déclaré les chercheurs de l'entreprise de sécurité dans un rapport. « Avec la progression continue du développement de LLM, le premier coût potentiel pour les victimes est monétaire : par exemple, l'utilisation de modèles de pointe comme Claude 3 Opus peut quasiment tripler le coût à hauteur de 100 000 $ par jour. »

C’est pour profiter des jeux de rôle, générer des scripts, analyser des images et utiliser des invites textuelles sans payer et sans les limites normales imposées par les services gratuits que les attaquants souhaitent accéder aux LLM. Sysdig a trouvé des preuves que, dans certains cas au moins, les utilisateurs qui se livrent au LLMjacking sont basés en Russie, où les sanctions occidentales ont imposé des limites sévères à l'accès aux chatbots LLM et aux services fournis par des entreprises occidentales. « La principale langue utilisée dans les invites est l'anglais (80 %), la deuxième, le coréen (10 %), le reste étant le russe, le roumain, l'allemand, l'espagnol et le japonais », ont indiqué les chercheurs.

Des API Bedrock abusées

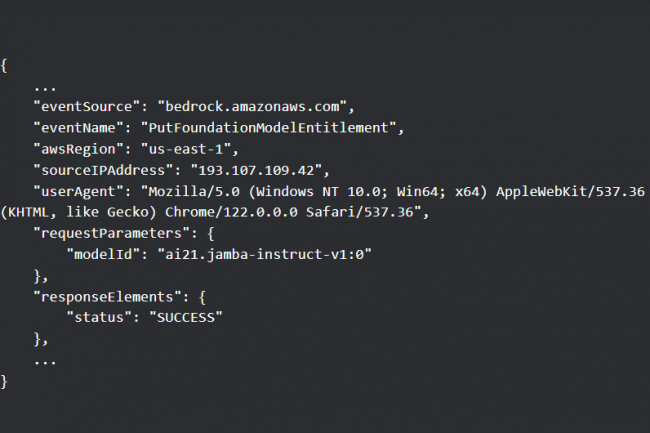

Le service Amazon Bedrock d’AWS permet aux entreprises de déployer et d'utiliser facilement les LLM de plusieurs fournisseurs d'IA, de les enrichir de leurs propres ensembles de données et de créer des agents et des applications autour d'eux. Le service prend en charge une longue liste d'actions API pour gérer les modèles et d'interagir avec eux par programmation. Les actions API les plus courantes appelées par les attaquants via des informations d'identification compromises au début de cette année comprenaient InvokeModel, InvokeModelStream, Converse et ConverseStream. Mais récemment, les chercheurs ont aussi vu que des attaquants abusaient de PutFoundationModelEntitlement et de PutUseCaseForModelAccess, utilisées pour activer des modèles, ainsi que ListFoundationModels et GetFoundationModelAvailability, afin de détecter à l'avance les modèles auxquels un compte a accès. Cela signifie que les entreprises qui ont déployé Bedrock sans activer certains modèles ne sont pas à l'abri.

L’écart de coût entre les différents modèles peut être substantiel. Par exemple, pour l'utilisation d'un modèle Claude 2.x, les chercheurs ont estimé le coût potentiel à plus de 46 000 $ par jour, mais pour des modèles tels que Claude 3 Opus, le coût pourrait être deux à trois fois plus élevé. Les chercheurs ont vu des attaquants utiliser Claude 3 pour générer et améliorer le code d'un script destiné à interroger le modèle en premier lieu. Le script a pour objectif d’interagir en permanence avec le modèle, en générant des réponses, en surveillant un contenu spécifique et en enregistrant les résultats dans des fichiers texte. « La désactivation des modèles dans Bedrock et l'exigence d'activation ne doivent pas être considérées comme une mesure de sécurité », ont mis en garde les chercheurs. « Les attaquants peuvent les activer à la place de l’utilisateur et le feront pour atteindre leurs objectifs ». C’est ce qui se passe par exemple avec l'API Converse, annoncée en mai, qui simplifie l’interaction des utilisateurs avec les modèles Amazon Bedrock. Selon Sysdig, les attaquants ont commencé à abuser de l'API dans les 30 jours qui ont suivi sa publication. Ils précisent par ailleurs que les actions Converse API n'apparaissent pas automatiquement dans les journaux CloudTrail, contrairement aux actions InvokeModel.

La sécurisation des identifiants et des jetons LLM en guise d’atténuation

Même si la journalisation est activée, les attaquants malins essaieront de la désactiver en appelant DeleteModelInvocationLoggingConfiguration, qui désactive la journalisation des invocations pour CloudWatch et S3. Dans d'autres cas, ils vérifieront l'état de la journalisation et éviteront d'utiliser des informations d'identification volées afin de dissimuler leur activité. Souvent, les attaquants n'appellent pas directement les modèles Bedrock d'Amazon, mais utilisent des services et des outils tiers. C'est le cas par exemple de SillyTavern, une application frontale pour interagir avec les LLM qui demande aux utilisateurs de fournir leurs propres identifiants à un service LLM de leur choix ou à un service proxy. « Compte tenu du coût important, tout un marché et un écosystème se sont développés autour de l'accès aux LLM », avertissent les chercheurs. « Les informations d'identification sont obtenues de différentes manières : paiement, essais gratuits ou vol. Comme cet accès est une denrée précieuse, des serveurs proxy inversés sont utilisés pour garder les informations d'identification en lieu sûr et sous contrôle. »

Les entreprises doivent prendre des mesures pour s'assurer que leurs identifiants et jetons AWS ne sont pas divulgués dans des référentiels de code, des fichiers de configuration et ailleurs. Elles doivent également appliquer le principe du moindre privilège en limitant les jetons à la tâche pour laquelle ils ont été créés. « Les entreprises doivent évaluer en permanence leur cloud par rapport aux contrôles de posture des meilleures pratiques, telles que la norme AWS Foundational Security Best Practices », ont recommandé les chercheurs de Sysdig. « Elles doivent surveiller leur cloud pour détecter les informations d'identification potentiellement compromises, les activités inhabituelles, l’usage inattendu de LLM et les indicateurs de menaces actives ciblant l’IA. »

Commentaire