Aujourd'hui, nombreuses sont les entreprises qui considèrent l'intelligence artificielle comme l'avenir, et nombreux sont les dirigeants considérant que ChatGPT est synonyme d'IA. Mais le projet phare d'OpenAI est loin d'être le seul grand modèle de langage et, pour certains projets logiciels ou domaines, il n'est peut-être même pas le meilleur choix. Des concurrents apparaissent presque quotidiennement. Il semble que tout le monde veuille construire la prochaine génération d'outils d'IA qui libéreront la Terre ou la détruiront, selon la personne qui parle. Certains modèles sont-ils meilleurs que d'autres ? Peut-être. Ils ont tous des défauts, des bizarreries, des pépins et des faiblesses qui deviennent de plus en plus évidents au fur et à mesure que l'on s'en sert. L'IA générative semble étonnante à première vue, mais avec le temps, son côté étrange et imprévisible commence à émerger.

Il est difficile de mesurer scientifiquement la qualité des réponses de l'IA générative en raison de la portée des modèles et de la manière dont ils sont utilisés. Un data scientist pourrait introduire des milliers, voire des millions de questions de test et évaluer les réponses, mais les résultats seront limités si les ensembles de tests se concentrent sur un seul type de question. La consultation d'une ressource telle que Hugging Face's Open LLM Leaderboard est intéressante mais pas nécessairement exacte. S'il est difficile de trouver un moyen précis de comparer les LLM, il est au moins plus facile de passer de l'un à l'autre. Certains projets comme OpenLLM ou FastChat simplifient par exemple le câblage de divers modèles malgré leurs différentes API et interfaces.

Un modèle de rentabilité encore trop flou

La grande question qui se pose en arrière-plan est celle du coût. Alors que tout le monde se réjouit de l'explosion de l'intérêt et des investissements, la construction d'un grand modèle linguistique peut prendre des mois, voire des années. Les équipes rassemblent d'abord les données d'entraînement, puis les font passer par du matériel coûteux qui consomme de l'électricité. Enfin, elles produisent le modèle. La meilleure façon de monétiser et de soutenir ce travail est une question qui évolue.

Certaines entreprises expérimentent le libre accès à leurs résultats, tandis que d'autres s'en remettent volontiers à des services dotés de leurs propres modèles de facturation. Les LLM open source peuvent être un véritable cadeau, mais seulement si vous êtes en mesure de gérer le travail de déploiement du modèle et de le faire fonctionner. En ce sens, nous avons dressé un aperçu de 14 grands modèles de langage qui ne sont pas GPT. Ils peuvent ou non correspondre aux besoins de tel projet d’entreprise. La seule façon de le savoir est d’envoyer des messages et d'évaluer soigneusement les résultats.

AgentGPT

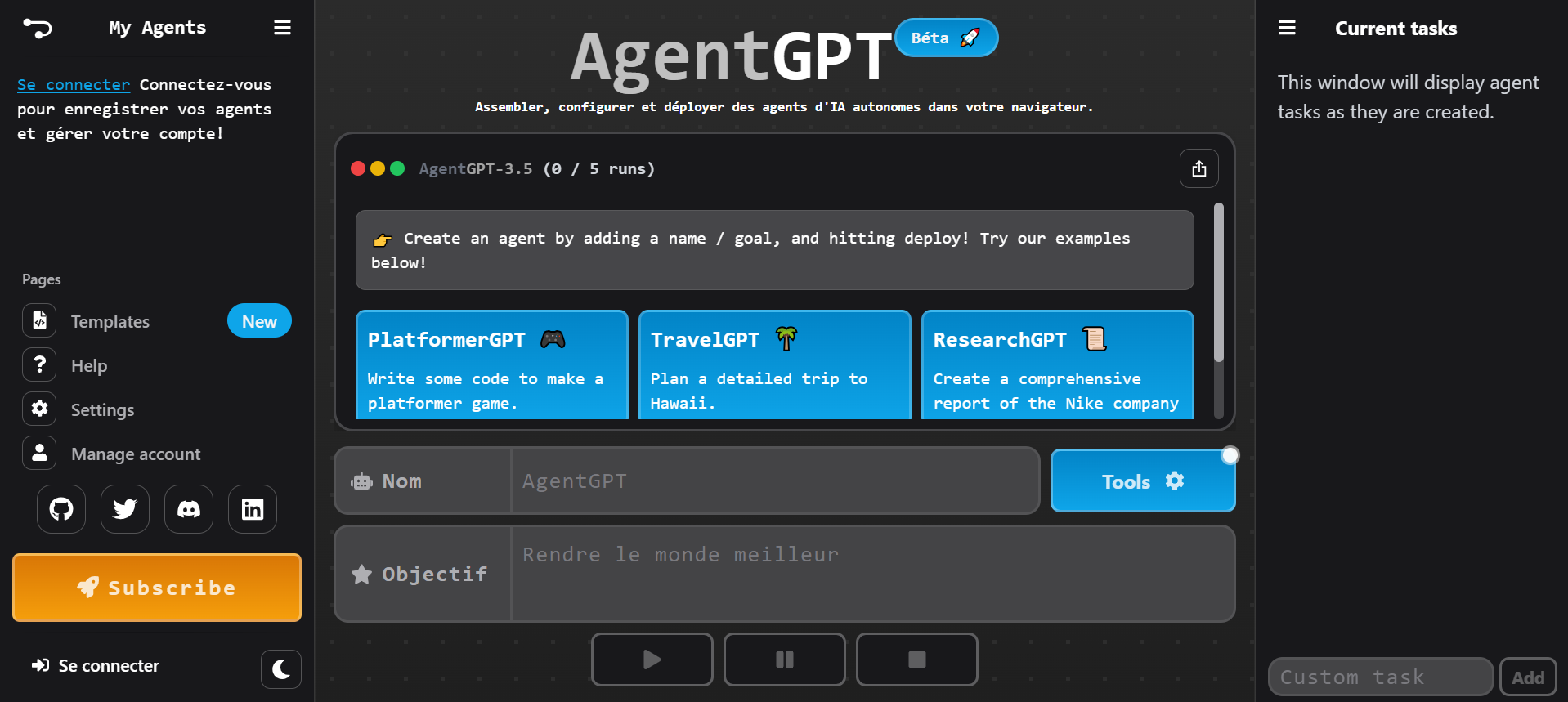

L’un des outils existants pour rassembler tout le code nécessaire à une application est AgentGPT. Il est conçu pour créer des agents qui peuvent être envoyés pour effectuer des tâches telles que planifier des vacances ou écrire le code d'un type de jeu, d’où son nom « Agent ». AgentGPT est construit en utilisant Next.js avec la pile T3DotGG, LangChainAI et GPT-3. Il s’inspire des idées de BabyAGI de Yohei Nakajima et d’AutoGPT de SigGravitas. Le code source d'une grande partie de la pile technologique est disponible sous licence GPL 3.0. Une version en cours d'exécution est également disponible en tant que service.

AgentGPT est disponible en bêta. (Crédit : AgentGPT)

Alpaca

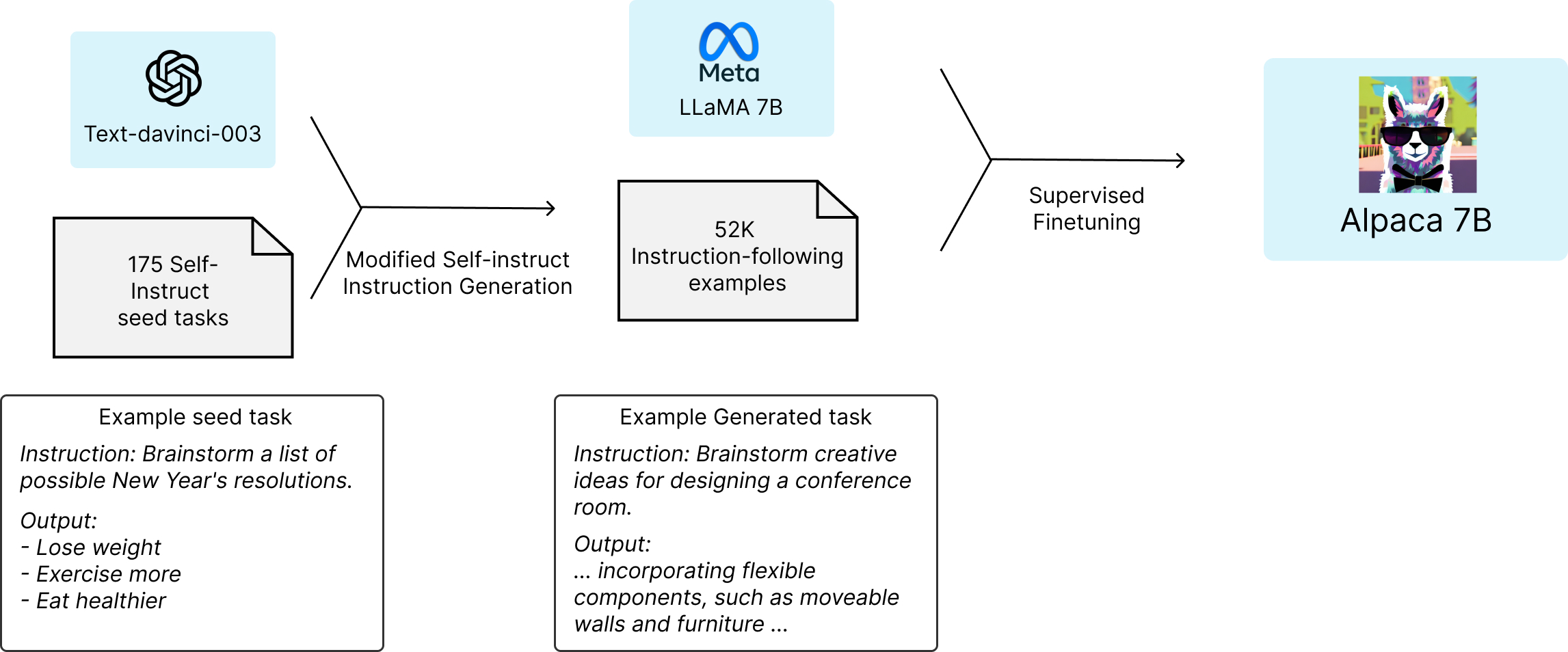

Plusieurs chercheurs de Stanford ont pris le Llama 7B de Meta et l'ont entraîné sur un ensemble d'invites qui imitent les modèles de suivi d'instructions comme ChatGPT. Cette mise au point a donné naissance à Alpaca 7B, un LLM qui ouvre les connaissances encodées dans le LLM Llama à une personne ordinaire qui peut y accéder en posant des questions et en donnant des instructions. Selon certaines estimations, ce LLM léger pourrait fonctionner avec moins de 600 dollars de matériel. Les créateurs d'Alpaca 7B distribuent l'ensemble d'entraînement et le code qui l'a construit. N'importe qui peut reproduire le modèle ou créer quelque chose de nouveau à partir d'un ensemble différent.

Alpaca 7B ouvre les connaissances encodées dans le LLM Llama. (Crédit : Alpaca)

Cerebras

Lorsque du matériel spécialisé et un modèle général évoluent ensemble, on peut obtenir une solution très rapide et efficace. Cerebras propose son LLM sur Hugging Face dans une variété de tailles allant de la plus petite (111 millions de paramètres) à la plus grande (13 milliards de paramètres) pour ceux qui veulent l'exécuter localement. Cependant, nombreux sont ceux qui voudront utiliser les services cloud, qui fonctionnent sur les propres processeurs intégrés de Cerebras, optimisés pour l'analyse de grands ensembles d'apprentissage.

Claude

Anthropic a créé Claude pour être un assistant utile qui peut prendre en charge de nombreuses tâches textuelles d'une entreprise, de la recherche au service à la clientèle. L'utilisateur reçoit un message et obtient une réponse. Anthropic a délibérément prévu des messages longs pour encourager des instructions plus complexes, ce qui permet aux utilisateurs de mieux contrôler les résultats. Anthropic propose actuellement deux versions : le modèle complet, appelé Claude-v1, et une version simplifiée, appelée Claude Instant, qui est nettement moins chère. La première version est destinée aux tâches nécessitant un raisonnement plus complexe et structuré, tandis que la seconde est plus rapide et mieux adaptée aux tâches simples telles que la classification et la modération.

Falcon

Le Falcon-40b de grande taille et le Falcon-7b plus petit ont été construits par le Technology Innovation Institute (TII) aux Émirats arabes unis. Les équipes ont entraîné le modèle Falcon sur un vaste ensemble d'exemples généraux tirés du RefinedWeb, en se concentrant sur l'amélioration de l'inférence. Ils ont ensuite fait volte-face et l'ont publié sous Apache 2.0, ce qui en fait l'un des modèles les plus ouverts et les plus libres disponibles pour l'expérimentation.

FrugalGPT

Il ne s'agit pas d'un modèle différent, mais plutôt d'une stratégie prudente visant à trouver le modèle le moins cher possible pour répondre à une question particulière. Les chercheurs qui ont développé FrugalGPT ont reconnu que de nombreuses questions ne nécessitent pas le modèle le plus grand et le plus cher. Leur algorithme commence par le plus simple et remonte une liste de LLM en cascade jusqu'à ce qu'il trouve une bonne réponse. Les expériences du chercheur suggèrent que cette approche prudente peut permettre d'économiser 98 % du coût, car de nombreuses questions n'ont pas besoin d'un modèle sophistiqué.

Gorilla

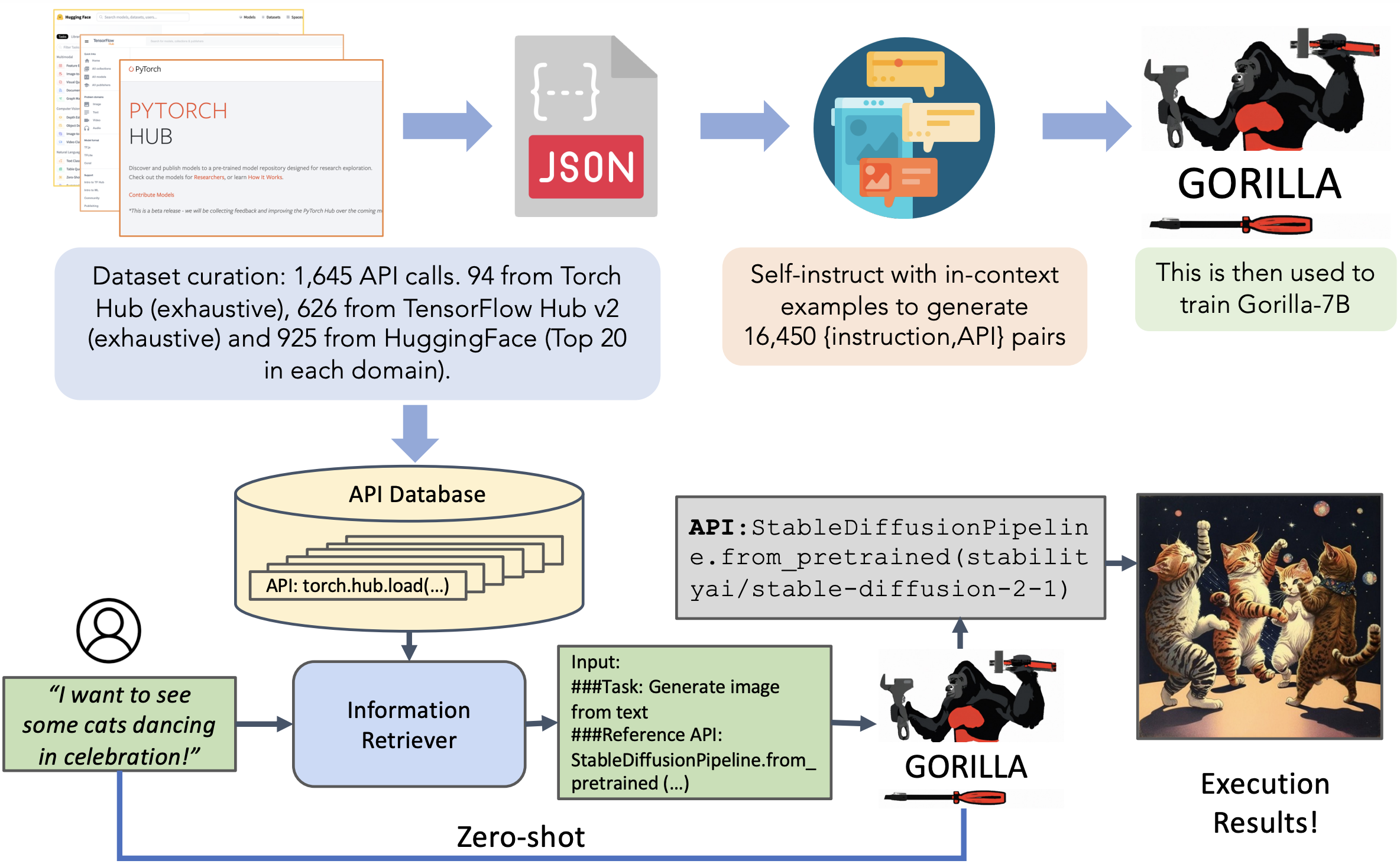

Vous avez probablement beaucoup entendu parler de l'utilisation de l'IA générative pour écrire du code. Les résultats sont souvent impressionnants en apparence, mais profondément erronés lorsqu'on y regarde de plus près. La syntaxe peut être correcte, mais les appels à l'API sont tous erronés, ou ils peuvent même être dirigés vers une fonction qui n'existe pas. Gorilla est un LLM conçu pour améliorer les interfaces de programmation. Ses créateurs ont commencé avec Llama et l'ont ensuite affiné en se concentrant sur des détails de programmation plus profonds tirés directement de la documentation. L'équipe de Gorilla propose également son propre ensemble de critères de référence centrés sur l'API pour tester la réussite. Il s'agit d'un ajout important pour les programmeurs qui cherchent à s'appuyer sur les IA pour l'assistance au codage.

Gorilla est un LLM qui peut fournir des appels d'API appropriés. Il est formé sur trois énormes ensembles de données de hub d'apprentissage automatique : Torch Hub, TensorFlow Hub et HuggingFace. Nous ajoutons rapidement de nouveaux domaines, notamment Kubernetes, GCP, AWS, OpenAPI, etc. Zero-shot Gorilla surpasse GPT-4, Chat-GPT et Claude. Gorilla est extrêmement fiable et réduit considérablement les erreurs d'hallucination. (Crédit : Gorilla)

ImageBind

Meta est souvent considéré comme une grande entreprise qui domine les réseaux sociaux, mais c'est aussi une force puissante dans le développement de logiciels open source. Maintenant que l'intérêt pour l'IA est en plein essor, il n'est pas surprenant que l'entreprise commence à partager un grand nombre de ses propres innovations. ImageBind est un projet qui vise à montrer comment l'IA peut créer plusieurs types de données à la fois, en l'occurrence du texte, de l'audio et de la vidéo. En d'autres termes, l'IA générative peut assembler tout un monde imaginaire, si vous la laissez faire.

Avec ImageBind, il est possible de créer différents types de fichiers en même temps à partir d'une image ou d'une vidéo. (Crédit : Meta)

Jasper

Les créateurs de Jasper ne voulaient pas construire un sage généraliste, mais une machine spécialisée dans la création de contenu. Au lieu d'une simple session de chat ouverte, le système propose plus de 50 modèles conçus pour des tâches particulières, comme la rédaction d'une annonce immobilière ou de caractéristiques de produits pour un site tel qu'Amazon. Les versions payantes s'adressent plus particulièrement aux entreprises qui souhaitent créer des textes marketing avec un ton cohérent.

Llama

Facebook (aujourd'hui Meta) a créé ce LLM fondamental et l'a publié dans le cadre de son « engagement en faveur de la science ouverte ». N'importe qui peut télécharger Llama et l'utiliser comme base pour créer des modèles plus fins pour des applications particulières (Alpaca et Vicuna ont tous deux été créés à partir de Llama). (Alpaca et Vicuna ont tous deux été construits à partir de Llama.) Le modèle est également disponible en quatre tailles différentes. Les versions les plus petites, avec seulement 7 milliards de paramètres, sont déjà utilisées dans des endroits improbables. À noter que, depuis le 19 juillet dernier, la seconde version de Llama est disponible.

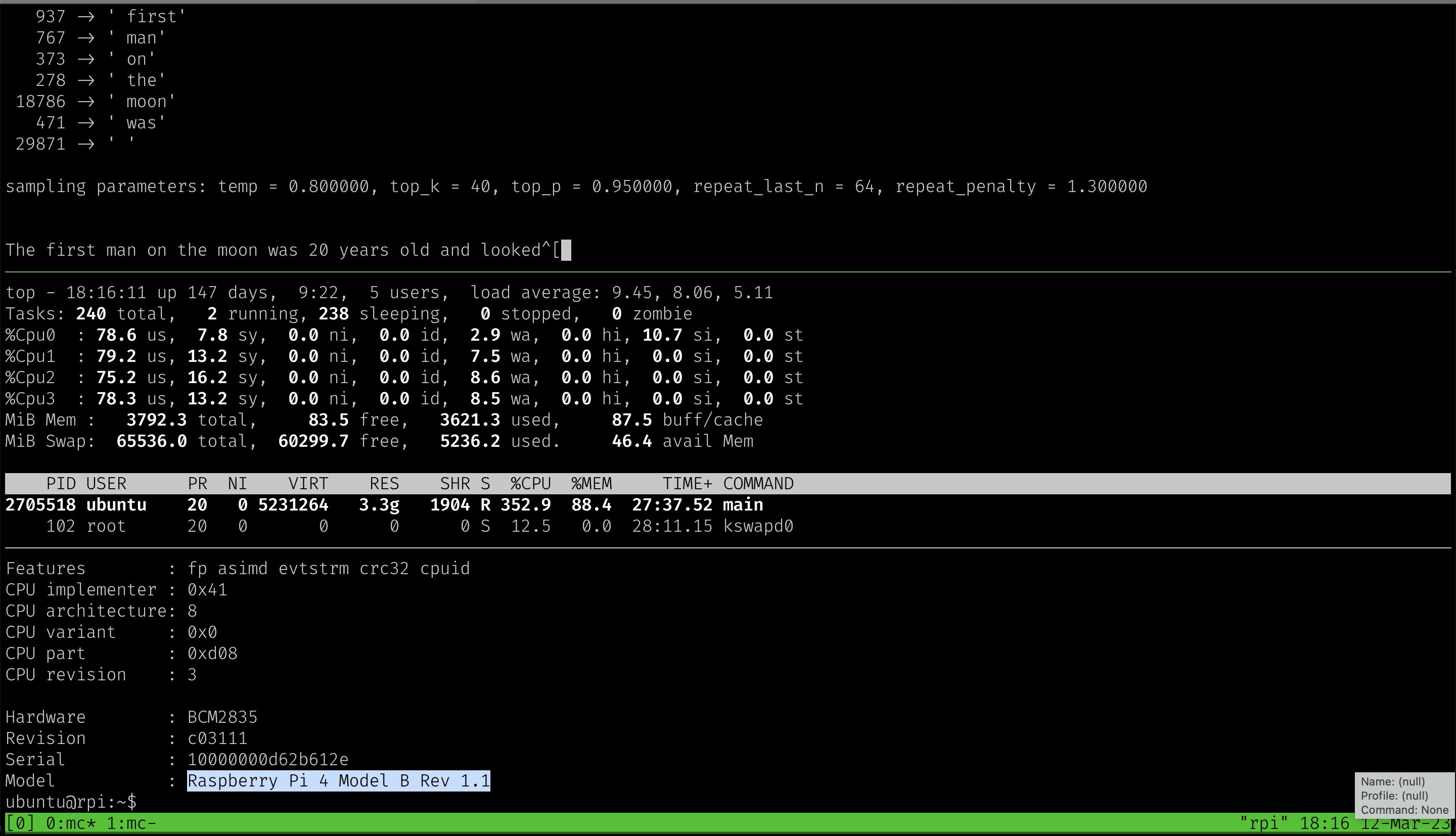

Un développeur affirme même que Llama fonctionne sur un Raspberry Pi, avec seulement 4 Go de RAM. (Crédit : Artem Andreenko/Twitter)

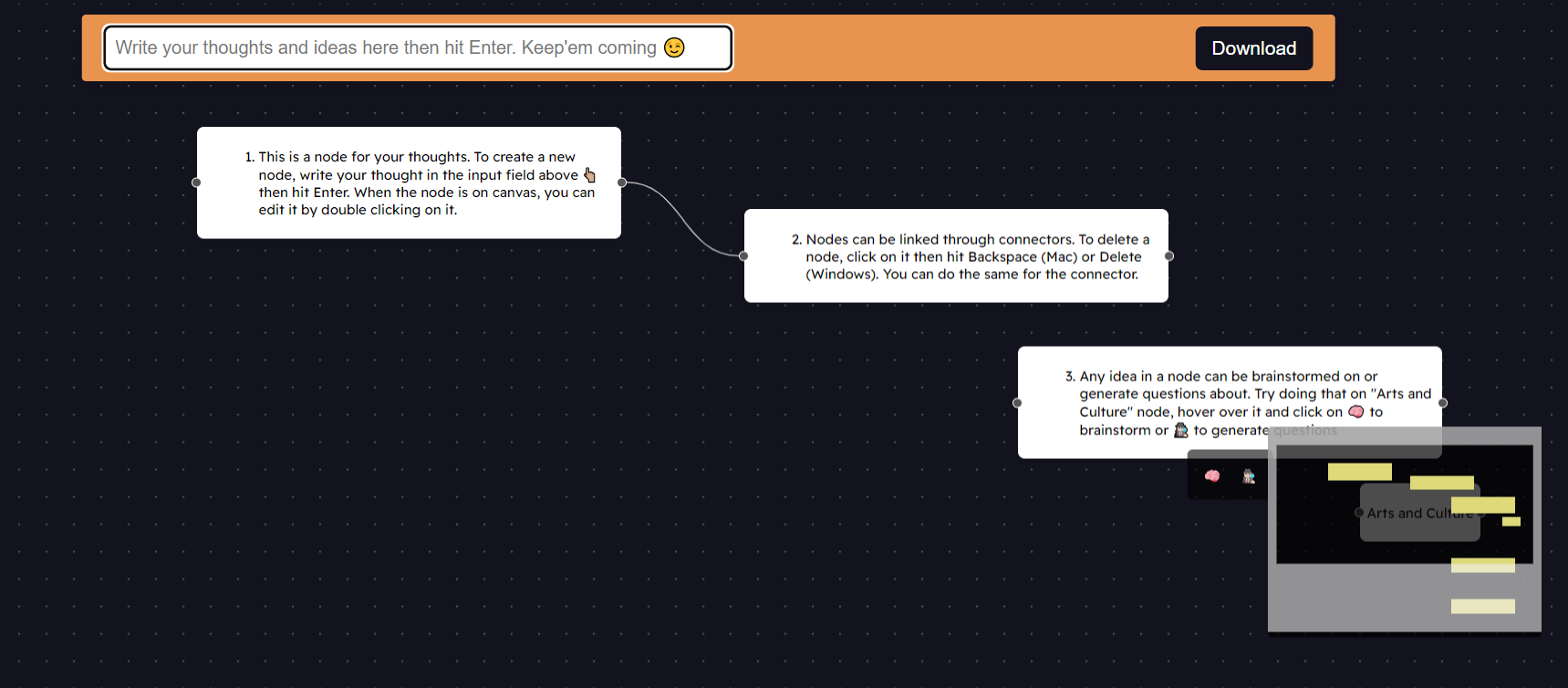

NodePad

Tout le monde n'est pas enthousiasmé par la manière dont les LLM génèrent des textes « linguistiquement exacts ». Les créateurs de NodePad estiment que la qualité du texte tend à détourner les utilisateurs de la double vérification des faits sous-jacents. Les LLM dotés d'une belle interface utilisateur « ont tendance à glorifier involontairement le résultat, ce qui rend plus difficile pour les utilisateurs d'anticiper ces problèmes ». NodePad est conçu pour favoriser l'exploration et l'idéation sans produire d'échantillons d'écriture polis que les utilisateurs ne feront qu'effleurer. Les résultats de ce LLM apparaissent sous forme de nœuds et de connexions, comme dans de nombreux « outils de cartographie mentale », et non comme des écrits finis. Les utilisateurs peuvent puiser dans les connaissances encyclopédiques du modèle pour trouver de grandes idées sans se perdre dans la présentation.

NodePad, un canevas simple pour explorer des idées prises en charge par l'IA. (Crédit : Nodepad)

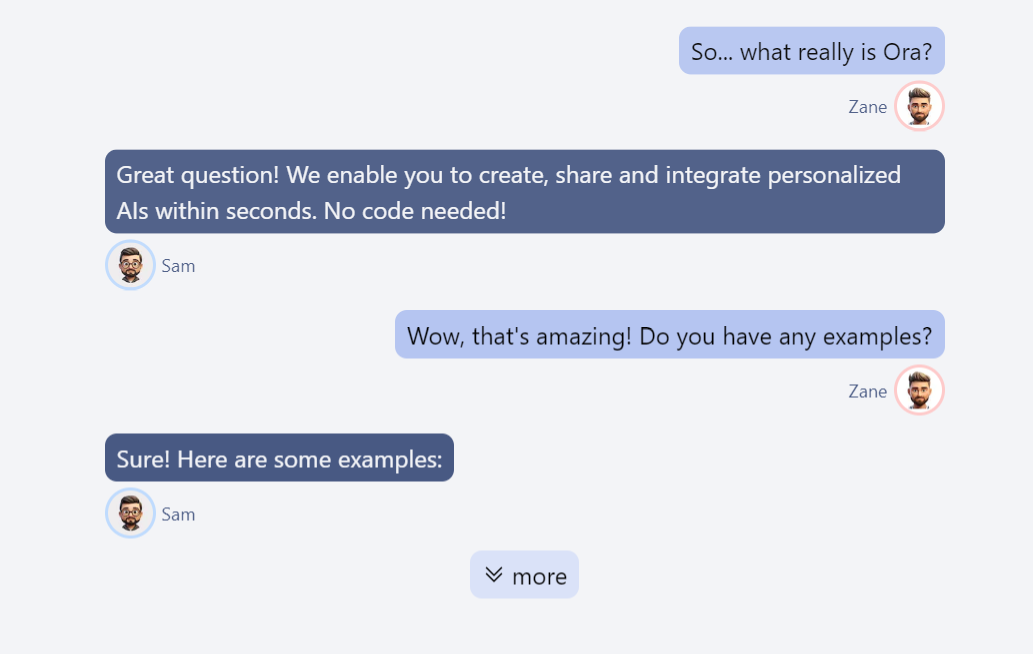

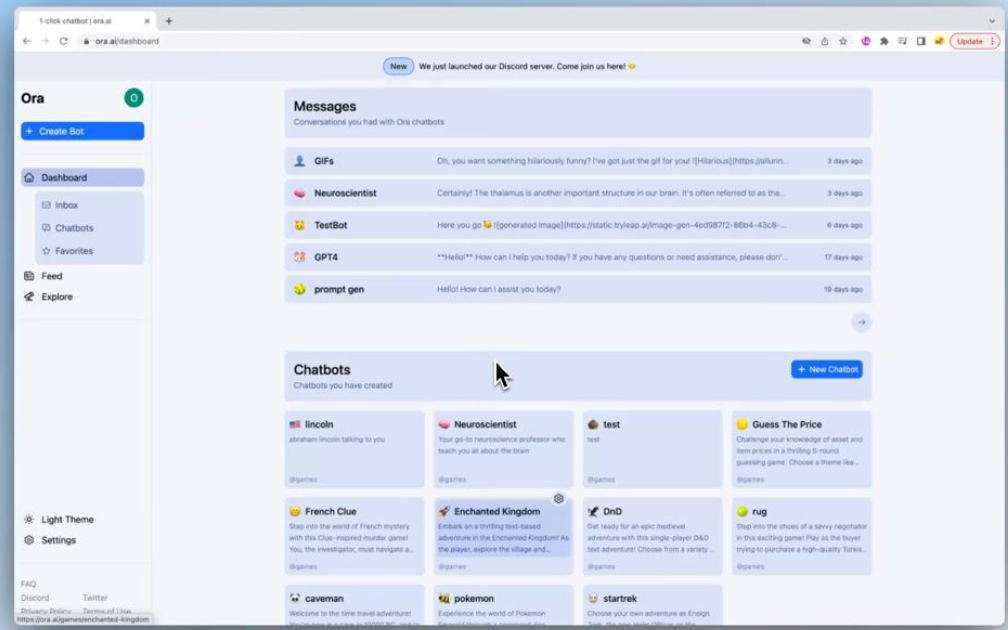

Ora.ai

Ora est un système qui permet aux utilisateurs de créer leurs propres chatbots ciblés, optimisés pour une tâche particulière. LibrarianGPT s'efforce de répondre à toute question par un passage direct d'un livre. Le professeur Carl Sagan, par exemple, est un bot qui puise dans tous les écrits de Sagan afin qu'il puisse vivre pendant des milliards et des milliards d'années. Vous pouvez créer votre propre robot ou utiliser l'un des centaines de robots déjà créés par d'autres.

Ora propose de créer son propre chatbot en fonction de l'usage ou de choisir parmi les templates proposés. (Crédit : Ora)

Orca

La première génération de grands modèles de langage s'est imposée par sa taille, devenant de plus en plus grande au fil du temps. Orca, créé par une équipe de chercheurs de Microsoft, inverse cette tendance. Le modèle n'utilise que 13 milliards de paramètres, ce qui permet de l'exécuter sur des machines moyennes. Les développeurs d'Orca ont réussi cet exploit en améliorant l'algorithme de formation afin d'utiliser des "traces d'explication", des "processus de pensée étape par étape" et des "instructions". Au lieu de demander à l'IA d'apprendre à partir d'un matériau brut, Orca a reçu un ensemble de formation conçu pour enseigner. En d'autres termes, tout comme les humains, les IA apprennent plus vite lorsqu'elles ne sont pas jetées dans le grand bain. Les premiers résultats sont prometteurs et l'équipe de Microsoft a fourni des repères qui suggèrent que le modèle est aussi performant que des modèles beaucoup plus importants.

Vicuna

Vicuna de LMSYS.org est un autre descendant de Llama. L'équipe de Vicuna a rassemblé un ensemble d'entraînement de 70 000 conversations différentes à partir de ShareGPT et a accordé une attention particulière à la création d'interactions à plusieurs tours et aux capacités de suivi des instructions. Disponible en version Vicuna-13b ou Vicuna-7b, ce LLM est l'une des solutions ouvertes les plus compétitives en termes de prix pour un chat interactif de base.

Commentaire