Le grand bain pour Kyutai. C'est en effet ce 3 juillet que ce laboratoire de recherche à but non lucratif spécialisé dans le GenAI - fruit du rapprochement entre Iliad, CMA-CGM et Schmidt Futures annoncé le 17 novembre dernier - a dévoilé ses premiers travaux. En l'occurrence un prototype d'assistant vocal d'IA, baptisé Moshi (moshi moshi signifie allo en japonais) développé par une équipe de 8 chercheurs et reposant sur l'infrastructure cloud de Scaleway embarquant notamment une centaine d'accélérateurs GPU Nvidia. "Moshi est très prometteur et a un gros potentiel pour changer la façon de communiquer avec des machines et l'accessibilité pour des personnes ayant des handicaps", a lancé Patrick Pérez, CEO de Kyutai.

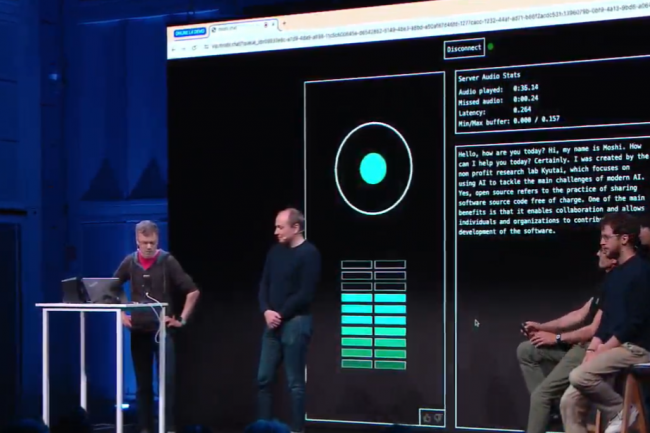

A l'occasion de cette annonce, une démonstration a été effectuée pour rendre compte des capacités de Moshi. Au-delà des performances de l'assistant pour engager, poursuivre et clôturer une conversation avec un humain, on notera quand même une impression assez troublante - voire dérangeante - de Moshi à couper la parole de son interlocuteur. Une caractéristique qui semble toutefois assumée : pour rendre plus crédible possible l'échange entre l'agent et un humain, de nombreux paramètres ont été intégrés comme la capacité à hésiter, à chuchoter, à parler avec un accent ou avec du ton... mais aussi à interrompre voire parler en même temps qu'un humain. En effet, des éléments paralinguistique ont été pris en compte (émotion, tonalité...) pour influencer et apporter une dynamique conversationnelle.

70 émotions et façons de parler supportées par Moshi

Dans le cadre de ses travaux, Kyutai a développé des capacités de traitements de pipeline de données multimodales et multistream, de speech to text et d'entrainement. Un grand volume et diversité de données ont ainsi été utilisées pour entrainer Moshi avec un LLM 7B (Helium). Des capacités de traitements et de génération audio pour apprendre à l'assistant à parler au bon moment et quoi dire ont aussi fait l'objet de paramétrages spécifiques (fine tuning). Du dialogue synthétique a été utilisé (pour le style oral) couplé à un moteur speech to text développé en interne sur lequel les modèles de données ont été entrainées. Concernant la voix en tant que telle, Kyutai a fait appel au service d'une artiste qui a nourri le modèle avec beaucoup de dialogues, pour un total de 70 émotions ou façons de parler (murmures, effroi, hésitations...). Un travail sur la latence a aussi été effectué pour atteindre 200 millisecondes, proche d'une conversation entre deux humains. Enfin un travail a aussi été fait concernant le code et le poids des modèles pour être capables de tourner en local, par exemple sur un Macbook Pro.

Kyutai prévoit par ailleurs de partager librement et gratuitement toute la connaissance, la documentation technique et les modèles ainsi que le code de son assistant vocal AI Moshi notamment à des fins de test et d'étude.

Commentaire