Toute la communauté cloud native s’est donnée rendez-vous à Porte de Versailles à Paris pour la tenue de la Kubecon. Organisée par la CNCF (cloud native computing foundation), cette édition européenne qui se tient dans la capitale en ce moment (20-23 mars) prévoit d’accueillir 12 000 personnes sur 3 jours. Priyanka Sharma, general manager de la CNCF a inauguré l’évènement avec un focus sur l’intelligence artificielle. « Nous construisons les infrastructures de demain », explique-t-elle en préambule tout en soulignant que Kubernetes, l’orchestrateur des clusters de conteneurs souffle cette année son dixième anniversaire (en juin prochain).

Elle relève les défis des entreprises face à l’IA aujourd’hui, « le prototypage est facile, mais la mise en production est compliquée. Par ailleurs, il y a beaucoup d’inquiétudes autour des coûts ». Selon elle, il faut éviter « une exubérance obsessionnelle », pour reprendre une célèbre phrase d’Alan Greenspan, ancien patron de la FED américaine. Pour cela, « il y a besoin de standardisation pour assurer l’interopérabilité, la sécurité, la gestion des coûts et des ressources, les métriques, les questions éthiques sur les traitements IA ». Et bien évidemment, la CNCF est le berceau idéal pour cela.

De fortes attentes sur l’optimisation des ressources

L’organisme s’est mis en ordre de marche avec plusieurs initiatives à commencer par un groupe de travail consacré à l’IA. Installé en octobre dernier, cette structure vient de publier un livre blanc recensant les défis et les solutions à l’état de l’art en matière d’IA. Et les challenges sont multiples comme le montre une table-ronde où intervenait notamment Timothée Lacroix, un des co-fondateurs de Mistral et Page Bailey, lead product manager chez Google Deepmind. Cette dernière a évoqué le problème d’allocation des ressources « avec des modèles de différentes tailles qui implique des infrastructures adaptées, mais aussi des librairies, des frameworks ». Sur ce point, le dirigeant français, privilégie « l’outil Slurm [NDLR : une solution open source qui décrit une demande d'allocation de ressources pour l'exécution d'un traitement] pour gérer l’allocation des nodes sur Kubernetes pour l’inférence et le fine tuning ».

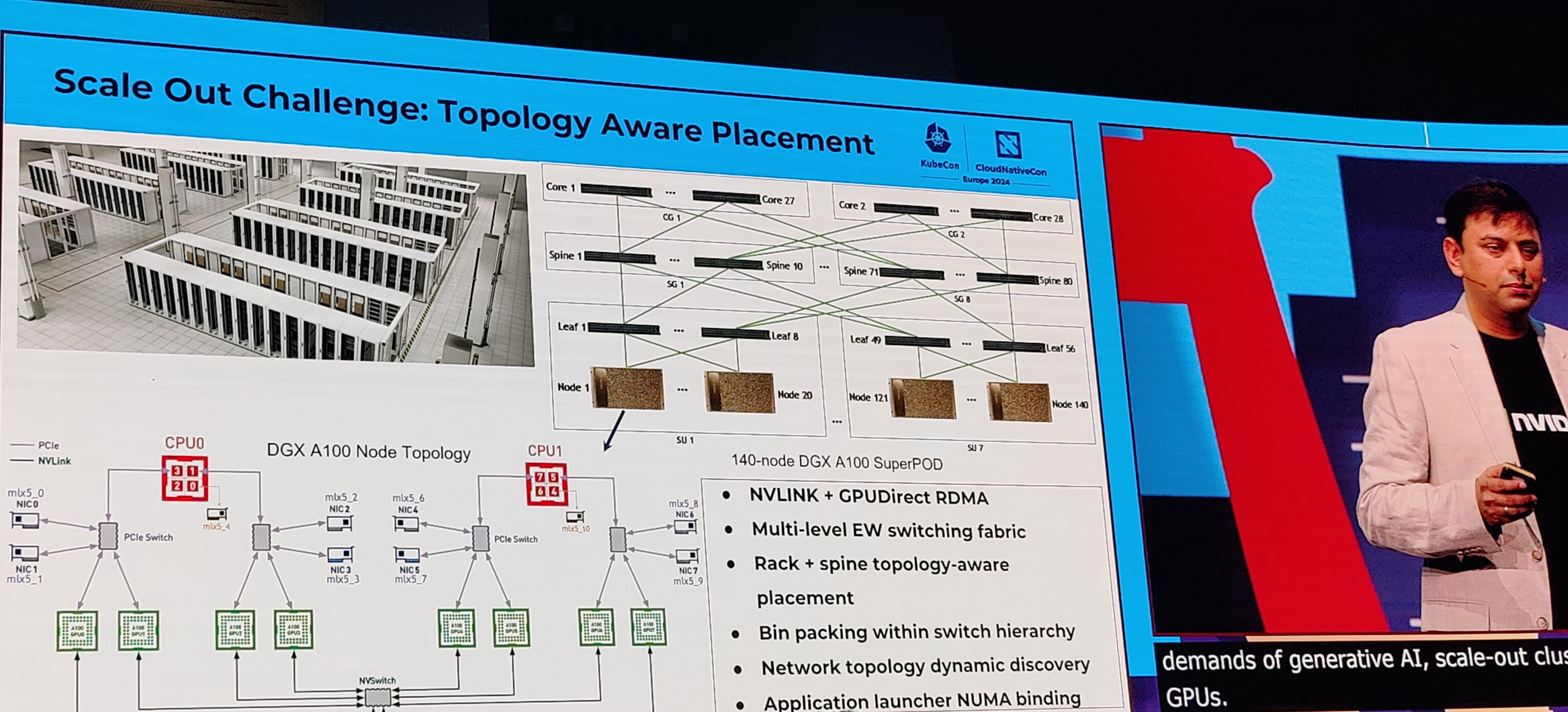

Nvidia a présenté ses avancées dans l'optimisation des ressources dans le service de génération d'image Picasso. (Crédit Photo : JC)

Cette question d’allocations des ressources notamment GPU a été également abordée par Nvidia. Kevin Klues, principal software engineer et Sanjay Chatterjee, senior engineer, ont partagé les avancées de la firme dans ce domaine à travers le service Picasso pour créer des applications générant du contenu visuel. Basées sur Kubernetes, ils ont développé différentes capacités pour optimiser certains points. « Nous avions 3 challenges. Le premier était d’adapter la topologie réseau des nodes, le second était relatif à la tolèrance aux pannes avec des besoins de détection, de diagnostic et d’automatisation de l’observabilité dans l’infrastructure GPU. Enfin, il était nécessaire d’optimiser l’aspect multi-dimensionnel des modèles, des frameworks ». Des problématiques partagées par le CERN, comme le souligne Ricardo Rocha, ingénieur au sein du centre d’étude, mais aussi membre du board technique du CNCF, « il peut y avoir une sous-utilisation des GPU et nous nous sommes inspirés des choses existantes dans le HPC sur les queues, la planification des primitives. Mais nous avons besoin de meilleurs outils pour comprendre les besoins de capacité, le flux des data, l’optimisation du stockage ».

L’IA prise en compte dans les projets

On le voit les attentes sont nombreuses et la CNCF va devoir mettre ses projets à la page de l’IA. « Kubernetes doit devenir le standard de l’IA », glisse Priyanka Sharma. Plusieurs projets sont déjà à pied d’œuvre pour intégrer ce volet. C’est le cas d’OpenTelemetry, le framework d’observabilité open source qui permet aux développeurs de générer, traiter et transmettre des données télémétriques dans un format unique et unifié, a mis dans sa roadmap les métriques liées à l’IA et aux LLM. L’initiative n’a par contre pas donné de détails, ni de calendrier sur les premiers rendus.

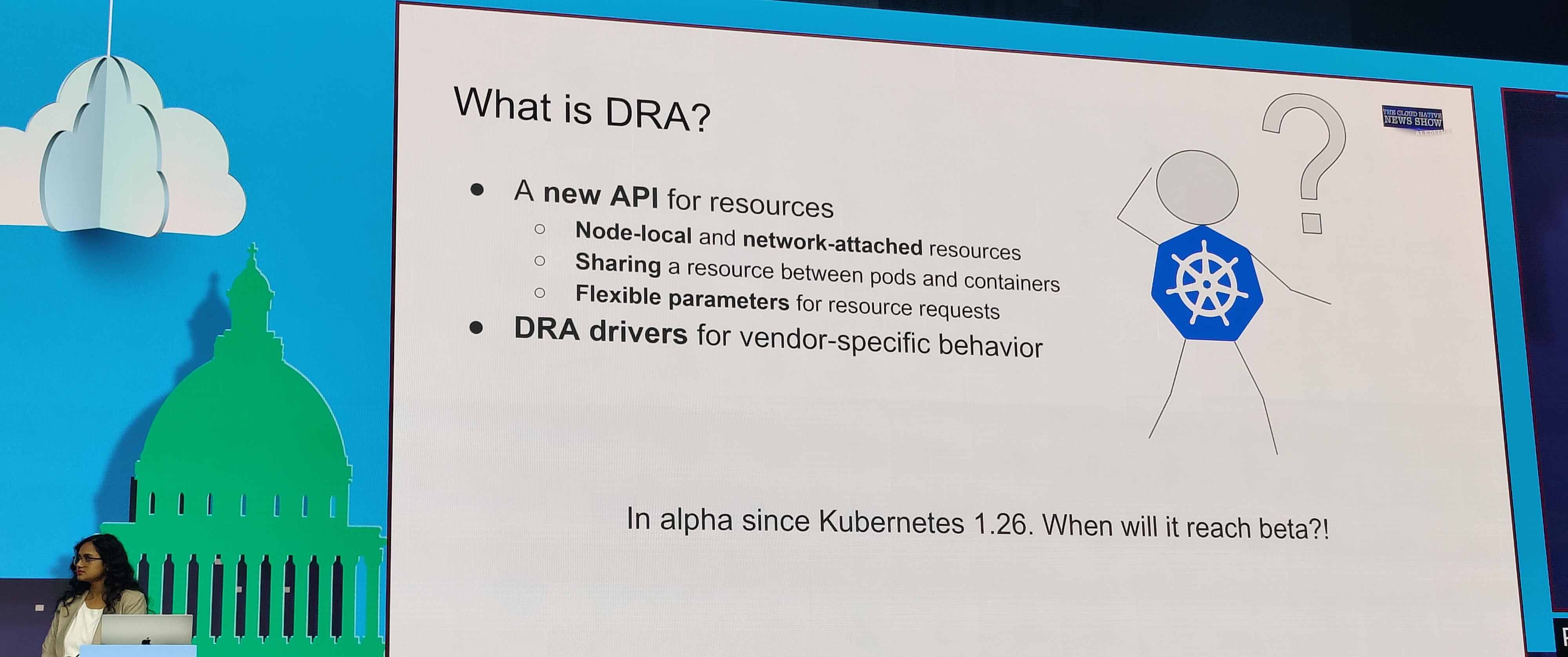

DRA est une réponse à la problématique des gestion des ressources GPU avec une API dédiée dans Kubernetes. (Crédit Photo : JC)

De son côté, Patrick Ohly, cloud software architect chez Intel est venu sur scène pour parler du projet DRA (Dynamic Resource Allocation). Il s’agit d’une API capable d’améliorer les capacités de Kubernetes à gérer des ressources locales comme le CPU ou la mémoire et aussi et surtout les GPU. Aujourd’hui en version alpha, l’API décrit les ressources matérielles dont un pod a besoin pour prendre en charge des accélérateurs complexes. Les choses avancent donc sur l'ensemble de l'écosystème du CNCF sur la prise en compte de l'IA, mais dans les allées du salon, la majorité des exposants mettait plutôt en avant le volet "legacy" de Kubernetes...

Commentaire