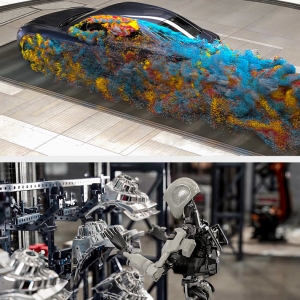

L'atténuation des erreurs pour les ordinateurs quantiques pourrait finalement conduire à des systèmes plus fiables et plus utiles, selon IBM. Le constructeur a récemment démontré comment sa technologie de gestion des erreurs permettait à un ordinateur quantique de surpasser l’approche classique d’un supercalculateur. L'informatique quantique excelle dans la résolution de certains problèmes importants et gourmands en données, et les futures applications devraient faire progresser de manière significative des domaines tels que l'IA et l'apprentissage automatique dans des secteurs comme l'automobile, la finance et la santé. Mais parmi les défis auxquels les développeurs sont confrontés figurent le bruit (des interactions indésirables affectant le travail de qbits) des systèmes quantiques d'aujourd'hui et les erreurs qu'ils génèrent.

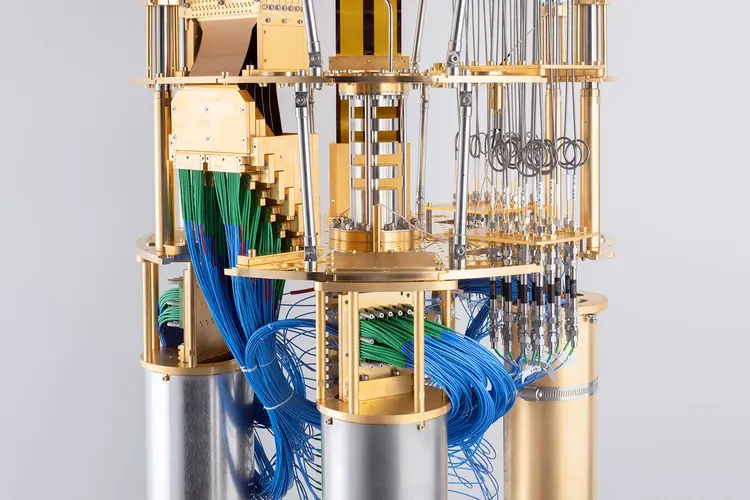

« Les systèmes quantiques d'aujourd'hui sont intrinsèquement bruyants et produisent un nombre important d'erreurs qui entravent les performances. Cela est dû à la nature fragile des bits quantiques ou qubits et aux perturbations de leur environnement », a déclaré IBM dans un communiqué sur ses derniers développements quantiques. Rappelons que le qubit est l’unité de base d’un ordinateur quantique pour réaliser un calcul. Comme l’expliquent les chercheurs de l’AlgoLab Quantique de l’IQ, « bien que de nombreux mécanismes soient mis en place pour isoler les qubits de l’environnement extérieur – notamment la présence d’un cryostat – différentes interactions indésirables affectent les qubits pendant l’exécution d’un algorithme et altèrent l’état quantique. Ces interactions indésirables constituent le « bruit » caractérisant l’ordinateur quantique actuel. Certaines sources de bruit sont systématiques et sont dues, par exemple, à des erreurs de calibration des portes quantiques ou encore à la mesure des qubits. Dans d’autres cas, le bruit provient de phénomènes aléatoires qui provoquent une perte d’information, un phénomène appelé décohérence. Rappelons que l’état d’un qubit est décrit par une superposition des états de base (plus basse énergie) et (plus haute énergie). Lorsque la perte d’information implique un échange d’énergie avec l’environnement – typiquement une transition de l’état vers l’état – on parle de relaxation du qubit. La perte d’information peut aussi survenir sans qu’un échange d’énergie soit impliqué, on parle alors de déphasage”.

Des progrès dans la réduction des erreurs

IBM Quantum et l'Université de Californie à Berkeley ont déclaré cette semaine qu'ils avaient développé des techniques qui montrent que "les ordinateurs quantiques bruyants seront en mesure de fournir de la valeur plus tôt que prévu, tout cela grâce aux progrès du matériel IBM Quantum et au développement de nouvelles méthodes d'atténuation des erreurs". Un article a été publié par les chercheurs dans la revue Nature. "Les erreurs se produisent naturellement dans un ordinateur : l'état quantique doit évoluer comme prescrit par le circuit quantique qui est exécuté. Cependant, l'état quantique réel et les bits quantiques pourraient évoluer différemment, provoquant des erreurs de calcul, dues à diverses perturbations inévitables dans l'environnement extérieur ou dans le matériel lui-même, des perturbations que nous appelons du bruit », ont déclaré les chercheurs. « Mais les erreurs quantiques sur les bits sont plus complexes que les erreurs classiques sur les bits. Non seulement la valeur zéro ou une du qubit peut changer, mais les qubits viennent également avec une phase – un peu comme une direction vers laquelle ils pointent. Nous devons trouver un moyen de gérer ces deux types d'erreurs à chaque niveau du système : en améliorant notre contrôle du matériel de calcul lui-même et en créant une redondance dans le matériel afin que même si un ou quelques qubits sortent en erreur, nous pouvons toujours récupérer une valeur précise pour nos calculs.

Le module cryostat d'IBM contribue à atténuer les erreurs de calculs quantiques. (Crédit IBM)

Plus récemment, des chercheurs d'IBM ont partagé une expérience qui a montré qu'en atténuant les erreurs, un ordinateur quantique était capable de surpasser les principales approches informatiques classiques. IBM a utilisé son processeur quantique Eagle de 127 qubits pour générer de grands états intriqués qui simulent la dynamique des spins dans un modèle de matériau et prédisent avec précision ses propriétés. Une équipe de scientifiques de l'UC Berkeley a effectué les mêmes simulations sur des supercalculateurs classiques pour vérifier les résultats du processeur IBM Quantum Eagle.

Au fur et à mesure que l'échelle et la complexité du modèle augmentaient, l'ordinateur quantique a continué à produire des résultats précis à l'aide de techniques avancées d'atténuation des erreurs, même si les méthodes de calcul classiques ont finalement faibli et ne correspondaient pas au système IBM Quantum, ont déclaré les chercheurs. "C'est la première fois que nous voyons des ordinateurs quantiques modéliser avec précision un système physique dans la nature au-delà des principales approches classiques", a déclaré Darío Gil, vice-président senior et directeur d'IBM Research, dans un communiqué. "Pour nous, cette étape est importante pour prouver que les ordinateurs quantiques actuels sont exploitables comme outils scientifiques capables de modéliser des problèmes extrêmement difficiles - et peut-être impossibles - pour les systèmes classiques signalant que nous entrons maintenant dans une nouvelle ère d'utilité pour l'informatique quantique."

Des clusters de serveurs 127 qbits

Le modèle de calcul utilisé par IBM pour explorer ce travail est une facette centrale de nombreux algorithmes conçus pour les dispositifs quantiques à court terme. Et la taille même des circuits – 127 qubits exécutant 60 étapes de portes quantiques – sont parmi les plus longues et les plus complexes réalisés avec succès à ce jour, ont déclaré les chercheurs. "Et avec la certitude que nos systèmes commencent à fournir une utilité au-delà des seules méthodes classiques, nous pouvons commencer à transformer notre parc d'ordinateurs quantiques en un parc composé uniquement de processeurs de 127 qubits ou plus", ont déclaré les chercheurs.

À la suite de cette étude, big blue a annoncé que ses systèmes Quantum fonctionnant à la fois dans le cloud et sur site chez des partenaires seront alimentés par un minimum de 127 qubits, à compléter au cours de l'année prochaine. "Ces processeurs donnent accès à une puissance de calcul suffisamment importante pour surpasser les méthodes classiques pour certaines applications et offriront des temps de cohérence améliorés ainsi que des taux d'erreur plus faibles par rapport aux systèmes quantiques IBM précédents", ont déclaré les chercheurs. « De telles capacités peuvent être combinées avec des techniques d'atténuation des erreurs en constante évolution pour permettre aux systèmes Quantum d'atteindre un nouveau seuil pour l'industrie, qu'IBM a appelé " l'échelle de l'utilité ", un point auquel les ordinateurs quantiques pourraient servir d'outils scientifiques pour résoudre une nouvelle échelle de problèmes que les systèmes classiques ne pourront peut-être jamais résoudre.

IBM continue de progresser sur la feuille de route quantique qu'elle a présentée l'automne dernier. Parmi ses objectifs à long terme figurent le développement d'un système de plus de 4 000 qubits construit avec des grappes de processeurs quantiques d'ici 2025, et le développement de logiciels capables de contrôler les systèmes quantiques et de les mettre en réseau tout en éliminant les erreurs. Lors de l'IBM Quantum Summit 2022, la société a déclaré qu'elle poursuivait le développement d'une plate-forme quantique modulaire appelée System Two qui combinera plusieurs processeurs en un seul système et utilisera un middleware de cloud hybride pour intégrer les flux de travail quantiques et classiques.

Commentaire