Même en virtuel, Andy Jassy, le CEO d’AWS a gardé son rythme habituel de 3 heures de conférence lors de l’évènement Re:Invent. Et dans ce laps de temps, beaucoup d’annonces ont été faites sur différents sujets. En introduction, il n’a pas pu faire l’impasse sur la crise du Covid-19 qui a sans conteste « accéléré la migration vers le cloud ». Il ajoute, « aujourd’hui les entreprises ont réellement une stratégie pour aller dans le cloud ».

Un rapprochement avec AMD et de l’intensif avec Intel

Fer de lance historique d’AWS, le dirigeant a démarré sa présentation par les évolutions relatives aux instances avec de plus en plus de demandes autour de celles qui offrent d’importantes ressources IT pour des applications de plus en plus gourmandes, comme les bases de données in memory ou le machine learning. Travaillant habituellement avec Intel, AWS se rapproche aussi d’AMD en dévoilant les instances G4ad, la première de la gamme EC2 intégrant des puces Epyc et des GPU comme la Radeon Pro V520. Elles s’adressent en priorité aux workloads à forte intensité de calcul graphique comme la vidéo ou le streaming. Cette association avec AMD concurrence les G4dn, équipées de GPU Nvidia, en revendiquant jusqu’à 40% d’amélioration des performances.

Autre séries d’instances, les M5zn ciblent les workoloads à forte intensité de calcul comme les jeux, les applications financières, la modélisation, la simulation. Elles embarquent des puces Intel Xeon Scalable offrant une fréquence maximale de 4,5 GHz. A noter que les VM M5zn ne comprennent pas de stockage flash local et que le ratio mémoire/puissance de calcul est inférieur à celui des instances précédentes. AWS se justifie en indiquant que ces modifications aideront les clients à éviter la surcapacité et donc les surcoûts.

Des instances gonflées pour le stockage et l’analyse de données

Parmi les autres instances dévoilées, il y a les D3 qui se focalisent sur le stockage en proposant jusqu’à 38 To de capacité par VM. Pour les outils d’analyse de données, AWS déploie les instances R5b qui mettent l’accent sur la partie bande passante (avec des vitesses de 60 Gb/s vers et depuis EBS) et réseau.Toujours dans les services requérant des déplacements rapides de grands volumes de données, AWS pousse ses processeurs Graviton2 avec les instances C6gn. Ces dernières offrent jusqu’à 38 Gbt/s sur le stockage EBS et jusqu’à 100 Gbt/s sur le réseau.

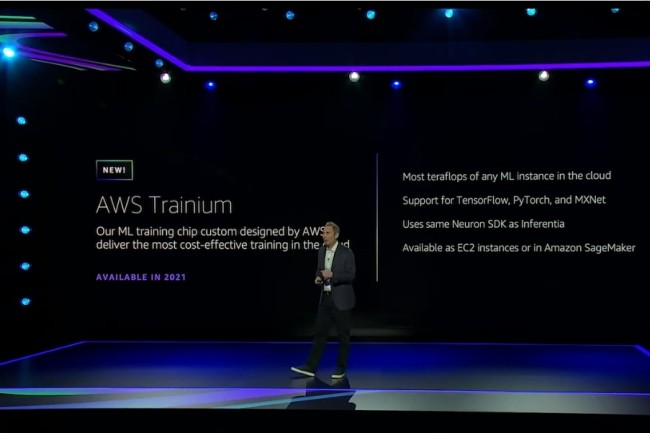

Des puces dédiées pour l’entraînement de l’IA

Sur Graviton2, Andy Jassy a expliqué que ces puces avaient un grand avenir au sein d’AWS. « Nous ne sommes pas près d’avoir fini d’investir et d’inventer avec Graviton », souligne-t-il. Mais le patron du fournisseur de cloud réfléchit aussi sur les besoins dans le domaine de l’IA et du machine learning. Dans ce cadre, AWS a dévoilé la puce Trainium, dédiée à l’entraînement des modèles d’apprentissage automatique. Compatible avec TensorFlow, PyTorch et MXNet. A la clé, Amazon promet 30% de débit en plus et 45% de coût par interférence en moins par rapport à des instances avec GPU. Les offres sous Trainium devraient débuter en 2021 sur EC2 et SageMaker.

Toujours dans le domaine de l’entraînement du machine learning, AWS travaille en tandem avec Intel sur des instances basées sur les puces Gaudi de Habana, qui seront disponibles au début 2021. Issues du rachat de Habana Lab en décembre 2019 par Intel, ces puces IA intègrent des fonctionnalités RDMA over Converged Ethernet pour fournir des capacités de mise à l’échelle pour un TCO réduit. Elles supporteront PyTorch et Tensorflow. Là encore, AWS annonce de meilleures performances et de vitesses par rapport aux instances sous GPU Nvidia, qui au final est le grand perdant/absent de ce millésime de Re:Invent.

Commentaire