Si les entreprises voient l’intérêt du machine learning pour certaines tâches ou process, elles peuvent être rebutées par la mise en œuvre des modèles. HPE veut les aider en lançant deux solutions : Swarm Learning et Machine Learning Development System. La première se base sur l’apprentissage en essaim qui vise à exploiter la valeur des données générées à la périphérie ou sur des sites distribués. La seconde fournit une solution matérielle d’entraînement des modèles pour éviter aux entreprises de créer leurs propres infrastructures ad hoc.

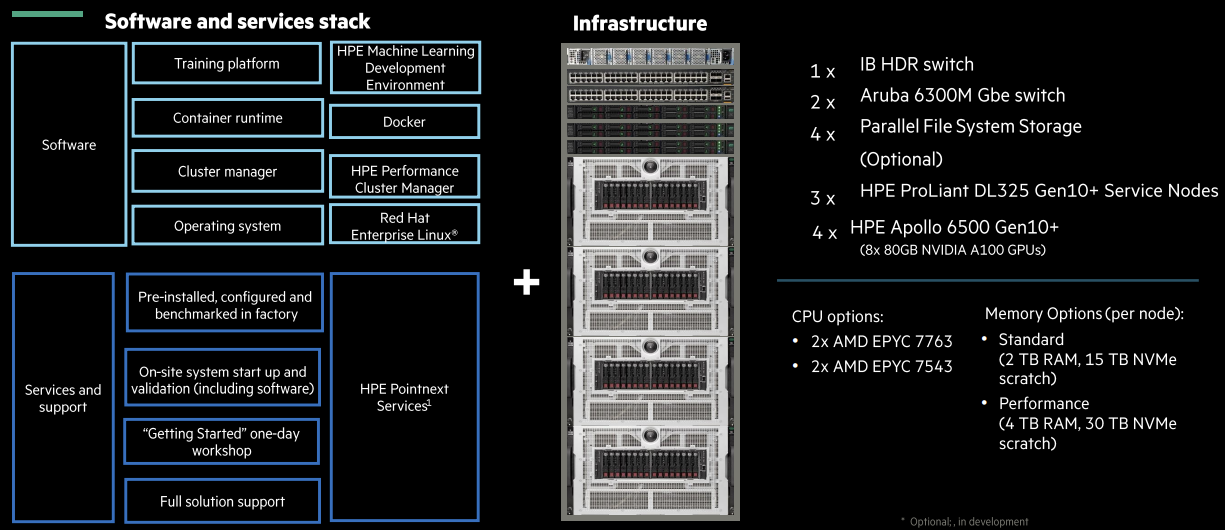

Machine Learning Development System, s'appuie sur le rachat en 2021 de Determined AI. Elle propose une plateforme open source pour accélérer l'entraînement des modèles de machine learning et s'intègre avec le matériel HPE. A cette fin, plusieurs configurations sont possibles, mais HPE indique qu'une « petite configuration » type est constituée d’un serveur Apollo 6500 Gen10 dont la puissance est suffisante pour les entraînements des modèles de ML, de serveurs HPE ProLiant DL325 et de switchs Aruba CX 6300. Elle comprend aussi la plate-forme réseau Quantum InfiniBand de Nvidia, et les logiciels spécialisés de HPE : Machine Learning Development Environment et Performance Cluster.

Exemple de configuration pré-packagée pour entraîner les modèles de machine learning (Crédit Photo: HPE)

Du calcul HPC pour le ML

Selon Peter Rutten, vice-président de la recherche d'IDC, le concept vise essentiellement à apporter des capacités de calcul haute performance (HPC) au machine learning en entreprise pour leur éviter de concevoir leurs propres systèmes. « Maintenant que l'IA est plus mature, les entreprises sont vraiment demandeuses de ce type de système », a-t-il déclaré.

« Cette nécessité d’avoir à concevoir son propre système est le plus grand obstacle à l'introduction de l'IA dans l’entreprise ». Pour certaines, l’usage de ressources dans le cloud peut être une option, mais, très souvent, les données requises pour entraîner les modèles d'IA sont sensibles et critiques pour la société, de sorte que ce genre d’option n’est pas envisageable pour certaines d’entre elles, sans parler des restrictions réglementaires de certaines industries, qui la rendent carrément impossible pour d'autres.

Du ML décentralisé en « essaim »

Avec son produit Swarm Learning, HPE essaye justement de résoudre la question de la nature sensible des données d'apprentissage machine. Le framework décentralisé de Swarm Learning utilise la conteneurisation pour atteindre deux objectifs : d’abord, il permet d’effectuer les tâches d'apprentissage machine sur des systèmes en périphérie (edge), sans avoir à faire d'aller-retour vers un datacenter central, et d'obtenir ainsi des informations précises, plus rapidement qu'elles ne le pourraient autrement. Ensuite, il permet à des entreprises de nature équivalente de partager entre elles les résultats de l'apprentissage des modèles d'IA sans avoir à partager les données sous-jacentes entre elles, ce qui peut apporter des avantages à l'ensemble du secteur. « Prenons l'exemple de sept hôpitaux qui essaient tous de résoudre des problèmes grâce à des modèles d’IA, mais, comme ils ne peuvent pas partager leurs données, l'entraînement des modèles sera limité », a expliqué M. Rutten. Ces derniers seront peu précis, avec un biais potentiel inhérent, en fonction de la démographie des patients et un tas d'autres facteurs. « Pour résoudre ce problème, Swarm Learning ne partage pas les données, mais uniquement les résultats d’entraînement du modèle et les combine en un modèle unique qui aura été entraîné à partir de toutes les données », a encore déclaré M. Rutten.

Ce dernier fait remarquer que cette technique d’apprentissage « en essaim » est relativement récente, ce qui signifie que son adoption généralisée pourrait prendre du temps. Par-contre, selon lui, le système de développement de l'apprentissage automatique Machine Learning Development System de HPE cible directement un point de tension actuel, et c’est sans doute l'annonce la plus intéressante des deux. « C'est presque une offre aaS (as a service) pour le datacenter de l’entreprise », a-t-il précisé. « C'est exactement ce que recherchent les gens pour entraîner des modèles d'IA dans leur entreprise », a-t-il ajouté.

Commentaire