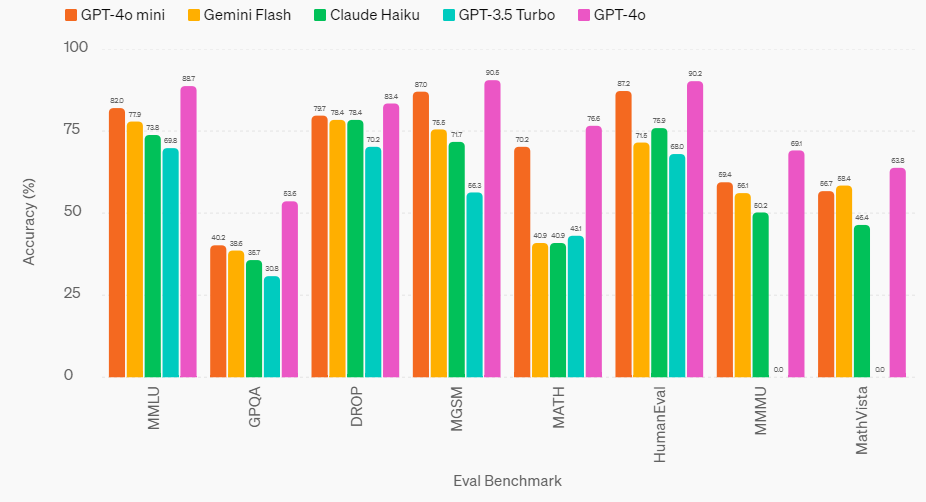

Avec l'IA, c'est tout le temps la saison des LLM. Après avoir ouvert les vannes d'un grand modèle de langage multimodal GPT-4o au printemps, OpenAI annonce en plein coeur de l'été sa déclinaison mini. Une annonce d'importance aux yeux du père de ChatGPT qui indique que GPT-4o mini s'annonce d'ores et déjà comme son petit modèle proposant le meilleur rapport performance/coût. Si GPT-4o est plus rapide et moins cher que GPT-4 Turbo, de son côté GPT-4o mini est plus performant et moins cher que GPT-3.5 Turbo. "GPT-4o mini obtient un score de 82 % sur MMLU et surpasse actuellement GPT-4 sur les préférences de chat au benchmark LMSYS. Son prix est de 15 cents par million de jetons d'entrée et de 60 cents par million de jetons de sortie, soit un ordre de grandeur plus abordable que les modèles de frontière précédents et plus de 60 % moins cher que le GPT-3.5 Turbo", explique OpenAI. Sans surprise GPT-4o mini se fait battre à tous les benhmarks par GPT-4o mais ce dernier n'est pas du tout proposé au même prix.

"GPT-4o mini surpasse GPT-3.5 Turbo et d'autres petits modèles sur des benchmarks académiques à la fois pour l'intelligence textuelle et le raisonnement multimodal, et prend en charge la même gamme de langues que GPT-4o. Il fait également preuve d'excellentes capacités en matière d'appel de fonctions, ce qui permet aux développeurs de créer des applications qui récupèrent des données ou entreprennent des actions avec des systèmes externes, ainsi que de meilleures performances en matière de contexte long par rapport à GPT-3.5 Turbo", avance OpenAI.

Evaluation des performances de GPT-4à mini d'OpenAI face à deux modèles concurrents et deux modèles plus anciens d'OpenAI. (crédit : OpenAI)

GPT-3.5 remplacé par GPT-4o mini dans ChatGPT

Dans le détail, GPT-4o mini ressort mieux placé que d'autres petits modèles concurrents pour les tâches de raisonnement impliquant à la fois du texte et de la vision. Il décroche ainsi un score de 82,0 % sur MMLU contre 77,9 % pour Gemini Flash et 73,8 % pour Claude Haiku. S'agissant de ses capacités en raisonnement mathématique, là encore le rejeton d'OpenAI se distingue avec un score sur MGSM de 87 % versus 75,5 % pour Gemini Flash et 71,7 % pour Claude Haiku. Pour la performance de code (HumanEval), GPT-4o mini affiche un résultat de 87,2 % versus 71,5 % et 75,9 % pour ses deux compétiteurs. Ce dernier modèle se démarque aussi sur MMMU (raisonnement multimodal), avec un score de 59,4 % contre 56,1 % pour Gemini Flash et 50,2 % pour Claude Haiku.

A noter que dans les versions free, plus et team de ChatGPT, les utilisateurs peuvent accéder à GPT-4o mini dès maintenant et en remplacement de GPT-3.5. Les utilisateurs de la version entreprise devront patienter la semaine prochaine pour y accéder.

Commentaire