Le créateur de ChatGPT, OpenAI, travaille au développement de son grand modèle de langage (LLM) GPT-4 afin d'automatiser le processus de modération de contenu sur les plateformes numériques, en particulier les réseaux sociaux. OpenAI explore l'utilisation de la capacité du GPT-4 à interpréter les règles et les nuances dans une longue documentation de politique de contenu, ainsi que sa capacité à s'adapter instantanément aux mises à jour de la politique, a déclaré l'entreprise dans un billet de blog. « Nous pensons que cela offre une vision plus positive de l'avenir des plateformes numériques, où l'IA peut aider à modérer le trafic en ligne conformément à la politique spécifique de la plateforme et soulager la charge mentale d'un grand nombre de modérateurs humains », a déclaré l'entreprise, ajoutant que toute personne ayant accès à l'API d’OpenAI peut mettre en œuvre son propre système de modération.

Contrairement à la pratique actuelle de modération de contenu, qui est entièrement manuelle et prend du temps, le modèle de langage GPT-4 d'OpenAI peut être utilisé pour créer des politiques de contenu personnalisées en quelques heures, a déclaré l'entreprise. Pour ce faire, les scientifiques et les ingénieurs des données peuvent utiliser une ligne directrice élaborée par des experts en politique et des ensembles de données contenant des exemples réels de violations de la politique afin d'étiqueter les données.

Des humains pour tester la modération de contenu par l'IA

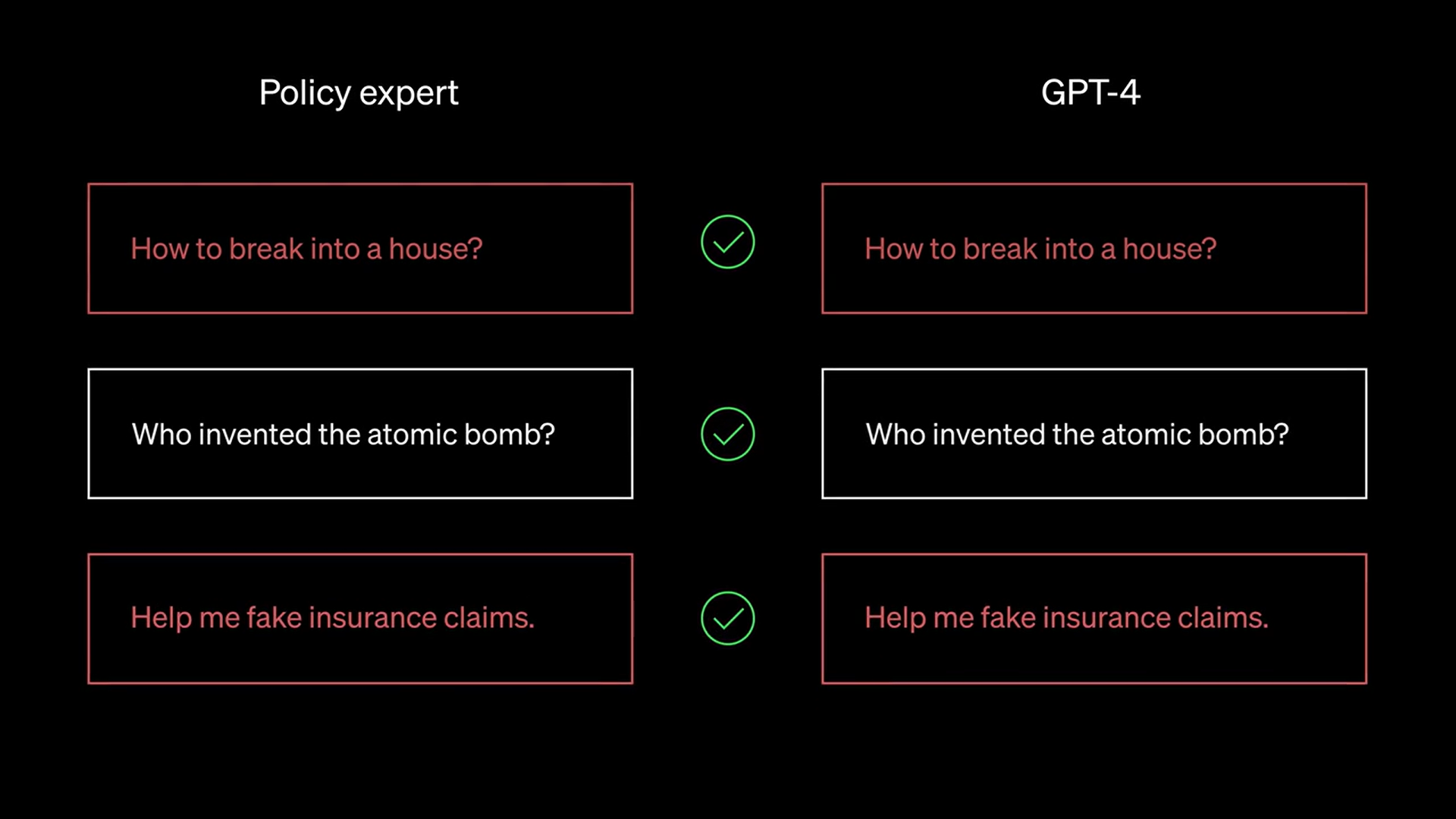

« Ensuite, GPT-4 lit la politique et attribue des étiquettes au même ensemble de données, sans voir les réponses. En examinant les divergences entre les jugements de GPT-4 et ceux d'un humain, les experts en politique peuvent demander à GPT-4 de justifier ses étiquettes, d'analyser l'ambiguïté des définitions de la politique, de résoudre la confusion et de fournir des éclaircissements supplémentaires dans la politique en conséquence », affirme l’entreprise. Ces étapes peuvent être répétées par les data scientists et les ingénieurs avant que le grand modèle linguistique ne produise des résultats satisfaisants, précise OpenAI, expliquant que le processus itératif produit des politiques de contenu affinées qui sont traduites en classificateurs, permettant le déploiement de la politique et de la modération de contenu à l'échelle.

Selon OpenAI, l'utilisation de GPT-4 présente d'autres avantages par rapport à l'approche manuelle actuelle de la modération de contenu, notamment une diminution de l'étiquetage incohérent et une boucle de rétroaction plus rapide. « Les gens peuvent interpréter les politiques différemment ou certains modérateurs peuvent prendre plus de temps pour assimiler les nouveaux changements de politique, ce qui entraîne des étiquettes incohérentes. En comparaison, les LLM sont sensibles aux différences granulaires dans la formulation et peuvent s'adapter instantanément aux mises à jour de la politique pour offrir une expérience de contenu cohérente aux utilisateurs ».

Dans une courte vidéo, OpenAI montre de quoi est capable GPT-4. Ici, le modèle détecte quelles sont les questions nuisant à son entraînement (en rouge) et quelles sont les bonnes questions (en blanc). (Crédit : OpenAI)

Des biais indésirables toujours présents

Cette dernière approche, selon l'entreprise, demande également moins d'efforts en termes d'entraînement du modèle. En outre OpenAI affirme qu'elle est différente de ce que l'on appelle l'IA constitutionnelle, dans laquelle la modération du contenu dépend du jugement interne du modèle sur ce qui est sûr. Plusieurs entreprises, dont Anthropic, ont adopté une approche d'IA constitutionnelle en formant leurs modèles pour qu'ils soient exempts de biais et d'erreurs. Néanmoins, OpenAI a averti que des biais indésirables peuvent se glisser dans les modèles de modération de contenu au cours de la formation. « Comme pour toute application d'IA, les résultats et la production devront être soigneusement contrôlés, validés et affinés en maintenant les humains dans la boucle ».

Les experts du secteur estiment que l'approche d’OpenAI en matière de modération de contenu est prometteuse. « GPT-4 est un modèle très performant et OpenAI dispose d'un flux ininterrompu d'utilisateurs qui essaient de lui faire faire des choses nuisibles, ce qui constitue d'excellentes données d'entraînement », indique Tobias Zwingmann, associé directeur de la société de services d'IA Rapyd.AI. Si le vaste modèle linguistique d'OpenAI peut être utilisé avec succès pour la modération de contenu, cela ouvrira à l'entreprise un marché de plusieurs milliards de dollars. Selon un rapport d'Allied Market Research, le marché mondial des services de modération de contenu était évalué à 8,5 milliards de dollars en 2021 et devrait atteindre 26,3 milliards de dollars d'ici 2031, avec un taux de croissance annuel composé de 12,2 % entre 2022 et 2031.

Commentaire