Les produits AutoML répondent à la volonté de démocratisation de l'IA de Google. « Il s’agit de réduire les barrières d’accès à l’intelligence artificielle et de mettre l’IA à la portée du plus grand nombre de communautés de développeurs, de chercheurs et d'entreprises », ont écrit dans un blog Fei-Fei Li, Chief Scientist AI/ML (Google Cloud) et Jia Li, responsable R&D du Cloud IA et Directrice Senior chez Google. À noter que Fei-Fei Li est par ailleurs Professeure associée en Computer Science à l’université de Stanford, directrice du Stanford Artificial Intelligence Lab (SAIL) et du Stanford Vision Lab. Quant à Jia Li, elle était précédemment directrice de la recherche chez Snapchat, et antérieurement responsable du Visual Computing & Learning Group chez Yahoo.

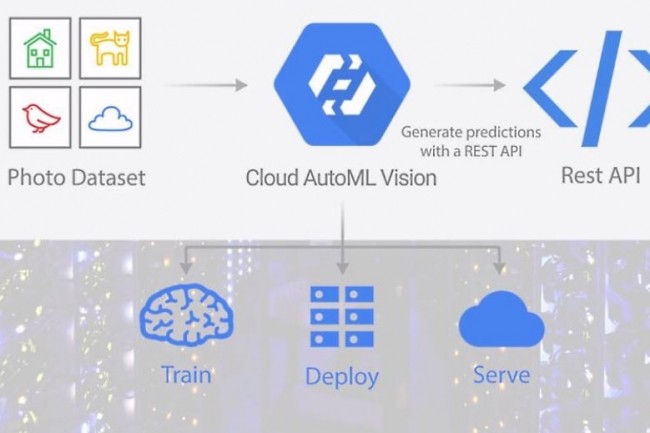

AutoML Vision est le premier produit disponible de la suite de Google - les développeurs intéressés doivent faire une demande pour en obtenir l’accès - pour construire des modèles de vision personnalisés basés sur la technologie de reconnaissance d'images propriétaire de Google. L’interface utilisateur permet aux développeurs de glisser/déposer les images pour les étiqueter en fonction de leurs besoins. Le modèle s’entraîne sur les entrées et les utilisateurs peuvent ensuite l'évaluer et l'affiner. Google propose également de recourir à « son équipe interne pour la labélisation ». Elle peut examiner les instructions personnalisées et classer les images en conséquence. Parmi les adopteurs précoces, on peut citer la marque de vêtements Urban Outfitters qui teste l’automatisation de la reconnaissance de motifs ou de styles d’encolures sur ses produits. Disney utilise aussi la technologie pour construire des modèles de vision afin d’associer ses produits avec des personnages, des catégories et des couleurs Disney. La Zoological Society of London utilise également AutoML Vision pour analyser et annoter des images d'animaux prises par des caméras automatiques installées dans la nature.

Démystifier l'apprentissage machine

« À l'heure actuelle, seules quelques entreprises disposent des compétences et des budgets nécessaires pour prendre la pleine mesure du potentiel de l’apprentissage machine et de l’IA », ont encore écrit Fei-Fei Li et Jia Li. « Aujourd’hui, peu de personnes sont capables de construire des modèles d'apprentissage machine évolués. Et le processus pour développer un modèle ML personnalisé reste long et compliqué, même pour les entreprises qui ont les moyens de s’offrir des ingénieurs en apprentissage machine et en IA ». L’an dernier, Google a déjà lancé son moteur d'apprentissage Cloud Machine Learning Engine, livré via des API. Mais sa nouvelle suite permettra de « combler le fossé » et de rendre l'AI « accessible à toutes les entreprises », a encore écrit Fei-Fei Li et Jia Li.

D’autres fournisseurs de services cloud concurrents de Google cherchent aussi à « démocratiser » l'apprentissage machine. C’est le cas de Microsoft qui propose, avec Azure Machine Learning Studio, un « environnement de création graphique simple, basé sur un navigateur Web, ne nécessitant aucun codage ». En septembre, l’éditeur a également enrichi sa gamme d'outils IA, même si ses produits sont toujours en preview. C’est aussi le cas d’Amazon Web Services, qui a lancé en novembre, pendant la conférence Re: Invent, un service d'apprentissage machine de bout en bout entièrement géré appelé Sagemaker et une caméra vidéo qui utilise des modèles deep learning appelés DeepLens. « Les développeurs veulent simplifier et démystifier l’apprentissage machine. Ils ne veulent pas qu’il soit perçu comme une boîte noire. Ils veulent en faciliter l’usage », avait déclaré Andy Jassy, le CEO d'AWS, pendant la conférence. « Il n'y a pas beaucoup d'experts en apprentissage machine dans le monde. La plupart finissent par travailler dans les grandes entreprises technologiques. Et si l'on veut qu’un plus grand nombre d’entreprises utilisent l'apprentissage machine, nous devons résoudre le problème de l’accessibilité de la technologie en permettant à tous les développeurs et scientifiques de l’utiliser », a-t-il ajouté.

Commentaire