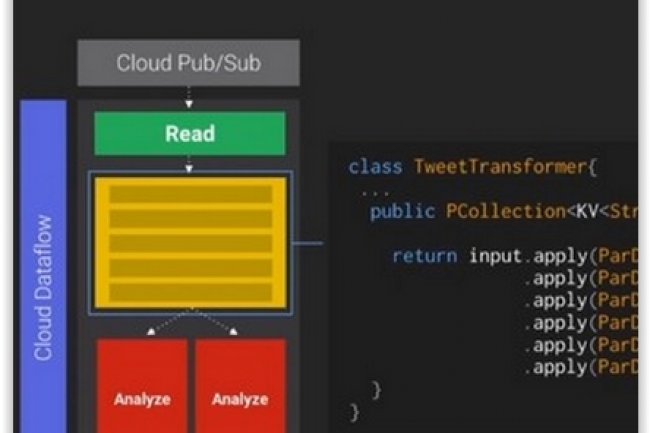

Afin d'étendre les capacités de sa plateforme Cloud Dataflow, Google livre un SDK Java qui permet d'utiliser son service d'analyse de flux de données en temps réel. « Ce SDK, livré en Open Source, fournit une base pour rendre Dataflow compatible avec d'autres langages et d'autres environnements de développement », a déclaré Sam McVeety, ingénieur logiciel de Google, dans un communiqué récent. « Nous avons beaucoup appris sur la façon de transformer les données en intelligence, en particulier à partir des modèles de programmation FlumeJava originaux, servant de socle pour Cloud Dataflow, que nous avons continué à faire évoluer en interne chez Google », a-t-il ajouté.

En combinant les modèles de flux et de traitement par lots, Google espère étendre son service Dataflow et stimuler l'innovation. « Les volumes de données ne cessent de croître, il faut donc que les langages et les modèles de programmation évoluent », a déclaré Sam McVeety. « Nous préparons actuellement une version Python 3 du SDK pour offrir aux développeurs un choix encore plus large et permettre à d'autres applications d'accéder à Dataflow. Pour le développeur, les modèles de programmation réutilisables sont essentiels en termes d'efficacité. Le SDK pour Cloud Dataflow introduit un modèle unifié pour le traitement batch et le traitement par flux de données », a-t-il encore ajouté.

Une portabilité de service et d'exécution au service pour soulager les développeurs

En ce qui concerne les autres environnements, l'ingénieur logiciel de Google pense que les nouvelles méthodes de développement, en particulier dans le cloud, sont dépendantes de services hétérogènes. « En même temps que la maturation de Storm, de Spark, et de la grande famille Hadoop se poursuit, les modèles de programmation prennent des routes différentes, ce qui représente un grand défi pour les développeurs. Nous souhaitons les soulager dans leur tâche en leur apportant le choix dans les plates-formes de déploiement avec une portabilité de service et d'exécution », indique Sam McVeety.

Lancé en juin dernier, Cloud Dataflow est la première étape vers un modèle de services gérés pour le traitement des données. Toujours en phase de développement alpha, le service est réservé aux utilisateurs inscrits en liste blanche (les nouveaux entrants doivent faire une demande pour accéder au service), sachant que l'objectif de Cloud Dataflow est de centrer le travail sur l'analyse sans avoir à se préoccuper de la tuyauterie et de l'infrastructure de traitement sous-jacente. Selon InfoWorld, Cloud Dataflow n'est probablement pas un « Hadoop killer », mais une façon pour les utilisateurs de Google Cloud d'enrichir leurs applications.

Google livre un SDK Java pour Google Cloud Dataflow

0

Réaction

Le géant de la recherche Google veut ouvrir sa plate-forme d'analyse de gros volumes de données Cloud Dataflow à d'autres langages et à d'autres environnements.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire